Open WebUI: Interfaz de LLM autohospedada

Alternativa de ChatGPT autohospedada para modelos de lenguaje local

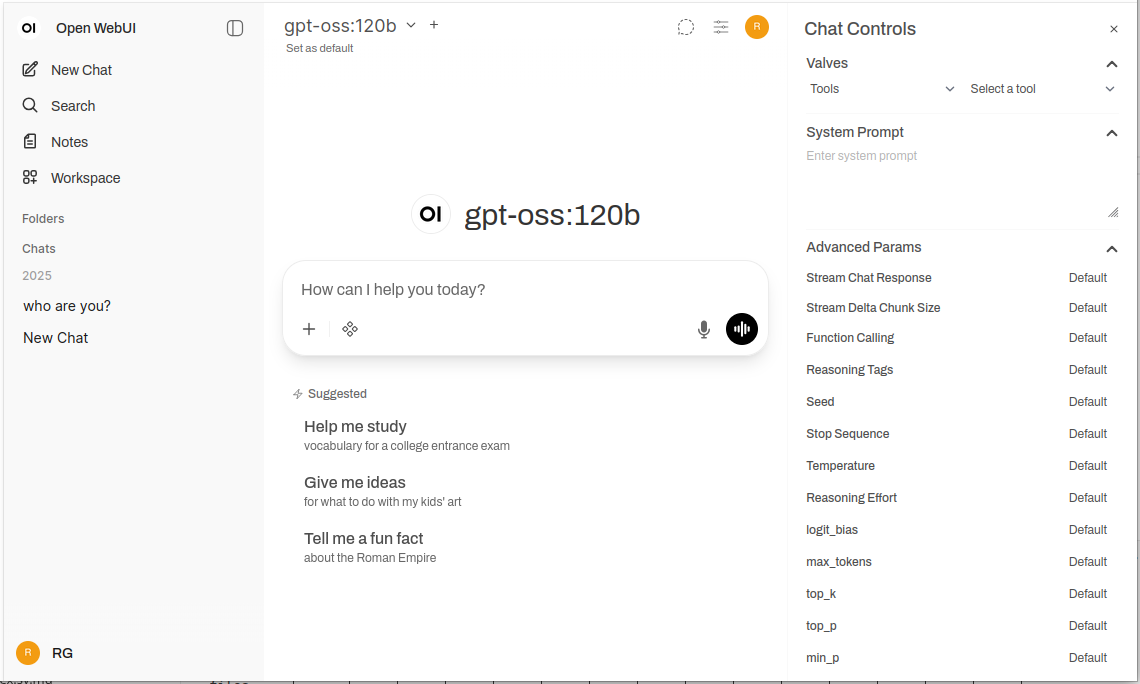

Open WebUI es una poderosa, extensible y rica en características interfaz web autogestionada para interactuar con modelos de lenguaje grandes.

Soporta Ollama y cualquier API compatible con OpenAI, trayendo la familiar experiencia de ChatGPT a tu infraestructura con privacidad completa, capacidad offline y características empresariales.

Para una comparación más amplia de backends locales y en la nube de LLM—Ollama, vLLM, Docker Model Runner, LocalAI y proveedores en la nube—ve LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

¿Qué es Open WebUI?

Open WebUI es una aplicación web de código abierto, autogestionada que proporciona una interfaz moderna de chat para interactuar con modelos de lenguaje grandes. A diferencia de los servicios de IA basados en la nube, Open WebUI se ejecuta completamente en tu infraestructura, dándote el control total sobre tus datos, conversaciones y selección de modelos.

Aunque Open WebUI se usa comúnmente con Ollama (y a veces se llama informalmente “Ollama WebUI”), en realidad es una plataforma independiente del backend. Puede conectarse a la API de Ollama para la ejecución local de modelos, pero también soporta cualquier endpoint compatible con OpenAI—incluyendo vLLM, LocalAI, LM Studio, Text Generation WebUI e incluso proveedores en la nube. Esta flexibilidad hace que Open WebUI sea una solución completa que soporta múltiples backends, RAG (Generación Aumentada con Recuperación), chat con documentos, autenticación multiusuario, capacidades de voz y opciones de personalización extensas. Ya estés ejecutando modelos en una laptop, un servidor doméstico o un clúster de Kubernetes, Open WebUI se escala para satisfacer tus necesidades.

¿Por qué elegir Open WebUI?

Privacidad primero: Todos los datos permanecen en tu infraestructura—ningún chat, documento ni prompts salen de tu red a menos que configure explícitamente APIs externas.

Capacidad offline: Perfecto para entornos aislados, redes restringidas o situaciones donde el acceso a Internet es inconfiable o prohibido. Cuando se combina con modelos ejecutados localmente a través de Ollama o vLLM, se logra una independencia total de los servicios en la nube.

Rico en características: A pesar de ser autogestionado, Open WebUI compite con ofertas comerciales con subida de documentos y RAG, historial de conversación con búsqueda semántica, plantillas y compartir de prompts, gestión de modelos, entrada/salida de voz, diseño responsive para dispositivos móviles y temas oscuros/claros.

Soporte multiusuario: Sistema de autenticación integrado con control de acceso basado en roles (administrador, usuario, pendiente), panel de administración de usuarios, aislamiento de conversaciones y prompts y modelos compartidos entre equipos.

Guía rápida de instalación

La forma más rápida de comenzar con Open WebUI es usando Docker. Esta sección cubre los escenarios de implementación más comunes.

Instalación básica (conectando a Ollama existente)

Si ya tienes Ollama en ejecución en tu sistema, usa este comando:

docker run -d \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

Esto ejecuta Open WebUI en el puerto 3000, persistiendo los datos en un volumen de Docker. Accédalo en http://localhost:3000.

Instalación empaquetada (Open WebUI + Ollama)

Para una configuración completa de todo en uno con Ollama incluido:

docker run -d \

-p 3000:8080 \

--gpus all \

-v ollama:/root/.ollama \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:ollama

La bandera --gpus all habilita el acceso a GPU para una inferencia más rápida. Omítala si solo estás ejecutando en CPU.

Configuración con Docker Compose

Para implementaciones en producción, Docker Compose proporciona una mejor mantenibilidad:

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

ports:

- "11434:11434"

volumes:

- ollama:/root/.ollama

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

open-webui:

image: ghcr.io/open-webui/open-webui:main

ports:

- "3000:8080"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

volumes:

- open-webui:/app/backend/data

depends_on:

- ollama

restart: always

volumes:

ollama:

open-webui:

Implemente con docker-compose up -d.

Implementación en Kubernetes

Para implementaciones empresariales, Open WebUI proporciona gráficos Helm:

helm repo add open-webui https://helm.openwebui.com/

helm repo update

helm install open-webui open-webui/open-webui \

--set ollama.enabled=true \

--set ingress.enabled=true \

--set ingress.host=chat.yourdomain.com

Esto crea una implementación lista para producción con almacenamiento persistente, verificaciones de salud y configuración opcional de entrada.

Análisis profundo de las características principales

RAG y chat con documentos

La implementación de RAG de Open WebUI permite subir documentos y que el modelo los cite en conversaciones. El sistema fragmenta automáticamente los documentos, genera incrustaciones, los almacena en una base de datos vectorial y recupera el contexto relevante cuando se hacen preguntas.

Formatos compatibles: PDF, DOCX, TXT, Markdown, CSV y más a través de analizadores integrados.

Uso: Haga clic en el botón ‘+’ en un chat, seleccione ‘Subir archivos’, elija sus documentos y comience a hacer preguntas. El modelo citará pasajes relevantes y números de página en sus respuestas.

Configuración: Puede ajustar el tamaño del fragmento, superposición, modelo de incrustación y parámetros de recuperación en la configuración de administrador para un rendimiento óptimo con sus tipos de documentos.

Autenticación y gestión multiusuario

Open WebUI incluye un sistema de autenticación completo adecuado para uso en equipos y organizaciones:

- Autenticación local: Nombre de usuario/contraseña con cifrado seguro de contraseñas

- Integración OAuth/OIDC: Conectar a proveedores de identidad existentes (Google, GitHub, Keycloak, etc.)

- LDAP/Active Directory: Integración con directorios empresariales

- Acceso basado en roles: Administrador (control total), Usuario (acceso estándar), Pendiente (requiere aprobación)

Los administradores pueden gestionar usuarios, monitorear el uso, configurar el acceso a modelos por usuario/grupo y establecer políticas de retención de conversaciones.

Entrada y salida de voz

El soporte integrado para interacción por voz hace que Open WebUI sea accesible y conveniente:

- Voz a texto: Usa la API de Web Speech o servicios STT configurados externamente

- Texto a voz: Varios motores TTS compatibles (basados en navegador, Coqui TTS, ElevenLabs, etc.)

- Soporte de idiomas: Trabaja con múltiples idiomas según su configuración de TTS/STT

Herramientas de ingeniería de prompts

Open WebUI proporciona herramientas robustas para la gestión de prompts:

- Biblioteca de prompts: Guarde prompts frecuentes como plantillas

- Variables y marcadores de posición: Cree prompts reutilizables con contenido dinámico

- Compartir prompts: Comparta prompts efectivos con su equipo

- Versionado de prompts: Rastree cambios e mejoras a lo largo del tiempo

Gestión de modelos

Facilita el cambio y gestión de modelos a través de la interfaz:

- Catálogo de modelos: Explore y descargue modelos directamente desde la biblioteca de Ollama

- Modelos personalizados: Suba y configure modelos personalizados GGUF

- Parámetros de modelos: Ajuste temperatura, top-p, longitud de contexto y otros parámetros de muestreo por conversación

- Metadatos de modelos: Vea detalles del modelo, tamaño, cuantización y capacidades

Configuración y personalización

Variables de entorno

Opciones clave de configuración mediante variables de entorno:

# URL del backend (Ollama u otra API compatible con OpenAI)

OLLAMA_BASE_URL=http://localhost:11434

# Habilitar autenticación

WEBUI_AUTH=true

# Rol de usuario por defecto (usuario, administrador, pendiente)

DEFAULT_USER_ROLE=pending

# Habilitar registro de usuarios

ENABLE_SIGNUP=true

# Correo electrónico del administrador (crea automáticamente una cuenta de administrador)

WEBUI_ADMIN_EMAIL=admin@example.com

# Base de datos (por defecto SQLite, o PostgreSQL para producción)

DATABASE_URL=postgresql://user:pass@host:5432/openwebui

# Habilitar RAG

ENABLE_RAG=true

# Modelo de incrustación para RAG

RAG_EMBEDDING_MODEL=sentence-transformers/all-MiniLM-L6-v2

Conectar a backends alternativos

Open WebUI funciona con cualquier API compatible con OpenAI. Configure la URL base en Configuraciones → Conexiones:

- vLLM:

http://localhost:8000/v1 - LocalAI:

http://localhost:8080 - LM Studio:

http://localhost:1234/v1 - Text Generation WebUI:

http://localhost:5000/v1 - OpenAI:

https://api.openai.com/v1(requiere clave API) - Azure OpenAI: URL de punto final personalizado

Configuración de proxy inverso

Para implementaciones en producción, ejecute Open WebUI detrás de un proxy inverso:

Ejemplo de Nginx:

server {

listen 443 ssl http2;

server_name chat.yourdomain.com;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# Soporte para WebSocket

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}

Ejemplo de Traefik (etiquetas de Docker):

labels:

- "traefik.enable=true"

- "traefik.http.routers.openwebui.rule=Host(`chat.yourdomain.com`)"

- "traefik.http.routers.openwebui.entrypoints=websecure"

- "traefik.http.routers.openwebui.tls.certresolver=letsencrypt"

- "traefik.http.services.openwebui.loadbalancer.server.port=8080"

Optimización del rendimiento

Ajuste de base de datos

Para implementaciones multiusuario, cambie de SQLite a PostgreSQL:

# Instalar dependencias

pip install psycopg2-binary

# Configurar URL de base de datos

DATABASE_URL=postgresql://openwebui:password@postgres:5432/openwebui

PostgreSQL maneja mejor a usuarios concurrentes y proporciona un mejor rendimiento de consulta para la búsqueda de conversaciones y operaciones de RAG.

Selección del modelo de incrustación

El rendimiento de RAG depende en gran medida de la elección del modelo de incrustación:

- Rápido/Recursos limitados:

all-MiniLM-L6-v2(384 dimensiones, ~80MB) - Equilibrado:

all-mpnet-base-v2(768 dimensiones, ~420MB) - Mejor calidad:

bge-large-en-v1.5(1024 dimensiones, ~1.3GB)

Configure en Configuraciones → RAG → Modelo de incrustación.

Estrategias de caché

Habilite el caché de conversaciones para reducir llamadas repetidas a la API:

- Caché de modelos: Ollama almacena automáticamente modelos cargados en memoria

- Caché de respuestas: Open WebUI puede cachear prompts idénticos (configurable)

- Caché de incrustaciones: Reutilice incrustaciones para documentos procesados previamente

Buenas prácticas de seguridad

Cuando implemente Open WebUI en producción, siga estas pautas de seguridad:

- Habilite la autenticación: Nunca ejecute Open WebUI sin autenticación en redes públicas

- Use HTTPS: Siempre implemente detrás de un proxy inverso con TLS/SSL

- Actualizaciones periódicas: Mantenga Open WebUI y Ollama actualizados para parches de seguridad

- Restricción de acceso: Use reglas de firewall para limitar el acceso a redes de confianza

- Claves API seguras: Si se conecta a APIs externas, use variables de entorno, nunca codifique claves

- Registros de auditoría: Active y monitoree los registros de acceso para actividad sospechosa

- Copia de seguridad de datos: Realice copias de seguridad periódicas del volumen

/app/backend/data - Cifrado de base de datos: Active el cifrado en reposo para PostgreSQL en producción

- Limitación de tasa: Configure límites de tasa para prevenir el abuso

- Filtrado de contenido: Implemente políticas de contenido adecuadas para su organización

Casos de uso y aplicaciones reales

Asistente de conocimiento personal

Combine Open WebUI con modelos locales y RAG para crear una base de conocimiento privada. Suba sus notas, artículos de investigación, documentación de proyectos y documentos personales. Realice consultas conversacionales sin enviar datos a servicios en la nube—perfecto para investigadores, estudiantes y trabajadores del conocimiento que valoran la privacidad.

Colaboración en equipos de desarrollo

Implemente Open WebUI para su equipo de desarrollo con acceso compartido a documentación técnica, especificaciones de API y conocimiento del código. La función RAG permite a los desarrolladores encontrar rápidamente información relevante en miles de páginas de documentos, mientras que el historial de conversaciones ayuda a rastrear decisiones arquitectónicas y discusiones técnicas.

Chatbot interno empresarial

Las organizaciones pueden implementar Open WebUI detrás de su firewall con integración SSO, proporcionando a los empleados un asistente de IA que tiene acceso a wikis internos, políticas y procedimientos. El control de acceso basado en roles asegura que la información sensible se mantenga segmentada correctamente, mientras que los controles de administración mantienen el gobierno y la conformidad.

Educación y formación

Las instituciones educativas usan Open WebUI para proporcionar a estudiantes y facultad asistencia de IA sin preocupaciones de privacidad. Suba materiales de cursos, libros de texto y notas de clases para preguntas y respuestas contextuales. El sistema multiusuario permite rastrear el uso mientras se mantiene la privacidad de los datos de los estudiantes.

Aplicaciones en salud y legal

En industrias reguladas donde la privacidad de los datos es crítica, Open WebUI permite flujos de trabajo asistidos por IA mientras se mantiene la conformidad con HIPAA o GDPR. Los profesionales médicos pueden consultar bases de datos de medicamentos y protocolos de tratamiento, mientras que los equipos legales pueden buscar casos y contratos—todo sin que los datos salgan de la infraestructura controlada.

Entornos aislados y sin conexión

Las agencias gubernamentales, instalaciones de investigación y centros operativos seguros usan Open WebUI en redes aisladas. La capacidad completa de funcionamiento sin conexión asegura que la asistencia de IA esté disponible incluso sin conexión a Internet, crítica para entornos clasificados o ubicaciones remotas.

Solución de problemas comunes

Problemas de conexión

Problema: Open WebUI no puede conectarse a Ollama

Solución: Verifique que Ollama esté en ejecución (curl http://localhost:11434), revise la variable de entorno OLLAMA_BASE_URL y asegúrese de que las reglas de firewall permitan la conexión. Para implementaciones con Docker, use nombres de servicio (http://ollama:11434) en lugar de localhost.

Problema: Los modelos no aparecen en la interfaz

Solución: Confirme que los modelos están instalados (ollama list), refresque la lista de modelos en la configuración de Open WebUI y revise los registros del navegador para errores de API.

Problemas de carga y RAG

Problema: La carga de documentos falla

Solución: Verifique los límites de tamaño de archivo en la configuración, verifique el formato de archivo compatible, asegúrese de que haya suficiente espacio en el volumen de datos y revise los registros del contenedor para errores de análisis.

Problema: Las respuestas de RAG no citan documentos cargados

Solución: Verifique que el modelo de incrustación esté descargado y en ejecución, revise la configuración del tamaño de fragmento (intente fragmentos más pequeños para mayor granularidad), aumente el número de fragmentos recuperados en la configuración de RAG y asegúrese de que la consulta sea relevante para el contenido del documento.

Problemas de rendimiento

Problema: Tiempos de respuesta lentos

Solución: Active la aceleración de GPU si está disponible, reduzca el tamaño del modelo o use versiones cuantizadas, aumente OLLAMA_NUM_PARALLEL para solicitudes concurrentes y asigne más RAM a los contenedores de Docker.

Problema: Errores de memoria insuficiente

Solución: Use modelos más pequeños (7B en lugar de 13B de parámetros), reduzca la longitud de contexto en los parámetros del modelo, limite a usuarios concurrentes o agregue más RAM/espacio de intercambio a su sistema.

Autenticación y acceso

Problema: No se puede iniciar sesión o crear una cuenta de administrador

Solución: Establezca WEBUI_AUTH=true, configure WEBUI_ADMIN_EMAIL para crear automáticamente una cuenta de administrador, borre cookies y caché del navegador y revise los registros del contenedor para errores de base de datos.

Problema: Los usuarios no pueden registrarse

Solución: Verifique ENABLE_SIGNUP=true, revise la configuración DEFAULT_USER_ROLE (use user para aprobación automática o pending para aprobación manual) y asegúrese de que la base de datos sea escribible.

Alternativas a Open WebUI

Aunque Open WebUI destaca por proporcionar una interfaz autogestionada con una integración fuerte de Ollama, varias alternativas ofrecen enfoques diferentes al mismo problema. Su elección depende de si necesita flexibilidad multi-proveedor, manejo especializado de documentos, simplicidad extrema o características empresariales.

LibreChat se destaca como la solución más independiente del proveedor, ofreciendo soporte nativo para OpenAI, Anthropic, Azure OpenAI, Google Vertex AI, AWS Bedrock y Ollama en una sola interfaz. Su arquitectura de plugins y características empresariales como multi-tenancy, controles de acceso detallados y cuotas de uso lo hacen ideal para organizaciones que necesiten soportar múltiples proveedores de IA o requieran auditorías detalladas. El intercambio es la complejidad—LibreChat requiere más esfuerzo de configuración y recursos más pesados que Open WebUI, y su soporte de Ollama parece secundario a los proveedores en la nube. Si su equipo usa Claude para escribir, GPT-4 para codificar y modelos locales para trabajos sensibles a la privacidad, la interfaz unificada de LibreChat resplandece.

Para flujos de trabajo intensivos en documentos, AnythingLLM toma un enfoque basado en la base de conocimiento que va más allá del RAG básico. Su modelo de espacio de trabajo organiza documentos y conversaciones en entornos aislados, mientras que las características avanzadas de recuperación incluyen búsqueda híbrida, reordenamiento y seguimiento de citas. Los conectores de datos extraen contenido de GitHub, Confluence y Google Drive, y las capacidades de agentes permiten razonamiento multi-paso y automatización de flujos de trabajo. Esto hace que AnythingLLM sea excelente para consultorías que gestionan múltiples bases de conocimiento de clientes o equipos de soporte que trabajan con documentación extensa. La interfaz de chat es menos pulida que la de Open WebUI, pero si la consulta de grandes colecciones de documentos es su necesidad principal, las avanzadas capacidades de recuperación justifican la curva de aprendizaje más empinada.

LobeChat prioriza la experiencia del usuario sobre la profundidad de las características, ofreciendo una interfaz elegante, amigable para dispositivos móviles con capacidades de aplicación web progresiva. Su diseño moderno, animaciones suaves y fuerte soporte de voz/multimodal lo hacen popular entre diseñadores y usuarios no técnicos que desean un asistente de IA que funcione de forma fluida en múltiples dispositivos. La implementación PWA proporciona una experiencia de aplicación móvil similar a la que Open WebUI no puede igualar. Sin embargo, las características empresariales son limitadas, el ecosistema de plugins es más pequeño y las capacidades de RAG retrasan tanto a Open WebUI como a AnythingLLM.

Para usuarios que prefieren aplicaciones de escritorio, Jan.ai proporciona instaladores multiplataforma (Windows, macOS, Linux) con gestión local de modelos sin configuración. No es necesario instalar Ollama por separado ni lidiar con Docker—Jan combina todo en una aplicación nativa con soporte de bandeja del sistema y descargas de modelos con un solo clic. Esta filosofía de “funciona desde el primer momento” hace que Jan sea ideal para dar modelos locales a familiares o colegas que no están cómodos con herramientas de línea de comandos. Los intercambios son la falta de soporte multiusuario, menos características avanzadas y la falta de capacidad de acceso remoto.

Chatbox ocupa la nicho ligero—un cliente multiplataforma minimalista que soporta OpenAI, Claude, Gemini y APIs locales con un muy bajo gasto de recursos. Es perfecto para desarrolladores que necesiten probar rápidamente diferentes proveedores de API o usuarios con hardware de recursos limitados. El fricción de configuración es mínima, pero algunas características están limitadas por suscripción, no es totalmente de código abierto y el soporte de RAG es limitado.

Varias interfaz minimalistas específicas de Ollama existen para usuarios que desean “solo lo suficiente”: Hollama gestiona múltiples servidores de Ollama en diferentes máquinas, Ollama UI proporciona chat básico y carga de PDF con una implementación extremadamente fácil de desplegar, y Oterm ofrece una interfaz de terminal sorprendentemente capaz para sesiones SSH y flujos de trabajo tmux. Estos sacrifican características por simplicidad y velocidad.

Para organizaciones que requieren soporte de proveedor, opciones comerciales como TypingMind Team, BionicGPT y Dust.tt ofrecen autogestión con respaldo profesional, certificaciones de cumplimiento y SLAs. Intercambian la libertad de código abierto por garantía de disponibilidad, auditorías de seguridad y responsabilidad—apropiadas cuando su organización necesita contratos de soporte empresarial.

Elegir sabiamente: Open WebUI golpea el punto dulce para la mayoría de las implementaciones autogestionadas de Ollama, equilibrando características completas con una complejidad manejable. Elija LibreChat cuando la flexibilidad multi-proveedor sea primordial, AnythingLLM para flujos de trabajo avanzados de documentos, LobeChat para usuarios móviles o conscientes del diseño, Jan para usuarios no técnicos de escritorio o opciones comerciales cuando necesite soporte de proveedor. Para la mayoría de los usuarios técnicos que ejecutan modelos locales, el desarrollo activo, la comunidad fuerte y la excelente implementación de RAG de Open WebUI lo hacen el punto de partida recomendado.

Desarrollos futuros y roadmap

Open WebUI continúa con un desarrollo rápido con varias características emocionantes en el roadmap:

Mejora del soporte multimodal: Mejor manejo de imágenes, modelos de visión y conversaciones multimodales con modelos como LLaVA y Bakllava.

Capacidades de agentes mejoradas: Llamada de funciones, uso de herramientas y flujos de trabajo de razonamiento multi-paso similares a los de AutoGPT.

Mejor experiencia móvil: Aplicaciones nativas para iOS y Android más allá de la implementación actual de PWA para una mejor experiencia móvil.

Características avanzadas de RAG: RAG basado en gráficos, segmentación semántica, recuperación de múltiples consultas y recuperación de documentos padre para un mejor contexto.

Características colaborativas: Conversaciones compartidas, espacios de trabajo de equipo y colaboración en tiempo real en prompts y documentos.

Integraciones empresariales: Soporte más profundo de SSO, provisionamiento SCIM, registros de auditoría avanzados y reportes de cumplimiento para industrias reguladas.

El proyecto mantiene la compatibilidad hacia atrás y el versionado semántico, haciendo que las actualizaciones sean sencillas. El repositorio activo de GitHub ve commits diarios y gestión de problemas receptiva.

Conclusión

Open WebUI ha evolucionado de una simple interfaz frontal de Ollama a una plataforma completa para interacciones de IA autogestionadas. Su combinación de privacidad, características y facilidad de implementación lo hacen una excelente opción para individuos, equipos y organizaciones que deseen aprovechar modelos locales de LLM sin sacrificar capacidades.

Ya seas un desarrollador probando modelos, una organización construyendo herramientas de IA internas o un individuo que prioriza la privacidad, Open WebUI proporciona la base para potentes flujos de trabajo de IA autogestionados. La comunidad activa, actualizaciones regulares y arquitectura extensible aseguran que permanezca una opción líder en el espacio de IA autogestionada.

Empiece con la instalación básica de Docker, experimente con RAG subiendo algunos documentos, pruebe diferentes modelos de la biblioteca de Ollama y explore gradualmente características avanzadas a medida que crezcan sus necesidades. La curva de aprendizaje es suave, pero el techo es alto—Open WebUI se escala desde una laptop personal a un clúster de Kubernetes empresarial.

Para aquellos que comparan alternativas, el diseño de Open WebUI centrado en Ollama, conjunto equilibrado de características y desarrollo activo lo hacen el punto de partida recomendado para la mayoría de las implementaciones de LLM autogestionadas. Puedes siempre migrar a soluciones más especializadas si surgen necesidades específicas, pero muchos usuarios encuentran que las capacidades de Open WebUI son suficientes para su viaje completo desde la experimentación hasta la producción.

Para ver cómo los backends típicos de Open WebUI (Ollama, vLLM, etc.) se ajustan con Docker Model Runner, LocalAI y proveedores en la nube, consulte nuestra guía LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

Enlaces útiles

Cuando configure su entorno de Open WebUI, le beneficiará entender el ecosistema más amplio de opciones de alojamiento y despliegue de LLM locales. La guía completa Local LLM Hosting: Complete 2025 Guide - Ollama, vLLM, LocalAI, Jan, LM Studio & More compara 12+ herramientas locales de LLM incluyendo Ollama, vLLM, LocalAI y otras, ayudándole a elegir el backend óptimo para su implementación de Open WebUI basado en la madurez de API, capacidades de llamada de herramientas y benchmarks de rendimiento.

Para despliegues de producción de alto rendimiento donde el throughput y la latencia son críticos, explore la guía vLLM Quickstart: High-Performance LLM Serving, que cubre la configuración de vLLM con Docker, compatibilidad con API de OpenAI y optimización de PagedAttention. Esto es particularmente valioso si Open WebUI está sirviendo múltiples usuarios concurrentes y el rendimiento de Ollama se convierte en un cuello de botella.

Entender cómo su backend maneja solicitudes concurrentes es crucial para la planificación de capacidad. El artículo How Ollama Handles Parallel Requests explica el modelo de cola de solicitudes, gestión de memoria de GPU y ejecución concurrente de Ollama, ayudándole a configurar límites y expectativas adecuados para escenarios multiusuario de su implementación de Open WebUI.

Recursos externos

Para documentación oficial y soporte de la comunidad, consulte estos recursos externos: