Incrustaciones Multimodales: Conectando Modalidades de IA

Unifique texto, imágenes y audio en espacios de incrustación compartidos

Embeddings cruzales representan un avance significativo en inteligencia artificial, permitiendo entender y razonar entre diferentes tipos de datos dentro de un espacio de representación unificado.

Esta tecnología impulsa aplicaciones multimodales modernas, desde la búsqueda de imágenes hasta la generación de contenido.

Esta imagen proviene del artículo:

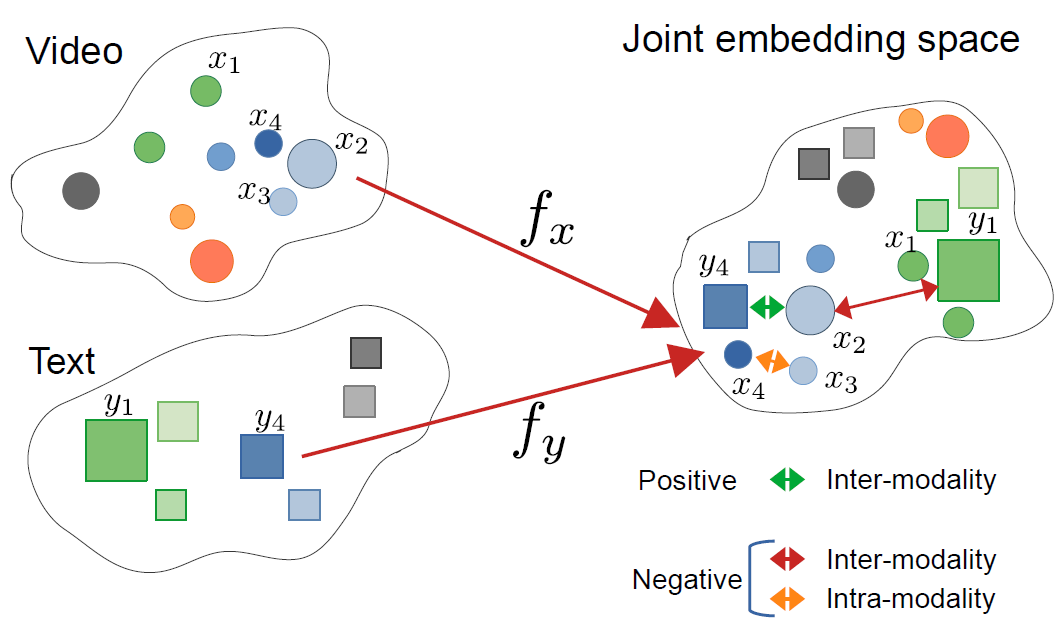

CrossCLR: aprendizaje contrastivo cruzal para representaciones de video multimodal, por Mohammadreza Zolfaghari y otros

Esta imagen proviene del artículo:

CrossCLR: aprendizaje contrastivo cruzal para representaciones de video multimodal, por Mohammadreza Zolfaghari y otros

Entendiendo los Embeddings Cruzales

Los embeddings cruzales son representaciones vectoriales que codifican información de diferentes modalidades—como texto, imágenes, audio y video—en un espacio de embedding compartido. A diferencia de los embeddings tradicionales de una sola modalidad, los enfoques cruzales aprenden una representación unificada donde los conceptos semánticamente similares se agrupan juntos, independientemente de su formato original.

¿Qué son los Embeddings Cruzales?

En su núcleo, los embeddings cruzales resuelven un desafío crítico en la IA: cómo comparar y relacionar información entre diferentes tipos de datos. Un clasificador de imágenes tradicional solo puede trabajar con imágenes, mientras que un modelo de texto maneja solo texto. Los embeddings cruzales cierran esta brecha proyectando diferentes modalidades en un espacio de vector común donde:

- Una imagen de un gato y la palabra “gato” tienen vectores de embedding similares

- Las relaciones semánticas se preservan entre modalidades

- Las métricas de distancia (similitud del coseno, distancia euclidiana) miden la similitud cruzada

Esta representación unificada permite capacidades poderosas, como buscar imágenes usando consultas de texto, generar descripciones de imágenes o incluso clasificación de cero ejemplos sin entrenamiento específico para la tarea.

La Arquitectura detrás del Aprendizaje Cruzal

Los sistemas modernos de embeddings cruzales suelen emplear arquitecturas de codificadores duales con objetivos de aprendizaje contrastivo:

Codificadores Duales: Redes neuronales separadas codifican cada modalidad. Por ejemplo, CLIP utiliza:

- Un transformer de visión (ViT) o ResNet para imágenes

- Un codificador de texto basado en transformer para el lenguaje

Aprendizaje Contrastivo: El modelo aprende maximizando la similitud entre pares coincidentes (por ejemplo, imagen y su descripción) mientras minimiza la similitud entre pares no coincidentes. La función de pérdida contrastiva se puede expresar como:

$$ \mathcal{L} = -\log \frac{\exp(\text{sim}(v_i, t_i) / \tau)}{\sum_{j=1}^{N} \exp(\text{sim}(v_i, t_j) / \tau)} $$

donde $v_i$ es el embedding de la imagen, $t_i$ es el embedding del texto, $\text{sim}$ es la similitud (normalmente el coseno) y $\tau$ es un parámetro de temperatura.

Tecnologías Clave y Modelos

CLIP: Pionero en Entendimiento Visión-Lenguaje

CLIP (Contrastive Language-Image Pre-training) de OpenAI revolucionó el campo al entrenar en 400 millones de pares imagen-texto de internet. La arquitectura del modelo consta de:

import torch

from transformers import CLIPProcessor, CLIPModel

from PIL import Image

# Cargar modelo CLIP preentrenado

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

# Preparar entradas

image = Image.open("ejemplo.jpg")

texts = ["una foto de un gato", "una foto de un perro", "una foto de un pájaro"]

# Procesar y obtener embeddings

inputs = processor(text=texts, images=image, return_tensors="pt", padding=True)

# Obtener puntajes de similitud cruzada

outputs = model(**inputs)

logits_per_image = outputs.logits_per_image

probs = logits_per_image.softmax(dim=1)

print(f"Probabilidades: {probs}")

La innovación clave de CLIP fue su escala y simplicidad. Al entrenar en datos de gran tamaño a escala web sin anotaciones manuales, logró capacidades notables de transferencia de cero ejemplos. ¿Cómo se diferencia CLIP de modelos de visión tradicionales? A diferencia de clasificadores supervisados entrenados en conjuntos de etiquetas fijos, CLIP aprende de la supervisión del lenguaje natural, lo que lo hace adaptable a cualquier concepto visual describible en texto.

ImageBind: Extendiendo a Seis Modalidades

ImageBind de Meta extiende los embeddings cruzales más allá de la visión y el lenguaje para incluir:

- Audio (sonidos ambientales, habla)

- Información de profundidad

- Imágenes térmicas

- Datos de IMU (sensor de movimiento)

Esto crea un espacio de embedding multimodal verdadero donde todas las seis modalidades están alineadas. La idea clave es que las imágenes sirven como una “modalidad de unión”—al emparejar imágenes con otras modalidades y aprovechar la alineación existente entre visión y lenguaje, ImageBind crea un espacio unificado sin requerir todos los posibles pares de modalidades durante el entrenamiento.

Alternativas de Código Abierto

El ecosistema se ha expandido con varias implementaciones de código abierto:

OpenCLIP: Una implementación comunitaria que ofrece modelos más grandes y recetas de entrenamiento diversas:

import open_clip

model, _, preprocess = open_clip.create_model_and_transforms(

'ViT-L-14',

pretrained='laion2b_s32b_b82k'

)

tokenizer = open_clip.get_tokenizer('ViT-L-14')

Modelos LAION-5B: Entrenados en el gran conjunto de datos abierto LAION-5B, ofrecen alternativas a modelos propietarios con un rendimiento comparable o mejor.

Para desarrolladores interesados en soluciones de código abierto de estado de la artes para embeddings de texto, los modelos de embedding y reordenamiento de Qwen3 en Ollama ofrecen un excelente rendimiento multilingüe con un despliegue local fácil.

Estrategias de Implementación

Construyendo un Sistema de Búsqueda Cruzal

Una implementación práctica de embeddings cruzales para búsqueda semántica implica varios componentes. ¿Cuáles son las principales aplicaciones de los embeddings cruzales? Poder casos de uso desde la búsqueda de productos en e-commerce hasta la moderación de contenido y herramientas creativas.

import numpy as np

from typing import List, Tuple

import faiss

from transformers import CLIPModel, CLIPProcessor

class CrossModalSearchEngine:

def __init__(self, model_name: str = "openai/clip-vit-base-patch32"):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.image_index = None

self.image_metadata = []

def encode_images(self, images: List) -> np.ndarray:

"""Codificar imágenes en embeddings"""

inputs = self.processor(images=images, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_image_features(**inputs)

return embeddings.cpu().numpy()

def encode_text(self, texts: List[str]) -> np.ndarray:

"""Codificar consultas de texto en embeddings"""

inputs = self.processor(text=texts, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_text_features(**inputs)

return embeddings.cpu().numpy()

def build_index(self, image_embeddings: np.ndarray):

"""Construir índice FAISS para búsqueda eficiente de similitud"""

dimension = image_embeddings.shape[1]

# Normalizar embeddings para similitud del coseno

faiss.normalize_L2(image_embeddings)

# Crear índice (usando HNSW para despliegue a gran escala)

self.image_index = faiss.IndexHNSWFlat(dimension, 32)

self.image_index.hnsw.efConstruction = 40

self.image_index.add(image_embeddings)

def search(self, query: str, k: int = 10) -> List[Tuple[int, float]]:

"""Buscar imágenes usando consulta de texto"""

query_embedding = self.encode_text([query])

faiss.normalize_L2(query_embedding)

distances, indices = self.image_index.search(query_embedding, k)

return list(zip(indices[0], distances[0]))

# Ejemplo de uso

engine = CrossModalSearchEngine()

# Construir índice desde la colección de imágenes

image_embeddings = engine.encode_images(image_collection)

engine.build_index(image_embeddings)

# Buscar con texto

results = engine.search("atardecer sobre montañas", k=5)

Ajuste Fino para Tareas Específicas del Dominio

Aunque los modelos preentrenados funcionan bien para propósitos generales, las aplicaciones específicas del dominio se benefician del ajuste fino:

from transformers import CLIPModel, CLIPProcessor, AdamW

import torch.nn as nn

class FineTuneCLIP:

def __init__(self, model_name: str, num_epochs: int = 10):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.num_epochs = num_epochs

def contrastive_loss(self, image_embeddings, text_embeddings, temperature=0.07):

"""Calcular pérdida contrastiva InfoNCE"""

# Normalizar embeddings

image_embeddings = nn.functional.normalize(image_embeddings, dim=1)

text_embeddings = nn.functional.normalize(text_embeddings, dim=1)

# Calcular matriz de similitud

logits = torch.matmul(image_embeddings, text_embeddings.T) / temperature

# Etiquetas son diagonales (pares coincidentes)

labels = torch.arange(len(logits), device=logits.device)

# Pérdida simétrica

loss_i = nn.functional.cross_entropy(logits, labels)

loss_t = nn.functional.cross_entropy(logits.T, labels)

return (loss_i + loss_t) / 2

def train(self, dataloader, learning_rate=5e-6):

"""Ajustar en datos específicos del dominio"""

optimizer = AdamW(self.model.parameters(), lr=learning_rate)

self.model.train()

for epoch in range(self.num_epochs):

total_loss = 0

for batch in dataloader:

images, texts = batch['images'], batch['texts']

# Procesar entradas

inputs = self.processor(

text=texts,

images=images,

return_tensors="pt",

padding=True

)

# Paso hacia adelante

outputs = self.model(**inputs, return_loss=True)

loss = outputs.loss

# Paso hacia atrás

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_loss += loss.item()

avg_loss = total_loss / len(dataloader)

print(f"Época {epoch+1}/{self.num_epochs}, Pérdida: {avg_loss:.4f}")

Consideraciones para el Despliegue en Producción

Optimizar el Rendimiento de la Inferencia

¿Cómo puedo optimizar los embeddings cruzales para producción? La optimización del rendimiento es crítica para el despliegue en el mundo real:

Cuantización del Modelo: Reducir el tamaño del modelo y aumentar la velocidad de inferencia:

import torch

from torch.quantization import quantize_dynamic

# Cuantización dinámica para inferencia en CPU

quantized_model = quantize_dynamic(

model,

{torch.nn.Linear},

dtype=torch.qint8

)

Conversión a ONNX: Exportar a ONNX para inferencia optimizada:

import torch.onnx

dummy_input = processor(text=["muestra"], return_tensors="pt")

torch.onnx.export(

model,

tuple(dummy_input.values()),

"clip_model.onnx",

input_names=['input_ids', 'attention_mask'],

output_names=['output'],

dynamic_axes={

'input_ids': {0: 'batch_size'},

'attention_mask': {0: 'batch_size'}

}

)

Procesamiento por Lotes: Maximizar el uso de la GPU mediante el procesamiento por lotes:

def batch_encode(items: List, batch_size: int = 32):

"""Procesar elementos en lotes para eficiencia"""

embeddings = []

for i in range(0, len(items), batch_size):

batch = items[i:i+batch_size]

batch_embeddings = encode_batch(batch)

embeddings.append(batch_embeddings)

return np.concatenate(embeddings, axis=0)

Almacenamiento Escalable de Vectores

Para aplicaciones a gran escala, las bases de datos de vectores son esenciales. ¿Cuáles marcos admiten implementaciones de embeddings cruzales? Más allá de los modelos mismos, la infraestructura importa:

FAISS (Facebook AI Similarity Search): Biblioteca eficiente para búsqueda de similitud

- Soporta miles de millones de vectores

- Varios tipos de índice (plano, IVF, HNSW)

- Aceleración de GPU disponible

Milvus: Base de datos vectorial de código abierto

from pymilvus import connections, Collection, FieldSchema, CollectionSchema, DataType

# Definir esquema

fields = [

FieldSchema(name="id", dtype=DataType.INT64, is_primary=True, auto_id=True),

FieldSchema(name="embedding", dtype=DataType.FLOAT_VECTOR, dim=512),

FieldSchema(name="metadata", dtype=DataType.JSON)

]

schema = CollectionSchema(fields, description="Embeddings de imágenes")

# Crear colección

collection = Collection("imágenes", schema)

# Crear índice

index_params = {

"metric_type": "IP", # Producto interno (similitud del coseno)

"index_type": "IVF_FLAT",

"params": {"nlist": 1024}

}

collection.create_index("embedding", index_params)

Pinecone/Weaviate: Servicios de bases de datos vectoriales gestionadas que ofrecen escalabilidad y mantenimiento fácil.

Casos de Uso Avanzados y Aplicaciones

Clasificación de Cero Ejemplos

Los embeddings cruzales permiten la clasificación sin entrenamiento específico para la tarea. Esta capacidad se extiende más allá de los enfoques tradicionales de visión por computadora—por ejemplo, si estás interesado en una detección de objetos más especializada con TensorFlow, representa un enfoque de aprendizaje supervisado complementario para tareas específicas de detección.

def zero_shot_classify(image, candidate_labels: List[str], model, processor):

"""Clasificar imagen en categorías arbitrarias"""

# Crear prompts de texto

text_inputs = [f"una foto de un {label}" for label in candidate_labels]

# Obtener embeddings

inputs = processor(

text=text_inputs,

images=image,

return_tensors="pt",

padding=True

)

outputs = model(**inputs)

# Calcular probabilidades

logits = outputs.logits_per_image

probs = logits.softmax(dim=1)

# Devolver predicciones ordenadas

sorted_indices = probs.argsort(descending=True)[0]

return [(candidate_labels[idx], probs[0][idx].item()) for idx in sorted_indices]

# Ejemplo de uso

labels = ["gato", "perro", "pájaro", "pez", "caballo"]

predictions = zero_shot_classify(image, labels, model, processor)

print(f"Predicción principal: {predictions[0]}")

RAG Multimodal (Retrieval-Augmented Generation)

Combinar embeddings cruzales con modelos de lenguaje crea poderosos sistemas RAG multimodales. Una vez que has recuperado documentos relevantes, reordenar con modelos de embedding puede mejorar significativamente la calidad de los resultados reordenando los candidatos recuperados según su relevancia:

class MultimodalRAG:

def __init__(self, clip_model, llm_model):

self.clip = clip_model

self.llm = llm_model

self.knowledge_base = []

def add_documents(self, images, texts, metadata):

"""Añadir documentos multimodales a la base de conocimiento"""

image_embeds = self.clip.encode_images(images)

text_embeds = self.clip.encode_text(texts)

# Almacenar información combinada

for i, (img_emb, txt_emb, meta) in enumerate(

zip(image_embeds, text_embeds, metadata)

):

self.knowledge_base.append({

'image_embedding': img_emb,

'text_embedding': txt_emb,

'metadata': meta,

'index': i

})

def retrieve(self, query: str, k: int = 5):

"""Recuperar contenido multimodal relevante"""

query_embedding = self.clip.encode_text([query])[0]

# Calcular similitudes

similarities = []

for doc in self.knowledge_base:

# Promedio de similitud entre modalidades

img_sim = np.dot(query_embedding, doc['image_embedding'])

txt_sim = np.dot(query_embedding, doc['text_embedding'])

combined_sim = (img_sim + txt_sim) / 2

similarities.append((combined_sim, doc))

# Devolver top-k

similarities.sort(reverse=True)

return [doc for _, doc in similarities[:k]]

def answer_query(self, query: str):

"""Responder consulta usando contexto recuperado"""

retrieved_docs = self.retrieve(query)

# Construir contexto desde documentos recuperados

context = "\n".join([doc['metadata']['text'] for doc in retrieved_docs])

# Generar respuesta con LLM

prompt = f"Contexto:\n{context}\n\nPregunta: {query}\n\nRespuesta:"

answer = self.llm.generate(prompt)

return answer, retrieved_docs

Si estás implementando sistemas RAG de producción en Go, podrías encontrar útil esta guía sobre reordenar documentos de texto con Ollama y modelo de embedding Qwen3 en Go para optimizar la calidad de recuperación.

Moderación de Contenido y Seguridad

Los embeddings cruzales excelentes en la detección de contenido inapropiado a través de modalidades:

class ContentModerator:

def __init__(self, model, processor):

self.model = model

self.processor = processor

# Definir categorías de seguridad

self.unsafe_categories = [

"contenido violento",

"contenido adulto",

"imagen odiosa",

"violencia gráfica",

"material explícito"

]

self.safe_categories = [

"seguro para el trabajo",

"familiar amigable",

"contenido educativo"

]

def moderate_image(self, image, threshold: float = 0.3):

"""Verificar si la imagen contiene contenido inseguro"""

# Combinar todas las categorías

all_categories = self.unsafe_categories + self.safe_categories

text_inputs = [f"imagen que contiene {cat}" for cat in all_categories]

# Obtener predicciones

inputs = self.processor(

text=text_inputs,

images=image,

return_tensors="pt"

)

outputs = self.model(**inputs)

probs = outputs.logits_per_image.softmax(dim=1)[0]

# Verificar categorías inseguras

unsafe_scores = probs[:len(self.unsafe_categories)]

max_unsafe_score = unsafe_scores.max().item()

return {

'is_safe': max_unsafe_score < threshold,

'confidence': 1 - max_unsafe_score,

'flagged_categories': [

self.unsafe_categories[i]

for i, score in enumerate(unsafe_scores)

if score > threshold

]

}

Buenas Prácticas y Errores Comunes

Preprocesamiento de Datos

El preprocesamiento adecuado es crucial para un rendimiento óptimo:

from torchvision import transforms

# Preprocesamiento estándar de CLIP

clip_transform = transforms.Compose([

transforms.Resize(224, interpolation=transforms.InterpolationMode.BICUBIC),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(

mean=[0.48145466, 0.4578275, 0.40821073],

std=[0.26862954, 0.26130258, 0.27577711]

)

])

Manejo de Sesgos y Equidad

Los modelos cruzales pueden heredar sesgos de los datos de entrenamiento:

Estrategias de mitigación:

- Evaluar en grupos demográficos diversos

- Usar técnicas de deseses durante el ajuste fino

- Implementar recuperación con conciencia de equidad

- Auditoría y monitoreo regulares en producción

Evaluación de Calidad de Embedding

Monitorear la calidad de los embeddings en producción:

def assess_embedding_quality(embeddings: np.ndarray):

"""Calcular métricas para la calidad de los embeddings"""

# Calcular distancia promedio entre pares

distances = np.linalg.norm(

embeddings[:, None] - embeddings[None, :],

axis=2

)

avg_distance = distances.mean()

# Verificar agrupamiento (baja distancia intra-clúster)

from sklearn.cluster import KMeans

kmeans = KMeans(n_clusters=10)

labels = kmeans.fit_predict(embeddings)

# Calcular puntaje de silueta

from sklearn.metrics import silhouette_score

score = silhouette_score(embeddings, labels)

return {

'avg_pairwise_distance': avg_distance,

'silhouette_score': score

}

Ejemplo de Despliegue con Docker

Empaquetar tu aplicación de embeddings cruzales para un despliegue fácil:

FROM nvidia/cuda:11.8.0-cudnn8-runtime-ubuntu22.04

# Instalar Python y dependencias

RUN apt-get update && apt-get install -y python3-pip

WORKDIR /app

# Instalar requisitos

COPY requirements.txt .

RUN pip3 install --no-cache-dir -r requirements.txt

# Copiar código de la aplicación

COPY . .

# Exponer puerto de API

EXPOSE 8000

# Ejecutar servidor de API

CMD ["uvicorn", "api:app", "--host", "0.0.0.0", "--port", "8000"]

# api.py - Servidor FastAPI para embeddings cruzales

from fastapi import FastAPI, File, UploadFile

from pydantic import BaseModel

import torch

from PIL import Image

import io

app = FastAPI()

# Cargar modelo al inicio

@app.on_event("startup")

async def load_model():

global model, processor

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

if torch.cuda.is_available():

model = model.cuda()

class TextQuery(BaseModel):

text: str

@app.post("/embed/text")

async def embed_text(query: TextQuery):

inputs = processor(text=[query.text], return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_text_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/embed/image")

async def embed_image(file: UploadFile = File(...)):

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(images=image, return_tensors="pt")

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_image_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/similarity")

async def compute_similarity(

text: TextQuery,

file: UploadFile = File(...)

):

# Obtener ambos embeddings

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(text=[text.text], images=image, return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

outputs = model(**inputs)

similarity = outputs.logits_per_image[0][0].item()

return {"similarity": similarity}

Direcciones Futuras

El campo de los embeddings cruzales continúa evolucionando rápidamente:

Mayor Cobertura de Modalidades: Los modelos futuros probablemente incorporarán más modalidades como el tacto (retroalimentación háptica), el olfato y el sabor para un entendimiento multimodal más completo.

Mejora de Eficiencia: Investigación en distilación y arquitecturas eficientes hará que los poderosos modelos de embeddings cruzales sean accesibles en dispositivos de borde.

Mejor Alineación: Técnicas avanzadas para alinear modalidades con mayor precisión, incluyendo pérdidas de consistencia cíclica y entrenamiento adversarial.

Comprensión Composicional: Pasar más allá de la simple identificación de objetos para comprender relaciones y composiciones complejas entre modalidades.

Modelado Temporal: Mejor manejo de video y datos de series temporales con razonamiento temporal explícito en espacios de embedding.

Enlaces Útiles

- Repositorio de CLIP de OpenAI

- OpenCLIP: Implementación de Código Abierto

- Documentación de Transformers de Hugging Face

- ImageBind de Meta

- Conjunto de datos LAION-5B

- Documentación de FAISS

- Base de datos vectorial Milvus

- Base de datos vectorial Pinecone

- Papel: Aprendiendo modelos visuales transferibles desde la supervisión del lenguaje natural

- Papel: ImageBind: Un espacio de embedding para unirlos todos

- Detección de objetos con TensorFlow

- Reordenamiento con modelos de embedding

- Reordenamiento de documentos de texto con Ollama y modelo de embedding Qwen3 - en Go

- Modelos de embedding y reordenamiento de Qwen3 en Ollama: Rendimiento de estado de la artes

Los embeddings cruzales representan un cambio de paradigma en cómo los sistemas de IA procesan e entienden la información. Al romper las barreras entre diferentes tipos de datos, estas técnicas permiten aplicaciones de IA más naturales y capaces. Ya sea que estés construyendo sistemas de búsqueda, herramientas de moderación de contenido o aplicaciones creativas, dominar los embeddings cruzales abre un mundo de posibilidades para la innovación en IA multimodal.