Docker Model Runner vs Ollama (2026): ¿Cuál es mejor para LLMs locales?

Compare Docker Model Runner y Ollama para LLM local

Correr modelos de lenguaje grandes (LLMs) localmente ha ganado popularidad cada vez mayor por razones de privacidad, control de costos y capacidades fuera de línea. El paisaje cambió significativamente en abril de 2025 cuando Docker introdujo Docker Model Runner (DMR), su solución oficial para la implementación de modelos de IA.

Ahora tres enfoques compiten por el interés de los desarrolladores: el Model Runner nativo de Docker, soluciones de terceros contenedorizadas (vLLM, TGI) y la plataforma independiente Ollama.

Para una visión más amplia que incluya proveedores de la nube y consideraciones de infraestructura, consulte Hosting de LLM: Comparación entre infraestructura local, autogestionada y en la nube.

TL;DR – Docker Model Runner vs Ollama

Esta comparación se centra en correr modelos de lenguaje grandes (LLMs) localmente usando Docker o runtimes independientes, cubriendo rendimiento, soporte de GPU, compatibilidad con API y escenarios de implementación en producción.

- Mejor para flujos de trabajo nativos de Docker: Docker Model Runner

- Mejor para simplicidad y prototipado rápido: Ollama

- Mejor para Kubernetes y orquestación: Configuraciones basadas en Docker

- Mejor para desarrollo en una sola máquina: Ollama

Si ya estás usando Docker intensivamente, DMR tiene sentido.

Si quieres la forma más rápida de correr LLMs localmente, Ollama es más sencillo.

Si estás comparando más de solo Docker Model Runner y Ollama, consulta nuestro análisis completo de Ollama vs vLLM vs LM Studio y otras herramientas locales de LLM. Ese guía compara la madurez de la API, soporte de hardware, llamadas de herramientas y preparación para producción en más de 12 runtimes locales de LLM.

Comparación directa entre Docker Model Runner y Ollama

Con la entrada oficial de Docker en el espacio de ejecución de LLM, la comparación se vuelve más interesante. Aquí está cómo DMR y Ollama se comparan cara a cara:

| Característica | Docker Model Runner | Ollama |

|---|---|---|

| Instalación | Pestaña de AI en Docker Desktop o docker-model-plugin |

Un solo comando: curl | sh |

| Estilo de Comando | docker model pull/run/package |

ollama pull/run/list |

| Formato del Modelo | GGUF (OCI Artifacts) | GGUF (nativo) |

| Distribución del Modelo | Docker Hub, registros OCI | Registro de Ollama |

| Configuración de GPU | Automática (más sencilla que la tradicional de Docker) | Automática |

| API | Compatible con OpenAI | Compatible con OpenAI |

| Integración con Docker | Nativa (es Docker) | Se ejecuta en Docker si es necesario |

| Soporte de Compose | Nativo | A través de la imagen de Docker |

| Curva de Aprendizaje | Baja (para usuarios de Docker) | Más baja (para todos) |

| Socios del Ecosistema | Google, Hugging Face, VMware | LangChain, CrewAI, Open WebUI |

| Mejor Para | Flujos de trabajo nativos de Docker | Simplicidad independiente |

Insight Clave: DMR lleva los flujos de trabajo de Docker a la implementación de LLM, mientras que Ollama permanece agnóstico de marcos con una operación independiente más sencilla. Su infraestructura existente importa más que las diferencias técnicas.

¿Es Docker Model Runner mejor que Ollama?

Depende de tu flujo de trabajo.

- Elige Docker Model Runner (DMR) si tu equipo ya depende intensivamente de Docker, artefactos OCI y orquestación de contenedores.

- Elige Ollama si quieres la forma más sencilla de correr LLMs localmente con mínima configuración y prototipado rápido.

Para la mayoría de los entornos de una sola máquina, Ollama es más fácil de usar.

Para flujos de trabajo de CI/CD nativos de Docker y orquestación empresarial, DMR se integra de forma más natural.

Cómo correr un LLM en Docker: DMR vs Ollama

Si tu objetivo es simplemente correr un LLM dentro de Docker, tanto Docker Model Runner como Ollama en contenedores de Docker pueden lograrlo.

Docker Model Runner usa comandos nativos docker model pull y docker model run, empaquetando modelos como artefactos OCI.

Ollama también puede correr dentro de Docker usando la imagen oficial ollama/ollama, exponiendo una API compatible con OpenAI en el puerto 11434.

La diferencia clave está en la integración del flujo de trabajo:

- DMR se adapta naturalmente a pipelines de CI/CD nativos de Docker.

- Ollama en Docker ofrece una gestión más sencilla de modelos con flexibilidad de orquestación de Docker.

Entendiendo los runners de modelos de Docker

Los runners de modelos basados en Docker usan contenerización para empaquetar motores de inferencia de LLM junto con sus dependencias. El paisaje incluye tanto la solución oficial de Docker como marcos de terceros.

Docker Model Runner (DMR) - Solución Oficial

En abril de 2025, Docker introdujo Docker Model Runner (DMR), un producto oficial diseñado para simplificar la ejecución de modelos de IA localmente usando la infraestructura de Docker. Esto representa el compromiso de Docker de hacer la implementación de modelos de IA tan sencilla como la implementación de contenedores.

Características Clave de DMR:

- Integración Nativa con Docker: Usa comandos familiares de Docker (

docker model pull,docker model run,docker model package) - Empaquetado como Artefactos OCI: Los modelos se empaquetan como artefactos OCI, permitiendo su distribución a través de Docker Hub y otros registros

- API Compatible con OpenAI: Reemplazo directo para puntos finales de OpenAI, simplificando la integración

- Aceleración con GPU: Soporte nativo de GPU sin configuración compleja de nvidia-docker

- Soporte del Formato GGUF: Trabaja con formatos populares de modelos cuantizados

- Integración con Docker Compose: Configura y despliega modelos fácilmente usando herramientas estándar de Docker

- Soporte de Testcontainers: Se integra de forma sencilla con marcos de prueba

Instalación:

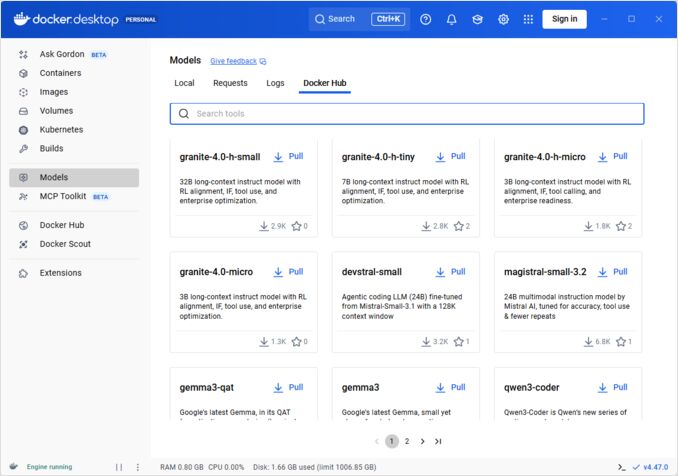

- Docker Desktop: Habilitar a través de la pestaña de AI en la configuración

- Docker Engine: Instalar el paquete

docker-model-plugin

Ejemplo de Uso:

# Descargar un modelo desde Docker Hub

docker model pull ai/smollm2

# Ejecutar inferencia

docker model run ai/smollm2 "Explica Docker Model Runner"

# Empaquetar modelo personalizado

docker model package --gguf /ruta/a/model.gguf --push myorg/mymodel:latest

Para una referencia completa de los comandos docker model, opciones de empaquetado, banderas de configuración y ejemplos prácticos, consulta nuestro detallado Docker Model Runner Cheatsheet: Comandos y Ejemplos. Cubre la descarga de modelos, empaquetado, configuración y mejores prácticas para desplegar LLMs localmente con Docker.

DMR se asocia con Google, Hugging Face y VMware Tanzu para expandir el ecosistema de modelos de IA disponible a través de Docker Hub. Si eres nuevo en Docker o necesitas un recordatorio sobre comandos de Docker, nuestro Docker Cheatsheet proporciona una guía completa sobre operaciones esenciales de Docker.

Soluciones de Docker de Terceros

Más allá de DMR, el ecosistema incluye marcos establecidos:

- Contenedores vLLM: Servidor de inferencia de alto rendimiento optimizado para procesamiento por lotes

- Inferencia de Generación de Texto (TGI): Solución lista para producción de Hugging Face

- Contenedores llama.cpp: Implementación ligera en C++ con soporte de cuantización

- Contenedores personalizados: Envolturas de PyTorch, Transformers o marcos propietarios

Ventajas del enfoque de Docker

Flexibilidad y Agnosticismo de Marcos: Los contenedores de Docker pueden ejecutar cualquier marco de LLM, desde PyTorch hasta ONNX Runtime, dando a los desarrolladores completo control sobre la pila de inferencia.

Aislamiento de Recursos: Cada contenedor opera en entornos aislados con límites definidos de recursos (CPU, memoria, GPU), evitando conflictos de recursos en despliegues de múltiples modelos.

Soporte de Orquestación: Docker se integra de forma sencilla con Kubernetes, Docker Swarm y plataformas en la nube para escalar, balancear carga y alta disponibilidad.

Control de Versiones: Diferentes versiones de modelos o marcos pueden coexistir en el mismo sistema sin conflictos de dependencias.

Desventajas del enfoque de Docker

Complejidad: Requiere comprensión de contenerización, montajes de volúmenes, configuración de red y passthrough de GPU (nvidia-docker).

Sobrecarga: Aunque mínima, Docker añade una capa de abstracción que afecta ligeramente el tiempo de inicio y el uso de recursos.

Carga de Configuración: Cada despliegue requiere configuración cuidadosa de Dockerfiles, variables de entorno y parámetros de tiempo de ejecución.

Entendiendo Ollama

Ollama es una aplicación diseñada específicamente para ejecutar LLMs localmente, diseñada con la simplicidad como su principio central. Proporciona:

- Binario nativo para Linux, macOS y Windows

- Biblioteca de modelos integrada con instalación en un solo comando

- Detección y optimización automática de GPU

- API RESTful compatible con el formato de OpenAI

- Gestión de contexto y estado del modelo

Ventajas de Ollama

Simplicidad: La instalación es sencilla (curl | sh en Linux), y ejecutar modelos requiere solo ollama run llama2. Para una referencia completa de los comandos de la CLI de Ollama como ollama serve, ollama run, ollama ps y flujos de trabajo de gestión de modelos, consulta nuestro Ollama CLI Cheatsheet.

Rendimiento Optimizado: Basado en llama.cpp, Ollama está altamente optimizado para velocidad de inferencia con soporte de cuantización (Q4, Q5, Q8).

Gestión de Modelos: Registro de modelos integrado con comandos como ollama pull, ollama list y ollama rm simplifica el ciclo de vida de los modelos.

Experiencia del Desarrollador: API limpia, documentación extensa y ecosistema en crecimiento de integraciones (LangChain, CrewAI, etc.). La versatilidad de Ollama se extiende a casos de uso especializados como reordenamiento de documentos de texto con modelos de embedding.

Eficiencia de Recursos: Gestión automática de memoria y descarga de modelos cuando están inactivos conserva recursos del sistema.

Desventajas de Ollama

Bloqueo de Marcos: Principalmente soporta modelos compatibles con llama.cpp, limitando la flexibilidad para marcos como vLLM o motores de inferencia personalizados.

Limitada Personalización: Configuraciones avanzadas (cuantización personalizada, streams de CUDA específicos) son menos accesibles que en entornos de Docker.

Desafíos de Orquestación: Aunque Ollama puede ejecutarse en contenedores, carece de soporte nativo para características avanzadas de orquestación como escalado horizontal.

Comparación de Rendimiento

Velocidad de Inferencia

Docker Model Runner: Rendimiento comparable a Ollama, ya que ambos soportan modelos cuantizados GGUF. Para Llama 2 7B (Q4), se espera 20-30 tokens/segundo en CPU y 50-80 tokens/segundo en GPUs medianas. Sobrecarga de contenedor mínima.

Ollama: Utiliza backend altamente optimizado de llama.cpp con cuantización eficiente. Para Llama 2 7B (Q4), se espera 20-30 tokens/segundo en CPU y 50-80 tokens/segundo en GPUs medianas. Sin sobrecarga de contenerización. Para detalles sobre cómo Ollama maneja solicitudes paralelas, consulta nuestro análisis sobre cómo Ollama maneja solicitudes paralelas.

Docker (vLLM): Optimizado para procesamiento por lotes con empaquetamiento continuo. Las solicitudes individuales pueden ser ligeramente más lentas, pero el throughput destaca bajo carga concurrente alta (100+ tokens/segundo por modelo con empaquetamiento).

Docker (TGI): Similar a vLLM con excelente rendimiento de empaquetamiento. Añade características como streaming y generación token por token.

Uso de Memoria

Docker Model Runner: Similar a Ollama con carga automática de modelos. Los modelos GGUF Q4 típicamente usan 4-6 GB de RAM. Sobrecarga de contenedor mínima (decenas de MB).

La configuración del tamaño de contexto puede impactar significativamente el uso de memoria y el comportamiento del modelo. Por defecto, algunas imágenes de CUDA de Docker Model Runner codifican un límite de 4096 tokens, incluso si se especifican valores más altos en docker-compose. Para pasos detallados sobre cómo sobrescribir este comportamiento y empaquetar modelos con tamaños de contexto personalizados, consulta nuestra guía sobre configurar el tamaño de contexto en Docker Model Runner.

Ollama: Gestión automática de memoria carga modelos según sea necesario y los descarga cuando están inactivos. Un modelo 7B Q4 típicamente usa 4-6 GB de RAM. Más eficiente para escenarios de un solo modelo.

Soluciones de Docker Tradicionales: El uso de memoria depende del marco. vLLM preasigna memoria de GPU para un rendimiento óptimo, mientras que los contenedores basados en PyTorch pueden usar más RAM para pesos del modelo y caché KV (8-14 GB para modelos 7B).

Tiempo de Inicio

Docker Model Runner: El inicio del contenedor añade ~1 segundo, más el tiempo de carga del modelo (2-5 segundos). Total: 3-6 segundos para modelos medianos.

Ollama: Inicio casi inmediato con carga del modelo que toma 2-5 segundos para modelos medianos. Experiencia de inicio frío más rápida.

Docker Tradicional: El inicio del contenedor añade 1-3 segundos, más el tiempo de carga del modelo. El precalentamiento de contenedores mitiga esto en despliegues de producción.

Recomendaciones por Caso de Uso

Elige Docker Model Runner cuando

- Flujo de trabajo basado en Docker: Tu equipo ya usa Docker extensamente

- Herramientas unificadas: Quieres una sola herramienta (Docker) para contenedores y modelos

- Distribución de artefactos OCI: Necesitas integración con registros empresariales

- Integración con Testcontainers: Estás probando características de IA en CI/CD

- Preferencia por Docker Hub: Quieres distribución de modelos a través de canales familiares

Elige Ollama cuando

- Prototipado rápido: Experimentación rápida con diferentes modelos

- Agnosticismo de marcos: No estás atado al ecosistema de Docker

- Simplicidad absoluta: Mínima configuración y sobrecarga de mantenimiento

- Despliegues en una sola máquina: Ejecución en laptops, estaciones de trabajo o máquinas virtuales individuales

- Gran biblioteca de modelos: Acceso a una extensa biblioteca de modelos preconfigurados

Elige Soluciones de Docker de Terceros cuando

- Despliegues en producción: Necesidad de orquestación y monitoreo avanzados

- Servicio múltiple de modelos: Ejecutar diferentes marcos (vLLM, TGI) simultáneamente

- Orquestación de Kubernetes: Escalar en clusters con balanceo de carga

- Marcos personalizados: Usar Ray Serve o motores de inferencia propietarios

- Control estricto de recursos: Imponer límites granulares de CPU/GPU por modelo

Enfoques Híbridos: Lo Mejor de Ambos Mundos

No estás limitado a un solo enfoque. Considera estas estrategias híbridas:

Opción 1: Docker Model Runner + Contenedores Tradicionales

Usa DMR para modelos estándar y contenedores de terceros para marcos especializados:

# Descargar un modelo estándar con DMR

docker model pull ai/llama2

# Ejecutar vLLM para escenarios de alto rendimiento

docker run --gpus all vllm/vllm-openai

Opción 2: Ollama en Docker

Ejecutar Ollama dentro de contenedores de Docker para capacidades de orquestación:

docker run -d \

--name ollama \

--gpus all \

-v ollama:/root/.ollama \

-p 11434:11434 \

ollama/ollama

Esto proporciona:

- Gestión intuitiva de modelos de Ollama

- Capacidad de orquestación e aislamiento de Docker

- Despliegue en Kubernetes con manifiestos estándar

Opción 3: Mezclar y Usar según el Caso de Uso

- Desarrollo: Ollama para iteración rápida

- Entorno de pruebas: Docker Model Runner para pruebas de integración

- Producción: vLLM/TGI en Kubernetes para escalar

Compatibilidad de API

Todas las soluciones modernas convergen en APIs compatibles con OpenAI, simplificando la integración:

API de Docker Model Runner: Puntos finales compatibles con OpenAI servidos automáticamente al ejecutar modelos. No se requiere configuración adicional.

# Los modelos se ejecutan con API expuesta automáticamente

docker model run ai/llama2

# Usar punto final compatible con OpenAI

curl http://localhost:8080/v1/chat/completions -d '{

"model": "llama2",

"messages": [{"role": "user", "content": "¿Por qué es azul el cielo?"}]

}'

API de Ollama: Puntos finales compatibles con OpenAI hacen de Ollama un reemplazo directo para aplicaciones que usan SDK de OpenAI. El streaming está completamente soportado.

curl http://localhost:11434/api/generate -d '{

"model": "llama2",

"prompt": "¿Por qué es azul el cielo?"

}'

APIs de Soluciones de Docker de Terceros: vLLM y TGI ofrecen puntos finales compatibles con OpenAI, mientras que contenedores personalizados pueden implementar APIs propietarias.

La convergencia en la compatibilidad con OpenAI significa que puedes cambiar entre soluciones con mínimos cambios de código.

Gestión de Recursos

Aceleración de GPU

Docker Model Runner: Soporte nativo de GPU sin configuración compleja de nvidia-docker. Detecta y usa automáticamente las GPUs disponibles, simplificando significativamente la experiencia de GPU en Docker en comparación con contenedores tradicionales.

Si estás usando GPUs NVIDIA y quieres configurar correctamente la aceleración de CUDA, consulta nuestra guía detallada sobre añadir soporte de GPU NVIDIA a Docker Model Runner. Cubre la configuración del daemon de Docker, configuración del Toolkit de Contenedores NVIDIA y cómo verificar que tu LLM esté usando realmente la memoria de GPU en lugar de recurrir a la inferencia en CPU.

# La aceleración de GPU funciona automáticamente

docker model run ai/llama2

Ollama: Detección automática de GPU en GPUs NVIDIA con capacidad de CUDA. No se requiere configuración adicional más allá de la instalación del controlador.

Contenedores Tradicionales de Docker: Requiere runtime de nvidia-docker y asignación explícita de GPU:

docker run --gpus all my-llm-container

Recurso de CPU

Ambos se recuperan automáticamente a la inferencia en CPU cuando no están disponibles las GPUs, aunque el rendimiento disminuye significativamente (5-10 veces más lento para modelos grandes). Para insights sobre el rendimiento en CPU en procesadores modernos, lee nuestra prueba sobre cómo Ollama usa el rendimiento de CPU de Intel y núcleos eficientes.

Soporte de Multi-GPU

Ollama: Soporta paralelismo de tensores en múltiples GPUs para modelos grandes.

Docker: Depende del marco. vLLM y TGI soportan inferencia de múltiples GPUs con configuración adecuada.

Comunidad y Ecosistema

Docker Model Runner: Lanzado en abril de 2025 con fuerte respaldo empresarial. Alianzas con Google, Hugging Face y VMware Tanzu AI Solutions aseguran disponibilidad amplia de modelos. Integración con la gran comunidad de desarrolladores de Docker (millones de usuarios) proporciona acceso inmediato al ecosistema. Aún se está construyendo recursos específicos de la comunidad como producto nuevo.

Ollama: Comunidad en rápido crecimiento con más de 50K estrellas en GitHub. Fuerte ecosistema de integración (LangChain, LiteLLM, Open WebUI, CrewAI) y comunidad activa en Discord. Amplias herramientas de terceros y tutoriales disponibles. Documentación y recursos de la comunidad más maduros. Para una visión general completa de las interfaces disponibles, consulta nuestra guía sobre interfaz de chat de código abierto para instancias locales de Ollama. Como con cualquier proyecto de código abierto en rápido crecimiento, es importante monitorear la dirección del proyecto - lee nuestro análisis de primeras señales de enshittificación de Ollama para entender preocupaciones potenciales.

Soluciones de Docker de Terceros: vLLM y TGI tienen ecosistemas maduros con soporte empresarial. Amplios estudios de caso de producción, guías de optimización y patrones de despliegue de Hugging Face y colaboradores de la comunidad.

Consideraciones de Costo

Docker Model Runner: Gratis con Docker Desktop (personal/educativo) o Docker Engine. Docker Desktop requiere suscripción para organizaciones más grandes (250+ empleados o $10M+ en ingresos). Los modelos distribuidos a través de Docker Hub siguen el precio de registro de Docker (repositorios públicos gratuitos, repositorios privados pagos).

Ollama: Completamente gratuito y de código abierto sin costos de licencia independientemente del tamaño de la organización. Los costos de recursos dependen solo del hardware.

Soluciones de Docker de Terceros: Gratis para marcos de código abierto (vLLM, TGI). Posibles costos para plataformas de orquestación de contenedores (ECS, GKE) y almacenamiento en registro privado.

Consideraciones de Seguridad

Docker Model Runner: Usa el modelo de seguridad de Docker con aislamiento de contenedores. Los modelos empaquetados como artefactos OCI pueden escanearse y firmarse. La distribución a través de Docker Hub permite control de acceso y escaneo de vulnerabilidades para usuarios empresariales.

Ollama: Ejecuta como un servicio local con API expuesta en localhost por defecto. La exposición de red requiere configuración explícita. El registro de modelos es de confianza (curado por Ollama), reduciendo riesgos de cadena de suministro.

Soluciones Tradicionales de Docker: El aislamiento de red está integrado. El escaneo de seguridad de contenedores (Snyk, Trivy) y firma de imágenes son prácticas estándar en entornos de producción.

Todos los soluciones requieren atención a:

- Procedencia del modelo: Modelos no confiables pueden contener código malicioso o backdoors

- Autenticación de API: Implementar autenticación/autorización en despliegues de producción

- Limitación de tasas: Prevenir abuso y agotamiento de recursos

- Exposición de red: Asegurar que las APIs no se expongan accidentalmente a internet

- Privacidad de datos: Los modelos procesan datos sensibles; asegurar cumplimiento con regulaciones de protección de datos

Rutas de Migración

De Ollama a Docker Model Runner

El soporte de GGUF de Docker Model Runner hace que la migración sea sencilla:

- Habilitar Docker Model Runner en Docker Desktop o instalar

docker-model-plugin - Convertir referencias de modelos:

ollama run llama2→docker model pull ai/llama2ydocker model run ai/llama2 - Actualizar puntos finales de API de

localhost:11434a punto final de DMR (normalmentelocalhost:8080) - Ambos usan APIs compatibles con OpenAI, por lo que el código de la aplicación requiere cambios mínimos

De Docker Model Runner a Ollama

Moverse a Ollama para una operación independiente más sencilla:

- Instalar Ollama:

curl -fsSL https://ollama.ai/install.sh | sh. Para una lista completa de comandos de CLI de Ollama y opciones de configuración, consulta la hoja de referencia de CLI de Ollama. - Descargar modelos equivalentes:

ollama pull llama2 - Actualizar puntos finales de API a

localhost:11434de Ollama - Probar con

ollama run llama2para verificar funcionalidad

De Contenedores Tradicionales de Docker a DMR

Simplificar tu configuración de LLM de Docker:

- Habilitar Docker Model Runner

- Reemplazar Dockerfiles personalizados con comandos

docker model pull - Eliminar configuración de nvidia-docker (DMR maneja GPU automáticamente)

- Usar

docker model runen lugar de comandosdocker runcomplejos

De Cualquier Solución a Ollama en Docker

Enfoque mejor de ambos mundos:

docker pull ollama/ollama- Ejecutar:

docker run -d --gpus all -v ollama:/root/.ollama -p 11434:11434 ollama/ollama - Usar comandos de Ollama como de costumbre:

docker exec -it ollama ollama pull llama2 - Ganar orquestación de Docker con simplicidad de Ollama

Monitoreo y Observabilidad

Ollama: Métricas básicas a través de API (/api/tags, /api/ps). Herramientas de terceros como Open WebUI proporcionan dashboards.

Docker: Integración completa con Prometheus, Grafana, pila ELK y servicios de monitoreo en la nube. Las métricas de contenedor (CPU, memoria, GPU) están disponibles fácilmente.

Conclusión

El paisaje de despliegue local de LLM se ha evolucionado significativamente con la introducción de Docker Model Runner (DMR) en 2025. La elección ahora depende de tus requisitos específicos:

- Para desarrolladores buscando integración con Docker: DMR proporciona integración nativa con flujos de trabajo de Docker usando comandos

docker model - Para máxima simplicidad: Ollama sigue siendo la solución más sencilla con gestión de modelos en un solo comando

- Para producción y empresas: Tanto DMR como soluciones de terceros (vLLM, TGI) en Docker ofrecen orquestación, monitoreo y escalabilidad

- Para lo mejor de ambos: Ejecutar Ollama en contenedores de Docker para combinar simplicidad con infraestructura de producción

La introducción de DMR reduce la brecha entre Docker y Ollama en términos de facilidad de uso. Ollama sigue ganando en simplicidad para prototipado rápido, mientras que DMR destaca para equipos ya invertidos en flujos de trabajo de Docker. Ambos enfoques están en desarrollo activo, listos para producción y el ecosistema es lo suficientemente maduro como para que cambiar entre ellos sea relativamente indoloro.

Línea Final: Si ya estás usando Docker extensamente, DMR es la elección natural. Si quieres la experiencia más sencilla independientemente de la infraestructura, elige Ollama. Para comparar estas opciones locales con APIs de la nube y otros entornos autogestionados, consulta nuestra guía Hosting de LLM: Comparación entre infraestructura local, autogestionada y en la nube.

Enlaces Útiles

Docker Model Runner

- Página Oficial de Docker Model Runner

- Documentación de Docker Model Runner

- Guía de Comienzo de Docker Model Runner

- Blog de Anuncio de Docker Model Runner

Ollama

Otras Soluciones de Docker

- Documentación de vLLM

- Inferencia de Generación de Texto de Hugging Face

- Repositorio de GitHub de llama.cpp

- Toolkit de Contenedores NVIDIA