Interfaz de chat para instancias locales de Ollama

Breve visión general de las interfaces de usuario más destacadas para Ollama en 2025

Locally hosted Ollama permite ejecutar modelos de lenguaje grandes en tu propia máquina, pero usarlo desde la línea de comandos no es muy amigable para el usuario. Aquí hay varios proyectos de código abierto que ofrecen interfaces estilo ChatGPT que se conectan a un Ollama local.

Estas UIs admiten chat conversacional, a menudo con características como carga de documentos para generación aumentada con recuperación (RAG), y se ejecutan como aplicaciones web o de escritorio. A continuación se muestra una comparación de las opciones clave, seguida de secciones detalladas sobre cada una. Para una visión más amplia de cómo se encaja Ollama local con vLLM, Docker Model Runner, LocalAI y proveedores en la nube—incluyendo consideraciones de costo e infraestructura—vea LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

Comparación de UIs compatibles con Ollama

| Herramienta de UI | Plataforma | Soporte de documentos | Integración con Ollama | Fortalezas | Limitaciones |

|---|---|---|---|---|---|

| Page Assist | Extensión del navegador (Chrome, Firefox) | Sí – agregar archivos para análisis | Conecta a Ollama local a través de la configuración de la extensión | Chat en el navegador; gestión fácil de modelos y integración de contexto de la página web. | Solo en el navegador; requiere instalar/configurar una extensión. |

| Open WebUI | Aplicación web (autohospedada; Docker/PWA) | Sí – RAG integrado (subir documentos o agregar a la biblioteca) | Soporte directo de la API de Ollama o servidor empaquetado (configurar URL base) | Funciones ricas (multi-LLM, sin conexión, generación de imágenes); móvil-friendly (PWA). | Configuración más pesada (Docker/K8s); alcance amplio puede ser excesivo para uso simple. |

| LobeChat | Aplicación web (autohospedada; PWA compatible) | Sí – “Base de conocimiento” con carga de archivos (PDF, imágenes, etc.) | Soporta Ollama como uno de varios backends de AI (requiere habilitar el acceso a la API de Ollama) | Interfaz de chat elegante estilo ChatGPT; chat por voz, plugins y soporte multi-modelo. | Conjunto de funciones complejo; requiere configuración del entorno (por ejemplo, cross-origin para Ollama). |

| LibreChat | Aplicación web (autohospedada; multiusuario) | Sí – “Chat con archivos” usando RAG (a través de embeddings) | Compatible con Ollama y muchos otros proveedores (cambiable por chat) | Interfaz familiar estilo ChatGPT; funciones ricas (agentes, intérprete de código, etc.). | Instalación/configuración puede ser involucrada; proyecto grande puede ser más de lo necesario para uso básico. |

| AnythingLLM | Aplicación de escritorio (Windows, Mac, Linux) o web (Docker) | Sí – RAG integrado: arrastrar y soltar documentos (PDF, DOCX, etc.) con citas | Ollama soportado como proveedor de LLM (establecido en configuración o entorno Docker) | Interfaz de UI todo en uno (ChatGPT privado con tus documentos); constructor de agentes sin código, soporte multiusuario. | Uso mayor de recursos (base de datos de embeddings, etc.); la aplicación de escritorio carece de algunas funciones multiusuario. |

| Chat-with-Notes | Aplicación web (servidor ligero Flask) | Sí – subir archivos de texto/PDF y chatear con su contenido | Usa Ollama para todas las respuestas de AI (requiere que Ollama se ejecute localmente) | Configuración muy simple e interfaz enfocada en preguntas y respuestas de documentos; los datos permanecen locales. | UI básica y funcionalidad; único usuario, un documento a la vez (sin características avanzadas). |

Cada una de estas herramientas está activamente mantenido y es de código abierto. A continuación, nos adentramos en detalles de cada opción, incluyendo cómo funcionan con Ollama, características notables y equilibrios.

Page Assist (Extensión del navegador)

Page Assist es una extensión de navegador de código abierto que lleva el chat de LLM local a tu navegador. Soporta navegadores basados en Chromium y Firefox, ofreciendo una barra lateral o pestaña estilo ChatGPT donde puedes conversar con un modelo. Page Assist puede conectarse a Ollama local como proveedor de AI, o a otros backends locales, a través de su configuración. Notablemente, permite añadir archivos (por ejemplo, PDFs o texto) para que el AI analice dentro del chat, habilitando flujos de trabajo básicos de RAG. Incluso puedes hacer que te ayude con el contenido de la página web actual o realizar búsquedas en Internet para información.

La instalación es sencilla: instale la extensión desde la tienda de Chrome o los complementos de Firefox, asegúrese de que Ollama esté en ejecución y seleccione Ollama como proveedor de AI local en la configuración de Page Assist. La interfaz incluye características como historial de chat, selección de modelos y una URL compartible opcional para los resultados de su chat. También está disponible una interfaz web mediante un atajo del teclado si prefiere una experiencia de chat en pestaña completa.

Fortalezas: Page Assist es ligero y conveniente – ya que vive en el navegador, no hay servidor separado que ejecutar. Es ideal para contextos de navegación (puedes abrirla en cualquier página web) y soporta integración de búsqueda en Internet y archivos adjuntos para enriquecer la conversación. También ofrece funciones prácticas como atajos del teclado para nuevo chat y alternar la barra lateral.

Limitaciones: Al ser una extensión, está restringida a un entorno de navegador. La interfaz es más simple y algo menos rica en características que aplicaciones de chat independientes. Por ejemplo, la gestión multiusuario o plugins avanzados de agentes no están en el alcance. Además, la configuración inicial puede requerir construir/cargar la extensión si no hay una versión preempaquetada disponible para su navegador (el proyecto proporciona instrucciones de construcción usando Bun o npm). En general, Page Assist es ideal para uso individual cuando deseas acceder rápidamente a chats impulsados por Ollama mientras navegas por Internet, con capacidades moderadas de RAG.

Open WebUI (Aplicación web autohospedada)

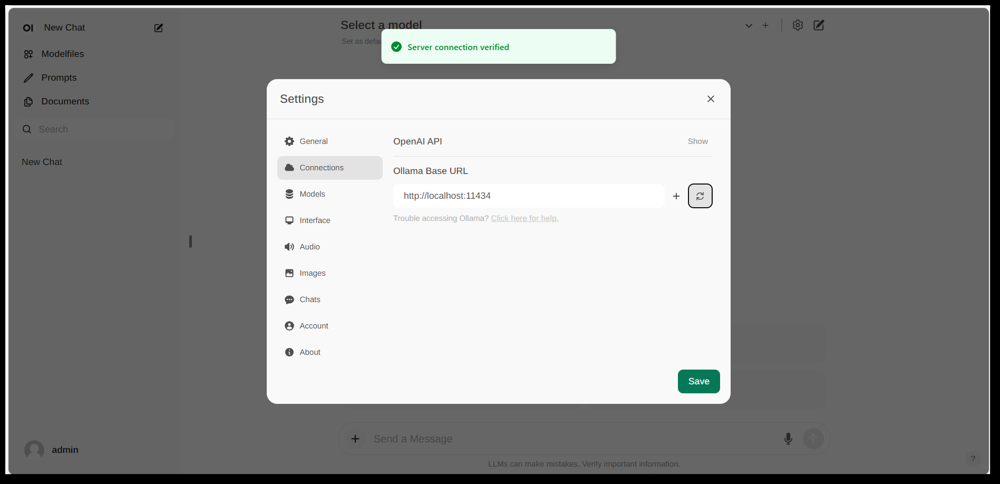

Interfaz de configuración de Open WebUI, mostrando una conexión Ollama configurada (URL base establecida en la API local de Ollama). La interfaz incluye una sección de documentos, habilitando flujos de trabajo RAG.

Open WebUI es una poderosa interfaz frontal general de chat originalmente creada para trabajar con Ollama, y ahora ampliada para soportar varios backends de LLM. Se ejecuta como una aplicación web autohospedada y generalmente se despliega mediante Docker o Kubernetes para facilitar la instalación. Una vez en ejecución, se accede a través del navegador (con soporte para instalarlo como una Aplicación Web Progresiva en dispositivos móviles).

Open WebUI ofrece una interfaz de chat completa con soporte multiusuario, gestión de modelos y características extensas. Críticamente, tiene capacidades integradas de RAG – puedes subir o importar documentos a una biblioteca de documentos y luego hacer preguntas con recuperación de información. La interfaz permite cargar documentos directamente en una sesión de chat o mantener una biblioteca persistente de conocimiento. Incluso soporta realizar búsquedas en Internet e insertar resultados en la conversación para información actualizada.

Integración con Ollama: Open WebUI se conecta a Ollama a través de su API. Puedes ejecutar el contenedor Docker de Open WebUI junto con un servidor Ollama y establecer una variable de entorno para apuntar a la URL de Ollama, o usar una imagen Docker especial que incluye Ollama con la interfaz web. En la práctica, después de lanzar los contenedores, visitarás Open WebUI en tu navegador y verás el “Conexión con el servidor verificada” si se configura correctamente (como se muestra en la imagen anterior). Esto significa que la interfaz está lista para usar tus modelos locales de Ollama para el chat. Open WebUI también soporta puntos finales compatibles con la API de OpenAI, por lo que puede interactuar con LM Studio, OpenRouter, etc., además de Ollama.

Fortalezas: Esta solución es una de las más ricas en características y flexibles. Soporta múltiples modelos simultáneos y hilos de conversación, “personajes” personalizados o prompts del sistema, generación de imágenes y más. La implementación de RAG es robusta – obtienes una interfaz completa para gestionar documentos e incluso configurar qué almacén de vectores o servicio de búsqueda usar para recuperación. Open WebUI también está activamente desarrollado (con una comunidad extensa, como se indica por su alto número de estrellas en GitHub) y está diseñado para extensibilidad y escalabilidad. Es una buena opción si quieres una interfaz de chat completa para modelos locales, especialmente en un escenario con múltiples usuarios o casos de uso complejos.

Limitaciones: Con gran poder viene mayor complejidad. Open WebUI puede ser excesivo para uso personal simple – desplegar contenedores de Docker y gestionar la configuración puede ser intimidador si no estás familiarizado. Consuma más recursos que una aplicación ligera, ya que ejecuta un servidor web, base de datos opcional para historial de chat, etc. Además, características como control de acceso basado en roles y gestión de usuarios, aunque útiles, indican que está orientado hacia un entorno de servidor – un solo usuario en un PC doméstico puede no necesitar todo eso. En resumen, la configuración es más pesada y la interfaz puede parecer compleja si solo necesitas una clon básica de ChatGPT. Pero para aquellos que sí necesitan su amplitud de características (o quieren cambiar fácilmente entre Ollama y otros proveedores de modelos en una interfaz), Open WebUI es una opción principal.

LobeChat (Marco estilo ChatGPT con plugins)

Banner de la interfaz de LobeChat mostrando “Ollama Soportado” y múltiples modelos locales. LobeChat permite desplegar una aplicación web estilo ChatGPT usando Ollama u otros proveedores, con características como entrada de voz y plugins.

LobeChat es un marco de chat de código abierto que destaca por una experiencia del usuario pulida y flexibilidad. Es esencialmente una aplicación web estilo ChatGPT que puedes autohospedar, con soporte para múltiples proveedores de AI – desde OpenAI y Anthropic hasta modelos abiertos a través de Ollama. LobeChat está diseñado con privacidad en mente (lo ejecutas tú mismo) y tiene una interfaz moderna que incluye conveniencias como memoria de conversación, modo de conversación por voz y incluso generación de imágenes a través de plugins.

Una de las características clave de LobeChat es su capacidad de Base de Conocimiento. Puedes subir documentos (en formatos como PDF, imágenes, audio, video) y crear una base de conocimiento que se pueda utilizar durante el chat. Esto significa que puedes hacer preguntas sobre el contenido de tus archivos – un flujo de trabajo de RAG que LobeChat soporta de forma nativa. La interfaz proporciona gestión de estos archivos/bases de conocimiento y permite alternar su uso en la conversación, ofreciendo una experiencia de Q&A más rica más allá del LLM base.

Para usar LobeChat con Ollama, desplegarás la aplicación de LobeChat (por ejemplo, mediante una imagen de Docker proporcionada o script) y configurarás Ollama como el backend. LobeChat reconoce a Ollama como un proveedor de primer orden – incluso ofrece un script de despliegue de un solo clic a través del navegador Pinokio AI si lo usas. En la práctica, es posible que necesites ajustar la configuración de Ollama (como habilitar CORS según las instrucciones de LobeChat) para que la interfaz web de LobeChat pueda acceder a la API HTTP de Ollama. Una vez configurado, podrás elegir un modelo alojado en Ollama en la interfaz de LobeChat y conversar con él, incluyendo preguntas sobre tus documentos subidos.

Fortalezas: La interfaz de LobeChat suele ser elogiada por ser limpia y amigable para el usuario, muy similar en apariencia y sensación al de ChatGPT (lo que puede facilitar la adopción). Añade valor con extras como entrada/salida de voz para conversaciones habladas y un sistema de plugins para extender la funcionalidad (similar a los plugins de ChatGPT, permitiendo cosas como navegación web o generación de imágenes). El soporte multi-modelo permite cambiar fácilmente entre, por ejemplo, un modelo local de Ollama y un modelo de API de OpenAI en la misma interfaz. También soporta instalación como una PWA móvil amigable, por lo que puedes acceder a tu chat local en movimiento.

Limitaciones: Configurar LobeChat puede ser más complejo que algunas alternativas. Es una aplicación de pila completa (a menudo ejecutada con Docker Compose), por lo que hay cierta sobrecarga. En particular, configurar la integración con Ollama requiere habilitar solicitudes de origen cruzado en el lado de Ollama y asegurar que los puertos coincidan – una tarea de una sola vez, pero técnica. Además, aunque LobeChat es bastante poderoso, no todas las características pueden ser necesarias para cada usuario; por ejemplo, si no necesitas soporte multi-proveedor o plugins, la interfaz puede parecer abrumadora en comparación con una herramienta mínima. Finalmente, ciertas características avanzadas como el despliegue de un solo clic asumen entornos específicos (navegador Pinokio o Vercel), los cuales puedes o no usar. En general, LobeChat es ideal si quieres un alternativo completo de ChatGPT que se ejecute localmente con Ollama, y no te importa un poco de configuración inicial para llegar allí.

LibreChat (Clon de ChatGPT con soporte multi-proveedor)

LibreChat (anteriormente conocido como ChatGPT-Clone o UI) es un proyecto de código abierto que busca replicar y extender la interfaz y funcionalidad de ChatGPT. Puede desplegarse localmente (o en su propio servidor) y soporta una variedad de backends de AI – incluyendo modelos de código abierto a través de Ollama. Esencialmente, LibreChat proporciona la experiencia familiar de chat (interfaz de diálogo con historial, mensajes de usuario y asistente) mientras permite conectar diferentes proveedores de modelos en el backend.

LibreChat soporta interacción con documentos y RAG a través de un complemento llamado RAG API y servicios de embedding. En la interfaz, puedes usar características como “Chat con archivos”, que te permite subir documentos y luego hacer preguntas sobre ellos. En segundo plano, esto usa embeddings y un almacén de vectores para recuperar contexto relevante de tus archivos. Esto significa que puedes lograr un efecto similar al de ChatGPT + conocimiento personalizado, todo localmente. El proyecto incluso proporciona un repositorio separado para el servicio RAG si deseas autohospedarlo.

Usar LibreChat con Ollama generalmente implica ejecutar el servidor de LibreChat (por ejemplo, mediante Node/Docker) y asegurarte de que pueda alcanzar el servicio de Ollama. LibreChat tiene un “Punto final personalizado” donde puedes ingresar una URL compatible con la API de OpenAI. Dado que Ollama puede exponer una API local compatible con OpenAI, LibreChat puede apuntarse a http://localhost:11434 (o dondequiera que Ollama esté escuchando). De hecho, LibreChat menciona explícitamente a Ollama entre sus proveedores de AI compatibles – junto con otros como OpenAI, Cohere, etc. Una vez configurado, puedes seleccionar el modelo (el modelo de Ollama) en un desplegable y chatear. LibreChat también permite cambiar modelos o proveedores incluso durante la conversación y soporta múltiples configuraciones de chat/presets de contexto.

Fortalezas: La principal ventaja de LibreChat es el conjunto rico de características construidas alrededor de la experiencia de chat. Incluye cosas como ramificación de conversación, búsqueda de mensajes, soporte integrado de intérprete de código (ejecución segura de código en un entorno aislado) y integraciones de herramientas/agentes. Es esencialmente ChatGPT++, con la capacidad de integrar modelos locales. Para alguien que le guste la interfaz de ChatGPT, LibreChat se sentirá muy familiar y requerirá poco aprendizaje. El proyecto es activo y comunitario (como se evidencia por sus actualizaciones frecuentes y discusiones), y es bastante flexible: puedes conectar a muchos tipos de endpoints de LLM o incluso ejecutarlo con múltiples usuarios con autenticación para un entorno de equipo.

Limitaciones: Con sus muchas características, LibreChat puede ser más pesado de ejecutar. La instalación podría involucrar configurar una base de datos para almacenar chats y configurar variables de entorno para varios APIs. Si habilitas todos los componentes (RAG, agentes, generación de imágenes, etc.), es una pila bastante compleja. Para un solo usuario que solo necesita un chat básico con un modelo local, LibreChat podría ser más de lo necesario. Además, la interfaz, aunque familiar, no está altamente especializada para preguntas y respuestas de documentos – hace el trabajo pero carece de una interfaz dedicada de “biblioteca de documentos” (las subidas generalmente se hacen dentro de un chat o mediante API). En resumen, LibreChat brilla cuando deseas un entorno completo estilo ChatGPT con una gama de características ejecutándose localmente, pero soluciones más simples podrían ser suficientes para casos de uso enfocados.

AnythingLLM (Aplicación de escritorio o servidor todo en uno)

AnythingLLM es una aplicación de IA todo en uno que destaca por RAG y facilidad de uso. Permite “chatear con tus documentos” usando modelos de LLM de código abierto o incluso modelos de OpenAI, todo a través de una interfaz unificada. Notablemente, AnythingLLM está disponible tanto como una aplicación de escritorio multiplataforma (para Windows, Mac, Linux) y como un servidor autohospedado (vía Docker). Esta flexibilidad significa que puedes ejecutarla como una aplicación normal en tu PC, o desplegarla para múltiples usuarios en un servidor.

El manejo de documentos es el núcleo de AnythingLLM. Puedes arrastrar y soltar documentos (PDF, TXT, DOCX, etc.) en la aplicación, y automáticamente los indexará en una base de datos de vectores (viene con LanceDB por defecto). En la interfaz de chat, cuando hagas preguntas, recuperará fragmentos relevantes de tus documentos y proporcionará respuestas citadas, para que sepas de qué archivo y sección vino la información. Esencialmente, construye una base de conocimiento privada para ti y permite que el LLM la use como contexto. Puedes organizar documentos en “espacios de trabajo” (por ejemplo, un espacio de trabajo por proyecto o tema), aislando contextos según sea necesario.

Usar Ollama con AnythingLLM es sencillo. En la configuración, eliges Ollama como proveedor de LLM. Si lo ejecutas mediante Docker, estableces variables de entorno como LLM_PROVIDER=ollama y proporcionas la OLLAMA_BASE_PATH (la URL a tu instancia de Ollama). El servidor de AnythingLLM enviará luego todas las consultas de modelos a la API de Ollama. Ollama está oficialmente soportado, y los documentos mencionan que puedes aprovecharlo para ejecutar varios modelos abiertos (como Llama 2, Mistral, etc.) localmente. De hecho, los desarrolladores destacan que combinar AnythingLLM con Ollama desbloquea poderosas capacidades de RAG offline: Ollama maneja la inferencia del modelo, y AnythingLLM maneja los embeddings y la lógica de UI/agentes.

Fortalezas: AnythingLLM proporciona una solución integral para Q&A privado y chat. Las fortalezas clave incluyen: configuración fácil para RAG (el trabajo pesado de embedding y almacenamiento de vectores está automatizado), soporte multi-documento con citación clara de fuentes, y características adicionales como Agentes de IA (tiene un constructor de agentes sin código donde puedes crear flujos de trabajo personalizados y uso de herramientas). También es multiusuario de fábrica (especialmente en modo servidor), con cuentas de usuario y permisos si se necesitan. La interfaz está diseñada para ser simple (caja de chat + barra lateral de documentos/espacios de trabajo) pero poderosa bajo el capó. Para uso personal, la aplicación de escritorio es un gran plus – obtienes una aplicación nativa sin necesidad de abrir un navegador o ejecutar comandos, y almacena datos localmente por defecto.

Limitaciones: Debido a que integra muchos componentes (API de LLM, modelos de embedding, base de datos de vectores, etc.), AnythingLLM puede ser intensivo en recursos. Cuando ingresas documentos, puede tomar tiempo y memoria para generar embeddings (incluso soporta usar Ollama mismo o modelos locales para embeddings con modelos como nomic-embed). La aplicación de escritorio simplifica el uso, pero si tienes muchos documentos o archivos muy grandes, espera un procesamiento pesado en segundo plano. Otra limitación es que los usuarios avanzados pueden encontrarlo menos configurable que ensamblar su propia pila – por ejemplo, actualmente usa LanceDB o Chroma; si quisieras un almacén de vectores diferente, tendrías que sumergirte en la configuración o el código. También, aunque soporta multi-proveedor, la interfaz está realmente orientada hacia un modelo a la vez (cambiarías la configuración global del proveedor si quisieras usar un modelo diferente). En resumen, AnythingLLM es una excelente solución lista para usar para chat local de documentos, especialmente con Ollama, pero es una aplicación más grande para ejecutar en comparación con UIs mínimos.

Chat-with-Notes (Interfaz de chat de documentos minimalista)

Chat-with-Notes es una aplicación minimalista específicamente construida para chatear con archivos de texto locales usando modelos gestionados por Ollama. Esencialmente, es un servidor web ligero de Flask que ejecutas en tu PC, proporcionando una página web simple donde puedes subir un documento y comenzar a chatear sobre él. El objetivo de este proyecto es simplicidad: no tiene muchas características, pero sí hace el trabajo básico de responder preguntas sobre documentos con un LLM local.

Usar Chat-with-Notes implica primero asegurarte de que tu instancia de Ollama esté ejecutando un modelo (por ejemplo, podrías iniciar Ollama con ollama run llama2 o otro modelo). Luego lanzas la aplicación Flask (python app.py) y abres el sitio web local. La interfaz te pedirá que subas un archivo (formatos admitidos incluyen texto plano, Markdown, archivos de código, HTML, JSON y PDF). Una vez subido, el contenido del texto del archivo se mostrará, y podrás hacer preguntas o chatear con el AI sobre ese contenido. La conversación ocurre en un formato típico de burbujas de chat. Si subes un nuevo archivo durante la conversación, la aplicación te preguntará si quieres iniciar un chat nuevo o mantener el contexto actual y solo agregar la información del nuevo archivo. De esta manera, puedes hablar sobre múltiples archivos secuencialmente si es necesario. También hay botones para borrar el chat o exportar la conversación a un archivo de texto.

Bajo el capó, Chat-with-Notes consulta la API de Ollama para generar respuestas. Ollama maneja la inferencia del modelo, y Chat-with-Notes simplemente proporciona el prompt (que incluye partes relevantes del texto subido). No usa una base de datos de vectores; en su lugar, simplemente envía el contenido completo del archivo (o fragmentos de él) junto con tu pregunta al modelo. Este enfoque funciona mejor para documentos de tamaño razonable que se ajusten al contexto de la ventana del modelo.

Fortalezas: La aplicación es extremadamente fácil de desplegar y usar. No hay configuración compleja – si tienes Python y Ollama configurados, puedes tenerlo en funcionamiento en un minuto o dos. La interfaz es limpia y minimalista, enfocada en el contenido de texto y el Q&A. Por su enfoque, asegura que todos los datos permanezcan locales y solo en memoria (ningún llamado externo excepto a Ollama en localhost). Es una excelente opción si específicamente quieres chatear con archivos y no necesitas conversaciones generales sin un documento.

Limitaciones: La minimalidad de Chat-with-Notes significa que carece de muchas características encontradas en otras UIs. Por ejemplo, no soporta usar múltiples modelos o proveedores (es exclusivo de Ollama por diseño), y no mantiene una biblioteca a largo plazo de documentos – subes archivos según sea necesario por sesión, y no hay índice de vectores persistente. Escalar a documentos muy grandes podría ser complicado sin ajustes manuales, ya que podría intentar incluir mucha información en el prompt. Además, la interfaz, aunque funcional, no está tan pulida (no hay modo oscuro, no hay formato de texto enriquecido de las respuestas, etc.). En esencia, esta herramienta es ideal para análisis rápidos de archivos con un modelo de Ollama. Si tus necesidades crecen (por ejemplo, muchos documentos, o deseo de una interfaz más elegante), podrías superar Chat-with-Notes. Pero como punto de partida o solución personal “pregúntame mi PDF” sobre Ollama, es muy efectiva.

Conclusión

Cada una de estas UIs de código abierto puede mejorar tu experiencia con modelos de Ollama locales al proporcionar una interfaz de chat amigable para el usuario y capacidades adicionales como respuesta a preguntas sobre documentos. La mejor elección depende de tus requisitos y nivel técnico:

- Para configuración rápida y uso en el navegador: Page Assist es una excelente opción, integrándose directamente en tu navegación web con poco esfuerzo.

- Para un entorno de aplicación web completa: Open WebUI o LibreChat ofrecen características extensas y flexibilidad multi-modelo, adecuados para usuarios avanzados o configuraciones multiusuario.

- Para una alternativa elegante de ChatGPT con potencial de plugins: LobeChat ofrece un buen equilibrio entre usabilidad y características en un paquete autohospedado.

- Para interacciones centradas en documentos: AnythingLLM proporciona una solución todo en uno (especialmente si te gusta tener una aplicación de escritorio), mientras que Chat-with-Notes ofrece un enfoque minimalista para preguntas y respuestas de un solo documento.

Dado que todas estas herramientas están activamente mantenidas, también puedes esperar mejoras y apoyo comunitario. Al elegir una de estas UIs, podrás chatear con tus modelos locales de Ollama de manera conveniente – ya sea analizando documentos, codificando con asistencia o simplemente teniendo una IA conversacional disponible sin dependencias en la nube. Cada solución mencionada anteriormente es de código abierto, por lo que puedes personalizarlas aún más según tus necesidades o incluso contribuir a su desarrollo. Para ver cómo Ollama local más estas UIs se encajan con otras opciones locales y en la nube, consulte nuestra LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared guía.

¡Feliz chateo con tu LLM local!