Comparando la idoneidad de las GPU de NVidia para la IA

La IA requiere mucha potencia...

En medio del caos del mundo moderno aquí estoy comparando especificaciones técnicas de diferentes tarjetas adecuadas para tareas de IA (Deep Learning, Detección de Objetos y LLMs). Aunque todas son increíblemente caras.

Para obtener más información sobre cómo la elección de GPU afecta el throughput de LLM, los límites de VRAM y las pruebas en diferentes entornos de ejecución, consulte Rendimiento de LLM: Benchmarks, Cuellos de Botella & Optimización.

Esta es una imagen generada por IA. No la tomes en serio…

Vamos a echar un vistazo a otras opciones, simplemente para explorar

| Tarjeta | VRAM | Ancho de Banda | Ancho de Banda de Memoria | Núcleos CUDA | Núcleos Tensor | Potencia (W) |

|---|---|---|---|---|---|---|

| RTX 4060 Ti 16GB | 16 GB | 128-bit | 288 GB/s | 4,352 | 136 | 165 |

| RTX 4070 Ti 16GB | 16 GB | 256-bit | 672 GB/s | 7,680 | 240 | 285 |

| RTX 4080 16GB | 16 GB | 256-bit | 716.8 GB/s | 9,728 | 304 | 320 |

| RTX 4080 Super 16GB | 16 GB | 256-bit | 736 GB/s | 10,240 | 320 | 320 |

| RTX 4090 24GB | 24 GB | 384-bit | 1008 GB/s | 16,384 | 512 | 450 |

| RTX 5060 Ti 16GB | 16 GB | 128-bit | 448 GB/s | 4,608 | 144 | 180 |

| RTX 5070 Ti 16GB | 16 GB | 256-bit | 896 GB/s | 8,960 | 280 | 300 |

| RTX 5080 16GB | 16 GB | 256-bit | 896 GB/s | 10,752 | 336 | ~320 |

| RTX 5090 32GB | 32 GB | 512-bit | 1792 GB/s | 21,760 | 680 | ~450 |

| RTX 2000 Ada | 16 GB | 128-bit | 224 GB/s | 2,816 | 88 | 70 |

| RTX 4000 Ada | 20 GB | 160-bit | 280 GB/s | 6,144 | 192 | 70 |

| RTX 4500 Ada | 24 GB | 192-bit | 432 GB/s | 7,680 | 240 | 210 |

| RTX 5000 Ada | 32 GB | 256-bit | 576 GB/s | 12,800 | 400 | 250 |

| RTX 6000 Ada | 48 GB | 384-bit | 960 GB/s | 18,176 | 568 | 300 |

Ancho de Banda de Memoria:

- RTX 5090 (1792 GB/s), luego RTX 4090 (1008 GB/s), luego RTX 6000 Ada (960 GB/s)

Núcleos Tensor:

- RTX 5090 (680), luego RTX 6000 Ada (568), luego RTX 4090 (512)

Núcleos CUDA

- RTX 5090 (21,760), luego RTX 6000 Ada (18,176), luego RTX 4090 (16,384)

RAM

- RTX 6000 Ada (48 GB), luego RTX 5090 y RTX 5000 Ada (32 GB), luego RTX 4090 (24 GB)

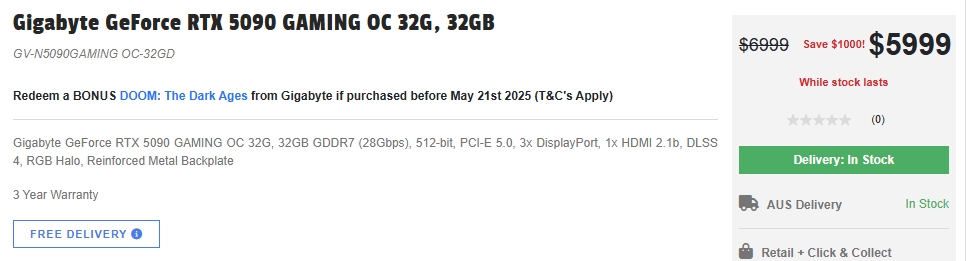

Precios en Australia

- RTX 6000 Ada: 12,000 AUD

- RTX 5090: 6,000 AUD

- RTX 5000 Ada: 7,000 AUD

- RTX 4090: agotado

Mejor GPU para consumidores de LLM

Aun así, creo que la RTX 5090 sería la mejor opción para machine learning, deep learning, IA e incluso LLM :).

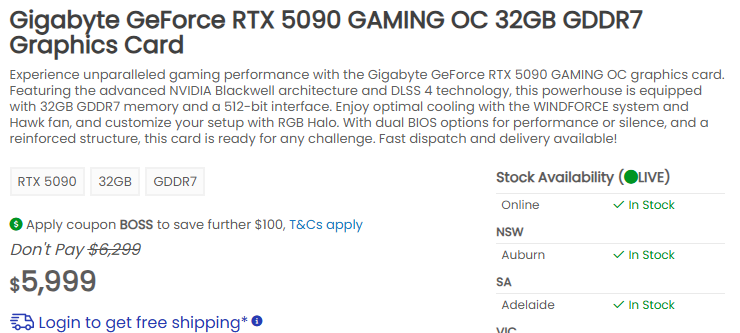

Precios reales

Un poco caras…

Y los precios reales de la RTX 5090 son un 50% más altos de lo esperado. Mira esto!

Eso fue el 15/05/2025

Para explorar benchmarks de LLM, requisitos de VRAM y ajuste de rendimiento en diferentes GPUs y entornos de ejecución, consulta nuestro Rendimiento de LLM: Benchmarks, Cuellos de Botella & Optimización.