Mover modelos de Ollama a una ubicación diferente

Los archivos del modelo LLM de Ollama ocupan mucho espacio.

Después de instalar ollama es mejor reconfigurar ollama para que los almacene en un nuevo lugar de inmediato. Así, después de que descarguemos un nuevo modelo, no se descargará en la ubicación antigua.

Sobre Ollama

Ollama es una interfaz basada en texto para modelos de IA LLM y una API que también puede alojarlos. Para una comparación más amplia de Ollama con vLLM, Docker Model Runner, LocalAI y proveedores en la nube—incluyendo consideraciones de costo e infraestructura—consulte Comparación de infraestructura para alojar LLM: local, autoalojado y en la nube.

Instalar Ollama

Vaya a https://ollama.com/download

Para instalar Ollama en Linux:

curl -fsSL https://ollama.com/install.sh | sh

Ollama en Windows está en la página: https://ollama.com/download/windows Ollama para Mac también está allí: https://ollama.com/download/macOllamaSetup.exe

Descargar, listar y eliminar modelos de Ollama

Para descargar algunos modelos de Ollama: Vaya a la Biblioteca de Ollama (https://ollama.com/library) y encuentre el modelo que necesita, también puede encontrar allí etiquetas y tamaños de modelos.

Luego ejecute:

ollama pull gemma2:latest

# O también obtenga una versión ligeramente más inteligente que aún se ajusta bien a 16 GB de VRAM:

ollama pull gemma2:27b-instruct-q3_K_S

# O:

ollama pull llama3.1:latest

ollama pull llama3.1:8b-instruct-q8_0

ollama pull mistral-nemo:12b-instruct-2407-q6_K

ollama pull mistral-small:22b-instruct-2409-q4_0

ollama pull phi3:14b-medium-128k-instruct-q6_K

ollama pull qwen2.5:14b-instruct-q5_0

Para verificar los modelos que Ollama tiene en su repositorio local:

ollama list

Para eliminar algunos modelos innecesarios:

ollama rm qwen2:7b-instruct-q8_0 # por ejemplo

Ubicación de los modelos de Ollama

Por defecto, los archivos de modelos se almacenan en:

- Windows: C:\Users%username%.ollama\models

- Linux: /usr/share/ollama/.ollama/models

- macOS: ~/.ollama/models

Configurar la ubicación de los modelos de Ollama en Windows

Para crear una variable de entorno en Windows puede seguir estas instrucciones:

- Abra la configuración de Windows.

- Vaya a Sistema.

- Seleccione Acerca de.

- Seleccione Configuración del sistema avanzada.

- Vaya a la pestaña Avanzada.

- Seleccione Variables de entorno…

- Haga clic en Nuevo…

- Y cree una variable llamada OLLAMA_MODELS que apunte a donde quiere almacenar los modelos

Mover modelos de Ollama en Linux

Edite los parámetros del servicio systemd de Ollama

sudo systemctl edit ollama.service

o

sudo xed /etc/systemd/system/ollama.service

Esto abrirá un editor.

Para cada variable de entorno, agregue una línea Environment bajo la sección [Service]:

[Service]

Environment="OLLAMA_MODELS=/specialplace/ollama/models"

Guarde y salga.

También hay parámetros de Usuario y Grupo, estos deben tener acceso a esta carpeta.

Recargue systemd y reinicie Ollama:

sudo systemctl daemon-reload

sudo systemctl restart ollama

si algo salió mal

systemctl status ollama.service

sudo journalctl -u ollama.service

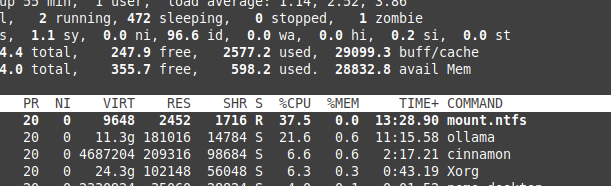

Almacenamiento de archivos en partición NTFS

Por favor, tenga en cuenta que si está ejecutando Linux y guardando sus modelos en una partición formateada en NTFS, sus modelos se cargarán mucho más lento, más del 20%.

Instalar Ollama en Windows en una carpeta específica

Junto con los modelos

.\OllamaSetup.exe /DIR=D:\OllamaDir

Exponer la API de Ollama en la red interna

Aquí, interno significa red local.

Agregue a la configuración del servicio:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

Para ver cómo se ajusta Ollama con otras opciones locales y en la nube de LLM, consulte nuestra Comparación de infraestructura para alojar LLM: local, autoalojado y en la nube.

Enlaces útiles

- Prueba: Cómo Ollama está utilizando el rendimiento de los núcleos de CPU de Intel y núcleos eficientes

- Cómo Ollama maneja solicitudes en paralelo

- Rendimiento de LLM y canales PCIe: consideraciones clave

- Comparación de velocidad de LLM

- Comparación de habilidades de resumen de LLM

- Escribir prompts efectivos para LLMs

- Autoalojar Perplexica con Ollama

- Proveedores de LLM en la nube