Hardware

Auto-Hospedagem de LLM e Soberania Artificial

Controle dados e modelos com LLMs auto-hospedados

Auto-hospedagem de LLMs mantém os dados, modelos e inferência sob seu controle - um caminho prático para soberania em IA para equipes, empresas e nações.

Aqui: o que é a soberania em IA, quais aspectos e métodos são usados para construí-la, como a auto-hospedagem de LLMs se encaixa, e como países estão abordando o desafio.

Melhores LLMs para Ollama em GPU com 16GB de VRAM

Teste de velocidade de LLM na RTX 4080 com 16 GB de VRAM

Executar modelos de linguagem grandes localmente oferece privacidade, capacidade offline e zero custos de API. Este benchmark revela exatamente o que se pode esperar de 9 populares LLMs no Ollama no RTX 4080.

Preços de GPU e RAM Disparam na Austrália: RTX 5090 Subiu 15%, RAM Subiu 38% - Janeiro de 2026

Verificação de preços de GPU e RAM em janeiro de 2025

Hoje estamos analisando as GPUs de alto desempenho para consumidores e módulos de RAM.

Especificamente, estou olhando para

preços da RTX-5080 e RTX-5090, e 32GB (2x16GB) DDR5 6000.

Melhores Emuladores de Terminal para Linux: Comparação de 2026

Escolha o terminal certo para seu fluxo de trabalho no Linux

Preço do DGX Spark AU: de $6.249 a $7.999 em grandes varejistas

Preço real em AUD de varejistas australianos agora

O

NVIDIA DGX Spark

(GB10 Grace Blackwell) está

agora disponível na Austrália

em grandes varejistas de PCs com estoque local.

Se você tem acompanhado o

preço e disponibilidade globais do DGX Spark,

você ficará interessado em saber que os preços na Austrália variam de $6.249 a $7.999 AUD, dependendo da configuração de armazenamento e do varejista.

Autosserviço do Cognee: Testes de Desempenho de LLM

Testando o Cognee com LLMs locais - resultados reais

Cognee é um framework Python para construir grafos de conhecimento a partir de documentos usando LLMs. Mas funciona com modelos auto-hospedados?

Ubuntu perdeu a rede após a atualização do kernel

Como resolvi problemas de rede no Ubuntu

Após instalar automaticamente um novo kernel, Ubuntu 24.04 perdeu a rede Ethernet. Este problema frustrante aconteceu comigo pela segunda vez, então estou documentando a solução aqui para ajudar outros que enfrentam o mesmo problema.

Preço da RAM na Austrália - Dezembro de 2025

Posto curto, apenas registrando o preço

Com essa volatilidade louca dos preços da RAM, para formar e ter uma melhor ideia, vamos rastrear o preço da RAM na Austrália primeiro nós mesmos.

Surto no Preço da RAM: Até 619% em 2025

Preços da RAM disparam entre 163% e 619% à medida que a demanda por IA pressiona a oferta

O mercado de memória está experimentando uma volatilidade de preços sem precedentes no final de 2025, com preços da RAM disparando dramaticamente em todos os segmentos.

Preços da NVidia RTX 5080 e RTX 5090 na Austrália - novembro de 2025

Preços de GPUs para Consumo Adequadas para IA - RTX 5080 e RTX 5090

Vamos comparar os preços das principais GPUs de consumo para o topo, que são adequadas para LLMs em particular e para a IA em geral.

Especificamente, estou olhando para

preços do RTX-5080 e RTX-5090.

Infraestrutura de IA em Hardware para Consumo

Implante IA empresarial em hardware de baixo custo com modelos abertos

A democratização da IA está aqui. Com LLMs de código aberto como Llama 3, Mixtral e Qwen agora rivalizando com modelos proprietários, as equipes podem construir infraestrutura poderosa de IA usando hardware de consumo - reduzindo custos enquanto mantêm o controle completo sobre a privacidade dos dados e o deployment.

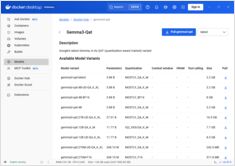

Adicionando suporte a GPU da NVIDIA ao Docker Model Runner

Habilite a aceleração da GPU para o Docker Model Runner com suporte à NVIDIA CUDA

Docker Model Runner é a ferramenta oficial do Docker para executar modelos de IA localmente, mas habilitar a aceleração da GPU da NVidia no Docker Model Runner requer uma configuração específica.

NVIDIA DGX Spark vs Mac Studio vs RTX-4080: Comparação de Desempenho do Ollama

Benchmarks do GPT-OSS 120b em três plataformas de IA

Fui atrás de alguns testes de desempenho interessantes do GPT-OSS 120b em execução no Ollama em três plataformas diferentes: NVIDIA DGX Spark, Mac Studio e RTX 4080. O modelo GPT-OSS 120b da biblioteca Ollama tem 65GB, o que significa que ele não cabe na VRAM de 16GB de um RTX 4080 (ou no mais novo RTX 5080).

Docker Model Runner Cheatsheet: Comandos e Exemplos

Referência rápida para comandos do Docker Model Runner

Docker Model Runner (DMR) é a solução oficial do Docker para executar modelos de IA localmente, introduzida em abril de 2025. Este guia rápido fornece uma referência rápida para todos os comandos essenciais, configurações e melhores práticas.

GNOME Boxes: Um Guia Abrangente sobre Funcionalidades, Vantagens, Desafios e Alternativas

Gerenciamento simples de VM para Linux com GNOME Boxes

No cenário atual da computação, a virtualização tornou-se essencial para desenvolvimento, testes e execução de múltiplos sistemas operacionais. Para usuários de Linux que buscam uma forma simples e intuitiva de gerenciar máquinas virtuais, GNOME Boxes destaca-se como uma opção leve e amigável ao usuário que prioriza a facilidade de uso sem sacrificar a funcionalidade.