Farfalle vs Perplexica

Porównanie dwóch samodzielnie hostowanych silników wyszukiwania AI

Świetna jedzenie to przyjemność dla oczu również. Ale w tym poście porównamy dwa systemy wyszukiwania oparte na AI, Farfalle i Perplexica.

Przy okazji, ten kształt makaronu nazywa się również “farfalle”.

Ale tutaj porównuję tylko to, jak te dwa systemy zachowują się. Nie kształty makaronu.

OK. Skup się!

Proszę zobaczyć również Instalacja i konfiguracja Perplexica - z ollama oraz Instalacja i konfiguracja Ollama.

Perplexica

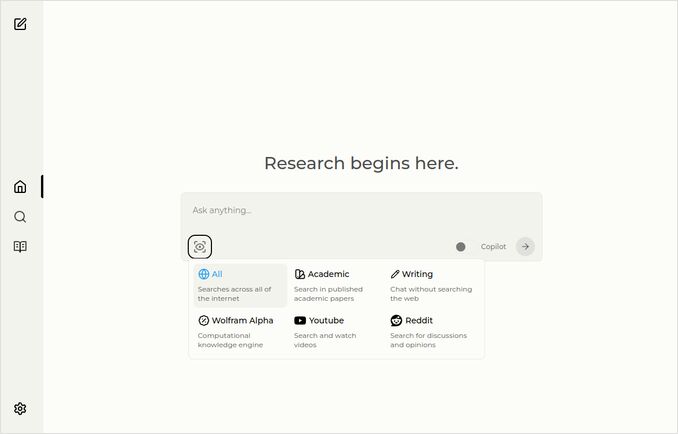

Oto strona główna z rozwijanym menu wyboru źródeł.

- Perplexica jest zaimplementowana w

- TypeScript i React.Js (UI)

- TypeScript i Express.Js (Backend)

- zawiera również konfigurację do silnika metawyszukiwania SearxNG

- Ma tryb Copilot

- Ma możliwość użycia dowolnego modelu LLM hostowanego przez Ollama jako modelu do rozmów lub modelu do wstawiania wektorów

- Ma trzy małe wewnętrzne modele wstawiania wektorów

Farfalle

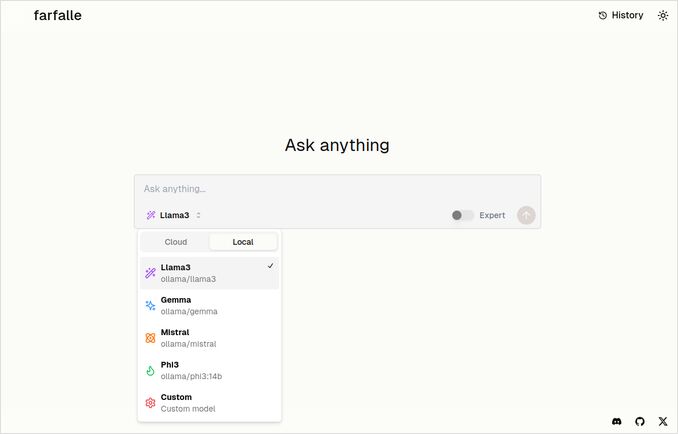

- Farfalle jest zaimplementowana w

- TypeScript i React.Js (UI)

- Python Fastapi (Backend)

- zawiera również odniesienie do silnika metawyszukiwania SearxNG. Nie ma wiele konfiguracji dla tego, dość standardowy obraz Docker.

- Ma tryb Eksperta, który powinien przygotować kilka żądań z oryginalnego i połączyć odpowiedzi. Ale to nie działało w naszym teście.

- Ma możliwość użycia czterech modeli LLM hostowanych przez Ollama jako modelu do rozmów (llama3, mistral, gemma, phi3). To dobre zestawienie opcji, ale chciałbym, aby było bardziej elastyczne i pozwalało używać dowolnego modelu, który Ollama obsługuje.

- Brak opcji dla modelu wstawiania wektorów

Porównanie przeprowadzone przez Perplexica i Farfalle samego

Uruchomiłem ten sam żądanie Porównaj farfalle i perplexica na podstawie odporności, społeczności, wsparcia i modeli LLM wspieranych

Oba Perplexica i Farfalle korzystały z modelu llama3 hostowanego lokalnie przez ollama. Pełna nazwa modelu to llama3 8b q4.

Nie wierzę 100% w to, co mówią odpowiedzi, tylko zobacz długość tekstu, strukturę i ogólną jakość odpowiedzi.

Wierzę w około 70%…

Odpowiedź porównania Perplexica

Porównanie Farfalle i Perplexica

Odporność

Farfalle: 8/10 - Farfalle to popularny silnik wyszukiwania AI znany z niezawodności i zdolności do obsługi złożonych zapytań. Ma silną podstawę w przetwarzaniu języka naturalnego (NLP) i uczeniu maszynowym (ML). Choć nie jest doskonały, odporność Farfalle jest dobrze ustalona.

Perplexica: 9/10 - Perplexica jest zbudowana na modelu Phi-3 firmy Meta AI, który jest zaprojektowany do odporności. Testowano go, aby dostarczał dokładnych odpowiedzi nawet wobec niejasnych lub niepewnych zapytań. Możliwość przekładania pytań i adaptacji do różnych kontekstów czyni z niego odporny silnik wyszukiwania.

Społeczność

Farfalle: 7/10 - Farfalle ma zaangażowaną społeczność użytkowników, którzy doceniają jej możliwości. Choć może nie mieć takiego samego poziomu przyjęcia jak Perplexica, społeczność użytkowników Farfalle jest nadal znacząca.

Perplexica: 8,5/10 - Perplexica zdobyła szerokie uznanie za innowacyjne podejście do silników wyszukiwania. Jej społeczność rośnie szybko, a wielu użytkowników docenia jej zdolność dostarczania dokładnych i relevantnych wyników.

Wsparcie

Farfalle: 6,5/10 - Farfalle oferuje podstawowe wsparcie poprzez FAQ, dokumentację i fora. Choć nie jest tak kompleksowe jak wsparcie Perplexica, społeczność użytkowników Farfalle jest ogólnie samodzielna.

Perplexica: 9/10 - Perplexica oferuje rozszerzone zasoby wsparcia, w tym szczegółową dokumentację, FAQ i fora społecznościowe. Jego twórcy są aktywnie zaangażowani w społeczność, zapewniając użytkownikom wdrożenie i skuteczne wsparcie w odpowiednim czasie.

Wsparcie modeli LLM

Farfalle: Nie - Farfalle to samodzielny silnik wyszukiwania AI, który nie opiera się na dużych modelach językowych (LLM) dla swoich możliwości.

Perplexica: Tak - Perplexica jest zbudowana na modelu Phi-3 firmy Meta AI, który jest LLM. To pozwala Perplexica wykorzystać moc uczenia głębokiego dla bardziej dokładnych i relevantnych wyników.

Ogólny wynik Farfalle: 22/30 Perplexica: 34,5/40

Na podstawie tych kryteriów, Perplexica wydaje się mieć lekkie przewagę nad Farfalle pod względem odporności, wsparcia społeczności i integracji z modelem LLM. Jednak oba silniki wyszukiwania mają swoje zalety, a wybór zależy w końcu od Twoich konkretnych potrzeb i preferencji.

Rekomendacja Jeśli szukasz niezawodnego silnika wyszukiwania AI z silnymi możliwościami przetwarzania języka naturalnego, Perplexica może być lepszym wyborem. Jeśli preferujesz prostszy, bez zbędnych funkcji podejście do wyszukiwania, Farfalle nadal może dostarczyć wspaniałych wyników.

Odpowiedź porównania Farfalle

Porównanie Farfalle i Perplexica

Farfalle i Perplexica to dwa silniki wyszukiwania oparte na AI, które zyskały na uwadze w ostatnim czasie. Oto porównanie tych dwóch projektów na podstawie odporności, społeczności, wsparcia i wsparcia modeli LLM (Large Language Model).

Odporność

- Farfalle jest zaprojektowana do samodostosowania z lokalnymi lub chmurowymi modelami LLM, co czyni ją bardziej odporną opcją dla użytkowników, którzy chcą mieć kontrolę nad swoim silnikiem wyszukiwania.

- Perplexica z kolei jest otwartym źródłem alternatywą dla Perplexity AI i stale poprawiana przez swoich twórców.

Społeczność

- Perplexica ma zaangażowaną społeczność programistów i użytkowników, którzy przyczyniają się do jej rozwoju i dostarczają wsparcia

- Społeczność Farfalle jest mniejsza, ale nadal ma obecność na GitHub

Wsparcie

- Perplexica oferuje regularne aktualizacje i poprawki, a także kanał Discordowy do dyskusji poza regularnym wsparciem

- Wsparcie Farfalle ogranicza się do problemów i propozycji zmian na GitHub

Wsparcie modeli LLM Oba Farfalle i Perplexica wspierają modele LLM. Perplexica korzysta z Ollama, lokalnego modelu LLM, podczas gdy Farfalle wspiera zarówno lokalne, jak i chmurowe modele LLM.

Podsumowując, Farfalle jest bardziej odporna dzięki swojej architekturze samodostosowania, podczas gdy Perplexica ma silniejszą społeczność i lepsze wsparcie. Oba projekty wspierają modele LLM, ale Perplexica korzysta z Ollama konkretnie.

Wnioski

Jaka jest różnica między Perplexica a Farfalle?

Odpowiedź:

- Pomimo pewnych błędów faktualnych, oba systemy uważają, że Perplexica jest lepsza niż Farfalle, co chciałbym zaakceptować.

- Bardzo lubię interfejs użytkownika Farfalle, choć są one dość bliskie

- Lubię pomysł trybu eksperta Farfalle, choć nie działał w moim środowisku

- Natknąłem się na 3 błędy podczas uruchamiania Farfalle. Kod Perplexica jest bardziej wyrafinowany

- Po skonfigurowaniu, Perplexica działała bez żadnych błędów

- Perplexica pozwala używać dowolnego modelu hostowanego przez Ollama. Farfalle pozwala używać tylko Gemma, Llama3, Mistral i Phi3 (przeddefiniowane wersje, które są nieco przestarzałe).

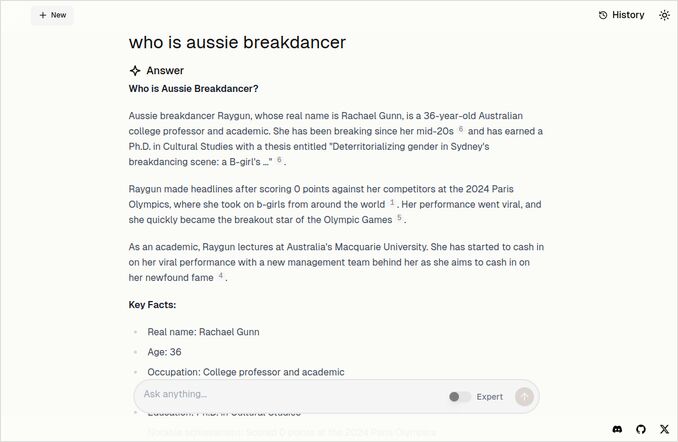

- Lubię odpowiedzi Farfalle. Zobacz obrazek Farfalle poniżej. Prosto do rzeczy bez tych „Zgodnie z kontekstem dostarczonym”…

Więcej przykładów

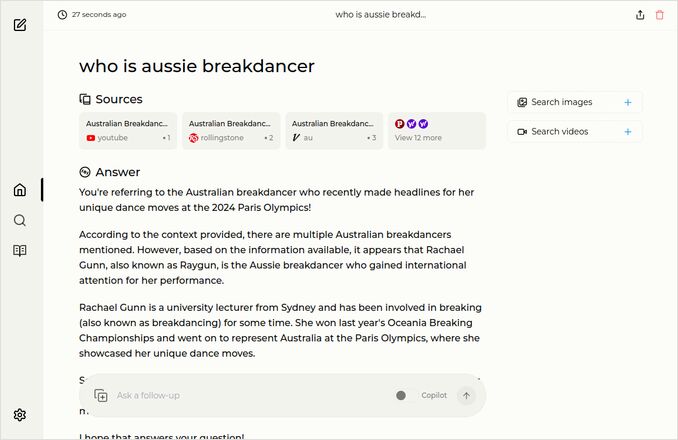

Te pokazują odpowiedzi na to samo pytanie o australijskiego breakdancer. Wiesz, tego z doktorat, który zdobył 0 (Zero) punktów i prawdopodobnie wykluczył breakdancing z programu olimpijskiego.

Odpowiedź Farfalle

Odpowiedź Perplexica

Jeśli przeczytasz (lub przeczytasz) ten ostatni akapit, dziękuję, że dzielisz swoimi zainteresowaniami. To naprawdę ekscytujące czasy. Mam nadzieję, że będziecie dobrze!

Przydatne linki

- Wyszukiwanie vs Deepsearch vs Deep Research

- Test: Jak Ollama wykorzystuje wydajność procesora Intel i jądra efektywne

- Jak Ollama obsługuje żądania równoległe

- Samodostosowanie Perplexica - z Ollama

- Porównanie możliwości sumaryzacji modeli LLM

- Pisanie skutecznych promptów dla LLM

- Testowanie wykrywania błędów logicznych przez nowe LLM: gemma2, qwen2 i mistral Nemo

- Ollama cheatsheet

- Cheatsheet Markdown

- Dostawcy LLM w chmurze

- Modele Qwen3 Embedding & Reranker na Ollama: Stan technologii