Docker Model Runner vs Ollama(2026年):ローカルLLMにおいてどちらが優れているか?

Docker Model RunnerとOllamaを比較してみる:ローカルLLM向け

ローカルで大規模言語モデル(LLM)を実行する は、プライバシー、コスト管理、オフライン機能のためにますます人気になってきています。 2025年4月にDockerが**Docker Model Runner (DMR)**を導入し、AIモデルの展開用の公式ソリューションとして登場したことで、状況は大きく変わりました。

今や、開発者の関心を引く3つのアプローチが競い合っています:Docker本家のModel Runner、第三者のコンテナ化ソリューション(vLLM、TGI)、およびスタンドアロンのOllamaプラットフォーム。

クラウドプロバイダーおよびインフラストラクチャのトレードオフを含むより広い視点については、LLMホスティング:ローカル、セルフホスト、クラウドインフラストラクチャの比較を参照してください。

TL;DR – Docker Model Runner vs Ollama

この比較は、Dockerまたはスタンドアロンランタイムを使用してローカルで大規模言語モデル(LLM)を実行することに焦点を当てています。パフォーマンス、GPUサポート、APIの互換性、およびプロダクション展開のシナリオをカバーしています。

- Dockerネイティブワークフローに最適: Docker Model Runner

- シンプルさと迅速なプロトタイピングに最適: Ollama

- Kubernetesおよびオーケストレーションに最適: Dockerベースの設定

- 単一マシン開発に最適: Ollama

すでにDockerを積極的に使用している場合は、DMRが理にかなっています。

ローカルでLLMを実行する最も簡単な方法を望む場合は、Ollamaがシンプルです。

Docker Model RunnerとOllama以外のものを比較している場合は、Ollama vs vLLM vs LM Studioおよび他のローカルLLMツールの完全な比較ガイドをご覧ください。このガイドでは、12以上のローカルLLMランタイムにわたってAPIの成熟度、ハードウェアサポート、ツール呼び出し、およびプロダクション準備状況を比較しています。

Docker Model Runner vs Ollama:直接比較

DockerがLLMランナー空間に公式に参入したことで、この比較はより興味深いものになりました。DMRとOllamaの直接比較を以下に示します:

| フィーチャー | Docker Model Runner | Ollama |

|---|---|---|

| インストール | Docker Desktop AIタブまたはdocker-model-plugin |

単一コマンド:curl | sh |

| コマンドスタイル | docker model pull/run/package |

ollama pull/run/list |

| モデルフォーマット | GGUF(OCIアーテファクト) | GGUF(ネイティブ) |

| モデル配布 | Docker Hub、OCIレジストリ | Ollamaレジストリ |

| GPU設定 | 自動(伝統的なDockerよりも簡単) | 自動 |

| API | OpenAI互換 | OpenAI互換 |

| Docker統合 | ネイティブ(Docker自体) | 必要に応じてDockerで実行可能 |

| Composeサポート | ネイティブ | Dockerイメージ経由 |

| 学習曲線 | 低(Dockerユーザー向け) | 最低(誰でも) |

| エコシステムパートナー | Google、Hugging Face、VMware | LangChain、CrewAI、Open WebUI |

| 最適な用途 | Dockerネイティブワークフロー | スタンドアロンのシンプルさ |

主要な洞察: DMRはLLM展開にDockerワークフローをもたらし、Ollamaはフレームワークに依存せず、シンプルなスタンドアロン操作を提供します。既存のインフラストラクチャが技術的な違いよりも重要です。

Docker Model RunnerはOllamaより優れているか?

それはあなたのワークフローに依存します。

- Docker Model Runner(DMR)を選びましょうもし、チームがすでにDocker、OCIアーテファクト、およびコンテナオーケストレーションに大きく依存している場合。

- Ollamaを選びましょうもし、LLMをローカルで実行する最も簡単な方法を望む場合で、最小限の設定と迅速なプロトタイピングを望む場合。

ほとんどの単一マシン構成では、Ollamaが使いやすいです。

DockerネイティブCI/CDパイプラインおよび企業用コンテナワークフローでは、DMRがより自然に統合されます。

LLMをDockerで実行する方法:DMR vs Ollama

あなたの目的が単にDocker内でLLMを実行することであれば、Docker Model RunnerとDockerコンテナ内で動作するOllamaのどちらもこの目標を達成できます。

Docker Model Runnerはネイティブのdocker model pullとdocker model runコマンドを使用し、モデルをOCIアーテファクトとしてパッケージ化します。

Ollamaは公式のollama/ollamaコンテナイメージを使用してDocker内でも実行でき、ポート11434でOpenAI互換のAPIを公開します。

主な違いはワークフロー統合にあります:

- DMRはDockerネイティブCI/CDパイプラインに自然に適合します。

- Docker内でのOllamaは、Dockerオーケストレーションの柔軟性を伴ったシンプルなモデル管理を提供します。

Docker Model Runnerの理解

Dockerベースのモデルランナーは、コンテナ化によってLLM推論エンジンとその依存関係をパッケージ化します。この分野には、Dockerの公式ソリューションと第三者フレームワークの両方が含まれます。

Docker Model Runner(DMR)- 公式ソリューション

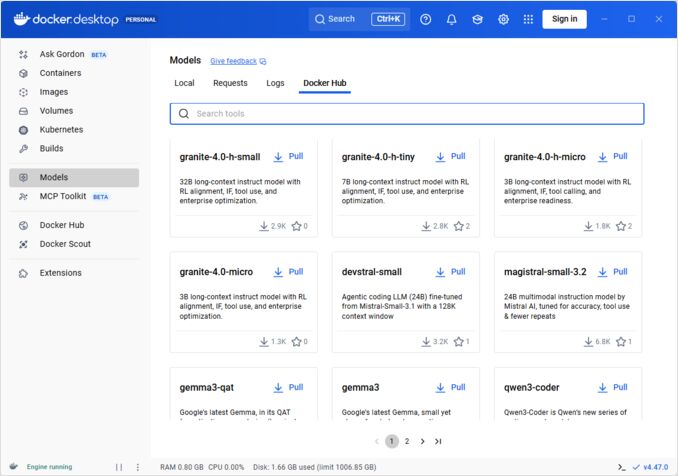

2025年4月にDockerは、**Docker Model Runner(DMR)**という公式製品を導入しました。これは、Dockerのインフラストラクチャを使用してローカルでAIモデルを実行するのを簡単にするために設計されています。これは、DockerがAIモデルの展開をコンテナ展開と同じように簡単にするというコミットメントを示しています。

DMRの主な機能:

- ネイティブDocker統合: 親しみやすいDockerコマンド(

docker model pull、docker model run、docker model package)を使用 - OCIアーテファクトパッケージ化: モデルはOCIアーテファクトとしてパッケージ化され、Docker Hubおよび他のレジストリを通じて配布可能

- OpenAI互換API: OpenAIエンドポイントの即時置き換え、統合を簡略化

- GPU加速: 複雑なnvidia-docker構成なしにネイティブGPUサポート

- GGUFフォーマットサポート: 人気のあるクアンタイズモデルフォーマットと互換性あり

- Docker Compose統合: 標準Dockerツールを使用してモデルを簡単に構成および展開

- Testcontainersサポート: テストフレームワークとシームレスに統合

インストール:

- Docker Desktop: 設定のAIタブで有効化

- Docker Engine:

docker-model-pluginパッケージをインストール

使用例:

# Docker Hubからモデルをプル

docker model pull ai/smollm2

# 推論を実行

docker model run ai/smollm2 "Docker Model Runnerを説明してください"

# カスタムモデルをパッケージ

docker model package --gguf /path/to/model.gguf --push myorg/mymodel:latest

docker modelコマンド、パッケージングオプション、構成フラグ、および実践的な例の完全なリファレンスについては、Docker Model Runnerチートシート: コマンドと例を参照してください。モデルプル、パッケージング、構成、およびDockerを使用してローカルでLLMを展開するためのベストプラクティスをカバーしています。

DMRはGoogle、Hugging Face、およびVMware Tanzuと提携しており、Docker Hubを通じて利用可能なAIモデルエコシステムを拡張しています。Dockerに新規またはリフレッシュが必要な場合は、Dockerチートシートで、必須のDocker操作に関する包括的なガイドをご覧ください。

第三者Dockerソリューション

DMR以外にも、確立されたフレームワークが存在します:

- vLLMコンテナ: バッチ処理に最適化された高スループット推論サーバー

- テキスト生成推論(TGI): Hugging Faceの生産性に適したソリューション

- llama.cppコンテナ: 量子化を伴う軽量なC++実装

- カスタムコンテナ: PyTorch、Transformers、またはプロプライエタリフレームワークをラッピング

Dockerアプローチの利点

柔軟性とフレームワーク非依存性: Dockerコンテナは、PyTorchからONNXランタイムに至るあらゆるLLMフレームワークを実行でき、開発者が推論スタックを完全にコントロールできます。

リソース分離: 各コンテナは定義されたリソース制限(CPU、メモリ、GPU)を持つ分離された環境で動作し、マルチモデル展開時のリソース競合を防止します。

オーケストレーションサポート: DockerはKubernetes、Docker Swarm、クラウドプラットフォームとシームレスに統合され、スケーリング、ロードバランシング、高可用性を提供します。

バージョン管理: 同じシステム上に異なるモデルバージョンやフレームワークを共存させ、依存関係の競合を回避できます。

Dockerアプローチの欠点

複雑さ: コンテナ化、ボリュームマウント、ネットワーク構成、GPUパススルー(nvidia-docker)の理解が必要です。

オーバーヘッド: 最小限ではありますが、Dockerはわずかな抽象化レイヤーを追加し、起動時間とリソース使用にわずかな影響を与えます。

構成負荷: 各展開ではDockerfile、環境変数、ランタイムパラメータの慎重な構成が必要です。

Ollamaの理解

Ollamaは、LLMをローカルで実行するための目的に特化したアプリケーションで、シンプルさがその核の原理です。提供する機能には以下があります:

- Linux、macOS、Windows用のネイティブバイナリ

- 1コマンドでインストール可能な組み込みモデルライブラリ

- 自動GPU検出と最適化

- OpenAI形式と互換性のあるRESTful API

- モデルコンテキストおよび状態管理

Ollamaの利点

シンプルさ: インストールは簡単(Linuxではcurl | sh)、モデルの実行にはollama run llama2だけです。Ollama CLIコマンド(ollama serve、ollama run、ollama ps)やモデル管理ワークフローの完全なリファレンスについては、Ollama CLIチートシートを参照してください。

最適化されたパフォーマンス: llama.cppに基づいており、量子化サポート(Q4、Q5、Q8)により、推論速度が非常に最適化されています。

モデル管理: 命令ollama pull、ollama list、ollama rmを使用した組み込みモデルレジストリにより、モデルライフサイクルが簡略化されています。

開発者体験: クリーンなAPI、豊富なドキュメント、および拡大するエコシステム(LangChain、CrewAIなど)。Ollamaの汎用性は、埋め込みモデルを使用したテキストドキュメントの再ランキングなどの専門用途にも広がります。

リソース効率: 空いているときにモデルを自動的にアンロードし、システムリソースを節約する自動メモリ管理。

Ollamaの欠点

フレームワークの制限: 主にllama.cpp互換モデルをサポートし、vLLMやカスタム推論エンジンなどのフレームワークの柔軟性を制限します。

限定されたカスタマイズ: データベースや特定のCUDAストリームなどの高度な構成は、Docker環境よりもアクセスが困難です。

オーケストレーションの課題: Ollamaはコンテナで実行できますが、水平スケーリングなどの高度なオーケストレーション機能にはネイティブサポートがありません。

パフォーマンス比較

推論速度

Docker Model Runner: Ollamaと同様にGGUF量子化モデルをサポートしているため、パフォーマンスは比較的近いです。Llama 2 7B (Q4)では、CPUでは20-30トークン/秒、中規模GPUでは50-80トークン/秒が期待されます。コンテナのオーバーヘッドは最小です。

Ollama: 高度に最適化されたllama.cppバックエンドを使用し、効率的な量子化を提供します。Llama 2 7B (Q4)では、CPUでは20-30トークン/秒、中規模GPUでは50-80トークン/秒が期待されます。コンテナ化のオーバーヘッドはありません。Ollamaが並列リクエストを処理する方法については、Ollamaが並列リクエストを処理する方法の分析をご覧ください。

Docker (vLLM): 連続バッチ処理に最適化されており、単一リクエストはやや遅いかもしれませんが、高並列負荷(100トークン/秒以上のモデル)ではスループットが優れています。

Docker (TGI): vLLMと同様に、バッチ処理性能が優れており、ストリーミングおよびトークンごとの生成機能を追加しています。

メモリ使用量

Docker Model Runner: Ollamaと同様に自動モデルロードが可能です。GGUF Q4モデルは通常4-6GB RAMを使用します。コンテナのオーバーヘッドは最小(数十MB)です。

コンテキストサイズの設定は、メモリ使用量とモデルの動作に大きな影響を与えることがあります。デフォルトでは、一部のDocker Model Runner CUDAイメージが4096トークンの制限をハードコードしており、docker-composeでより高い値を指定しても無視されることがあります。Docker Model Runnerでカスタムコンテキストサイズでモデルをパッケージする方法については、Docker Model Runnerでコンテキストサイズを設定する方法のガイドをご覧ください。

Ollama: モデルを必要に応じて自動的にロードし、アイドル時にアンロードする自動メモリ管理が可能です。7B Q4モデルは通常4-6GB RAMを使用します。単一モデルのシナリオでは最も効率的です。

伝統的なDockerソリューション: メモリはフレームワークに依存します。vLLMはGPUメモリを事前割り当てして最適なパフォーマンスを実現しますが、PyTorchベースのコンテナはモデルの重みおよびKVキャッシュ(7Bモデルでは8-14GB)に多くのRAMを使用する可能性があります。

起動時間

Docker Model Runner: コンテナ起動は約1秒かかり、モデルロード(2-5秒)が必要です。中規模モデルでは合計で3-6秒かかります。

Ollama: コンテナ起動はわずかで、モデルロードに中規模モデルでは2-5秒かかります。最も速い冷起動体験です。

伝統的なDocker: コンテナ起動は1-3秒かかり、モデルロード時間がかかります。生産展開ではコンテナのプリウォームによりこの問題を緩和できます。

用途別推奨

Docker Model Runnerを選択するとき

- Dockerファーストワークフロー: すでにDockerを広く使用しているチーム

- 統合されたツール: コンテナとモデルの両方を1つのツール(Docker)で扱いたい

- OCIアーテファクト配布: 企業レジストリ統合が必要

- Testcontainers統合: CI/CDでのAI機能テスト

- Docker Hubの好意: 既存のチャネルを通じたモデル配布を望む

Ollamaを選択するとき

- 迅速なプロトタイピング: 異なるモデルを迅速に試験したい

- フレームワーク非依存: Dockerエコシステムに縛られたくない

- 絶対的なシンプルさ: 最小限の構成とメンテナンスオーバーヘッド

- 単一サーバー展開: ラップトップ、ワークステーション、または単一のVMで実行

- 大規模モデルライブラリ: 拡張された事前設定済みモデルレジストリにアクセスしたい

第三者Dockerソリューションを選択するとき

- 生産展開: 高度なオーケストレーションと監視が必要

- マルチモデルサービング: vLLM、TGIなどの異なるフレームワークを同時に実行

- Kubernetesオーケストレーション: クラスタスケーリングとロードバランシング

- カスタムフレームワーク: Ray Serveまたはプロプライエタリ推論エンジンを使用

- 厳密なリソース管理: モデルごとに細かいCPU/GPU制限を課す必要がある

ハイブリッドアプローチ: 最も良い点の組み合わせ

単一のアプローチに縛られることはありません。以下のハイブリッド戦略を検討してください:

オプション1: Docker Model Runner + 伝統的なコンテナ

標準モデルにDMRを使用し、専門的なフレームワークに第三コンテナを使用します:

# DMRで標準モデルをプル

docker model pull ai/llama2

# 高スループットシナリオでvLLMを実行

docker run --gpus all vllm/vllm-openai

オプション2: Docker内でのOllama

Dockerコンテナ内でOllamaを実行してオーケストレーション機能を提供します:

docker run -d \

--name ollama \

--gpus all \

-v ollama:/root/.ollama \

-p 11434:11434 \

ollama/ollama

これにより以下が提供されます:

- Ollamaの直感的なモデル管理

- Dockerのオーケストレーションおよび分離機能

- Kubernetesでの標準マニフェストによる展開

オプション3: 用途別に混在させる

- 開発: Ollamaで迅速なイテレーション

- ステージング: Docker Model Runnerで統合テスト

- 生産: KubernetesでのvLLM/TGIによるスケーリング

API互換性

すべての現代的なソリューションはOpenAI互換のAPIに収束しており、統合を簡略化しています:

Docker Model Runner API: モデルを実行するだけで、自動的にOpenAI互換エンドポイントが提供されます。追加の構成は不要です。

# モデルを実行してAPIが自動的に公開される

docker model run ai/llama2

# OpenAI互換エンドポイントを使用

curl http://localhost:8080/v1/chat/completions -d '{

"model": "llama2",

"messages": [{"role": "user", "content": "なぜ空は青いのですか?"}]

}'

Ollama API: OpenAI互換エンドポイントは、OpenAI SDKを使用するアプリケーションの即時置き換えとして機能します。ストリーミングも完全にサポートされています。

curl http://localhost:11434/api/generate -d '{

"model": "llama2",

"prompt": "なぜ空は青いのですか?"

}'

第三者Docker API: vLLMおよびTGIはOpenAI互換エンドポイントを提供し、カスタムコンテナはプロプライエタリAPIを実装する場合があります。

OpenAI互換性への収束により、ソリューション間の切り替えに必要なコード変更は最小限です。

リソース管理

GPU加速

Docker Model Runner: 複雑なnvidia-docker構成なしにネイティブGPUサポート。利用可能なGPUを自動検出し、使用し、伝統的なコンテナに比べてDocker GPU体験を大幅に簡略化します。

NVIDIA GPUを使用してCUDA加速を正しく構成したい場合は、Docker Model RunnerにNVIDIA GPUサポートを追加するに関する詳細なガイドをご覧ください。Dockerデーモン構成、NVIDIA Container Toolkitの設定、およびLLMが実際にGPUメモリを使用しているかを確認する方法をカバーしています。

# GPU加速は自動で動作

docker model run ai/llama2

Ollama: CUDA対応のNVIDIA GPUで自動的にGPUを検出します。ドライバのインストール以外の構成は不要です。

伝統的なDockerコンテナ: nvidia-dockerランタイムおよび明示的なGPU割り当てが必要です:

docker run --gpus all my-llm-container

CPUフォールバック

どちらもGPUが利用できない場合にCPU推論にスムーズにフォールバックしますが、パフォーマンスは大幅に低下します(大規模モデルでは5-10倍遅くなります)。現代のプロセッサでのみCPUを使用したパフォーマンスについては、OllamaがIntel CPU性能と効率コアを使用する方法をご覧ください。

マルチGPUサポート

Ollama: 複数のGPUにわたるテンソル並列をサポートしています。

Docker: フレームワークに依存します。vLLMおよびTGIは適切な構成でマルチGPU推論をサポートしています。

コミュニティとエコシステム

Docker Model Runner: 2025年4月にリリースされ、強力な企業支援があります。Google、Hugging Face、VMware Tanzu AIソリューションとの提携により、Docker Hubを通じた幅広いモデルの利用が可能になりました。Dockerの膨大な開発者コミュニティ(数百万のユーザー)との統合により、即座にエコシステムへのアクセスが可能です。新規製品としてコミュニティ固有のリソースの構築はまだ進行中です。

Ollama: 50,000以上のGitHubスターを持つ急速に成長するコミュニティがあります。強力な統合エコシステム(LangChain、LiteLLM、Open WebUI、CrewAI)および活発なDiscordコミュニティがあります。豊富な第三者ツールとチュートリアルが利用可能です。より成熟したドキュメントとコミュニティリソースがあります。利用可能なインターフェースの包括的な概要については、ローカルOllamaインスタンス用のオープンソースチャットUIのガイドをご覧ください。急速に成長するオープンソースプロジェクトであるため、プロジェクトの方向性を監視することが重要です - Ollamaのenshittificationの初期の兆候の分析をご覧ください。

第三者Dockerソリューション: vLLMおよびTGIは成熟したエコシステムと企業サポートを備えています。Hugging Faceおよびコミュニティ貢献者による豊富な生産ケーススタディ、最適化ガイド、および展開パターンがあります。

コストの考慮

Docker Model Runner: Docker Desktop(個人/教育用)またはDocker Engineで無料です。Docker Desktopは250人以上の従業員または1000万ドル以上の収入を持つ大規模な組織ではサブスクリプションが必要です。Docker Hubを通じて配布されるモデルは、Dockerのレジストリ料金に従います(無料のパブリックリポジトリ、有料のプライベートリポジトリ)。

Ollama: あらゆる組織規模にかかわらず無料でオープンソースであり、ライセンスコストはありません。リソースコストはハードウェアのみに依存します。

第三者Dockerソリューション: vLLM、TGIなどのオープンソースフレームワークは無料です。コンテナオーケストレーションプラットフォーム(ECS、GKE)およびプライベートレジストリストレージのコストが発生する可能性があります。

セキュリティの考慮

Docker Model Runner: Dockerのセキュリティモデルを活用し、コンテナの分離を実現します。OCIアーテファクトとしてパッケージされたモデルはスキャンおよび署名が可能です。Docker Hubを通じた配布により、企業ユーザー向けにアクセス制御および脆弱性スキャンが可能になります。

Ollama: ローカルサービスとして動作し、デフォルトではlocalhostにAPIが公開されます。ネットワークへの公開は明示的な構成が必要です。モデルレジストリは信頼性が高い(Ollamaが管理)ため、サプライチェーンリスクが低減されます。

伝統的なDockerソリューション: ネットワーク分離は組み込みです。コンテナセキュリティスキャン(Snyk、Trivy)およびイメージ署名は生産環境での標準的な実践です。

すべてのソリューションでは以下に注意が必要です:

- モデルの出所: 信頼されていないモデルには悪意のあるコードやバックドアが含まれている可能性があります

- API認証: 生産展開では認証/認可を実装する必要があります

- レート制限: 滥用やリソース枯渇を防ぐ必要があります

- ネットワーク公開: APIがインターネットに無意識に公開されていないことを確認する必要があります

- データプライバシー: モデルは機密データを処理するため、データ保護規制に準拠する必要があります

マイグレーションパス

OllamaからDocker Model Runnerへ

Docker Model RunnerのGGUFサポートにより、マイグレーションが簡単です:

- Docker DesktopでDocker Model Runnerを有効化するか、

docker-model-pluginをインストール - モデル参照を変換:

ollama run llama2→docker model pull ai/llama2およびdocker model run ai/llama2 - APIエンドポイントを

localhost:11434からDMRエンドポイント(通常はlocalhost:8080)に更新 - 両方ともOpenAI互換APIを使用しているため、アプリケーションコードは最小限の変更で済みます

Docker Model RunnerからOllamaへ

シンプルなスタンドアロン操作のためにOllamaに移行:

- Ollamaをインストール:

curl -fsSL https://ollama.ai/install.sh | sh。Ollama CLIコマンドおよび構成オプションの完全なリストについては、Ollama CLIチートシートを参照してください。 - 類似モデルをプル:

ollama pull llama2 - APIエンドポイントをOllamaの

localhost:11434に更新 ollama run llama2で機能を確認してテスト

伝統的なDockerコンテナからDMRへ

Docker LLM構成を簡略化:

- Docker Model Runnerを有効化

- カスタムDockerfileを

docker model pullコマンドで置き換える - nvidia-docker構成を削除(DMRがGPUを自動的に処理)

- 複雑な

docker runコマンドの代わりにdocker model runを使用

どのソリューションからでもOllamaをDockerコンテナ内で実行

両方の良い点を組み合わせたアプローチ:

docker pull ollama/ollama- 実行:

docker run -d --gpus all -v ollama:/root/.ollama -p 11434:11434 ollama/ollama - 通常通りOllamaコマンドを使用:

docker exec -it ollama ollama pull llama2 - Dockerオーケストレーションを活用しつつ、Ollamaのシンプルさを享受

モニタリングと可視化

Ollama: 基本的なメトリクスはAPI経由で提供(/api/tags、/api/ps)。Open WebUIなどの第三者ツールはダッシュボードを提供します。

Docker: フル統合が可能です Prometheus, Grafana, ELKスタック、およびクラウドモニタリングサービス。コンテナメトリクス(CPU、メモリ、GPU)はすぐに利用可能です。

結論

2025年にDockerがDocker Model Runner(DMR)を導入したことで、ローカルLLM展開の風景は大きく変化しました。選択はあなたの具体的な要件に依存します:

- Docker統合を求める開発者: DMRは

docker modelコマンドを使用したネイティブDockerワークフロー統合を提供 - 最大のシンプルさを求める: Ollamaは1コマンドモデル管理で最も簡単なソリューション

- 生産および企業: DMRと第三のソリューション(vLLM、TGI)はDocker内でオーケストレーション、監視、スケーラビリティを提供

- 両方の最良: OllamaをDockerコンテナ内で実行して、シンプルさと生産インフラストラクチャの組み合わせ

DMRの導入により、DockerとOllamaの使いやすさのギャップは狭まりました。Ollamaは迅速なプロトタイピングにシンプルさで勝ち、DMRはDockerワークフローにすでに投資しているチームに優れています。どちらのアプローチも活発に開発され、生産準備ができており、エコシステムは十分に成熟しているため、切り替えるのは比較的痛みがありません。

結論: すでにDockerを広く使用している場合は、DMRが自然な選択です。インフラストラクチャに関係なく、最もシンプルな体験を望む場合は、Ollamaを選択してください。 ローカルオプションとクラウドAPI、その他のセルフホスト構成とを比較するには、LLMホスティング:ローカル、セルフホスト、クラウドインフラストラクチャの比較ガイドをご覧ください。

有用なリンク

Docker Model Runner

- Docker Model Runner公式ページ

- Docker Model Runnerドキュメント

- Docker Model Runnerの開始ガイド

- Docker Model Runnerの発表ブログ