Farfalle vs. Perplexica

Comparando dos motores de búsqueda de IA autohospedados

La comida deliciosa también es un placer para los ojos.

Pero en este post compararemos dos sistemas de búsqueda basados en IA, Farfalle y Perplexica.

Por cierto, esta forma de pasta también se llama “farfalle”.

Pero aquí solo comparo cómo estos dos sistemas se comportan. No las formas de pasta.

¡Concéntrate!

Por favor, vea también

Instalación y configuración de Perplexica con ollama

y

Instale y configure Ollama.

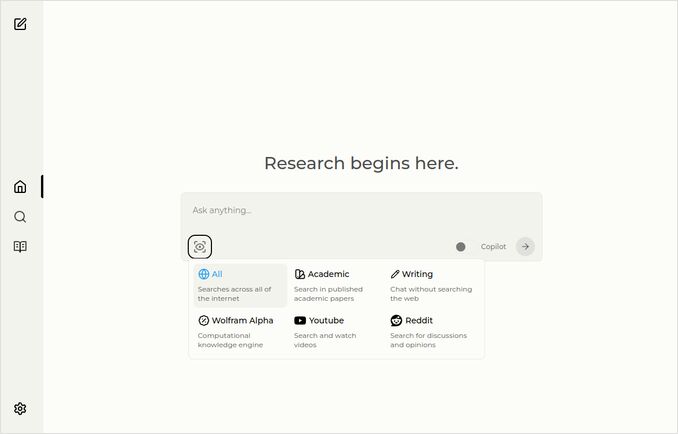

Perplexica

Aquí está la página principal con el menú desplegable para seleccionar fuentes.

- Perplexica está implementado en

- TypeScript y React.Js (Interfaz de usuario)

- TypeScript y Express.Js (Backend)

- también incluye configuración para el motor de búsqueda metasearch SearxNG

- Tiene un modo Copilot

- Tiene la capacidad de usar cualquier modelo LLM alojado en Ollama como modelo de chat o de incrustación

- Tiene tres modelos internos pequeños de incrustación

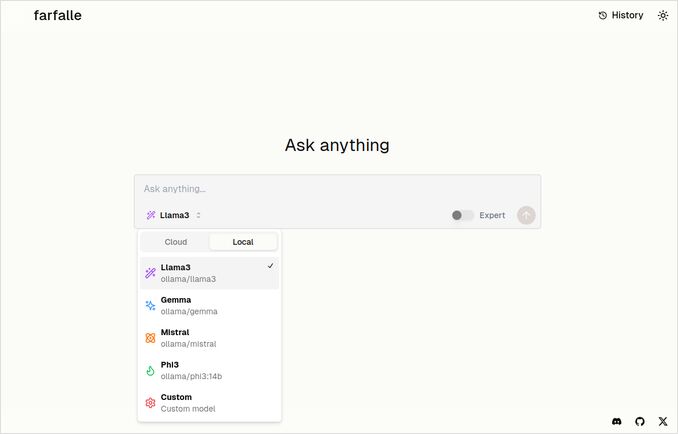

Farfalle

- Farfalle está implementado en

- TypeScript y React.Js (Interfaz de usuario)

- Python Fastapi (Backend)

- también incluye referencia para el motor de búsqueda metasearch SearxNG. No hay mucha configuración para esto, es una imagen de docker bastante estándar.

- Tiene un modo Experto que debería preparar varias solicitudes a partir de la original y combinar las respuestas. Pero esto no funcionó en nuestro test.

- Tiene la capacidad de usar cuatro modelos LLM alojados en Ollama como modelo de chat (llama3, mistral, gemma, phi3). Ese es un buen conjunto de opciones, pero preferiría que fuera más flexible y permitiera usar cualquier modelo que Ollama sirva.

- No hay opciones para modelos de incrustación

Comparación realizada por Perplexica y Farfalle mismos

He realizado la misma solicitud

Comparar farfalle y perplexica basado en robustez, comunidad, soporte y modelos LLM soportados

Ambos Perplexica y Farfalle estaban usando el modelo llama3 alojado localmente en ollama. El nombre completo del modelo es llama3 8b q4.

No creas al 100% lo que dicen las respuestas, solo mira la longitud del texto, estructura y calidad general de la respuesta.

Creería aproximadamente el 70%…

Respuesta de comparación de Perplexica

Comparación de Farfalle y Perplexica

Robustez

Farfalle: 8/10 - Farfalle es un motor de búsqueda de IA popular conocido por su fiabilidad y capacidad para manejar consultas complejas. Tiene una sólida base en procesamiento de lenguaje natural (NLP) y aprendizaje automático (ML). Aunque no sea perfecto, la robustez de Farfalle está bien establecida.

Perplexica: 9/10 - Perplexica está construido sobre el modelo Phi-3 de Meta AI, que está diseñado para robustez. Ha sido probado para proporcionar respuestas precisas incluso cuando se enfrenta con consultas ambiguas o poco claras. Su capacidad para reescribir preguntas y adaptarse a diferentes contextos lo hace un motor de búsqueda robusto.

Comunidad

Farfalle: 7/10 - Farfalle tiene una comunidad dedicada de usuarios que valoran sus capacidades. Aunque no tenga el mismo nivel de adopción que Perplexica, la base de usuarios de Farfalle sigue siendo significativa.

Perplexica: 8.5/10 - Perplexica ha ganado reconocimiento amplio por su enfoque innovador en los motores de búsqueda. Su comunidad está creciendo rápidamente, con muchos usuarios que valoran su capacidad para proporcionar resultados precisos y relevantes.

Soporte

Farfalle: 6.5/10 - Farfalle proporciona soporte básico a través de preguntas frecuentes, documentación y foros. Aunque no sea tan completo como el soporte de Perplexica, la base de usuarios de Farfalle generalmente es autónoma.

Perplexica: 9/10 - Perplexica ofrece recursos de soporte extensos, incluyendo documentación detallada, preguntas frecuentes y foros comunitarios. Sus desarrolladores están activamente involucrados con la comunidad, asegurando que los usuarios reciban asistencia oportuna y efectiva.

Modelos LLM Soportados

Farfalle: No - Farfalle es un motor de búsqueda de IA autónomo que no depende de modelos de lenguaje grandes (LLMs) para sus capacidades.

Perplexica: Sí - Perplexica está construido sobre el modelo Phi-3 de Meta AI, que es un LLM. Esto permite que Perplexica aproveche el poder del aprendizaje profundo para resultados más precisos y relevantes.

Puntuación general Farfalle: 22/30 Perplexica: 34.5/40

Basado en estos criterios, Perplexica parece tener una ligera ventaja sobre Farfalle en términos de robustez, soporte comunitario y integración con LLM. Sin embargo, ambos motores de búsqueda tienen sus fortalezas, y la elección finalmente depende de tus necesidades y preferencias específicas.

Recomendación Si estás buscando un motor de búsqueda de IA confiable con fuertes capacidades de NLP, Perplexica podría ser una mejor opción. Si prefieres un enfoque más directo y sin frills para la búsqueda, Farfalle aún podría proporcionar resultados excelentes.

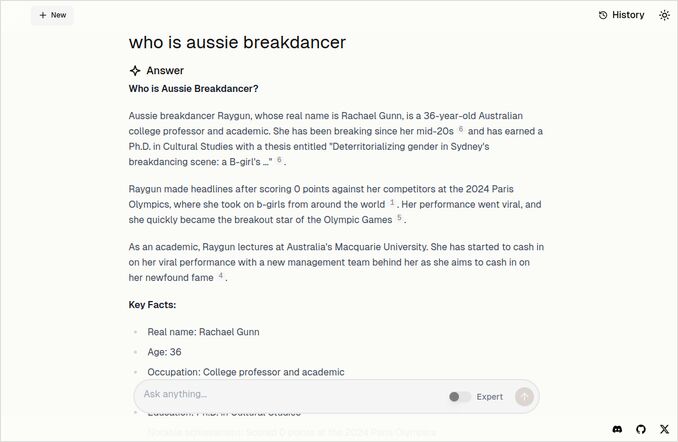

Respuesta de comparación de Farfalle

Comparación de Farfalle y Perplexica

Farfalle y Perplexica son dos motores de búsqueda impulsados por IA que han llamado la atención en los últimos tiempos. Aquí hay una comparación de estos dos proyectos basada en robustez, comunidad, soporte y soporte para LLM (Modelo de Lenguaje Grande).

Robustez

- Farfalle está diseñado para ser autoalojado con LLMs locales o en la nube, lo que lo hace una opción más robusta para usuarios que desean control sobre su motor de búsqueda.

- Perplexica, por otro lado, es una alternativa de código abierto a Perplexity AI y está siendo constantemente mejorado por sus desarrolladores.

Comunidad

- Perplexica tiene una comunidad dedicada de desarrolladores y usuarios que contribuyen a su desarrollo y proporcionan soporte

- La comunidad de Farfalle es más pequeña, pero aún tiene presencia en GitHub

Soporte

- Perplexica ofrece actualizaciones y mejoras regulares, así como un canal de Discord para discutir temas fuera del soporte regular

- El soporte de Farfalle está limitado a problemas en GitHub y solicitudes de extracción

Soporte para LLM Tanto Farfalle como Perplexica soportan LLM. Perplexica usa Ollama, un LLM local, mientras que Farfalle soporta tanto LLM locales como en la nube.

En resumen, Farfalle es más robusto debido a su diseño autoalojado, mientras que Perplexica tiene una comunidad más fuerte y mejor soporte. Ambos proyectos soportan LLM, pero Perplexica usa Ollama específicamente.

Conclusión

¿Cuál es la diferencia entre Perplexica y Farfalle?

La respuesta:

- Poniendo a un lado algunos errores factuales, ambos sistemas piensan que Perplexica es mejor que Farfalle, lo cual me gustaría aceptar.

- Realmente me gusta la interfaz de usuario de Farfalle, aunque están bastante cerca

- Me gusta la idea del modo experto de Farfalle, aunque no funcionó en mi entorno

- Me encontré con 3 errores al ejecutar Farfalle. El código de Perplexica está más pulido

- Una vez configurado, Perplexica funcionó sin errores

- Perplexica permite usar cualquier modelo alojado en Ollama. Y Farfalle permite usar solo Gemma, Llama3, Mistral y Phi3 (versiones predefinidas, que son un poco anticuadas).

- Me gustan más las respuestas de Farfalle. Mira la imagen de Farfalle a continuación. Al punto derecho sin esas “Según el contexto proporcionado”…

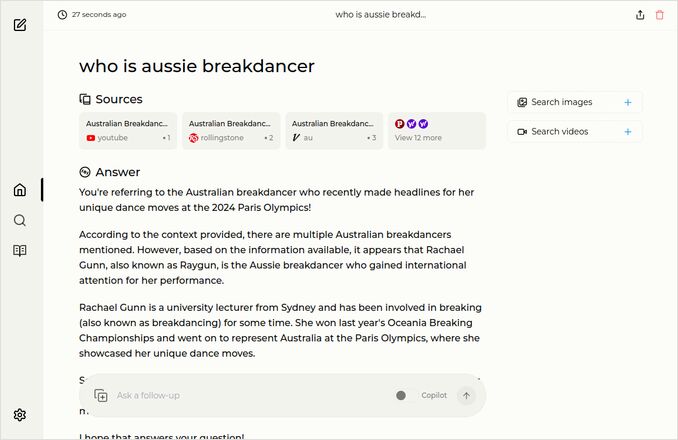

Más ejemplos

Estos muestran respuestas para la misma pregunta sobre el breakdancer australiano. Sabes, el que tiene un doctorado y obtuvo 0 (cero) puntos y probablemente tuvo el breakdancing eliminado del programa olímpico.

Respuesta de Farfalle

Respuesta de Perplexica

Si lees hacia arriba (o hacia abajo), gracias por tener los mismos intereses que yo. Es realmente emocionante.

¡Tenga un excelente día!

Enlaces útiles

- Búsqueda vs Deepsearch vs Deep Research

- Prueba: Cómo Ollama está usando el rendimiento de los núcleos de CPU de Intel y núcleos eficientes

- Cómo Ollama maneja solicitudes paralelas

- Autoalojamiento de Perplexica - con Ollama

- Comparación de capacidades de resumen de LLM

- Escribir prompts efectivos para LLMs

- Prueba de detección de falacias lógicas por nuevos LLMs: gemma2, qwen2 y mistral Nemo

- Cheatsheet de Ollama

- Cheatsheet de Markdown

- Proveedores de LLM en la nube

- Modelos de incrustación y reordenamiento de Qwen3 en Ollama: rendimiento de vanguardia