Embeddings Multimodais: Conectando Modalidades de IA

Unifique texto, imagens e áudio em espaços de embedding compartilhados

Embeddings cruzais representam uma revolução na inteligência artificial, permitindo compreensão e raciocínio entre diferentes tipos de dados dentro de um espaço de representação unificado.

Esta tecnologia alimenta aplicações multimodais modernas, desde a busca por imagens até a geração de conteúdo.

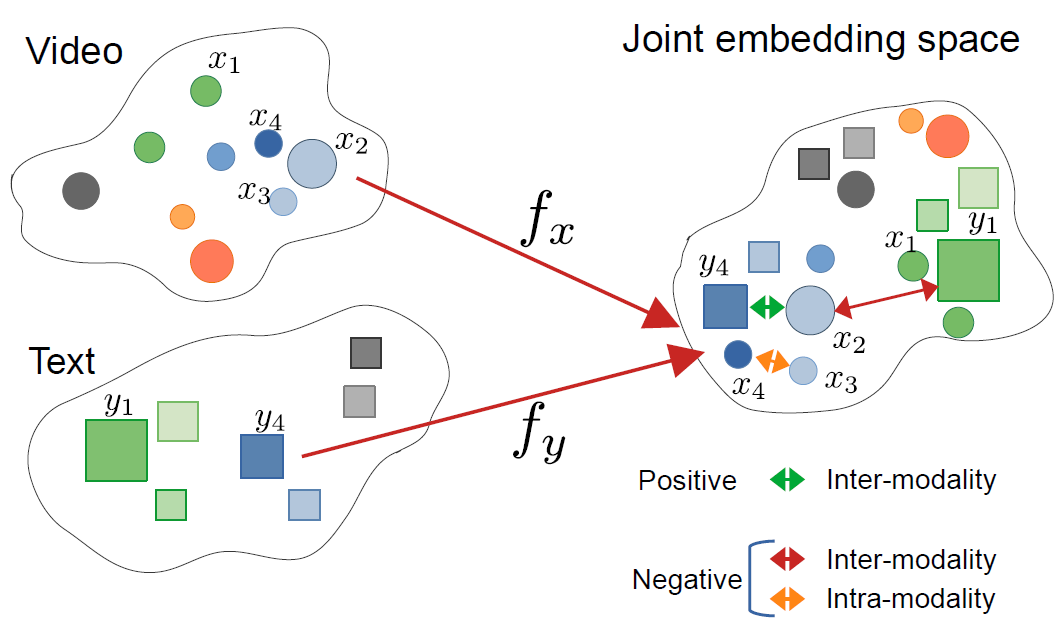

Esta imagem é do artigo:

CrossCLR: aprendizado contrastivo cruzal para representações de vídeo multimodal, por Mohammadreza Zolfaghari e outros

Esta imagem é do artigo:

CrossCLR: aprendizado contrastivo cruzal para representações de vídeo multimodal, por Mohammadreza Zolfaghari e outros

Entendendo Embeddings Cruzais

Embeddings cruzais são representações vetoriais que codificam informações de diferentes modalidades—como texto, imagens, áudio e vídeo—em um espaço de embedding compartilhado. Ao contrário dos embeddings tradicionais de única modalidade, as abordagens cruzais aprendem uma representação unificada onde conceitos semanticamente semelhantes se agrupam juntos, independentemente de seu formato original.

O Que São Embeddings Cruzais?

No seu núcleo, os embeddings cruzais resolvem um desafio crítico na IA: como comparar e relacionar informações entre diferentes tipos de dados. Um classificador de imagem tradicional só pode trabalhar com imagens, enquanto um modelo de texto lida apenas com texto. Os embeddings cruzais preenchem essa lacuna projetando diferentes modalidades em um espaço vetorial comum onde:

- Uma imagem de um gato e a palavra “gato” têm vetores de embedding semelhantes

- Relações semânticas são preservadas entre modalidades

- Métricas de distância (similaridade cosseno, distância euclidiana) medem similaridade cruzal

Esta representação unificada permite capacidades poderosas, como buscar imagens usando consultas de texto, gerar legendas a partir de imagens ou até mesmo classificação de zero-shot sem treinamento específico para a tarefa.

A Arquitetura por Trás do Aprendizado Cruzal

Sistemas modernos de embeddings cruzais geralmente empregam arquiteturas de codificadores duplos com objetivos de aprendizado contrastivo:

Codificadores Duplos: Redes neurais separadas codificam cada modalidade. Por exemplo, o CLIP usa:

- Um vision transformer (ViT) ou ResNet para imagens

- Um codificador de texto baseado em transformer para linguagem

Aprendizado Contrastivo: O modelo aprende maximizando a similaridade entre pares correspondentes (por exemplo, imagem e sua legenda) enquanto minimiza a similaridade entre pares não correspondentes. A função de perda contrastiva pode ser expressa como:

$$ \mathcal{L} = -\log \frac{\exp(\text{sim}(v_i, t_i) / \tau)}{\sum_{j=1}^{N} \exp(\text{sim}(v_i, t_j) / \tau)} $$

onde $v_i$ é o embedding da imagem, $t_i$ é o embedding do texto, $\text{sim}$ é a similaridade (geralmente cosseno) e $\tau$ é um parâmetro de temperatura.

Tecnologias e Modelos Principais

CLIP: Pioneirando o Entendimento de Visão e Linguagem

O CLIP (Contrastive Language-Image Pre-training) da OpenAI revolucionou a área ao ser treinado com 400 milhões de pares de imagem-texto da internet. A arquitetura do modelo consiste em:

import torch

from transformers import CLIPProcessor, CLIPModel

from PIL import Image

# Carregar modelo CLIP pré-treinado

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

# Preparar entradas

image = Image.open("example.jpg")

texts = ["uma foto de um gato", "uma foto de um cachorro", "uma foto de um pássaro"]

# Processar e obter embeddings

inputs = processor(text=texts, images=image, return_tensors="pt", padding=True)

# Obter pontuações de similaridade cruzal

outputs = model(**inputs)

logits_per_image = outputs.logits_per_image

probs = logits_per_image.softmax(dim=1)

print(f"Probabilidades: {probs}")

A inovação-chave do CLIP foi a escala e simplicidade. Ao treinar em dados de grande escala da web sem anotações manuais, ele atingiu capacidades notáveis de transferência de zero-shot. Como o CLIP difere de modelos de visão tradicionais? Ao contrário de classificadores supervisionados treinados em conjuntos de rótulos fixos, o CLIP aprende com supervisão natural da linguagem, tornando-o adaptável a qualquer conceito visual descritível em texto.

ImageBind: Extendendo para Seis Modalidades

O ImageBind da Meta estende embeddings cruzais além da visão e da linguagem, incluindo:

- Áudio (sons ambientais, fala)

- Informação de profundidade

- Imagem térmica

- Dados de IMU (sensor de movimento)

Isso cria um espaço de embedding multimodal verdadeiramente unificado onde todas as seis modalidades estão alinhadas. A ideia-chave é que as imagens servem como uma “modalidade de vinculação”—ao emparelhar imagens com outras modalidades e aproveitando o alinhamento existente entre visão e linguagem, o ImageBind cria um espaço unificado sem exigir todos os possíveis pares de modalidade durante o treinamento.

Alternativas Open-Source

O ecossistema se expandiu com várias implementações open-source:

OpenCLIP: Uma implementação comunitária oferecendo modelos maiores e receitas de treinamento diversas:

import open_clip

model, _, preprocess = open_clip.create_model_and_transforms(

'ViT-L-14',

pretrained='laion2b_s32b_b82k'

)

tokenizer = open_clip.get_tokenizer('ViT-L-14')

Modelos LAION-5B: Treinados no grande conjunto de dados open-source LAION-5B, oferecendo alternativas a modelos proprietários com desempenho comparável ou superior.

Para desenvolvedores interessados em soluções open-source de ponta para embeddings de texto, os modelos Qwen3 Embedding & Reranker no Ollama oferecem excelente desempenho multilíngue com fácil implantação local.

Estratégias de Implementação

Construindo um Sistema de Busca Cruzal

Uma implementação prática de embeddings cruzais para busca semântica envolve vários componentes. Quais são as principais aplicações de embeddings cruzais? Eles alimentam casos de uso desde a busca de produtos em comércio eletrônico até a moderação de conteúdo e ferramentas criativas.

import numpy as np

from typing import List, Tuple

import faiss

from transformers import CLIPModel, CLIPProcessor

class CrossModalSearchEngine:

def __init__(self, model_name: str = "openai/clip-vit-base-patch32"):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.image_index = None

self.image_metadata = []

def encode_images(self, images: List) -> np.ndarray:

"""Codificar imagens em embeddings"""

inputs = self.processor(images=images, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_image_features(**inputs)

return embeddings.cpu().numpy()

def encode_text(self, texts: List[str]) -> np.ndarray:

"""Codificar consultas de texto em embeddings"""

inputs = self.processor(text=texts, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_text_features(**inputs)

return embeddings.cpu().numpy()

def build_index(self, image_embeddings: np.ndarray):

"""Construir índice FAISS para busca de similaridade eficiente"""

dimension = image_embeddings.shape[1]

# Normalizar embeddings para similaridade cosseno

faiss.normalize_L2(image_embeddings)

# Criar índice (usando HNSW para implantação em grande escala)

self.image_index = faiss.IndexHNSWFlat(dimension, 32)

self.image_index.hnsw.efConstruction = 40

self.image_index.add(image_embeddings)

def search(self, query: str, k: int = 10) -> List[Tuple[int, float]]:

"""Buscar imagens usando consulta de texto"""

query_embedding = self.encode_text([query])

faiss.normalize_L2(query_embedding)

distances, indices = self.image_index.search(query_embedding, k)

return list(zip(indices[0], distances[0]))

# Exemplo de uso

engine = CrossModalSearchEngine()

# Construir índice a partir da coleção de imagens

image_embeddings = engine.encode_images(image_collection)

engine.build_index(image_embeddings)

# Buscar com texto

results = engine.search("pôr do sol sobre montanhas", k=5)

Afinamento para Tarefas Específicas de Domínio

Embora modelos pré-treinados funcionem bem para propósitos gerais, aplicações específicas de domínio beneficiam-se do afinamento:

from transformers import CLIPModel, CLIPProcessor, AdamW

import torch.nn as nn

class FineTuneCLIP:

def __init__(self, model_name: str, num_epochs: int = 10):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.num_epochs = num_epochs

def contrastive_loss(self, image_embeddings, text_embeddings, temperature=0.07):

"""Calcular a perda contrastiva InfoNCE"""

# Normalizar embeddings

image_embeddings = nn.functional.normalize(image_embeddings, dim=1)

text_embeddings = nn.functional.normalize(text_embeddings, dim=1)

# Calcular matriz de similaridade

logits = torch.matmul(image_embeddings, text_embeddings.T) / temperature

# Rótulos são diagonais (pares correspondentes)

labels = torch.arange(len(logits), device=logits.device)

# Perda simétrica

loss_i = nn.functional.cross_entropy(logits, labels)

loss_t = nn.functional.cross_entropy(logits.T, labels)

return (loss_i + loss_t) / 2

def train(self, dataloader, learning_rate=5e-6):

"""Afinar em dados específicos do domínio"""

optimizer = AdamW(self.model.parameters(), lr=learning_rate)

self.model.train()

for epoch in range(self.num_epochs):

total_loss = 0

for batch in dataloader:

images, texts = batch['images'], batch['texts']

# Processar entradas

inputs = self.processor(

text=texts,

images=images,

return_tensors="pt",

padding=True

)

# Passo para frente

outputs = self.model(**inputs, return_loss=True)

loss = outputs.loss

# Passo para trás

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_loss += loss.item()

avg_loss = total_loss / len(dataloader)

print(f"Época {epoch+1}/{self.num_epochs}, Perda: {avg_loss:.4f}")

Considerações para Implantação em Produção

Otimizando o Desempenho da Inferência

Como posso otimizar embeddings cruzais para produção? A otimização de desempenho é crítica para a implantação em mundo real:

Quantização do Modelo: Reduzir o tamanho do modelo e aumentar a velocidade de inferência:

import torch

from torch.quantization import quantize_dynamic

# Quantização dinâmica para inferência em CPU

quantized_model = quantize_dynamic(

model,

{torch.nn.Linear},

dtype=torch.qint8

)

Conversão para ONNX: Exportar para ONNX para inferência otimizada:

import torch.onnx

dummy_input = processor(text=["exemplo"], return_tensors="pt")

torch.onnx.export(

model,

tuple(dummy_input.values()),

"clip_model.onnx",

input_names=['input_ids', 'attention_mask'],

output_names=['output'],

dynamic_axes={

'input_ids': {0: 'batch_size'},

'attention_mask': {0: 'batch_size'}

}

)

Processamento em Lotes: Maximizar a utilização da GPU através do processamento em lotes:

def batch_encode(items: List, batch_size: int = 32):

"""Processar itens em lotes para eficiência"""

embeddings = []

for i in range(0, len(items), batch_size):

batch = items[i:i+batch_size]

batch_embeddings = encode_batch(batch)

embeddings.append(batch_embeddings)

return np.concatenate(embeddings, axis=0)

Armazenamento Escalável de Vetores

Para aplicações em grande escala, bancos de dados de vetores são essenciais. Quais frameworks suportam implementações de embeddings cruzais? Além dos próprios modelos, a infraestrutura importa:

FAISS (Facebook AI Similarity Search): Biblioteca eficiente de busca de similaridade

- Suporta bilhões de vetores

- Vários tipos de índice (plano, IVF, HNSW)

- Aceleração de GPU disponível

Milvus: Banco de dados vetorial open-source

from pymilvus import connections, Collection, FieldSchema, CollectionSchema, DataType

# Definir schema

fields = [

FieldSchema(name="id", dtype=DataType.INT64, is_primary=True, auto_id=True),

FieldSchema(name="embedding", dtype=DataType.FLOAT_VECTOR, dim=512),

FieldSchema(name="metadata", dtype=DataType.JSON)

]

schema = CollectionSchema(fields, description="Embeddings de imagens")

# Criar coleção

collection = Collection("imagens", schema)

# Criar índice

index_params = {

"metric_type": "IP", # Produto interno (similaridade cosseno)

"index_type": "IVF_FLAT",

"params": {"nlist": 1024}

}

collection.create_index("embedding", index_params)

Pinecone/Weaviate: Serviços de banco de dados vetorial gerenciado que oferecem escala e manutenção fáceis.

Casos de Uso Avançados e Aplicações

Classificação de Zero-Shot

Embeddings cruzais permitem classificação sem treinamento específico para a tarefa. Essa capacidade vai além das abordagens tradicionais de visão computacional—por exemplo, se você estiver interessado em detecção de objetos mais especializada com TensorFlow, isso representa uma abordagem complementar de aprendizado supervisionado para tarefas específicas de detecção.

def zero_shot_classify(image, candidate_labels: List[str], model, processor):

"""Classificar imagem em categorias arbitrárias"""

# Criar prompts de texto

text_inputs = [f"uma foto de um {label}" for label in candidate_labels]

# Obter embeddings

inputs = processor(

text=text_inputs,

images=image,

return_tensors="pt",

padding=True

)

outputs = model(**inputs)

# Calcular probabilidades

logits = outputs.logits_per_image

probs = logits.softmax(dim=1)

# Retornar previsões classificadas

sorted_indices = probs.argsort(descending=True)[0]

return [(candidate_labels[idx], probs[0][idx].item()) for idx in sorted_indices]

# Exemplo de uso

labels = ["gato", "cachorro", "pássaro", "peixe", "cavalo"]

predictions = zero_shot_classify(image, labels, model, processor)

print(f"Melhor previsão: {predictions[0]}")

RAG Multimodal (Retrieval-Augmented Generation)

Combinar embeddings cruzais com modelos de linguagem cria sistemas poderosos de RAG multimodal. Após recuperar documentos relevantes, reclassificação com modelos de embedding pode melhorar significativamente a qualidade dos resultados reordenando candidatos recuperados com base na relevância:

class MultimodalRAG:

def __init__(self, clip_model, llm_model):

self.clip = clip_model

self.llm = llm_model

self.knowledge_base = []

def add_documents(self, images, texts, metadata):

"""Adicionar documentos multimodais à base de conhecimento"""

image_embeds = self.clip.encode_images(images)

text_embeds = self.clip.encode_text(texts)

# Armazenar informações combinadas

for i, (img_emb, txt_emb, meta) in enumerate(

zip(image_embeds, text_embeds, metadata)

):

self.knowledge_base.append({

'image_embedding': img_emb,

'text_embedding': txt_emb,

'metadata': meta,

'index': i

})

def retrieve(self, query: str, k: int = 5):

"""Recuperar conteúdo multimodal relevante"""

query_embedding = self.clip.encode_text([query])[0]

# Calcular similaridades

similarities = []

for doc in self.knowledge_base:

# Média de similaridade entre modalidades

img_sim = np.dot(query_embedding, doc['image_embedding'])

txt_sim = np.dot(query_embedding, doc['text_embedding'])

combined_sim = (img_sim + txt_sim) / 2

similarities.append((combined_sim, doc))

# Retornar top-k

similarities.sort(reverse=True)

return [doc for _, doc in similarities[:k]]

def answer_query(self, query: str):

"""Responder a consulta usando contexto multimodal recuperado"""

retrieved_docs = self.retrieve(query)

# Construir contexto a partir de documentos recuperados

context = "\n".join([doc['metadata']['text'] for doc in retrieved_docs])

# Gerar resposta com LLM

prompt = f"Contexto:\n{context}\n\nPergunta: {query}\n\nResposta:"

answer = self.llm.generate(prompt)

return answer, retrieved_docs

Se você estiver implementando sistemas RAG em produção em Go, você pode encontrar este guia sobre reclassificação de documentos de texto com Ollama e modelo Qwen3 Embedding em Go particularmente útil para otimizar a qualidade da recuperação.

Moderação de Conteúdo e Segurança

Embeddings cruzais excelentes em detectar conteúdo inapropriado entre modalidades:

class ContentModerator:

def __init__(self, model, processor):

self.model = model

self.processor = processor

# Definir categorias de segurança

self.unsafe_categories = [

"conteúdo violento",

"conteúdo adulto",

"imagens odiosas",

"violência gráfica",

"material explícito"

]

self.safe_categories = [

"seguro para o trabalho",

"família amigável",

"conteúdo educacional"

]

def moderate_image(self, image, threshold: float = 0.3):

"""Verificar se a imagem contém conteúdo inapropriado"""

# Combinar todas as categorias

all_categories = self.unsafe_categories + self.safe_categories

text_inputs = [f"imagem contendo {cat}" for cat in all_categories]

# Obter previsões

inputs = self.processor(

text=text_inputs,

images=image,

return_tensors="pt"

)

outputs = self.model(**inputs)

probs = outputs.logits_per_image.softmax(dim=1)[0]

# Verificar categorias inseguras

unsafe_scores = probs[:len(self.unsafe_categories)]

max_unsafe_score = unsafe_scores.max().item()

return {

'is_safe': max_unsafe_score < threshold,

'confidence': 1 - max_unsafe_score,

'flagged_categories': [

self.unsafe_categories[i]

for i, score in enumerate(unsafe_scores)

if score > threshold

]

}

Boas Práticas e Erros Comuns

Pré-processamento de Dados

O pré-processamento adequado é crucial para o desempenho ótimo:

from torchvision import transforms

# Pré-processamento padrão do CLIP

clip_transform = transforms.Compose([

transforms.Resize(224, interpolation=transforms.InterpolationMode.BICUBIC),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(

mean=[0.48145466, 0.4578275, 0.40821073],

std=[0.26862954, 0.26130258, 0.27577711]

)

])

Lidando com Viés e Equidade

Modelos cruzais podem herdar vieses dos dados de treinamento:

Estratégias de mitigação:

- Avaliar em grupos demográficos diversos

- Usar técnicas de desvies durante o afinamento

- Implementar recuperação com consciência de equidade

- Auditoria e monitoramento regulares em produção

Avaliação da Qualidade de Embedding

Monitore a qualidade dos embeddings em produção:

def assess_embedding_quality(embeddings: np.ndarray):

"""Calcular métricas para qualidade de embedding"""

# Calcular distância média entre pares

distances = np.linalg.norm(

embeddings[:, None] - embeddings[None, :],

axis=2

)

avg_distance = distances.mean()

# Verificar agrupamento (baixa distância intra-clusters)

from sklearn.cluster import KMeans

kmeans = KMeans(n_clusters=10)

labels = kmeans.fit_predict(embeddings)

# Calcular score de silhueta

from sklearn.metrics import silhouette_score

score = silhouette_score(embeddings, labels)

return {

'avg_pairwise_distance': avg_distance,

'silhouette_score': score

}

Exemplo de Implantação com Docker

Empacote sua aplicação multimodal para implantação fácil:

FROM nvidia/cuda:11.8.0-cudnn8-runtime-ubuntu22.04

# Instalar Python e dependências

RUN apt-get update && apt-get install -y python3-pip

WORKDIR /app

# Instalar requisitos

COPY requirements.txt .

RUN pip3 install --no-cache-dir -r requirements.txt

# Copiar código da aplicação

COPY . .

# Expor porta do API

EXPOSE 8000

# Executar servidor do API

CMD ["uvicorn", "api:app", "--host", "0.0.0.0", "--port", "8000"]

# api.py - Servidor FastAPI para embeddings cruzais

from fastapi import FastAPI, File, UploadFile

from pydantic import BaseModel

import torch

from PIL import Image

import io

app = FastAPI()

# Carregar modelo no início

@app.on_event("startup")

async def load_model():

global model, processor

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

if torch.cuda.is_available():

model = model.cuda()

class TextQuery(BaseModel):

text: str

@app.post("/embed/text")

async def embed_text(query: TextQuery):

inputs = processor(text=[query.text], return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_text_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/embed/image")

async def embed_image(file: UploadFile = File(...)):

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(images=image, return_tensors="pt")

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_image_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/similarity")

async def compute_similarity(

text: TextQuery,

file: UploadFile = File(...)

):

# Obter ambos os embeddings

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(text=[text.text], images=image, return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

outputs = model(**inputs)

similarity = outputs.logits_per_image[0][0].item()

return {"similaridade": similarity}

Direções Futuras

O campo de embeddings cruzais continua a evoluir rapidamente:

Cobertura de Modalidade Mais Amplas: Modelos futuros provavelmente incorporarão modalidades adicionais, como toque (feedback tátil), cheiro e sabor para compreensão multimodal abrangente.

Melhor Eficiência: Pesquisas sobre distilação e arquiteturas eficientes tornarão modelos poderosos de embeddings cruzais acessíveis em dispositivos de borda.

Melhor Alinhamento: Técnicas avançadas para alinhar modalidades com mais precisão, incluindo perdas de consistência cíclica e treinamento adversarial.

Compreensão Composicional: Passar da simples reconhecimento de objetos para compreender relações e composições complexas entre modalidades.

Modelagem Temporal: Melhor tratamento de vídeo e dados de séries temporais com raciocínio temporal explícito em espaços de embedding.

Links Úteis

- Repositório OpenAI CLIP

- OpenCLIP: Implementação Open Source

- Documentação Transformers Hugging Face

- ImageBind da Meta

- Conjunto de Dados LAION-5B

- Documentação FAISS

- Banco de Dados Vetorial Milvus

- Banco de Dados Vetorial Pinecone

- Artigo: Aprendizado de Modelos Transferíveis a partir da Supervisão Natural da Linguagem

- Artigo: ImageBind: Um Espaço de Embedding para Unir Todos

- Detecção de objetos com TensorFlow

- Reclassificação com modelos de embedding

- Reclassificação de documentos de texto com Ollama e modelo Qwen3 Embedding - em Go

- Modelos Qwen3 Embedding & Reranker no Ollama: Desempenho de Ponta

Embeddings cruzais representam uma mudança paradigmática em como os sistemas de IA processam e compreendem informações. Ao quebrar as barreiras entre diferentes tipos de dados, essas técnicas permitem aplicações de IA mais naturais e capazes. Seja você construindo sistemas de busca, ferramentas de moderação de conteúdo ou aplicações criativas, dominar embeddings cruzais abre um mundo de possibilidades para inovação em IA multimodal.