Interfaces de Chat para Instâncias Locais do Ollama

Visão geral rápida das interfaces de usuário mais proeminentes para Ollama em 2025

O Ollama hospedado localmente permite que você execute modelos de linguagem grandes em sua própria máquina, mas usar o Ollama via linha de comando não é amigável para o usuário.

Aqui estão vários projetos de código aberto que oferecem interfaces do tipo ChatGPT que se conectam a um Ollama local.

Essas interfaces de usuário (UIs) suportam chat conversacional, frequentemente com recursos como carregamento de documentos para geração aumentada com recuperação (RAG), e funcionam como aplicações web ou de desktop. Abaixo está uma comparação das opções principais, seguida por seções detalhadas sobre cada uma.

Para uma visão mais ampla de como o Ollama local se encaixa com vLLM, Docker Model Runner, LocalAI e provedores de nuvem — incluindo trade-offs de custo e infraestrutura — veja LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

Comparação de UIs compatíveis com Ollama

| Ferramenta de UI | Plataforma | Suporte a Documentos | Integração com Ollama | Pontos Fortes | Limitações |

|---|---|---|---|---|---|

| Page Assist | Extensão do navegador (Chrome, Firefox) | Sim – adicione arquivos para análise | Conecta-se ao Ollama local via configuração da extensão | Chat no navegador; gerenciamento fácil de modelos e integração com o contexto da página da web. | Apenas no navegador; requer instalação/configuração de uma extensão. |

| Open WebUI | Aplicativo web (auto-hospedado; Docker/PWA) | Sim – RAG embutido (carregue documentos ou adicione à biblioteca) | Suporte direto à API do Ollama ou servidor embutido (configure a URL base) | Recursos ricos (multi-LLM, offline, geração de imagem); amigável para dispositivos móveis (PWA). | Instalação mais pesada (Docker/K8s); escopo amplo pode ser excessivo para uso simples. |

| LobeChat | Aplicativo web (auto-hospedado; suporte a PWA) | Sim – “Base de Conhecimento” com upload de arquivos (PDF, imagens, etc.) | Suporta Ollama como um dos múltiplos backends de IA (requer habilitar o acesso à API do Ollama) | Interface de chat elegante do tipo ChatGPT; chat de voz, plugins e suporte a múltiplos modelos. | Conjunto de recursos complexo; requer configuração do ambiente (ex: cross-origin para Ollama). |

| LibreChat | Aplicativo web (auto-hospedado; multi-usuário) | Sim – “Chat com Arquivos” usando RAG (via embeddings) | Compatível com Ollama e muitos outros provedores (alternável por chat) | Interface familiar do tipo ChatGPT; recursos ricos (agentes, interpretador de código, etc.). | Instalação/configuração pode ser envolvida; projeto grande pode ser mais do que necessário para uso básico. |

| AnythingLLM | Aplicativo de desktop (Windows, Mac, Linux) ou web (Docker) | Sim – RAG embutido: arraste e solte documentos (PDF, DOCX, etc.) com citações | Ollama suportado como provedor de LLM (definido na configuração ou no ambiente do Docker) | UI completa (ChatGPT privado com seus documentos); construtor de agentes sem código, suporte a múltiplos usuários. | Uso de recursos mais alto (banco de dados de embeddings, etc.); aplicativo de desktop falta alguns recursos de múltiplos usuários. |

| Chat-with-Notes | Aplicativo web (servidor leve Flask) | Sim – carregue arquivos de texto/PDF e converse com seu conteúdo | Usa Ollama para todas as respostas de IA (requer Ollama rodando localmente) | Configuração e interface muito simples focadas em perguntas e respostas com documentos; os dados permanecem locais. | UI básica e funcionalidade; único usuário, um documento por vez (sem recursos avançados). |

Cada uma dessas ferramentas é ativamente mantida e de código aberto. Em seguida, mergulhamos nos detalhes de cada opção, incluindo como elas funcionam com o Ollama, recursos notáveis e trade-offs.

Page Assist (Extensão do navegador)

Page Assist é uma extensão de navegador de código aberto que traz chat com LLM local para o seu navegador. Ela suporta navegadores baseados em Chromium e Firefox, oferecendo um painel lateral ou aba do tipo ChatGPT onde você pode conversar com um modelo. Page Assist pode se conectar a Ollama rodando localmente como provedor de IA, ou outros backends locais, por meio de suas configurações. Notavelmente, ela permite que você adicione arquivos (ex: PDFs ou texto) para que a IA analise dentro do chat, permitindo fluxos de trabalho básicos de RAG. Você até pode ter ela ajudando com o conteúdo da página atual ou realizando buscas na web por informações.

A instalação é simples: instale a extensão no Chrome Web Store ou nos Add-ons do Firefox, garanta que o Ollama esteja rodando e selecione Ollama como provedor de IA local nas configurações do Page Assist. A interface inclui recursos como histórico de chat, seleção de modelos e uma URL compartilhável opcional para seus resultados de chat. Uma interface web também está disponível via atalho de teclado se você preferir uma experiência de chat em aba completa.

Pontos Fortes: Page Assist é leve e conveniente – como vive no navegador, não há servidor separado para rodar. É excelente para contextos de navegação (você pode abri-lo em qualquer página da web) e suporta integração com busca na internet e anexos de arquivos para enriquecer a conversa. Também oferece recursos úteis como atalhos de teclado para novo chat e alternância do painel lateral.

Limitações: Sendo uma extensão, ela está restrita ao ambiente do navegador. A interface é mais simples e um pouco menos rica em recursos do que aplicativos de chat autônomos completos. Por exemplo, gerenciamento de múltiplos usuários ou plugins de agentes avançados não estão no escopo. Além disso, a instalação inicial pode exigir a construção/carregamento da extensão se uma versão pré-embalada não estiver disponível para seu navegador (o projeto fornece instruções de construção usando Bun ou npm). Em resumo, Page Assist é ideal para uso individual quando você deseja acesso rápido a chat com Ollama enquanto navega na web, com capacidades moderadas de RAG.

Open WebUI (Aplicativo Web Auto-Hospedado)

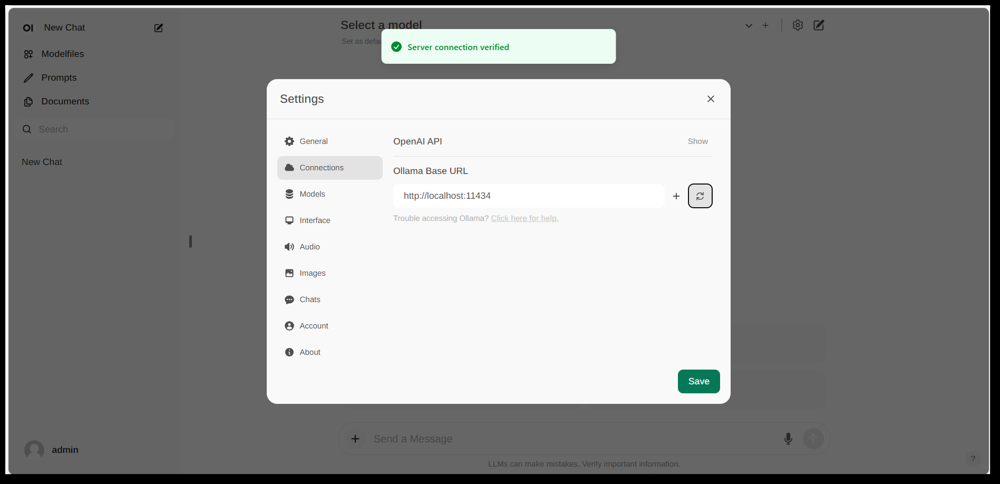

Interface de configurações do Open WebUI, mostrando uma conexão com Ollama configurada (URL base definida para a API local do Ollama). A interface inclui uma seção de Documentos, permitindo fluxos de trabalho RAG.

Open WebUI é uma poderosa interface de chat de propósito geral originalmente criada para funcionar com Ollama, e agora expandida para suportar diversos backends de LLM. Ele roda como uma aplicação web auto-hospedada e normalmente é implantado via Docker ou Kubernetes para facilitar a instalação. Uma vez em execução, você acessa-o através do seu navegador (com suporte para instalação como uma Aplicação Web Progressiva em dispositivos móveis).

Open WebUI oferece uma interface de chat completa com suporte a múltiplos usuários, gerenciamento de modelos e recursos extensos. Criticamente, ele possui capacidades RAG embutidas – você pode carregar ou importar documentos para uma biblioteca de documentos e então fazer perguntas com recuperação de informações. A interface permite carregar documentos diretamente em uma sessão de chat ou manter uma biblioteca persistente de conhecimento. Ele até suporta realizar buscas na web e injetar resultados na conversa para informações atualizadas.

Integração com Ollama: Open WebUI se conecta ao Ollama através de sua API. Você pode rodar o contêiner Docker do Open WebUI junto com um servidor Ollama e definir uma variável de ambiente para apontar para a URL do Ollama, ou usar uma imagem especial do Docker que empacota Ollama com a interface web. Na prática, após iniciar os contêineres, você visitará o Open WebUI no seu navegador e verá a mensagem “Conexão com o servidor verificada” se configurado corretamente (como mostrado na imagem acima). Isso significa que a interface está pronta para usar seus modelos locais de Ollama para chat. Open WebUI também suporta endpoints compatíveis com a API OpenAI, então ele pode se interfacear com LM Studio, OpenRouter, etc., além de Ollama.

Pontos Fortes: Esta solução é uma das mais ricas em recursos e flexíveis. Suporta vários modelos simultâneos e threads de conversa, personagens personalizados ou prompts de sistema, geração de imagem e muito mais. A implementação de RAG é robusta – você obtém uma interface completa para gerenciar documentos e até configurar qual armazenamento de vetores ou serviço de busca usar para recuperação. Open WebUI também é ativamente desenvolvido (com uma comunidade extensa, como indicado por sua alta contagem de estrelas no GitHub) e projetado para extensibilidade e escalabilidade. É uma boa escolha se você quiser uma interface de chat completa para modelos locais, especialmente em cenários com múltiplos usuários ou casos de uso complexos.

Limitações: Com grande poder vem maior complexidade. Open WebUI pode ser excesso para uso pessoal simples – implantar contêineres Docker e gerenciar a configuração pode ser intimidador se você não estiver familiarizado. Ele consome mais recursos do que uma aplicação leve, pois roda um servidor web, banco de dados opcional para histórico de conversas, etc. Além disso, recursos como controle de acesso baseado em papel e gerenciamento de usuários, embora úteis, indicam que ele está orientado para uma configuração de servidor – um único usuário em um PC doméstico pode não precisar de tudo isso. Em resumo, a instalação é mais pesada e a interface pode parecer complexa se você precisar apenas de um clone básico de ChatGPT. Mas para aqueles que precisam da amplitude de recursos (ou querem facilmente alternar entre Ollama e outros provedores de modelos em uma única interface), o Open WebUI é uma das principais opções.

LobeChat (Framework do tipo ChatGPT com Plugins)

Banner da interface do LobeChat mostrando “Ollama Supported” e múltiplos modelos locais. O LobeChat permite que você implante uma aplicação web elegante do tipo ChatGPT usando Ollama ou outros provedores, com recursos como entrada de voz e plugins.

LobeChat é um framework de chat de código aberto que enfatiza uma experiência do usuário polida e flexibilidade. É essencialmente uma aplicação web do tipo ChatGPT que você pode auto-hospedar, com suporte para vários provedores de IA – desde OpenAI e Anthropic até modelos abertos via Ollama. O LobeChat é projetado com privacidade em mente (você o roda por si mesmo) e tem uma interface moderna que inclui conveniências como memória de conversa, modo de conversa por voz e até geração de imagem por meio de plugins.

Um dos recursos-chave do LobeChat é sua capacidade de Base de Conhecimento. Você pode carregar documentos (em formatos como PDFs, imagens, áudio, vídeo) e criar uma base de conhecimento que pode ser usada durante a conversa. Isso significa que você pode fazer perguntas sobre o conteúdo dos seus arquivos – um fluxo de trabalho RAG que o LobeChat suporta de forma nativa. A interface fornece gerenciamento desses arquivos/bases de conhecimento e permite alternar seu uso na conversa, oferecendo uma experiência de Q&A mais rica além do LLM base.

Para usar o LobeChat com Ollama, você implantará a aplicação do LobeChat (por exemplo, via uma imagem Docker fornecida ou script) e configurará o Ollama como o backend. O LobeChat reconhece o Ollama como um provedor de primeira classe – até oferece um script de implantação de um clique via o navegador Pinokio AI se você usar esse. Na prática, você pode precisar ajustar as configurações do Ollama (como habilitar CORS conforme as instruções do LobeChat) para que a interface web do LobeChat possa acessar a API HTTP do Ollama. Uma vez configurado, você pode escolher um modelo hospedado no Ollama na interface do LobeChat e conversar com ele, incluindo perguntas sobre seus documentos carregados.

Pontos Fortes: A interface do LobeChat é frequentemente elogiada por ser limpa e amigável para o usuário, imitando muito o visual e o feel do ChatGPT (o que pode facilitar a adoção). Ela adiciona valor com extras como entrada/saída de voz para conversas por voz e um sistema de plugins para estender a funcionalidade (semelhante aos plugins do ChatGPT, permitindo coisas como navegação na web ou geração de imagem). O suporte a múltiplos modelos significa que você pode facilmente alternar entre, digamos, um modelo local do Ollama e um modelo da API da OpenAI na mesma interface. Também suporta instalação como uma PWA amigável para dispositivos móveis, então você pode acessar seu chat local em qualquer lugar.

Limitações: Configurar o LobeChat pode ser mais complexo do que algumas alternativas. É uma aplicação full-stack (geralmente rodada com Docker Compose), então há alguma sobrecarga. Em particular, configurar a integração com Ollama requer habilitar requisições cross-origin no lado do Ollama e garantir que as portas estejam alinhadas – uma tarefa única, mas técnica. Além disso, embora o LobeChat seja bastante poderoso, nem todos os recursos podem ser necessários para cada usuário; por exemplo, se você não precisar de suporte a múltiplos provedores ou plugins, a interface pode parecer entulhada em comparação a uma ferramenta mínima. Por fim, certos recursos avançados, como a implantação de um clique, assumem ambientes específicos (navegador Pinokio ou Vercel), os quais você pode ou não usar. Em resumo, o LobeChat é ideal se você quiser um alternativo completo do ChatGPT que rode localmente com o Ollama, e não se importar com um pouco de configuração inicial para chegar lá.

LibreChat (Clone do ChatGPT com Suporte a Múltiplos Provedores)

LibreChat (anteriormente conhecido como ChatGPT-Clone ou UI) é um projeto de código aberto com o objetivo de replicar e estender a interface e funcionalidade do ChatGPT. Ele pode ser implantado localmente (ou em seu próprio servidor) e suporta uma variedade de backends de IA – incluindo modelos abertos via Ollama. Essencialmente, o LibreChat oferece a experiência familiar de chat (interface de diálogo com histórico, mensagens do usuário e assistente) enquanto permite que você conecte diferentes provedores de modelos no backend.

O LibreChat suporta interação com documentos e RAG por meio de um complemento chamado RAG API e serviços de embedding. Na interface, você pode usar recursos como “Chat com Arquivos”, que permite carregar documentos e então fazer perguntas sobre eles. Em segundo plano, isso usa embeddings e um armazenamento de vetores para recuperar contexto relevante dos seus arquivos. Isso significa que você pode obter um efeito semelhante ao ChatGPT + conhecimento personalizado, tudo localmente. O projeto até fornece um repositório separado para o serviço RAG se você quiser auto-hospedá-lo.

Usar o LibreChat com Ollama geralmente envolve rodar o servidor do LibreChat (por exemplo, via Node/Docker) e garantir que ele possa acessar o serviço do Ollama. O LibreChat tem uma configuração de “Endpoint Personalizado” onde você pode inserir uma URL de API compatível com a OpenAI. Como o Ollama pode expor uma API local compatível com a OpenAI, o LibreChat pode ser apontado para http://localhost:11434 (ou onde o Ollama estiver ouvindo). De fato, o LibreChat explicitamente lista Ollama entre seus provedores de IA suportados – ao lado de outros como OpenAI, Cohere, etc. Uma vez configurado, você pode selecionar o modelo (do Ollama) em um menu suspenso e conversar livremente. O LibreChat também permite alternar modelos ou provedores mesmo no meio da conversa e suporta múltiplos presets de chat/contexos.

Pontos Fortes: A principal vantagem do LibreChat é o conjunto rico de recursos construídos em torno da experiência de chat. Ele inclui coisas como ramificação de conversa, busca de mensagens, suporte embutido ao Interpretador de Código (execução segura de código em sandbox) e integrações de ferramentas/agentes. É essencialmente o ChatGPT++, com a capacidade de integrar modelos locais. Para alguém que gosta da interface do ChatGPT, o LibreChat será muito familiar e requer pouco curva de aprendizado. O projeto é ativo e comunitário (como evidenciado por suas atualizações frequentes e discussões) e bastante flexível: você pode se conectar a muitos tipos de endpoints de LLM ou até rodá-lo com múltiplos usuários com autenticação para um ambiente de equipe.

Limitações: Com tantos recursos, o LibreChat pode ser mais pesado para rodar. A instalação pode envolver configurar um banco de dados para armazenar conversas e variáveis de ambiente para várias APIs. Se você habilitar todos os componentes (RAG, agentes, geração de imagem, etc.), é uma pilha bastante complexa. Para um único usuário que só precisa de um chat básico com um modelo local, o LibreChat pode ser mais do que necessário. Além disso, a interface, embora familiar, não é altamente especializada para perguntas e respostas com documentos – ela faz o trabalho, mas falta uma interface dedicada a “biblioteca de documentos” (os uploads geralmente são feitos dentro de uma conversa ou via API). Em resumo, o LibreChat brilha quando você quer um ambiente completo do tipo ChatGPT com uma gama de recursos rodando localmente, mas soluções mais simples podem ser suficientes para casos de uso focados.

AnythingLLM (Aplicativo de Desktop ou Servidor Todo-em-Uno)

AnythingLLM é uma aplicação de IA todo-em-uno que enfatiza RAG e facilidade de uso. Permite que você “converse com seus documentos” usando modelos de LLM abertos ou até mesmo modelos da OpenAI, tudo através de uma única interface unificada. Notavelmente, o AnythingLLM está disponível tanto como um aplicativo de desktop multiplataforma (para Windows, Mac, Linux) e como um servidor auto-hospedado (via Docker). Essa flexibilidade significa que você pode executá-lo como um aplicativo normal no seu PC, ou implantá-lo para múltiplos usuários em um servidor.

O tratamento de documentos está no cerne do AnythingLLM. Você pode arrastar e soltar documentos (PDF, TXT, DOCX, etc.) para dentro do aplicativo, e ele indexará automaticamente os documentos em um banco de dados de vetores (ele vem com LanceDB por padrão). Na interface de chat, quando você fizer perguntas, ele recuperará trechos relevantes dos seus documentos e fornecerá respostas com citações, para que você saiba de qual arquivo e seção a informação veio. Essencialmente, ele constrói uma base de conhecimento privada para você e permite que o LLM a use como contexto. Você pode organizar documentos em “workspaces” (por exemplo, um workspace por projeto ou tópico), isolando os contextos conforme necessário.

Usar o Ollama com o AnythingLLM é direto. Na configuração, você escolhe Ollama como provedor de LLM. Se estiver rodando via Docker, você define variáveis de ambiente como LLM_PROVIDER=ollama e fornece a OLLAMA_BASE_PATH (a URL da sua instância do Ollama). O servidor AnythingLLM então enviará todas as consultas de modelo para a API do Ollama. O Ollama é oficialmente suportado, e os documentos mencionam que você pode usá-lo para rodar diversos modelos abertos (como Llama 2, Mistral, etc.) localmente. Na verdade, os desenvolvedores destacam que combinar o AnythingLLM com o Ollama desbloqueia poderosas capacidades de RAG offline: o Ollama lida com a inferência do modelo, e o AnythingLLM lida com embeddings e a lógica de interface/agentes.

Pontos Fortes: O AnythingLLM oferece uma solução abrangente para perguntas e respostas privadas e chat. Principais pontos fortes incluem: configuração fácil para RAG (a parte pesada de embedding e armazenamento de vetores é automatizada), suporte a múltiplos documentos com citação clara de fontes, e recursos adicionais como Agentes de IA (ele tem um construtor de agentes sem código onde você pode criar fluxos de trabalho personalizados e uso de ferramentas). Também é multiusuário por padrão (especialmente em modo de servidor), com contas de usuários e permissões se necessário. A interface foi projetada para ser simples (caixa de chat + painel lateral de documentos/workspaces) mas poderosa em segundo plano. Para uso pessoal, o aplicativo de desktop é um grande plus – você obtém um aplicativo nativo sem precisar abrir um navegador ou executar comandos, e ele armazena dados localmente por padrão.

Limitações: Como integra muitos componentes (API de LLM, modelos de embedding, banco de dados de vetores, etc.), o AnythingLLM pode ser intensivo em recursos. Ao incorporar documentos, pode levar tempo e memória para gerar embeddings (ele até suporta usar o próprio Ollama ou modelos locais para embeddings com modelos como nomic-embed). O aplicativo de desktop simplifica o uso, mas se você tiver muitos documentos ou arquivos muito grandes, espere um processamento pesado em segundo plano. Outra limitação é que usuários avançados podem encontrar que é menos configurável do que montar sua própria pilha – por exemplo, ele usa atualmente LanceDB ou Chroma; se quiser um outro armazenamento de vetores, terá que mergulhar na configuração ou no código. Além disso, embora o suporte a múltiplos provedores seja compatível, a interface é realmente orientada para um modelo por vez (você trocaria a configuração global do provedor se quisesse usar um modelo diferente). Em resumo, o AnythingLLM é uma excelente solução pronta para uso para chat com documentos locais, especialmente com o Ollama, mas é uma aplicação maior para rodar em comparação com interfaces mínimas.

Chat-with-Notes (Interface de Chat de Documentos Mínima)

Chat-with-Notes é uma aplicação minimalista especificamente construída para conversar com arquivos de texto locais usando modelos geridos pelo Ollama. É essencialmente um servidor web leve Flask que você roda em seu PC, fornecendo uma página web simples onde você pode carregar um documento e iniciar um chat sobre ele. O objetivo deste projeto é simplicidade: ele não tem muitos recursos de brilho e whistles, mas faz o trabalho principal de responder perguntas sobre documentos com um LLM local.

Usar o Chat-with-Notes envolve primeiro garantir que sua instância do Ollama esteja rodando um modelo (por exemplo, você pode iniciar o Ollama com ollama run llama2 ou outro modelo). Em seguida, você inicia o aplicativo Flask (python app.py) e abre o site local. A interface vai pedir para você carregar um arquivo (formatos suportados incluem texto simples, Markdown, arquivos de código, HTML, JSON e PDFs). Depois de carregado, o conteúdo do texto do arquivo é exibido, e você pode fazer perguntas ou conversar com a IA sobre esse conteúdo. A conversa acontece em um formato de bolha de chat típico. Se você carregar um novo arquivo no meio da conversa, o aplicativo perguntará se você quer iniciar uma nova conversa ou manter o contexto atual da conversa e apenas adicionar as informações do novo arquivo. Dessa forma, você pode conversar sobre múltiplos arquivos sequencialmente, se necessário. Há também botões para limpar a conversa ou exportar a conversa para um arquivo de texto.

Em segundo plano, o Chat-with-Notes consulta a API do Ollama para gerar respostas. O Ollama lida com a inferência do modelo, e o Chat-with-Notes apenas fornece o prompt (que inclui partes relevantes do texto carregado). Ele não usa um banco de dados de vetores; em vez disso, ele simplesmente envia o conteúdo inteiro do arquivo (ou partes dele) junto com sua pergunta para o modelo. Esta abordagem funciona melhor para documentos de tamanho razoável que cabem no contexto da janela do modelo.

Pontos Fortes: O aplicativo é extremamente fácil de implantar e usar. Não há configuração complexa – se você tiver Python e Ollama configurados, você pode tê-lo rodando em um ou dois minutos. A interface é limpa e minimalista, focando no conteúdo do texto e no Q&A. Porque é tão focado, ele garante que todos os dados permaneçam locais e apenas na memória (sem chamadas externas, exceto para Ollama no localhost). É uma ótima escolha se você quiser especificamente conversar com arquivos e não precisar de conversas gerais sem um documento.

Limitações: A minimalidade do Chat-with-Notes significa que ele falta muitos recursos encontrados em outras interfaces. Por exemplo, ele não suporta o uso de múltiplos modelos ou provedores (é exclusivo para Ollama por design), e não mantém uma biblioteca de longo prazo de documentos – você carrega arquivos conforme necessário por sessão, e não há índice de vetores persistente. Escalar para documentos muito grandes pode ser complicado sem ajustes manuais, pois pode tentar incluir muito texto no prompt. Além disso, a interface, embora funcional, não é tão polida (não tem modo escuro, formatação de texto rica nas respostas, etc.). Em essência, esta ferramenta é ideal para análises rápidas de arquivos com um modelo Ollama. Se suas necessidades crescerem (por exemplo, muitos documentos ou desejo de uma interface mais sofisticada), você pode ultrapassar o Chat-with-Notes. Mas como um ponto de partida ou uma solução pessoal “pergunte meu PDF” sobre Ollama, é muito eficaz.

Conclusão

Cada uma dessas interfaces de usuário de código aberto pode melhorar sua experiência com modelos locais de Ollama, fornecendo uma interface de chat amigável para o usuário e capacidades adicionais como perguntas e respostas com documentos. A melhor escolha depende de suas necessidades e conforto técnico:

- Para instalação rápida e uso no navegador: Page Assist é uma excelente escolha, integrando-se diretamente em sua navegação com mínimos embaraços.

- Para um ambiente de aplicativo web completo: Open WebUI ou LibreChat oferecem recursos extensos e flexibilidade multi-modelo, adequados para usuários avançados ou configurações multiusuário.

- Para uma alternativa elegante do ChatGPT com potencial de plugins: LobeChat oferece um bom equilíbrio entre usabilidade e recursos em um pacote auto-hospedado.

- Para interações focadas em documentos: AnythingLLM oferece uma solução todo-em-uno (especialmente se você gostar de ter um aplicativo de desktop), enquanto Chat-with-Notes oferece uma abordagem minimalista para perguntas e respostas com um único documento.

Como todas essas ferramentas estão sendo ativamente mantidas, você também pode esperar melhorias e suporte da comunidade. Ao escolher uma dessas interfaces de usuário, você será capaz de conversar com seus modelos locais de Ollama de forma conveniente – seja analisando documentos, codificando com assistência ou simplesmente tendo uma inteligência artificial conversacional disponível sem dependências da nuvem. Cada solução acima é de código aberto, então você pode adaptá-las ainda mais às suas necessidades ou até contribuir para seu desenvolvimento. Para ver como o Ollama local mais essas interfaces de usuário se encaixa com outras opções locais e de nuvem, consulte nosso guia LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

Aproveite conversar com seu LLM local!