Mova os modelos Ollama para um local diferente

Os arquivos do modelo LLM Ollama ocupam muito espaço.

Após instalar ollama é melhor reconfigurar ollama para armazená-los em um novo local imediatamente. Assim, após puxarmos um novo modelo, ele não será baixado para o local antigo.

Sobre Ollama

Ollama é uma interface baseada em texto para modelos de IA LLM e uma API que também pode hospedá-los. Para uma comparação mais ampla entre Ollama e vLLM, Docker Model Runner, LocalAI e provedores de nuvem — incluindo trade-offs de custo e infraestrutura — veja Hospedagem de LLM: Comparação entre Infraestrutura Local, Auto-hospedada e Nuvem.

Instale Ollama

Vá para https://ollama.com/download

Para instalar Ollama no Linux:

curl -fsSL https://ollama.com/install.sh | sh

Ollama no Windows está na página: https://ollama.com/download/windows Ollama para Mac também está disponível: https://ollama.com/download/macOllamaSetup.exe

Baixar, listar e remover modelos Ollama

Para baixar alguns modelos Ollama: Vá para a Biblioteca Ollama (https://ollama.com/library) e encontre o modelo que você precisa, lá você também pode encontrar tags e tamanhos dos modelos.

Em seguida, execute:

ollama pull gemma2:latest

# Ou obtenha uma versão um pouco mais inteligente que ainda se encaixa bem em 16 GB de VRAM:

ollama pull gemma2:27b-instruct-q3_K_S

# Ou:

ollama pull llama3.1:latest

ollama pull llama3.1:8b-instruct-q8_0

ollama pull mistral-nemo:12b-instruct-2407-q6_K

ollama pull mistral-small:22b-instruct-2409-q4_0

ollama pull phi3:14b-medium-128k-instruct-q6_K

ollama pull qwen2.5:14b-instruct-q5_0

Para verificar os modelos que Ollama tem no repositório local:

ollama list

Para remover um modelo desnecessário:

ollama rm qwen2:7b-instruct-q8_0 # por exemplo

Localização dos modelos Ollama

Por padrão, os arquivos de modelo são armazenados em:

- Windows: C:\Users%username%.ollama\models

- Linux: /usr/share/ollama/.ollama/models

- macOS: ~/.ollama/models

Configurando o caminho dos modelos Ollama no Windows

Para criar uma variável de ambiente no Windows, você pode seguir estas instruções:

- Abra as Configurações do Windows.

- Vá para Sistema.

- Selecione Sobre.

- Selecione Configurações Avançadas do Sistema.

- Vá para a aba Avançada.

- Selecione Variáveis de Ambiente…

- Clique em Novo…

- E crie uma variável chamada OLLAMA_MODELS apontando para onde você deseja armazenar os modelos.

Mover modelos Ollama no Linux

Edite os parâmetros do serviço systemd do Ollama

sudo systemctl edit ollama.service

ou

sudo xed /etc/systemd/system/ollama.service

Isso abrirá um editor.

Para cada variável de ambiente, adicione uma linha Environment sob a seção [Service]:

[Service]

Environment="OLLAMA_MODELS=/specialplace/ollama/models"

Salve e saia.

Também há parâmetros de Usuário e Grupo, esses devem ter acesso a essa pasta.

Recarregue o systemd e reinicie o Ollama:

sudo systemctl daemon-reload

sudo systemctl restart ollama

se algo deu errado

systemctl status ollama.service

sudo journalctl -u ollama.service

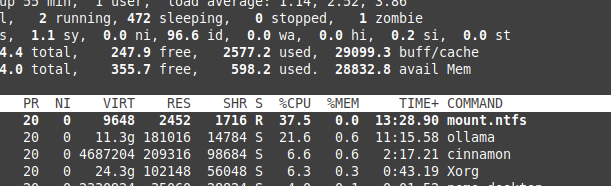

Armazenamento de arquivos no NTFS e sobrecarga

Por favor, esteja ciente de que, se você estiver executando Linux e mantendo seus modelos em uma partição formatada com NTFS, seus modelos carregarão muito mais devagar — mais de 20% mais lento.

Instale Ollama no Windows em uma pasta específica

Junto com os modelos

.\OllamaSetup.exe /DIR=D:\OllamaDir

Expondo a API do Ollama para a rede interna

Internamente aqui significa a rede local.

Adicione à configuração do serviço:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

Para ver como o Ollama se encaixa com outras opções locais e de nuvem de LLM, consulte nosso guia Hospedagem de LLM: Comparação entre Infraestrutura Local, Auto-hospedada e Nuvem.

Links úteis

- Teste: Como o Ollama está usando o desempenho da CPU Intel e núcleos eficientes

- Como o Ollama lida com solicitações paralelas

- Desempenho de LLM e canais PCIe: Considerações importantes

- Comparação de velocidade de LLM

- Comparando as habilidades de resumo de LLM

- Escrevendo prompts eficazes para LLMs

- Auto-hospedando Perplexica com Ollama

- Provedores de LLM em nuvem