Open WebUI : interface auto-hébergée pour LLM

Alternative auto-hébergée de ChatGPT pour les LLM locaux

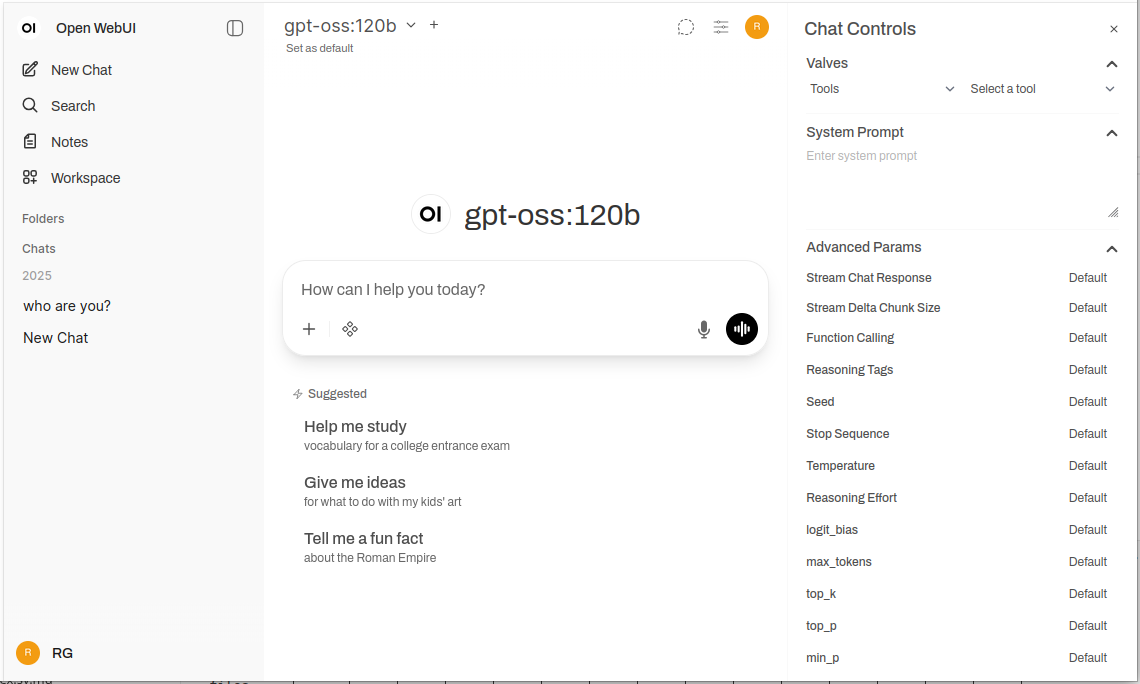

Open WebUI est une application web puissante, extensible et riche en fonctionnalités pour interagir avec les grands modèles de langage, hébergée localement.

Il prend en charge Ollama et tout API compatible avec OpenAI, apportant l’expérience familière de ChatGPT à votre infrastructure, avec une complète confidentialité, des capacités hors ligne et des fonctionnalités d’entreprise de niveau professionnel. Pour une comparaison plus large des backends locaux et cloud des LLM (Ollama, vLLM, Docker Model Runner, LocalAI et fournisseurs cloud), consultez LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

Qu’est-ce que Open WebUI ?

Open WebUI est une application web open source, hébergée localement, qui fournit une interface de chat moderne pour interagir avec les grands modèles de langage. Contrairement aux services d’IA basés sur le cloud, Open WebUI s’exécute entièrement sur votre infrastructure, vous donnant un contrôle complet sur vos données, vos conversations et votre sélection de modèles.

Bien que Open WebUI soit couramment utilisé avec Ollama (et est parfois informellement appelé une « interface WebUI pour Ollama »), il s’agit en réalité d’une plateforme indépendante du backend. Il peut se connecter à l’API d’Ollama pour l’exécution locale des modèles, mais il prend également en charge tout point de terminaison compatible avec OpenAI – y compris vLLM, LocalAI, LM Studio, Text Generation WebUI, et même les fournisseurs cloud. Cette flexibilité fait de Open WebUI une solution complète qui prend en charge plusieurs backends, le RAG (Génération Augmentée par Récupération) pour le chat documentaire, l’authentification multi-utilisateurs, les capacités vocales et des options de personnalisation étendues. Que vous exécutiez des modèles sur un ordinateur portable, un serveur domestique ou un cluster Kubernetes, Open WebUI s’adapte à vos besoins.

Pourquoi choisir Open WebUI ?

Confidentialité en premier lieu : Toutes les données restent sur votre infrastructure – aucune conversation, document ou invite ne quitte votre réseau à moins que vous ne configuriez explicitement des API externes.

Capable de fonctionner hors ligne : Parfait pour les environnements isolés, les réseaux restreints ou les situations où l’accès à Internet est instable ou interdit. Lorsqu’il est associé à des modèles exécutés localement via Ollama ou vLLM, vous atteignez une indépendance totale vis-à-vis des services cloud.

Riche en fonctionnalités : Malgré le fait qu’il soit hébergé localement, Open WebUI rivalise avec les offres commerciales grâce au téléchargement de documents et au RAG, à l’historique des conversations avec une recherche sémantique, aux modèles de prompts et à leur partage, à la gestion des modèles, aux capacités vocales d’entrée/sortie, à une conception responsive pour les appareils mobiles et aux thèmes sombres/clair.

Support multi-utilisateurs : Système d’authentification intégré avec un contrôle d’accès basé sur les rôles (administrateur, utilisateur, en attente), tableau de bord de gestion des utilisateurs, isolement des conversations et partage de prompts et de modèles entre les équipes.

Guide d’installation rapide

La manière la plus rapide de commencer avec Open WebUI est d’utiliser Docker. Cette section couvre les scénarios de déploiement les plus courants.

Installation basique (connexion à un Ollama existant)

Si vous avez déjà Ollama en cours d’exécution sur votre système, utilisez cette commande :

docker run -d \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

Cela exécute Open WebUI sur le port 3000, en persistant les données dans un volume Docker. Accédez-y à http://localhost:3000.

Installation complète (Open WebUI + Ollama)

Pour un déploiement complet avec Ollama inclus :

docker run -d \

-p 3000:8080 \

--gpus all \

-v ollama:/root/.ollama \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:ollama

Le drapeau --gpus all active l’accès GPU pour une inférence plus rapide. Omettez-le si vous exécutez uniquement sur CPU.

Configuration avec Docker Compose

Pour les déploiements en production, Docker Compose offre une meilleure maintenabilité :

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

ports:

- "11434:11434"

volumes:

- ollama:/root/.ollama

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

open-webui:

image: ghcr.io/open-webui/open-webui:main

ports:

- "3000:8080"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

volumes:

- open-webui:/app/backend/data

depends_on:

- ollama

restart: always

volumes:

ollama:

open-webui:

Déployez avec docker-compose up -d.

Déploiement Kubernetes

Pour les déploiements d’entreprise, Open WebUI fournit des chartes Helm :

helm repo add open-webui https://helm.openwebui.com/

helm repo update

helm install open-webui open-webui/open-webui \

--set ollama.enabled=true \

--set ingress.enabled=true \

--set ingress.host=chat.yourdomain.com

Cela crée un déploiement prêt pour la production avec un stockage persistant, des vérifications de santé et une configuration d’ingress optionnelle.

Analyse approfondie des fonctionnalités principales

RAG et chat documentaire

L’implémentation de RAG d’Open WebUI vous permet de télécharger des documents et d’avoir le modèle qui s’y réfère lors des conversations. Le système fragmente automatiquement les documents, génère des embeddings, les stocke dans une base de données vectorielle et récupère le contexte pertinent lorsque vous posez des questions.

Formats pris en charge : PDF, DOCX, TXT, Markdown, CSV, et plus encore grâce aux parseurs intégrés.

Utilisation : Cliquez sur le bouton ‘+’ dans un chat, sélectionnez ‘Télécharger des fichiers’, choisissez vos documents et commencez à poser des questions. Le modèle citera les passages pertinents et les numéros de pages dans ses réponses.

Configuration : Vous pouvez ajuster la taille de fragment, le chevauchement, le modèle d’embedding et les paramètres de récupération dans les paramètres administrateurs pour une performance optimale avec vos types de documents.

Authentification et gestion multi-utilisateurs

Open WebUI inclut un système complet d’authentification adapté à l’utilisation en équipe et organisationnelle :

- Authentification locale : Nom d’utilisateur/mot de passe avec hachage sécurisé des mots de passe

- Intégration OAuth/OIDC : Connexion aux fournisseurs d’identité existants (Google, GitHub, Keycloak, etc.)

- LDAP/Active Directory : Intégration de répertoires d’entreprise

- Accès basé sur les rôles : Administrateur (contrôle complet), Utilisateur (accès standard), En attente (requiert une approbation)

Les administrateurs peuvent gérer les utilisateurs, surveiller l’utilisation, configurer l’accès aux modèles par utilisateur/groupe et définir des politiques de rétention des conversations.

Entrée et sortie vocale

Le support intégré pour l’interaction vocale rend Open WebUI accessible et pratique :

- Reconnaissance vocale : Utilise l’API Web Speech ou des services STT externes configurés

- Synthèse vocale : Plusieurs moteurs TTS pris en charge (basés sur le navigateur, Coqui TTS, ElevenLabs, etc.)

- Prise en charge linguistique : Fonctionne avec plusieurs langues selon votre configuration TTS/STT

Outils d’ingénierie de prompts

Open WebUI fournit des outils robustes pour la gestion des prompts :

- Bibliothèque de prompts : Enregistrez des prompts fréquemment utilisés en tant que modèles

- Variables et placeholders : Créez des prompts réutilisables avec du contenu dynamique

- Partage de prompts : Partagez des prompts efficaces avec votre équipe

- Versionnage de prompts : Suivez les changements et les améliorations au fil du temps

Gestion des modèles

Changement et gestion facile des modèles via l’interface utilisateur :

- Catalogue de modèles : Parcourez et téléchargez directement des modèles depuis la bibliothèque d’Ollama

- Modèles personnalisés : Téléchargez et configurez des modèles GGUF personnalisés

- Paramètres de modèles : Ajustez la température, le top-p, la longueur du contexte et d’autres paramètres d’échantillonnage par conversation

- Métadonnées des modèles : Consultez les détails du modèle, la taille, la quantisation et les capacités

Configuration et personnalisation

Variables d’environnement

Options de configuration importantes via les variables d’environnement :

# URL du backend (Ollama ou autre API compatible avec OpenAI)

OLLAMA_BASE_URL=http://localhost:11434

# Activer l'authentification

WEBUI_AUTH=true

# Rôle utilisateur par défaut (user, admin, pending)

DEFAULT_USER_ROLE=pending

# Activer l'inscription utilisateur

ENABLE_SIGNUP=true

# Email administrateur (création automatique du compte administrateur)

WEBUI_ADMIN_EMAIL=admin@example.com

# Base de données (par défaut SQLite, ou PostgreSQL pour la production)

DATABASE_URL=postgresql://user:pass@host:5432/openwebui

# Activer RAG

ENABLE_RAG=true

# Modèle d'embedding pour RAG

RAG_EMBEDDING_MODEL=sentence-transformers/all-MiniLM-L6-v2

Connexion à d’autres backends

Open WebUI fonctionne avec tout API compatible avec OpenAI. Configurez l’URL de base dans Paramètres → Connexions :

- vLLM :

http://localhost:8000/v1 - LocalAI :

http://localhost:8080 - LM Studio :

http://localhost:1234/v1 - Text Generation WebUI :

http://localhost:5000/v1 - OpenAI :

https://api.openai.com/v1(requiert une clé API) - Azure OpenAI : URL de point de terminaison personnalisée

Configuration d’un proxy inverse

Pour les déploiements en production, exécutez Open WebUI derrière un proxy inverse :

Exemple Nginx :

server {

listen 443 ssl http2;

server_name chat.yourdomain.com;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# Support WebSocket

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}

Exemple Traefik (étiquettes Docker) :

labels:

- "traefik.enable=true"

- "traefik.http.routers.openwebui.rule=Host(`chat.yourdomain.com`)"

- "traefik.http.routers.openwebui.entrypoints=websecure"

- "traefik.http.routers.openwebui.tls.certresolver=letsencrypt"

- "traefik.http.services.openwebui.loadbalancer.server.port=8080"

Optimisation des performances

Réglage de la base de données

Pour les déploiements multi-utilisateurs, basculez de SQLite vers PostgreSQL :

# Installer les dépendances

pip install psycopg2-binary

# Configurer l'URL de la base de données

DATABASE_URL=postgresql://openwebui:password@postgres:5432/openwebui

PostgreSQL gère mieux les utilisateurs concurrents et offre une meilleure performance des requêtes pour la recherche de conversations et les opérations RAG.

Sélection du modèle d’embedding

La performance de RAG dépend fortement de votre choix de modèle d’embedding :

- Rapide/contraintes de ressources :

all-MiniLM-L6-v2(384 dimensions, ~80Mo) - Équilibré :

all-mpnet-base-v2(768 dimensions, ~420Mo) - Meilleure qualité :

bge-large-en-v1.5(1024 dimensions, ~1,3Go)

Configurez dans Paramètres → RAG → Modèle d’embedding.

Stratégies de mise en cache

Activez le mise en cache des conversations pour réduire les appels API répétés :

- Mise en cache des modèles : Ollama met automatiquement en cache les modèles chargés en mémoire

- Mise en cache des réponses : Open WebUI peut mettre en cache les prompts identiques (configurable)

- Mise en cache des embeddings : Réutilisez les embeddings pour les documents traités précédemment

Bonnes pratiques de sécurité

Lors du déploiement d’Open WebUI en production, suivez ces bonnes pratiques de sécurité :

- Activer l’authentification : Ne jamais exécuter Open WebUI sans authentification sur les réseaux publics

- Utiliser HTTPS : Déployez toujours derrière un proxy inverse avec TLS/SSL

- Mises à jour régulières : Gardez Open WebUI et Ollama à jour pour les correctifs de sécurité

- Restreindre l’accès : Utilisez des règles de pare-feu pour limiter l’accès aux réseaux approuvés

- Sécuriser les clés API : Si vous vous connectez à des API externes, utilisez des variables d’environnement, jamais de clés codées en dur

- Journalisation d’audit : Activez et surveillez les journaux d’accès pour les activités suspectes

- Sauvegardes de données : Sauvegardez régulièrement le volume

/app/backend/data - Chiffrement de la base de données : Activez le chiffrement au repos pour PostgreSQL en production

- Limitation de débit : Configurez des limites de débit pour empêcher les abus

- Filtrage de contenu : Implémentez des politiques de contenu adaptées à votre organisation

Cas d’utilisation et applications réelles

Assistant de connaissance personnel

Combinez Open WebUI avec des modèles locaux et RAG pour créer une base de connaissance privée. Téléchargez vos notes, vos articles de recherche, vos documents de projet et vos documents personnels. Posez des questions de manière conversationnelle sans envoyer de données vers les services cloud – idéal pour les chercheurs, les étudiants et les travailleurs de la connaissance qui valorisent la confidentialité.

Collaboration d’équipe de développement

Déployez Open WebUI pour votre équipe de développement avec un accès partagé à la documentation technique, aux spécifications API et aux connaissances du codebase. La fonctionnalité RAG permet aux développeurs de trouver rapidement des informations pertinentes sur des milliers de pages de documentation, tandis que l’historique des conversations aide à suivre les décisions architecturales et les discussions techniques.

Chatbot interne d’entreprise

Les organisations peuvent déployer Open WebUI derrière leur pare-feu avec une intégration SSO, offrant aux employés un assistant IA qui a accès aux wikis internes, aux politiques et aux procédures. Le contrôle d’accès basé sur les rôles assure que les informations sensibles restent correctement segmentées, tandis que les contrôles administratifs maintiennent la gouvernance et la conformité.

Éducation et formation

Les institutions éducatives utilisent Open WebUI pour fournir aux étudiants et aux enseignants un assistant IA sans préoccupation de confidentialité. Téléchargez des matériaux de cours, des manuels et des notes de conférence pour des Q&A contextuels. Le système multi-utilisateurs permet de suivre l’utilisation tout en maintenant la confidentialité des données des étudiants.

Applications de santé et juridiques

Dans les industries réglementées où la confidentialité des données est critique, Open WebUI permet des flux de travail assistés par l’IA tout en maintenant la conformité HIPAA ou GDPR. Les professionnels de la santé peuvent consulter des bases de données de médicaments et des protocoles de traitement, tandis que les équipes juridiques peuvent rechercher des jurisprudences et des contrats – tout sans que les données ne quittent l’infrastructure contrôlée.

Environnements isolés et hors ligne

Les agences gouvernementales, les laboratoires de recherche et les centres d’opérations sécurisés utilisent Open WebUI dans des réseaux isolés. La capacité totale hors ligne garantit que l’assistance AI reste disponible même sans connexion Internet, cruciale pour les environnements classifiés ou les zones éloignées.

Dépannage des problèmes courants

Problèmes de connexion

Problème : Open WebUI ne peut pas se connecter à Ollama

Solution : Vérifiez que Ollama est en cours d’exécution (curl http://localhost:114线), vérifiez la variable d’environnement OLLAMA_BASE_URL et assurez-vous que les règles de pare-feu permettent la connexion. Pour les déploiements Docker, utilisez les noms de service (http://ollama:11434) au lieu de localhost.

Problème : Les modèles ne s’affichent pas dans l’interface utilisateur

Solution : Confirmez que les modèles sont installés (ollama list), actualisez la liste des modèles dans les paramètres d’Open WebUI et vérifiez le console du navigateur pour les erreurs API.

Problèmes de téléchargement et de RAG

Problème : Le téléchargement de documents échoue

Solution : Vérifiez les limites de taille de fichiers dans les paramètres, vérifiez le format de fichier pris en charge, assurez-vous qu’il y a suffisamment d’espace disque dans le volume de données, et examinez les journaux du conteneur pour les erreurs de parsing.

Problème : Les réponses RAG ne font pas référence aux documents téléchargés

Solution : Vérifiez que le modèle d’embedding est téléchargé et en cours d’exécution, vérifiez les paramètres de taille de fragment (essayez des fragments plus petits pour une meilleure granularité), augmentez le nombre de fragments récupérés dans les paramètres RAG et assurez-vous que la requête est pertinente par rapport au contenu des documents.

Problèmes de performance

Problème : Temps de réponse lents

Solution : Activez l’accélération GPU si disponible, réduisez la taille du modèle ou utilisez des versions quantifiées, augmentez OLLAMA_NUM_PARALLEL pour les requêtes simultanées et allouez plus de RAM aux conteneurs Docker.

Problème : Erreurs de mémoire insuffisante

Solution : Utilisez des modèles plus petits (7B au lieu de 13B de paramètres), réduisez la longueur du contexte dans les paramètres du modèle, limitez le nombre d’utilisateurs simultanés ou ajoutez plus de RAM/espaces d’échange à votre système.

Authentification et accès

Problème : Impossible de se connecter ou de créer un compte administrateur

Solution : Définissez WEBUI_AUTH=true, configurez WEBUI_ADMIN_EMAIL pour créer automatiquement un administrateur, effacez les cookies et le cache du navigateur et vérifiez les journaux du conteneur pour les erreurs de base de données.

Problème : Les utilisateurs ne peuvent pas s’inscrire

Solution : Vérifiez que ENABLE_SIGNUP=true, vérifiez la configuration DEFAULT_USER_ROLE (utilisez user pour une approbation automatique ou pending pour une approbation manuelle) et assurez-vous que la base de données est accessible en écriture.

Alternatives à Open WebUI

Bien que Open WebUI excelle à fournir une interface hébergée localement avec une intégration forte d’Ollama, plusieurs alternatives offrent des approches différentes pour le même problème. Votre choix dépend de savoir si vous avez besoin de flexibilité multi-fournisseurs, de traitement spécialisé des documents, d’une extrême simplicité ou de fonctionnalités d’entreprise.

LibreChat se distingue comme la solution la plus indépendante des fournisseurs, offrant un support natif pour OpenAI, Anthropic, Azure OpenAI, Google Vertex AI, AWS Bedrock et Ollama dans une seule interface. Son architecture de plugin et ses fonctionnalités d’entreprise comme la multi-tenance, les contrôles d’accès détaillés et les quotas d’utilisation en font un choix idéal pour les organisations qui doivent supporter plusieurs fournisseurs d’IA ou nécessitent des audits détaillés. Le compromis est la complexité – LibreChat nécessite plus d’efforts de configuration et des ressources plus lourdes qu’Open WebUI, et son support d’Ollama semble secondaire par rapport aux fournisseurs cloud. Si votre équipe utilise Claude pour écrire, GPT-4 pour coder et des modèles locaux pour les travaux sensibles à la confidentialité, l’interface unifiée de LibreChat brille.

Pour les flux de travail lourds en documents, AnythingLLM adopte une approche de base de connaissances première qui va au-delà du RAG de base. Son modèle d’espace de travail organise les documents et les conversations en environnements isolés, tandis que les fonctionnalités de recherche avancées incluent la recherche hybride, le reranking et le suivi des citations. Les connecteurs de données extraient le contenu de GitHub, de Confluence et de Google Drive, et les capacités d’agents permettent des raisonnements multi-étapes et l’automatisation des workflows. Cela rend AnythingLLM excellent pour les cabinets de conseil gérant plusieurs bases de connaissances clients ou les équipes de support travaillant avec une documentation étendue. L’interface de chat est moins polie qu’Open WebUI, mais si la recherche de grandes collections de documents est votre besoin principal, les capacités de recherche sophistiquées justifient la courbe d’apprentissage plus raide.

LobeChat privilégie l’expérience utilisateur par rapport à la profondeur des fonctionnalités, offrant une interface moderne, mobile-friendly avec des capacités d’applications web progressives. Son design moderne, ses animations fluides et son fort support vocal/multimodal le rendent populaire auprès des designers et des utilisateurs non techniques qui souhaitent un assistant AI qui fonctionne de manière fluide à travers les appareils. L’implémentation PWA fournit une expérience d’application mobile qui Open WebUI ne matche pas. Cependant, les fonctionnalités d’entreprise sont limitées, l’écosystème de plugins est plus petit et les capacités de RAG sont en retard par rapport à celles d’Open WebUI et d’AnythingLLM.

Pour les utilisateurs qui préfèrent les applications de bureau, Jan.ai fournit des installateurs multiplateforme (Windows, macOS, Linux) avec une gestion locale des modèles sans configuration. Il n’est pas nécessaire d’installer Ollama séparément ou de gérer Docker – Jan regroupe tout dans une application native avec un support de la barre d’application et des téléchargements de modèles en un clic. Cette philosophie « ça marche tout de suite » rend Jan idéal pour donner des LLM locaux à des membres de la famille ou à des collègues qui ne sont pas à l’aise avec les outils en ligne de commande. Les compromis sont l’absence de support multi-utilisateurs, de moins de fonctionnalités avancées et de l’absence de capacité d’accès à distance.

Chatbox occupe le niche légère – un client multiplateforme minimal supportant OpenAI, Claude, Gemini et des APIs locales avec un faible surcoût de ressources. Il est parfait pour les développeurs qui souhaitent rapidement tester différents fournisseurs d’API ou les utilisateurs avec un matériel à ressources limitées. Le frottement d’installation est minimal, mais certaines fonctionnalités sont souscrites, ce n’est pas entièrement open source et le support RAG est limité.

Plusieurs UIs minimales spécifiques à Ollama existent pour les utilisateurs qui veulent « juste assez » d’interface : Hollama gère plusieurs serveurs Ollama sur différentes machines, Ollama UI fournit un chat de base et un téléchargement de PDF avec un déploiement extrêmement simple, et Oterm offre une interface basée sur le terminal surprenamment capable pour les sessions SSH et les workflows tmux. Ces derniers sacrifient des fonctionnalités pour la simplicité et la vitesse.

Pour les organisations nécessitant un support de fournisseur, les options commerciales comme TypingMind Team, BionicGPT et Dust.tt offrent un hébergement avec un soutien professionnel, des certificats de conformité et des SLAs. Ils échangent la liberté open source pour une disponibilité garantie, des audits de sécurité et de l’accountabilité – approprié lorsque votre organisation a besoin de contrats de support d’entreprise.

Choisir judicieusement : Open WebUI touche le point idéal pour la plupart des déploiements locaux d’Ollama, équilibrant les fonctionnalités complètes avec une complexité gérable. Choisissez LibreChat lorsque la flexibilité des fournisseurs est primordiale, AnythingLLM pour les workflows documentaires sophistiqués, LobeChat pour les utilisateurs mobile-first ou design-conscious, Jan pour les utilisateurs de bureau non techniques, ou des options commerciales lorsqu’un support de fournisseur est nécessaire. Pour la majorité des utilisateurs techniques exécutant des modèles locaux, le développement actif, la communauté forte et l’implémentation RAG excellente d’Open WebUI en font le point de départ recommandé.

Développements futurs et roadmap

Open WebUI continue de développer rapidement avec plusieurs fonctionnalités passionnantes sur la roadmap :

Meilleure prise en charge multimodale : Meilleure gestion des images, des modèles visuels et des conversations multimodales avec des modèles comme LLaVA et Bakllava.

Fonctionnalités améliorées d’agents : Appel de fonctions, utilisation d’outils et workflows de raisonnement multi-étapes similaires à AutoGPT.

Meilleures applications mobiles : Applications natives iOS et Android au-delà de l’implémentation PWA actuelle pour une meilleure expérience mobile.

Fonctionnalités avancées de RAG : RAG basé sur le graphe, découpage sémantique, recherche multi-requête et récupération de documents parents pour un meilleur contexte.

Fonctionnalités collaboratives : Conversations partagées, espaces de travail d’équipe et collaboration en temps réel sur les prompts et les documents.

Intégrations d’entreprise : Support SSO plus profond, provisionnement SCIM, journaux d’audit avancés et rapports de conformité pour les industries réglementées.

Le projet maintient la compatibilité descendante et la versioning sémantique, rendant les mises à niveau simples. Le dépôt GitHub actif voit des commits quotidiens et une gestion proactive des problèmes.

Conclusion

Open WebUI a évolué d’une simple interface frontend d’Ollama vers une plateforme complète pour les interactions d’IA hébergées localement. Sa combinaison de confidentialité, de fonctionnalités et d’ease de déploiement en fait un excellent choix pour les individus, les équipes et les organisations souhaitant utiliser des LLM locaux sans sacrifier les capacités.

Que vous soyez un développeur testant des modèles, une organisation créant des outils d’IA internes ou un individu privilégiant la confidentialité, Open WebUI fournit la base pour des workflows d’IA puissants et localement hébergés. La communauté active, les mises à jour régulières et l’architecture extensible assurent qu’il restera une option majeure dans l’espace des IA hébergées localement.

Commencez avec l’installation Docker basique, expérimentez le RAG en téléchargeant quelques documents, essayez différents modèles de la bibliothèque d’Ollama et explorez progressivement les fonctionnalités avancées à mesure que vos besoins grandissent. La courbe d’apprentissage est douce, mais le plafond est élevé – Open WebUI s’étend de l’ordinateur portable personnel au cluster Kubernetes d’entreprise.

Pour ceux qui comparent les alternatives, le design d’Ollama-first, l’ensemble équilibré de fonctionnalités et le développement actif d’Open WebUI en font le point de départ recommandé pour la plupart des déploiements d’LLM hébergés localement. Vous pouvez toujours migrer vers des solutions plus spécialisées si des besoins spécifiques émergent, mais de nombreux utilisateurs trouvent les capacités d’Open WebUI suffisantes pour leur parcours complet, de l’expérimentation à la production.

Pour voir comment les backends typiques d’Open WebUI (Ollama, vLLM, etc.) s’intègrent avec Docker Model Runner, LocalAI et les fournisseurs cloud, consultez notre guide LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

Liens utiles

Lorsque vous configurez votre environnement Open WebUI, vous bénéficierez de comprendre l’écosystème plus large des options d’hébergement et de déploiement des LLM locaux. Le guide complet Local LLM Hosting: Complete 2025 Guide - Ollama, vLLM, LocalAI, Jan, LM Studio & More compare 12+ outils locaux pour LLM incluant Ollama, vLLM, LocalAI et d’autres, vous aidant à choisir le backend optimal pour votre déploiement Open WebUI basé sur la maturité API, les capacités d’appel d’outils et les benchmarks de performance.

Pour les déploiements de production à haute performance où le débit et la latence sont critiques, explorez le guide vLLM Quickstart: High-Performance LLM Serving, qui couvre la configuration de vLLM avec Docker, la compatibilité API OpenAI et l’optimisation PagedAttention. Cela est particulièrement précieux si Open WebUI sert plusieurs utilisateurs simultanés et que les performances d’Ollama deviennent un goulot d’étranglement.

Comprendre comment votre backend gère les demandes parallèles est crucial pour la planification de la capacité. L’article How Ollama Handles Parallel Requests explique le modèle de file d’attente des demandes d’Ollama, la gestion de la mémoire GPU et le modèle d’exécution parallèle, vous aidant à configurer les limites et les attentes appropriées pour les scénarios de déploiement multi-utilisateurs d’Open WebUI.

Ressources externes

Pour la documentation officielle et le support communautaire, faites référence à ces ressources externes :