Docker Model Runner vs Ollama (2026): Welk van de twee is beter voor lokale LLMs?

Vergelijk Docker Model Runner en Ollama voor lokale LLM

Het uitvoeren van grote taalmodellen (LLMs) lokaal is steeds populairder geworden vanwege privacy, kostcontrole en offlinefunctionaliteiten. Het landschap is aanzienlijk veranderd in april 2025 toen Docker Docker Model Runner (DMR) introduceerde, hun officiële oplossing voor AI-modellering.

Nu zijn er drie aanpakken die strijden om de aandacht van ontwikkelaars: Docks eigen Model Runner, derde partij containeroplossingen (vLLM, TGI) en het standalone platform Ollama.

Voor een breder overzicht dat ook cloudproviders en infrastructuurcompromissen omvat, zie LLM Hosting: Lokaal, Self-Hosted & Cloud Infrastructure Vergelijking.

TL;DR – Docker Model Runner vs Ollama

Deze vergelijking richt zich op het uitvoeren van grote taalmodellen (LLMs) lokaal met behulp van Docker of standalone runtimes, met een overzicht van prestaties, GPU-ondersteuning, API-compatibiliteit en productie-uitrolscenario’s.

- Beste voor Docker-native workflows: Docker Model Runner

- Beste voor eenvoud en snelle prototyping: Ollama

- Beste voor Kubernetes & orchestration: Docker-gebaseerde opstellingen

- Beste voor single-machine ontwikkeling: Ollama

Als je al intensief Docker gebruikt, is DMR een logische keuze.

Als je de snelste manier zoekt om LLMs lokaal uit te voeren, is Ollama eenvoudiger.

Als je meer dan alleen Docker Model Runner en Ollama vergelijkt, zie dan ons volledig overzicht van Ollama vs vLLM vs LM Studio en andere lokale LLM-tools. Die gids vergelijkt API-rijpheid, hardware-ondersteuning, tool calling en productiebereidheid over 12+ lokale LLM-runtime’s.

Docker Model Runner vs Ollama: Directe Vergelijking

Met Docks officiële invloed op het LLM-runner-gebied, wordt de vergelijking interessanter. Hieronder staat hoe DMR en Ollama zich tegenover elkaar stellen:

| Kenmerk | Docker Model Runner | Ollama |

|---|---|---|

| Installatie | Docker Desktop AI tab of docker-model-plugin |

Enkele opdracht: curl | sh |

| Opdrachtstijl | docker model pull/run/package |

ollama pull/run/list |

| Modelformaat | GGUF (OCI Artifacts) | GGUF (natief) |

| Modelverdeling | Docker Hub, OCI registers | Ollama register |

| GPU-instelling | Automatisch (eenvoudiger dan traditionele Docker) | Automatisch |

| API | OpenAI-compatibel | OpenAI-compatibel |

| Docker-integratie | Natief (is Docker) | Werkt in Docker als nodig |

| Compose-ondersteuning | Natief | Via Docker-image |

| Leercurve | Laag (voor Docker-gebruikers) | Laagst (voor iedereen) |

| Ecosysteempartners | Google, Hugging Face, VMware | LangChain, CrewAI, Open WebUI |

| Beste voor | Docker-native workflows | Standalone eenvoud |

Belangrijk inzicht: DMR brengt Docker-workflows naar LLM-uitrol, terwijl Ollama framework-onafhankelijk blijft met eenvoudige standalone werking. Je bestaande infrastructuur is belangrijker dan technische verschillen.

Is Docker Model Runner beter dan Ollama?

Dat hangt af van je workflow.

- Kies Docker Model Runner (DMR) als je team al intensief gebruikmaakt van Docker, OCI-artefacten en containerorchestratie.

- Kies Ollama als je de eenvoudigste manier zoekt om LLMs lokaal uit te voeren met minimale configuratie en snelle prototyping.

Voor de meeste single-machine opstellingen is Ollama makkelijker te gebruiken.

Voor Docker-native CI/CD-pijplijnen en enterprise-containerwerken, sluit DMR natuurlijker aan.

Hoe voer je een LLM uit in Docker: DMR vs Ollama

Als je doel is om eenvoudigweg een LLM in Docker uit te voeren, kunnen zowel Docker Model Runner en Ollama in Docker-containers dit bereiken.

Docker Model Runner gebruikt native docker model pull en docker model run opdrachten, verpakkend modellen als OCI-artefacten.

Ollama kan ook in Docker worden uitgevoerd met behulp van de officiële ollama/ollama containerimage, met een OpenAI-compatibele API op poort 11434.

Het belangrijkste verschil ligt in werkstroomintegratie:

- DMR past natuurlijk in Docker-native CI/CD-pijplijnen.

- Ollama in Docker biedt eenvoudigere modelbeheer met Docker-orchestratieflexibiliteit.

Begrijpen van Docker Model Runners

Docker-gebaseerde modelrunners gebruiken containerisatie om LLM-inferentieengines te verpakken met hun afhankelijkheden. Het landschap omvat zowel Docks officiële oplossing als derde partij frameworks.

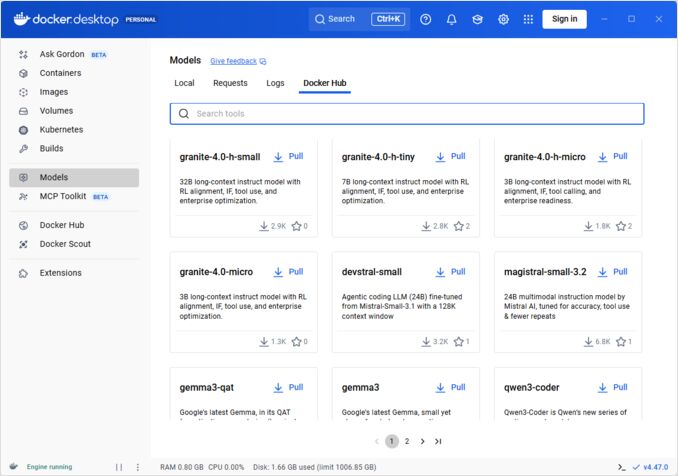

Docker Model Runner (DMR) - Officiële Oplossing

In april 2025 introduceerde Docker Docker Model Runner (DMR), een officieel product dat bedoeld is om het lokaal uitvoeren van AI-modellen te vereenvoudigen met behulp van Docks infrastructuur. Dit vertegenwoordigt Docks toewijding om AI-modeluitrol zo naadloos mogelijk te maken als containeruitrol.

Belangrijke kenmerken van DMR:

- Natuurlijke Docker-integratie: Gebruikt bekende Docker-opdrachten (

docker model pull,docker model run,docker model package) - OCI-artefactverpakkings: Modellen worden verpakt als OCI-artefacten, waardoor distributie mogelijk is via Docker Hub en andere registers

- OpenAI-compatibele API: Directe vervanging voor OpenAI-eindpunten, waardoor integratie eenvoudiger wordt

- GPU-accelleratie: Natieve GPU-ondersteuning zonder complexe nvidia-docker configuratie

- GGUF-formaatondersteuning: Werkt met populaire gequantiseerde modelformaten

- Docker Compose-integratie: Modelconfiguratie en -implementatie met standaard Docker-hulpmiddelen

- Testcontainers-ondersteuning: Vloeiend integratie met testframeworks

Installatie:

- Docker Desktop: Activeren via AI-tab in instellingen

- Docker Engine: Installeer

docker-model-pluginpakket

Voorbeeldgebruik:

# Trek een model op van Docker Hub

docker model pull ai/smollm2

# Voer inferentie uit

docker model run ai/smollm2 "Leg Docker Model Runner uit"

# Verpak een aangepast model

docker model package --gguf /pad/naar/model.gguf --push myorg/mymodel:latest

Voor een volledig overzicht van docker model opdrachten, verpakkingsopties, configuratieflags en praktische voorbeelden, zie onze gedetailleerde Docker Model Runner Cheatsheet: Opdrachten & Voorbeelden. Het behandelt modeltrekken, verpakken, configuratie en best practices voor het lokaal uitvoeren van LLMs met Docker.

DMR werkt samen met Google, Hugging Face en VMware Tanzu om het AI-model-ecosysteem uit te breiden dat beschikbaar is via Docker Hub. Als je nieuw bent op Docker of een herhaling nodig hebt van Docker-opdrachten, biedt onze Docker Cheatsheet een uitgebreide gids voor essentiële Docker-operaties.

Derde partij Docker-oplossingen

Naast DMR omvat het ecosysteem vastgestelde frameworks:

- vLLM containers: Hoge doorvoer inferentie-server geoptimaliseerd voor batchverwerking

- Text Generation Inference (TGI): Productiebereide oplossing van Hugging Face

- llama.cpp containers: Lichte C++-implementatie met gequantiseerde modellen

- Aangepaste containers: Wrappen PyTorch, Transformers of eigen frameworks

Voordelen van de Docker aanpak

Flexibiliteit en framework-onafhankelijkheid: Docker-containers kunnen elke LLM-framework uitvoeren, van PyTorch tot ONNX Runtime, waardoor ontwikkelaars volledige controle hebben over de inferentiestap.

Resourceisolatie: Elke container werkt in geïsoleerde omgevingen met gedefinieerde resourcebeperkingen (CPU, geheugen, GPU), voorkomend resourceconflicten bij meervoudige modelimplementaties.

Orchestration-ondersteuning: Docker sluit vloeiend aan bij Kubernetes, Docker Swarm en cloudplatforms voor schaalbaarheid, loadbalancing en hoge beschikbaarheid.

Versiebeheer: Verschillende modelversies of frameworks kunnen op hetzelfde systeem samenbestaan zonder afhankelijkheidsconflicten.

Nadelen van de Docker aanpak

Complexiteit: Vereist begrip van containerisatie, volume-aankoppelingen, netwerkconfiguratie en GPU-passthrough (nvidia-docker).

Overhead: Hoewel gering, voegt Docker een dunne abstractielayer toe die licht impact heeft op opstarttijd en resourcegebruik.

Configuratiebelast: Elke implementatie vereist zorgvuldige configuratie van Dockerfiles, omgevingsvariabelen en runtimeparameters.

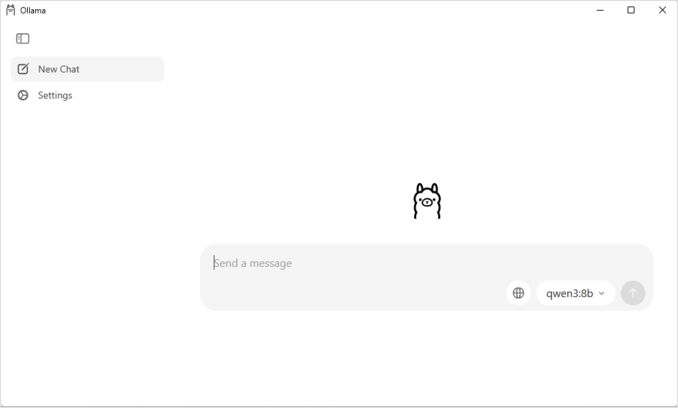

Begrijpen van Ollama

Ollama is een doelgerichte toepassing voor het lokaal uitvoeren van LLMs, ontworpen met eenvoud als kernprincipe. Het biedt:

- Native binair voor Linux, macOS en Windows

- Ingebouwde modelbibliotheek met één-opdracht installatie

- Automatische GPU-detectie en optimalisatie

- RESTful API compatibel met OpenAI-formaat

- Modelcontext en statusbeheer

Voordelen van Ollama

Eenvoud: Installatie is eenvoudig (curl | sh op Linux), en het uitvoeren van modellen vereist alleen ollama run llama2. Voor een volledig overzicht van Ollama CLI-opdrachten zoals ollama serve, ollama run, ollama ps en modelbeheerwerken, zie onze Ollama CLI Cheatsheet.

Optimaliseerde prestaties: Gebaseerd op llama.cpp is Ollama zeer goed geoptimaliseerd voor inferentiesnelheid met ondersteuning voor gequantiseerde modellen (Q4, Q5, Q8).

Modelbeheer: Ingebouwde modelregister met opdrachten zoals ollama pull, ollama list, en ollama rm vereenvoudigt het modellevenloopbeheer.

Ontwikkelaarservarie: Sfeervolle API, uitgebreide documentatie en groeiend ecosysteem van integraties (LangChain, CrewAI, enzovoort). Ollama’s flexibiliteit strekt zich uit naar gespecialiseerde toepassingen zoals herordenen van tekstdocumenten met embeddingmodellen.

Ressourceefficiëntie: Automatische geheugenbeheer en modelontlading bij inactiviteit bespaart systeemressourcen.

Nadelen van Ollama

Framework-lock-in: Voornamelijk ondersteunt modellen compatibel met llama.cpp, beperkend de flexibiliteit voor frameworks zoals vLLM of aangepaste inferentieengines.

Beperkte aanpassing: Geavanceerde configuraties (aangepaste gequantisering, specifieke CUDA-stromen) zijn minder toegankelijk dan in Docker-omgevingen.

Orchestrationuitdagingen: Hoewel Ollama in containers kan draaien, ontbreekt native ondersteuning voor geavanceerde orchestrationfuncties zoals horizontale schaalbaarheid.

Prestatievergelijking

Inferentiesnelheid

Docker Model Runner: Prestaties vergelijkbaar met Ollama, aangezien beide GGUF-gequantiseerde modellen ondersteunen. Voor Llama 2 7B (Q4), verwacht 20-30 tokens/second op CPU en 50-80 tokens/second op mid-range GPUs. Minimale containeroverhead.

Ollama: Gebruikt zeer geoptimaliseerde llama.cpp backend met efficiënte gequantisering. Voor Llama 2 7B (Q4), verwacht 20-30 tokens/second op CPU en 50-80 tokens/second op mid-range GPUs. Geen containerisatieoverhead. Voor details over hoe Ollama concurrente inferentie beheert, zie onze analyse over hoe Ollama parallele aanvragen beheert.

Docker (vLLM): Geoptimaliseerd voor batchverwerking met continue batchverwerking. Individuele aanvragen kunnen iets langzamer zijn, maar doorvoer excelleert bij hoge concurrentiebelasting (100+ tokens/second per model met batchverwerking).

Docker (TGI): Vergelijkbaar met vLLM met uitstekende batchverwerking. Voegt functies toe zoals streaming en token-voor-tokengeneratie.

Geheugengebruik

Docker Model Runner: Vergelijkbaar met Ollama met automatische modelbelading. GGUF Q4-modellen gebruiken meestal 4-6 GB RAM. Containeroverhead is minimaal (tientallen MB).

Contextgrootteconfiguratie kan aanzienlijk invloed hebben op geheugengebruik en modelgedrag. Standaard beperken sommige Docker Model Runner CUDA-afbeeldingen een contextgrootte van 4096 tokens, zelfs als hogere waarden worden opgegeven in docker-compose. Voor gedetailleerde stappen om dit gedrag te overschrijden en modellen met aangepaste contextgrootte te verpakken, zie onze gids over configureren van contextgrootte in Docker Model Runner.

Ollama: Automatische geheugenbeheer laadt modellen op aanvraag en ontlaadt ze bij inactiviteit. Een 7B Q4-model gebruikt meestal 4-6 GB RAM. Meest efficiënt voor single-modelscenario’s.

Traditionele Docker-oplossingen: Geheugen hangt af van het framework. vLLM vooraf alloceert GPU-geheugen voor optimale prestaties, terwijl PyTorch-gebaseerde containers mogelijk meer RAM gebruiken voor modelgewichten en KV-cache (8-14 GB voor 7B-modellen).

Opstarttijd

Docker Model Runner: Containeropstart voegt ongeveer 1 seconde toe, plus modelbelading (2-5 seconden). Totaal: 3-6 seconden voor gemiddelde modellen.

Ollama: Bijna onmiddellijke opstart met modelbelading die 2-5 seconden duurt voor gemiddelde modellen. Snelste koudstartervaring.

Traditionele Docker: Containeropstart voegt 1-3 seconden toe, plus modelbeladingstijd. Voorverwarming van containers vermindert dit in productieimplementaties.

Aanbevelingen voor gebruiksscenario’s

Kies Docker Model Runner wanneer

- Docker-first workflow: Je team gebruikt Docker intensief

- Gecombineerd hulpmiddel: Je wilt één tool (Docker) voor containers en modellen

- OCI-artefactdistributie: Je hebt enterprise registerintegratie nodig

- Testcontainers-integratie: Je test AI-functies in CI/CD

- Docker Hub voorkeur: Je wilt modeldistributie via bekende kanalen

Kies Ollama wanneer

- Snel prototyping: Snel experimenteren met verschillende modellen

- Framework-onafhankelijkheid: Niet gebonden aan Docker-ecosysteem

- Absolute eenvoud: Minimale configuratie en onderhoudsbelast

- Single-serverimplementaties: Uitvoeren op laptops, werkstations of single VMs

- Grote modelbibliotheek: Toegang tot uitgebreide vooraf geconfigureerde modelregister

Kies derde partij Docker-oplossingen wanneer

- Productieimplementaties: Noodzaak voor geavanceerde orchestration en monitoring

- Multi-modelserving: Uitvoeren van verschillende frameworks (vLLM, TGI) tegelijkertijd

- Kubernetes orchestration: Schalen over clusters met loadbalancing

- Aangepaste frameworks: Gebruik van Ray Serve of eigen inferentieengines

- Strikte resourcecontrole: Afdwingen van granulaire CPU/GPU-limieten per model

Hybride aanpakken: Beste van beide werelden

Je bent niet beperkt tot één aanpak. Overweeg deze hybride strategieën:

Optie 1: Docker Model Runner + Traditionele Containers

Gebruik DMR voor standaardmodellen en derde partij containers voor gespecialiseerde frameworks:

# Trek een standaardmodel op met DMR

docker model pull ai/llama2

# Voer vLLM uit voor hoge doorvoerscenario’s

docker run --gpus all vllm/vllm-openai

Optie 2: Ollama in Docker

Voer Ollama uit binnen Docker-containers voor orchestrationmogelijkheden:

docker run -d \

--name ollama \

--gpus all \

-v ollama:/root/.ollama \

-p 11434:11434 \

ollama/ollama

Dit biedt:

- Ollama’s intuïtieve modelbeheer

- Docker’s orchestration en isolatiecapaciteiten

- Kubernetes-implementatie met standaardmanifesten

Optie 3: Mix en match per gebruiksscenario

- Ontwikkeling: Ollama voor snelle iteratie

- Staging: Docker Model Runner voor integratietesten

- Productie: vLLM/TGI in Kubernetes voor schaalbaarheid

API-compatibiliteit

Alle moderne oplossingen convergeren naar OpenAI-compatibele APIs, waardoor integratie eenvoudiger wordt:

Docker Model Runner API: OpenAI-compatibele eindpunten worden automatisch aangeboden wanneer modellen worden uitgevoerd. Geen extra configuratie nodig.

# Model draait met API automatisch blootgesteld

docker model run ai/llama2

# Gebruik OpenAI-compatibele eindpunt

curl http://localhost:8080/v1/chat/completions -d '{

"model": "llama2",

"messages": [{"role": "user", "content": "Waarom is de lucht blauw?"}]

}'

Ollama API: OpenAI-compatibele eindpunten maken het een directe vervanging voor toepassingen die OpenAI’s SDK gebruiken. Streaming wordt volledig ondersteund.

curl http://localhost:11434/api/generate -d '{

"model": "llama2",

"prompt": "Waarom is de lucht blauw?"

}'

Derde partij Docker APIs: vLLM en TGI bieden OpenAI-compatibele eindpunten, terwijl aangepaste containers mogelijk eigen APIs implementeren.

De convergentie naar OpenAI-compatibiliteit betekent dat je tussen oplossingen kunt wisselen met minimale codeveranderingen.

Ressourcemanagement

GPU-accelleratie

Docker Model Runner: Natieve GPU-ondersteuning zonder complexe nvidia-docker configuratie. Automatisch detecteert en gebruikt beschikbare GPUs, waardoor de Docker GPU-ervaring aanzienlijk vereenvoudigd wordt vergeleken met traditionele containers.

Als je NVIDIA GPUs gebruikt en wil dat je CUDA-accelleratie correct wordt geconfigureerd, zie dan onze gedetailleerde gids over het toevoegen van NVIDIA GPU-ondersteuning aan Docker Model Runner. Het behandelt Docker-daemonconfiguratie, NVIDIA Container Toolkit setup en hoe je kunt controleren dat je LLM daadwerkelijk GPU-geheugen gebruikt in plaats van terug te vallen op CPU-inferentie.

# GPU-accelleratie werkt automatisch

docker model run ai/llama2

Ollama: Automatische GPU-detectie op CUDA-gecapte NVIDIA GPUs. Geen configuratie nodig naast driverinstallatie.

Traditionele Docker-containers: Vereist nvidia-docker runtime en expliciete GPU-toewijzing:

docker run --gpus all my-llm-container

CPU-fallback

Beiden vallen gracieus terug op CPU-inferentie wanneer GPUs niet beschikbaar zijn, hoewel de prestaties aanzienlijk dalen (5-10x langzamer voor grote modellen). Voor inzichten in CPU-only prestaties op moderne processors, lees onze test over hoe Ollama Intel CPU-prestaties en Efficient Cores gebruikt.

Multi-GPU-ondersteuning

Ollama: Ondersteunt tensorparallelisme over meerdere GPUs voor grote modellen.

Docker: Afhankelijk van het framework. vLLM en TGI ondersteunen multi-GPU-inferentie met correcte configuratie.

Community en Ecosysteem

Docker Model Runner: Gelanceerd in april 2025 met sterke enterprise-ondersteuning. Partnerschappen met Google, Hugging Face en VMware Tanzu AI Solutions zorgen voor brede modelbeschikbaarheid. Integratie met Docks enorme ontwikkelaarsgemeenschap (miljoenen gebruikers) biedt directe ecosysteemtoegang. Nog steeds in de fase van communityspecifieke resources als nieuw product.

Ollama: Snelle groeiende gemeenschap met 50K+ GitHub sterren. Sterke integratieecosysteem (LangChain, LiteLLM, Open WebUI, CrewAI) en actieve Discord-gemeenschap. Uitgebreide derde partij tools en tutorials beschikbaar. Meer rijpe documentatie en communityresources. Voor een volledig overzicht van beschikbare interfaces, zie onze gids naar open-source chat UIs voor lokale Ollama instanties. Net als bij elke snel groeiende open-sourceproject, is het belangrijk om het projectpad te volgen - lees onze analyse van vroege tekenen van Ollama enshittification om mogelijke zorgen te begrijpen.

Derde partij Docker-oplossingen: vLLM en TGI hebben rijpe ecosystemen met enterprise-ondersteuning. Uitgebreide productiestudiecasus, optimalisatiegidsen en implementatiemodellen van Hugging Face en communitybijdragers.

Kostenoverwegingen

Docker Model Runner: Gratis met Docker Desktop (persoonlijk/educatief) of Docker Engine. Docker Desktop vereist een abonnement voor grotere organisaties (250+ medewerkers of $10M+ omzet). Modellen die worden gedistribueerd via Docker Hub volgen Docks registerprijslijst (gratis openbare opslagplaatsen, betaalde private opslagplaatsen).

Ollama: Volledig gratis en open source met geen licentiekosten ongeacht organisatiegrootte. Ressourkosten hangen alleen af van hardware.

Derde partij Docker-oplossingen: Gratis voor open source frameworks (vLLM, TGI). Mogelijke kosten voor containerorchestrationplatforms (ECS, GKE) en private registryopslag.

Beveiligingsoverwegingen

Docker Model Runner: Maakt gebruik van Docks beveiligingsmodel met containerisolatie. Modellen verpakt als OCI-artefacten kunnen worden gescand en ondertekend. Distributie via Docker Hub biedt toegangscontrole en vulnerability scanning voor enterprisegebruikers.

Ollama: Werkt als lokale service met API blootgesteld op localhost standaard. Netwerkexposure vereist expliciete configuratie. Modelregister is vertrouwd (Ollama-geselecteerd), waardoor ketenrisico’s worden verlaagd.

Traditionele Docker-oplossingen: Netwerkisolatie is ingebouwd. Containerbeveiligingschecken (Snyk, Trivy) en beeldondertekening zijn standaardpraktijken in productieomgevingen.

Alle oplossingen vereisen aandacht voor:

- Modelprovenantie: Onvertrouwde modellen kunnen bevatte malware of backdoors bevatten

- API-authenticatie: Implementeer authenticatie/autorisatie in productieimplementaties

- Rate limiting: Voorkom misbruik en resourceuitputting

- Netwerkexposure: Zorg ervoor dat APIs niet onbedoeld blootgesteld worden aan het internet

- Data privacy: Modellen verwerken gevoelige data; zorg voor naleving van databeschermingsregelgeving

Migratiepaden

Van Ollama naar Docker Model Runner

Docker Model Runner’s GGUF-ondersteuning maakt migratie eenvoudig:

- Schakel Docker Model Runner in via Docker Desktop of installeer

docker-model-plugin - Converteer modelreferenties:

ollama run llama2→docker model pull ai/llama2endocker model run ai/llama2 - Werk API-eindpunten bij van

localhost:11434naar DMR-eindpunt (meestallocalhost:8080) - Beide gebruiken OpenAI-compatibele APIs, dus toepassingscode vereist minimale wijzigingen

Van Docker Model Runner naar Ollama

Verplaatsen naar Ollama voor eenvoudiger standalone werking:

- Installeer Ollama:

curl -fsSL https://ollama.ai/install.sh | sh. Voor een volledige lijst van Ollama CLI-opdrachten en configuratieopties, verwijzen naar de Ollama CLI cheetsheet. - Trek gelijke modellen op:

ollama pull llama2 - Werk API-eindpunten bij naar Ollama’s

localhost:11434 - Test met

ollama run llama2om functionaliteit te verifiëren

Van traditionele Docker-containers naar DMR

Vereenvoudig je Docker LLM-setup:

- Schakel Docker Model Runner in

- Vervang aangepaste Dockerfiles met

docker model pullopdrachten - Verwijder nvidia-docker configuratie (DMR beheert GPU automatisch)

- Gebruik

docker model runin plaats van complexedocker runopdrachten

Van elke oplossing naar Ollama in Docker

Best-of-both-worlds aanpak:

docker pull ollama/ollama- Start:

docker run -d --gpus all -v ollama:/root/.ollama -p 11434:11434 ollama/ollama - Gebruik Ollama opdrachten zoals gewoonlijk:

docker exec -it ollama ollama pull llama2 - Verkrijg Docker orchestration met Ollama eenvoud

Monitoring en Observability

Ollama: Basismetrieken via API (/api/tags, /api/ps). Derde partij tools zoals Open WebUI bieden dashboards.

Docker: Volledige integratie met Prometheus, Grafana, ELK stack en cloud monitoringdiensten. Containermetrieken (CPU, geheugen, GPU) zijn direct beschikbaar.

Conclusie

Het landschap van lokale LLM-uitrol is aanzienlijk veranderd met Docks introductie van Docker Model Runner (DMR) in 2025. De keuze hangt nu af van je specifieke eisen:

- Voor ontwikkelaars die Docker-integratie zoeken: DMR biedt natieve Docker werkstroomintegratie met

docker modelopdrachten - Voor maximale eenvoud: Ollama blijft de eenvoudigste oplossing met zijn één-opdracht modelbeheer

- Voor productie en enterprise: Zowel DMR als derde partij oplossingen (vLLM, TGI) in Docker bieden orchestration, monitoring en schaalbaarheid

- Voor het beste van beide: Draai Ollama in Docker-containers om eenvoud te combineren met productieinfrastructuur

De introductie van DMR verkleint de kloof tussen Docker en Ollama in termen van gebruiksgemak. Ollama wint nog steeds op eenvoud voor snelle prototyping, terwijl DMR uitblinkt voor teams die al ingezet zijn op Docker-workflows. Beide aanpakken worden actief ontwikkeld, productiebereid, en het ecosysteem is rijp genoeg dat het wisselen tussen hen relatief pijnloos is.

Kort samengevat: Als je al intensief Docker gebruikt, is DMR de natuurlijke keuze. Als je de absoluut eenvoudigste ervaring wil ongeacht infrastructuur, kies dan Ollama. Voor het vergelijken van deze lokale opties met cloud-API’s en andere self-hosted opstellingen, zie onze LLM Hosting: Lokaal, Self-Hosted & Cloud Infrastructure Vergelijking gids.

Nuttige Links

Docker Model Runner

- Docker Model Runner Officiële Pagina

- Docker Model Runner Documentatie

- Docker Model Runner Startgids

- Docker Model Runner Blogpost over introductie