Docker Model Runner vs Ollama (2026) : lequel est meilleur pour les LLM locaux ?

Comparez Docker Model Runner et Ollama pour un LLM local

Exécuter des grands modèles de langage (LLMs) localement a de plus en plus de popularité pour la confidentialité, le contrôle des coûts et les capacités hors ligne. Le paysage s’est considérablement transformé en avril 2025 lorsque Docker a introduit Docker Model Runner (DMR), sa solution officielle pour le déploiement de modèles d’IA.

Maintenant, trois approches rivalisent pour la part de marché des développeurs : le Model Runner natif de Docker, les solutions conteneurisées tierces (vLLM, TGI) et la plateforme autonome Ollama.

Pour une vue plus large qui inclut les fournisseurs de nuage et les compromis en matière d’infrastructure, consultez LLM Hosting : Comparaison des infrastructures locales, auto-hébergées et en nuage.

TL;DR – Docker Model Runner vs Ollama

Cette comparaison se concentre sur l’exécution de grands modèles de langage (LLMs) localement à l’aide de Docker ou de runtimes autonomes, couvrant la performance, le support GPU, la compatibilité API et les scénarios de déploiement en production.

- Meilleur pour les workflows natifs Docker : Docker Model Runner

- Meilleur pour la simplicité et la prototypage rapide : Ollama

- Meilleur pour Kubernetes & orchestration : les configurations basées sur Docker

- Meilleur pour le développement sur une seule machine : Ollama

Si vous utilisez déjà Docker de manière intensive, DMR a un sens.

Si vous souhaitez la manière la plus rapide d’exécuter des LLMs localement, Ollama est plus simple.

Si vous comparez plus que simplement Docker Model Runner et Ollama, consultez notre analyse complète de Ollama vs vLLM vs LM Studio et autres outils locaux pour les LLM. Ce guide compare la maturité de l’API, le support matériel, l’appel d’outils et la prête à la production sur 12+ runtimes locaux pour les LLM.

Comparaison directe entre Docker Model Runner et Ollama

Avec l’entrée officielle de Docker dans l’espace des runtimes LLM, la comparaison devient plus intéressante. Voici comment DMR et Ollama se comparent directement :

| Fonction | Docker Model Runner | Ollama |

|---|---|---|

| Installation | Onglet AI de Docker Desktop ou docker-model-plugin |

Une seule commande : curl | sh |

| Style de commande | docker model pull/run/package |

ollama pull/run/list |

| Format de modèle | GGUF (OCI Artifacts) | GGUF (natif) |

| Distribution de modèles | Docker Hub, registres OCI | Registre Ollama |

| Configuration GPU | Automatique (plus simple que le Docker traditionnel) | Automatique |

| API | Compatible OpenAI | Compatible OpenAI |

| Intégration Docker | Native (est Docker) | Exécuté en Docker si nécessaire |

| Support Compose | Native | Via l’image Docker |

| Courbe d’apprentissage | Faible (pour les utilisateurs Docker) | La plus faible (pour tout le monde) |

| Partenaires de l’écosystème | Google, Hugging Face, VMware | LangChain, CrewAI, Open WebUI |

| Meilleur pour | Workflows natifs Docker | Simplicité autonome |

Insight clé : DMR apporte les workflows Docker à l’hébergement des modèles d’IA, tandis qu’Ollama reste indépendant des cadres avec une opération autonome plus simple. Votre infrastructure existante compte plus que les différences techniques.

Docker Model Runner est-il meilleur qu’Ollama ?

Cela dépend de votre workflow.

- Choisissez Docker Model Runner (DMR) si votre équipe utilise déjà intensivement Docker, les artefacts OCI et l’orchestration conteneurisée.

- Choisissez Ollama si vous souhaitez la manière la plus simple d’exécuter des LLMs localement avec un minimum de configuration et un prototypage rapide.

Pour la plupart des configurations sur une seule machine, Ollama est plus facile à utiliser.

Pour les pipelines CI/CD natifs Docker et les workflows conteneurisés en entreprise, DMR s’intègre plus naturellement.

Comment exécuter un LLM en Docker : DMR vs Ollama

Si votre objectif est simplement d’exécuter un LLM à l’intérieur de Docker, à la fois Docker Model Runner et Ollama dans des conteneurs Docker peuvent atteindre cet objectif.

Docker Model Runner utilise les commandes natives docker model pull et docker model run, empaquetant les modèles en tant qu’artefacts OCI.

Ollama peut également s’exécuter dans Docker en utilisant l’image conteneur officielle ollama/ollama, exposant une API compatible OpenAI sur le port 11434.

La différence clé réside dans l’intégration du workflow :

- DMR s’intègre naturellement dans les pipelines CI/CD natifs Docker.

- Ollama dans Docker offre une gestion simplifiée des modèles avec une flexibilité d’orchestration Docker.

Comprendre les runners de modèles Docker

Les runners de modèles basés sur Docker utilisent la conteneurisation pour empaqueter les moteurs d’inférence LLM avec leurs dépendances. Le paysage inclut à la fois la solution officielle de Docker et les cadres tiers.

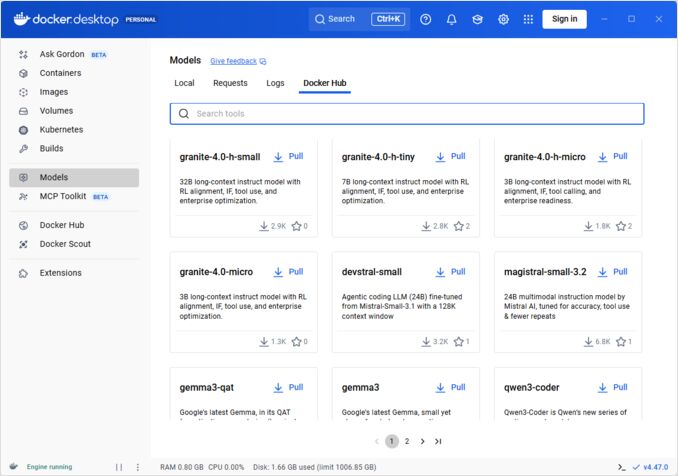

Docker Model Runner (DMR) - Solution officielle

En avril 2025, Docker a introduit Docker Model Runner (DMR), un produit officiel conçu pour simplifier l’exécution de modèles d’IA localement à l’aide de l’infrastructure Docker. Cela représente l’engagement de Docker à rendre le déploiement de modèles d’IA aussi fluide que le déploiement de conteneurs.

Fonctionnalités clés de DMR :

- Intégration native Docker : Utilise les commandes familières Docker (

docker model pull,docker model run,docker model package) - Empaquetage en tant qu’artefacts OCI : Les modèles sont empaquetés en tant qu’artefacts OCI, permettant leur distribution via Docker Hub et d’autres registres

- API compatible OpenAI : Remplacement direct des points de terminaison OpenAI, simplifiant l’intégration

- Accélération GPU : Support natif GPU sans configuration complexe nvidia-docker

- Support du format GGUF : Fonctionne avec les formats de modèles quantifiés populaires

- Intégration Docker Compose : Configurez et déployez facilement des modèles à l’aide des outils Docker standard

- Support Testcontainers : S’intègre naturellement avec les cadres de test

Installation :

- Docker Desktop : Activer via l’onglet AI dans les paramètres

- Docker Engine : Installer le package

docker-model-plugin

Exemple d’utilisation :

# Télécharger un modèle depuis Docker Hub

docker model pull ai/smollm2

# Exécuter une inférence

docker model run ai/smollm2 "Expliquez Docker Model Runner"

# Empaqueter un modèle personnalisé

docker model package --gguf /chemin/vers/model.gguf --push myorg/mymodel:latest

Pour une référence complète des commandes docker model, des options d’empaquetage, des drapeaux de configuration et des exemples pratiques, consultez notre guide détaillé Docker Model Runner Cheatsheet : Commandes et exemples. Il couvre le téléchargement de modèles, l’empaquetage, la configuration et les bonnes pratiques pour déployer des LLM localement avec Docker.

DMR collabore avec Google, Hugging Face et VMware Tanzu pour élargir l’écosystème de modèles d’IA disponible via Docker Hub. Si vous êtes nouveau dans Docker ou avez besoin d’un rappel sur les commandes Docker, notre Docker Cheatsheet fournit un guide complet sur les opérations Docker essentielles.

Solutions Docker tierces

Au-delà de DMR, l’écosystème inclut des cadres établis :

- Conteneurs vLLM : Serveur d’inférence à haute capacité de traitement optimisé pour le traitement par lots

- Text Generation Inference (TGI) : Solution de production de Hugging Face

- Conteneurs llama.cpp : Implémentation légère en C++ avec quantification

- Conteneurs personnalisés : Emboîtement de PyTorch, Transformers ou de cadres propriétaires

Avantages de l’approche Docker

Flexibilité et indépendance par rapport aux cadres : Les conteneurs Docker peuvent exécuter tout framework LLM, de PyTorch à ONNX Runtime, donnant aux développeurs un contrôle complet sur la pile d’inférence.

Isolation des ressources : Chaque conteneur fonctionne dans un environnement isolé avec des limites de ressources définies (CPU, mémoire, GPU), empêchant les conflits de ressources dans les déploiements à plusieurs modèles.

Support d’orchestration : Docker s’intègre naturellement avec Kubernetes, Docker Swarm et les plateformes cloud pour l’échelle, le balancement de charge et la haute disponibilité.

Contrôle de version : Différentes versions de modèles ou de cadres peuvent coexister sur le même système sans conflits de dépendances.

Inconvénients de l’approche Docker

Complexité : Exige la compréhension de la conteneurisation, des montages de volumes, de la configuration réseau et du passage GPU (nvidia-docker).

Surcharge : Bien que minimale, Docker ajoute une couche d’abstraction légère qui affecte légèrement le temps de démarrage et l’utilisation des ressources.

Charge de configuration : Chaque déploiement nécessite une configuration soigneuse des Dockerfiles, des variables d’environnement et des paramètres de runtime.

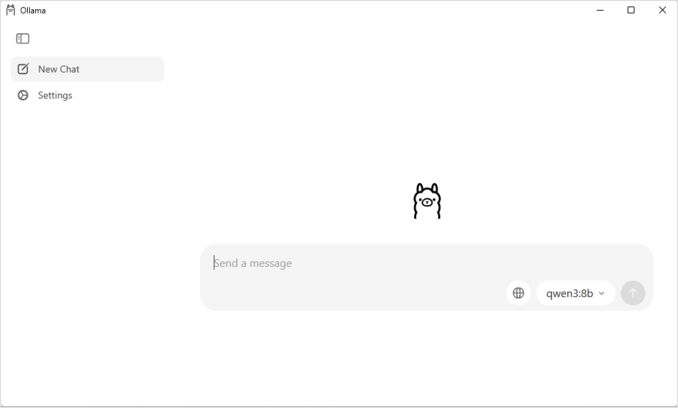

Comprendre Ollama

Ollama est une application conçue spécifiquement pour exécuter des LLM localement, conçue avec la simplicité comme principe central. Il fournit :

- Binaire natif pour Linux, macOS et Windows

- Bibliothèque de modèles intégrée avec une installation en une seule commande

- Détection automatique et optimisation GPU

- API RESTful compatible avec le format OpenAI

- Gestion du contexte et de l’état des modèles

Avantages d’Ollama

Simplicité : L’installation est directe (curl | sh sur Linux), et l’exécution de modèles nécessite simplement ollama run llama2. Pour une référence complète des commandes CLI Ollama telles que ollama serve, ollama run, ollama ps et les workflows de gestion des modèles, consultez notre Ollama CLI Cheatsheet.

Performance optimisée : Construit sur llama.cpp, Ollama est hautement optimisé pour la vitesse d’inférence avec le support de quantification (Q4, Q5, Q8).

Gestion des modèles : Registre de modèles intégré avec des commandes comme ollama pull, ollama list et ollama rm simplifiant le cycle de vie des modèles.

Expérience du développeur : API propre, documentation extensive et écosystème croissant d’intégrations (LangChain, CrewAI, etc.). La polyvalence d’Ollama s’étend à des cas d’utilisation spécialisés comme le classement des documents textuels avec des modèles d’embedding.

Efficacité des ressources : Gestion automatique de la mémoire et déchargement des modèles lors de l’inactivité pour économiser les ressources système.

Inconvénients d’Ollama

Verrouillage de framework : Principalement supporte les modèles compatibles avec llama.cpp, limitant la flexibilité pour les frameworks comme vLLM ou les moteurs d’inférence personnalisés.

Limitation de personnalisation : Les configurations avancées (quantification personnalisée, flux CUDA spécifiques) sont moins accessibles que dans les environnements Docker.

Défis d’orchestration : Bien qu’Ollama puisse s’exécuter dans des conteneurs, il manque d’un support natif pour des fonctionnalités d’orchestration avancées comme le scaling horizontal.

Comparaison de performance

Vitesse d’inférence

Docker Model Runner : Performance comparable à Ollama car les deux supportent les modèles quantifiés GGUF. Pour Llama 2 7B (Q4), prévoyez 20-30 tokens/seconde sur CPU et 50-80 tokens/seconde sur des GPU de milieu de gamme. Surcharge conteneur minimale.

Ollama : Utilise un backend hautement optimisé llama.cpp avec une quantification efficace. Pour Llama 2 7B (Q4), prévoyez 20-30 tokens/seconde sur CPU et 50-80 tokens/seconde sur des GPU de milieu de gamme. Aucune surcharge conteneur. Pour des détails sur la manière dont Ollama gère les demandes parallèles, consultez notre analyse sur comment Ollama gère les demandes parallèles.

Docker (vLLM) : Optimisé pour le traitement par lots avec le batch continu. Les demandes individuelles peuvent être légèrement plus lentes, mais le débit excelle sous charge élevée (100+ tokens/seconde par modèle avec le batch).

Docker (TGI) : Similaire à vLLM avec une excellente performance de batch. Ajoute des fonctionnalités comme le streaming et la génération token par token.

Utilisation de la mémoire

Docker Model Runner : Similaire à Ollama avec un chargement automatique des modèles. Les modèles GGUF Q4 utilisent généralement 4-6 Go de RAM. La surcharge conteneur est minimale (des dizaines de Mo).

La configuration de la taille du contexte peut avoir un impact significatif sur l’utilisation de la mémoire et le comportement du modèle. Par défaut, certains images Docker Model Runner CUDA fixent un limite de 4096 tokens, même si des valeurs plus élevées sont spécifiées dans docker-compose. Pour des étapes détaillées sur la manière de remplacer ce comportement et d’empaqueter des modèles avec des tailles de contexte personnalisées, consultez notre guide sur la configuration de la taille du contexte dans Docker Model Runner.

Ollama : Gestion automatique de la mémoire charge les modèles sur demande et les décharge lors de l’inactivité. Un modèle 7B Q4 utilise généralement 4-6 Go de RAM. Le plus efficace pour les scénarios à un seul modèle.

Solutions Docker traditionnelles : La mémoire dépend du framework. vLLM alloue préalablement la mémoire GPU pour une performance optimale, tandis que les conteneurs basés sur PyTorch peuvent utiliser plus de RAM pour les poids du modèle et le cache KV (8-14 Go pour les modèles 7B).

Temps de démarrage

Docker Model Runner : Le démarrage du conteneur ajoute ~1 seconde, plus le temps de chargement du modèle (2-5 secondes). Total : 3-6 secondes pour les modèles moyens.

Ollama : Démarrage quasi instantané avec le chargement du modèle prenant 2-5 secondes pour les modèles moyens. L’expérience de démarrage froide la plus rapide.

Docker traditionnel : Le démarrage du conteneur ajoute 1-3 secondes, plus le temps de chargement du modèle. Le préchauffage des conteneurs atténue cela dans les déploiements en production.

Recommandations pour les cas d’utilisation

Choisissez Docker Model Runner quand

- Workflow Docker-first : Votre équipe utilise déjà intensivement Docker

- Outils unifiés : Vous souhaitez un seul outil (Docker) pour les conteneurs et les modèles

- Distribution d’artefacts OCI : Vous avez besoin d’une intégration avec les registres d’entreprise

- Intégration Testcontainers : Vous testez les fonctionnalités d’IA dans les pipelines CI/CD

- Préférence pour Docker Hub : Vous souhaitez distribuer les modèles via des canaux familiers

Choisissez Ollama quand

- Prototypage rapide : Expérimentation rapide avec différents modèles

- Indépendance par rapport aux cadres : Non lié à l’écosystème Docker

- Simplicité absolue : Configuration et maintenance minimales

- Déploiements sur une seule machine : Exécution sur des ordinateurs portables, des stations de travail ou des VM uniques

- Grande bibliothèque de modèles : Accès à une bibliothèque de modèles préconfigurés étendue

Choisissez les solutions Docker tierces quand

- Déploiements en production : Besoin d’orchestration et de surveillance avancés

- Serving multi-modèles : Exécution simultanée de différents cadres (vLLM, TGI)

- Orchestration Kubernetes : Échelle sur des clusters avec équilibrage de charge

- Cadres personnalisés : Utilisation de Ray Serve ou de moteurs d’inférence propriétaires

- Contrôle strict des ressources : Application de limites granulaires CPU/GPU par modèle

Approches hybrides : Le meilleur des deux mondes

Vous n’êtes pas limité à une seule approche. Considérez ces stratégies hybrides :

Option 1 : Docker Model Runner + Conteneurs traditionnels

Utilisez DMR pour les modèles standard et des conteneurs tiers pour les cadres spécialisés :

# Télécharger un modèle standard avec DMR

docker model pull ai/llama2

# Exécuter vLLM pour les scénarios à haute capacité

docker run --gpus all vllm/vllm-openai

Option 2 : Ollama dans Docker

Exécutez Ollama dans des conteneurs Docker pour les capacités d’orchestration :

docker run -d \

--name ollama \

--gpus all \

-v ollama:/root/.ollama \

-p 11434:11434 \

ollama/ollama

Cela fournit :

- La gestion intuitive des modèles d’Ollama

- Les capacités d’orchestration et d’isolation de Docker

- Déploiement Kubernetes avec des manifestes standards

Option 3 : Mélange et adaptez selon les cas d’utilisation

- Développement : Ollama pour l’itération rapide

- Environnement de test : Docker Model Runner pour les tests d’intégration

- Production : vLLM/TGI dans Kubernetes pour l’échelle

Compatibilité API

Toutes les solutions modernes convergent vers des API compatibles OpenAI, simplifiant l’intégration :

API Docker Model Runner : Points de terminaison compatibles OpenAI fournis automatiquement lors de l’exécution des modèles. Aucune configuration supplémentaire nécessaire.

# Le modèle s'exécute avec l'API exposée automatiquement

docker model run ai/llama2

# Utilisez le point de terminaison compatible OpenAI

curl http://localhost:8080/v1/chat/completions -d '{

"model": "llama2",

"messages": [{"role": "user", "content": "Pourquoi le ciel est-il bleu ?"}]

}'

API Ollama : Points de terminaison compatibles OpenAI rendant Ollama un remplacement direct pour les applications utilisant le SDK OpenAI. Le streaming est pleinement pris en charge.

curl http://localhost:11434/api/generate -d '{

"model": "llama2",

"prompt": "Pourquoi le ciel est-il bleu ?"

}'

API Docker tierces : vLLM et TGI offrent des points de terminaison compatibles OpenAI, tandis que les conteneurs personnalisés peuvent implémenter des API propriétaires.

La convergence sur la compatibilité OpenAI signifie que vous pouvez passer d’une solution à une autre avec des changements de code minimaux.

Gestion des ressources

Accélération GPU

Docker Model Runner : Support GPU natif sans configuration complexe nvidia-docker. Détecte et utilise automatiquement les GPU disponibles, simplifiant considérablement l’expérience GPU de Docker par rapport aux conteneurs traditionnels.

Si vous utilisez des GPU NVIDIA et souhaitez configurer correctement l’accélération CUDA, consultez notre guide détaillé sur l’ajout du support GPU NVIDIA à Docker Model Runner. Il couvre la configuration du démon Docker, l’installation de l’outil NVIDIA Container Toolkit et la vérification que votre LLM utilise bien la mémoire GPU au lieu de recourir à l’inférence CPU.

# L'accélération GPU fonctionne automatiquement

docker model run ai/llama2

Ollama : Détection automatique du GPU sur les GPU NVIDIA compatibles CUDA. Aucune configuration nécessaire au-delà de l’installation du pilote.

Conteneurs Docker traditionnels : Requiert le runtime nvidia-docker et l’allocation explicite des GPU :

docker run --gpus all my-llm-container

Fallback CPU

Les deux basculent naturellement vers l’inférence CPU lorsqu’aucun GPU n’est disponible, bien que la performance diminue considérablement (5-10 fois plus lente pour les grands modèles). Pour des informations sur les performances CPU uniquement sur les processeurs modernes, lisez notre test sur comment Ollama utilise les performances du processeur Intel et les cœurs efficaces.

Support multi-GPU

Ollama : Supporte la parallélisation tensorielle sur plusieurs GPU pour les grands modèles.

Docker : Dépend du framework. vLLM et TGI supportent l’inférence multi-GPU avec une configuration appropriée.

Communauté et écosystème

Docker Model Runner : Lancé en avril 2025 avec un fort soutien d’entreprise. Les partenariats avec Google, Hugging Face et VMware Tanzu AI Solutions assurent une large disponibilité des modèles. L’intégration avec la communauté développeur massive de Docker (des millions d’utilisateurs) fournit un accès immédiat à l’écosystème. Encore en construction des ressources spécifiques à la communauté comme un nouveau produit.

Ollama : Communauté en croissance rapide avec plus de 50 000 étoiles sur GitHub. Écosystème d’intégration fort (LangChain, LiteLLM, Open WebUI, CrewAI) et communauté active sur Discord. Outils tiers et tutoriels extensifs disponibles. Documentation et ressources communautaires plus matures. Pour une vue d’ensemble complète des interfaces disponibles, consultez notre guide sur les interfaces UI open-source pour les instances locales Ollama. Comme avec tout projet open-source en croissance rapide, il est important de surveiller la direction du projet - lisez notre analyse des premiers signes d’enshittification d’Ollama pour comprendre les préoccupations potentielles.

Solutions Docker tierces : vLLM et TGI ont des écosystèmes matures avec un soutien d’entreprise. Des études de cas de production, des guides d’optimisation et des modèles de déploiement de Hugging Face et des contributeurs de la communauté.

Considérations de coût

Docker Model Runner : Gratuit avec Docker Desktop (personnel/éducationnel) ou Docker Engine. Docker Desktop nécessite une abonnement pour les grandes organisations (250+ employés ou 10 M$+ de revenus). Les modèles distribués via Docker Hub suivent les prix du registre Docker (répertoires publics gratuits, répertoires privés payants).

Ollama : Totalement gratuit et open-source sans coûts de licence, indépendamment de la taille de l’organisation. Les coûts de ressources dépendent uniquement du matériel.

Solutions Docker tierces : Gratuit pour les frameworks open-source (vLLM, TGI). Coûts potentiels pour les plateformes d’orchestration conteneur (ECS, GKE) et le stockage des registres privés.

Considérations de sécurité

Docker Model Runner : Utilise le modèle de sécurité Docker avec l’isolation des conteneurs. Les modèles empaquetés en tant qu’artefacts OCI peuvent être analysés et signés. La distribution via Docker Hub permet le contrôle d’accès et l’analyse des vulnérabilités pour les utilisateurs d’entreprise.

Ollama : S’exécute en tant que service local avec l’API exposée sur localhost par défaut. L’exposition réseau nécessite une configuration explicite. Le registre de modèles est fiable (curé par Ollama), réduisant les risques de chaîne d’approvisionnement.

Solutions Docker traditionnelles : L’isolation réseau est intégrée. L’analyse de sécurité des conteneurs (Snyk, Trivy) et la signature des images sont des pratiques standard dans les environnements de production.

Toutes les solutions nécessitent l’attention à :

- Origine des modèles : Les modèles non fiables peuvent contenir du code malveillant ou des backdoors

- Authentification API : Implémenter l’authentification/autorisation dans les déploiements en production

- Limitation de débit : Empêcher l’abus et l’épuisement des ressources

- Exposition réseau : Assurer que les API ne sont pas accidentellement exposées à l’internet

- Protection des données : Les modèles traitent des données sensibles ; assurez-vous de la conformité aux réglementations de protection des données

Chemins de migration

De Ollama vers Docker Model Runner

Le support GGUF de Docker Model Runner rend la migration simple :

- Activer Docker Model Runner dans Docker Desktop ou installer

docker-model-plugin - Convertir les références de modèles :

ollama run llama2→docker model pull ai/llama2etdocker model run ai/llama2 - Mettre à jour les points de terminaison API de

localhost:11434vers le point de terminaison DMR (généralementlocalhost:8080) - Les deux utilisent des APIs compatibles OpenAI, donc le code d’application nécessite des changements minimaux

De Docker Model Runner vers Ollama

Passer à Ollama pour une opération autonome plus simple :

- Installer Ollama :

curl -fsSL https://ollama.ai/install.sh | sh. Pour une liste complète des commandes CLI Ollama et des options de configuration, consultez le Ollama CLI cheatsheet. - Télécharger les modèles équivalents :

ollama pull llama2 - Mettre à jour les points de terminaison API vers

localhost:11434d’Ollama - Tester avec

ollama run llama2pour vérifier la fonctionnalité

De conteneurs Docker traditionnels vers DMR

Simplifiez votre configuration LLM Docker :

- Activer Docker Model Runner

- Remplacer les Dockerfiles personnalisés par des commandes

docker model pull - Supprimer la configuration nvidia-docker (DMR gère le GPU automatiquement)

- Utiliser

docker model runau lieu de commandesdocker runcomplexes

De toute solution vers Ollama dans Docker

Approche combinant les deux :

docker pull ollama/ollama- Exécuter :

docker run -d --gpus all -v ollama:/root/.ollama -p 11434:11434 ollama/ollama - Utiliser les commandes Ollama comme d’habitude :

docker exec -it ollama ollama pull llama2 - Obtenir l’orchestration Docker avec la simplicité d’Ollama

Surveillance et observabilité

Ollama : Métriques basiques via l’API (/api/tags, /api/ps). Les outils tiers comme Open WebUI fournissent des tableaux de bord.

Docker : Intégration complète avec Prometheus, Grafana, le stack ELK et les services de surveillance en nuage. Les métriques conteneur (CPU, mémoire, GPU) sont facilement disponibles.

Conclusion

Le paysage du déploiement local des LLM a considérablement évolué avec l’introduction par Docker de Docker Model Runner (DMR) en 2025. Le choix dépend maintenant de vos besoins spécifiques :

- Pour les développeurs cherchant une intégration Docker : DMR fournit une intégration native des workflows Docker avec les commandes

docker model - Pour la simplicité maximale : Ollama reste la solution la plus simple avec sa gestion des modèles en une seule commande

- Pour la production et l’entreprise : À la fois DMR et les solutions tierces (vLLM, TGI) dans Docker offrent l’orchestration, la surveillance et l’échelle

- Pour le meilleur des deux mondes : Exécuter Ollama dans des conteneurs Docker pour combiner la simplicité avec l’infrastructure de production

L’introduction de DMR réduit l’écart entre Docker et Ollama en termes d’ease of use. Ollama gagne sur la simplicité pour le prototypage rapide, tandis que DMR excelle pour les équipes déjà investies dans les workflows Docker. Les deux approches sont activement développées, prêtes à la production et l’écosystème est assez mature pour que le passage entre elles soit relativement indolore.

En résumé : Si vous utilisez déjà Docker de manière intensive, DMR est le choix naturel. Si vous souhaitez l’expérience la plus simple possible, indépendamment de l’infrastructure, choisissez Ollama. Pour comparer ces options locales avec les API en nuage et d’autres configurations auto-hébergées, consultez notre guide LLM Hosting : Comparaison des infrastructures locales, auto-hébergées et en nuage.

Liens utiles

Docker Model Runner

- Page officielle de Docker Model Runner

- Documentation Docker Model Runner

- Guide de démarrage Docker Model Runner

- Blog de l’annonce Docker Model Runner

Ollama

Autres solutions Docker

- Documentation vLLM

- Text Generation Inference de Hugging Face

- GitHub llama.cpp

- Outil NVIDIA Container Toolkit