Interfaces de chat pour les instances locales d'Ollama

Aperçu rapide des interfaces utilisateur les plus remarquables pour Ollama en 2025

L’hébergement local de Ollama permet d’exécuter des modèles de langage volumineux sur votre propre machine, mais son utilisation via la ligne de commande n’est pas très conviviale.

Voici plusieurs projets open source qui proposent des interfaces du style ChatGPT qui se connectent à un Ollama local.

Ces interfaces utilisateur prennent en charge la chat conversationnel, souvent avec des fonctionnalités comme le téléchargement de documents pour la génération augmentée par le recueil (RAG), et s’exécutent en tant qu’applications web ou de bureau. Voici une comparaison des principales options, suivie de sections détaillées sur chacune.

Comparaison des interfaces utilisateur compatibles avec Ollama

| Outil d’interface | Plateforme | Support des documents | Intégration avec Ollama | Points forts | Limitations |

|---|---|---|---|---|---|

| Page Assist | Extension de navigateur (Chrome, Firefox) | Oui – ajouter des fichiers pour l’analyse | Se connecte à Ollama local via la configuration de l’extension | Chat en navigateur ; gestion facile des modèles et intégration du contexte de la page web. | Uniquement en navigateur ; nécessite l’installation et la configuration d’une extension. |

| Open WebUI | Application web (auto-hébergée ; Docker/PWA) | Oui – RAG intégré (télécharger des documents ou les ajouter à la bibliothèque) | Support direct de l’API Ollama ou serveur empaqueté (configurer l’URL de base) | Fonctionnalités riches (multi-LLM, hors ligne, génération d’images) ; mobile-friendly (PWA). | Configuration plus lourde (Docker/K8s) ; portée large peut être trop complexe pour une utilisation simple. |

| LobeChat | Application web (auto-hébergée ; PWA support) | Oui – « Base de connaissances » avec téléchargement de fichiers (PDF, images, etc.) | Supporte Ollama comme un des multiples backends AI (nécessite l’activation de l’API d’Ollama) | Interface UI élégante du style ChatGPT ; chat vocal, plugins et support multi-modèles. | Ensemble de fonctionnalités complexe ; nécessite la configuration de l’environnement (ex. : croisement d’origine pour Ollama). |

| LibreChat | Application web (auto-hébergée ; multi-utilisateur) | Oui – « Chat avec des fichiers » via RAG (via les embeddings) | Compatibilité avec Ollama et de nombreux autres fournisseurs (changeable par chat) | Interface familière du style ChatGPT ; fonctionnalités riches (agents, interpréteur de code, etc.). | Installation/configuration peut être complexe ; projet important peut être plus que nécessaire pour une utilisation basique. |

| AnythingLLM | Application de bureau (Windows, Mac, Linux) ou web (Docker) | Oui – RAG intégré : glisser-déposer des documents (PDF, DOCX, etc.) avec citations | Ollama supporté comme fournisseur LLM (configurer dans les paramètres ou Docker env) | Interface UI tout-en-un (ChatGPT privé avec vos documents) ; générateur d’agents sans code, support multi-utilisateurs. | Utilisation des ressources plus élevée (base de données d’embeddings, etc.) ; l’application de bureau manque certaines fonctionnalités multi-utilisateurs. |

| Chat-with-Notes | Application web (serveur Flask léger) | Oui – télécharger des fichiers texte/PDF et chatter avec leur contenu | Utilise Ollama pour toutes les réponses AI (nécessite que Ollama soit exécuté localement) | Très simple à configurer et interface axée sur les questions/réponses de documents ; les données restent locales. | Interface et fonctionnalités basiques ; mono-utilisateur, un seul document à la fois (pas de fonctionnalités avancées). |

Chacun de ces outils est activement maintenu et open source. Ensuite, nous plongeons dans les détails de chaque option, y compris la manière dont elles fonctionnent avec Ollama, les fonctionnalités notables et les compromis.

Page Assist (Extension de navigateur)

Page Assist est une extension de navigateur open source qui apporte un chat local LLM à votre navigateur. Elle prend en charge les navigateurs basés sur Chromium et Firefox, offrant un onglet ou une barre latérale du style ChatGPT où vous pouvez converser avec un modèle. Page Assist peut se connecter à Ollama exécuté localement comme fournisseur d’IA, ou à d’autres backends locaux, via ses paramètres. Notamment, elle vous permet d’ajouter des fichiers (ex. PDF ou texte) pour que l’IA les analyse dans le chat, permettant ainsi des workflows RAG basiques. Vous pouvez même l’utiliser pour aider au contenu de la page web actuelle ou effectuer des recherches sur Internet.

L’installation est simple : installez l’extension depuis le Chrome Web Store ou Firefox Add-ons, assurez-vous que Ollama est en cours d’exécution, et sélectionnez Ollama comme fournisseur d’IA local dans les paramètres de Page Assist. L’interface inclut des fonctionnalités comme l’historique des chats, la sélection du modèle et une URL partageable optionnelle pour vos résultats de chat. Une interface web est également disponible via un raccourci clavier si vous préférez une expérience de chat en onglet complet.

Points forts : Page Assist est léger et pratique – puisqu’elle vit dans le navigateur, il n’y a aucun serveur à exécuter séparément. Elle est idéale pour le contexte de navigation (vous pouvez l’ouvrir sur n’importe quelle page web) et prend en charge l’intégration de la recherche Internet et les pièces jointes pour enrichir la conversation. Elle propose également des fonctionnalités pratiques comme des raccourcis clavier pour un nouveau chat et pour basculer la barre latérale.

Limitations : Étant une extension, elle est limitée à un environnement de navigateur. L’interface est plus simple et quelque peu moins riche en fonctionnalités que les applications de chat autonomes. Par exemple, la gestion multi-utilisateurs ou les plugins d’agents avancés ne sont pas dans la portée. De plus, l’installation initiale peut nécessiter de construire/charger l’extension si une version préemballée n’est pas disponible pour votre navigateur (le projet fournit des instructions de construction avec Bun ou npm). En résumé, Page Assist est idéale pour une utilisation individuelle lorsque vous souhaitez accéder rapidement à un chat alimenté par Ollama pendant la navigation web, avec des capacités RAG modérées.

Open WebUI (Application web auto-hébergée)

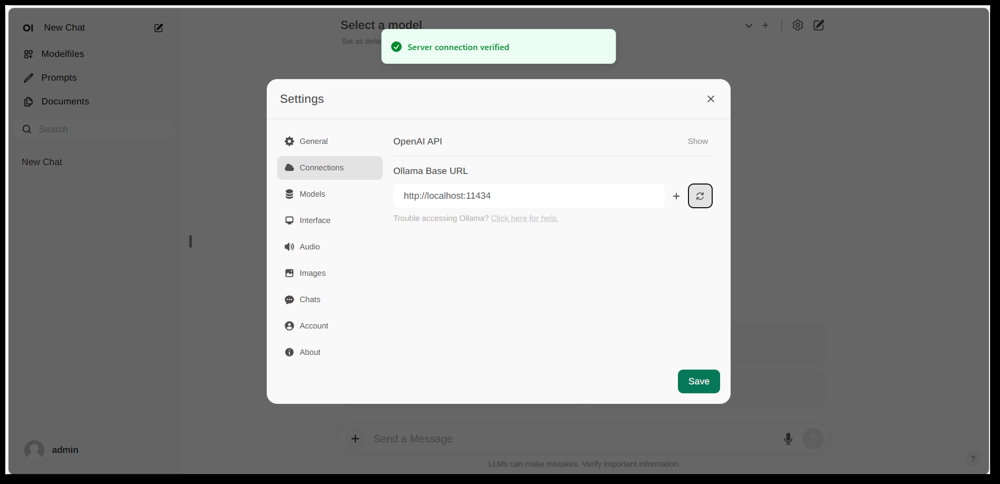

Interface des paramètres d’Open WebUI, montrant une connexion Ollama configurée (URL de base définie sur l’API locale d’Ollama). L’interface inclut une section Documents, permettant des workflows RAG.

Open WebUI est une interface de chat puissante et polyvalente, initialement créée pour travailler avec Ollama, et maintenant étendue pour supporter divers backends LLM. Elle s’exécute comme une application web auto-hébergée et est généralement déployée via Docker ou Kubernetes pour faciliter l’installation. Une fois en cours d’exécution, vous y accédez via votre navigateur (avec le support d’installation en tant qu’Application Web Progressive sur les appareils mobiles).

Open WebUI propose une interface de chat complète avec support multi-utilisateurs, gestion des modèles et fonctionnalités étendues. Critiquement, elle dispose de capacités RAG intégrées – vous pouvez télécharger ou importer des documents dans une bibliothèque de documents et ensuite poser des questions avec augmentation de recueil. L’interface permet de charger directement des documents dans une session de chat ou de maintenir une bibliothèque persistante de connaissances. Elle prend même en charge l’exécution de recherches web et l’injection des résultats dans la conversation pour des informations à jour.

Intégration avec Ollama : Open WebUI se connecte à Ollama via son API. Vous pouvez soit exécuter le conteneur Docker d’Open WebUI à côté d’un serveur Ollama et définir une variable d’environnement pour pointer vers l’URL d’Ollama, soit utiliser une image Docker spéciale qui emballera Ollama avec l’interface web. En pratique, après avoir lancé les conteneurs, vous visiterez Open WebUI dans votre navigateur et verrez le message « Connexion serveur vérifiée » si la configuration est correcte (comme indiqué dans l’image ci-dessus). Cela signifie que l’interface est prête à utiliser vos modèles Ollama locaux pour le chat. Open WebUI prend également en charge les points de terminaison compatibles avec l’API OpenAI, donc il peut s’interfacer avec LM Studio, OpenRouter, etc., en plus d’Ollama.

Points forts : Cette solution est l’une des plus riches en fonctionnalités et flexibles. Elle prend en charge plusieurs modèles simultanés et threads de conversation, des « personnages » ou prompts système personnalisés, la génération d’images, etc. L’implémentation RAG est robuste – vous obtenez une interface complète pour gérer les documents et même configurer quel magasin de vecteurs ou service de recherche utiliser pour le recueil. Open WebUI est également activement développé (avec une communauté étendue, comme indiqué par son nombre élevé d’étoiles sur GitHub) et conçu pour l’extensibilité et l’échelle. C’est un bon choix si vous souhaitez une interface de chat complète pour des modèles locaux, surtout dans un scénario avec plusieurs utilisateurs ou des cas d’utilisation complexes.

Limitations : Avec de grandes capacités vient une complexité accrue. Open WebUI peut être trop lourd pour une utilisation personnelle simple – déployer des conteneurs Docker et gérer la configuration peut être intimidant si vous n’êtes pas familiarisé. Il consomme plus de ressources qu’une application légère, car il exécute un serveur web, une base de données optionnelle pour l’historique des chats, etc. De plus, des fonctionnalités comme le contrôle d’accès basé sur les rôles et la gestion des utilisateurs, bien qu’utiles, indiquent qu’elle est orientée vers une configuration serveur – un seul utilisateur à un PC domestique n’aurait peut-être pas besoin de tout cela. En bref, l’installation est plus lourde et l’interface peut sembler complexe si vous avez besoin d’une copie simple de ChatGPT. Mais pour ceux qui ont besoin de sa large gamme de fonctionnalités (ou veulent facilement basculer entre Ollama et d’autres fournisseurs de modèles dans une seule interface), Open WebUI est un candidat de premier plan.

LobeChat (Cadre de chat du style ChatGPT avec plugins)

Bannière de l’interface de LobeChat montrant « Ollama Supporté » et plusieurs modèles locaux. LobeChat vous permet de déployer une application web élégante du style ChatGPT en utilisant Ollama ou d’autres fournisseurs, avec des fonctionnalités comme l’entrée vocale et les plugins.

LobeChat est un cadre de chat open source qui met l’accent sur une expérience utilisateur polie et une flexibilité. C’est essentiellement une application web du style ChatGPT que vous pouvez auto-héberger, avec un support pour plusieurs fournisseurs d’IA – des modèles d’OpenAI et Anthropic aux modèles open source via Ollama. LobeChat est conçu avec la confidentialité à l’esprit (vous l’exécutez vous-même) et a une interface moderne qui inclut des commodités comme la mémoire de conversation, le mode de conversation vocale et même la génération d’images via des plugins.

L’une des fonctionnalités clés de LobeChat est sa capacité de base de connaissances. Vous pouvez télécharger des documents (dans des formats tels que PDF, images, audio, vidéo) et créer une base de connaissances qui peut être utilisée pendant les conversations. Cela signifie que vous pouvez poser des questions sur le contenu de vos fichiers – un workflow RAG que LobeChat prend en charge nativement. L’interface fournit une gestion de ces fichiers/bases de connaissances et permet de basculer leur utilisation dans la conversation, offrant une expérience Q&A plus riche que le LLM de base.

Pour utiliser LobeChat avec Ollama, vous déployerez l’application LobeChat (par exemple, via une image Docker fournie ou un script) et configurerez Ollama comme backend. LobeChat reconnaît Ollama comme un fournisseur de premier plan – il propose même un script de déploiement en un clic via le navigateur Pinokio AI si vous l’utilisez. En pratique, vous devrez peut-être ajuster les paramètres d’Ollama (comme activer CORS selon les documents de LobeChat) afin que l’interface web de LobeChat puisse accéder à l’API HTTP d’Ollama. Une fois configuré, vous pouvez sélectionner un modèle hébergé par Ollama dans l’interface de LobeChat et converser avec lui, y compris interroger vos documents téléchargés.

Points forts : L’interface de LobeChat est souvent louée pour être propre et conviviale, imitant étroitement l’apparence et le sentiment de ChatGPT (ce qui peut faciliter l’adoption). Elle ajoute de la valeur avec des extras comme l’entrée/sortie vocale pour les conversations orales et un système de plugins pour étendre les fonctionnalités (similaire aux plugins de ChatGPT, permettant des choses comme la navigation web ou la génération d’images). Le support multi-modèles signifie que vous pouvez facilement basculer entre, disons, un modèle local d’Ollama et un modèle d’API d’OpenAI dans la même interface. Elle prend également en charge l’installation en tant qu’application PWA mobile-friendly, donc vous pouvez accéder à votre chat local en déplacement.

Limitations : Configurer LobeChat peut être plus complexe que certaines alternatives. C’est une application full-stack (souvent exécutée avec Docker Compose), donc il y a un peu de surcharge. En particulier, la configuration de l’intégration Ollama nécessite d’activer les requêtes cross-origin du côté d’Ollama et d’assurer que les ports correspondent – une tâche unique, mais technique. De plus, bien que LobeChat soit assez puissant, toutes les fonctionnalités ne seront peut-être pas nécessaires pour chaque utilisateur ; par exemple, si vous n’avez pas besoin d’un support multi-fournisseurs ou de plugins, l’interface peut sembler encombrée par rapport à un outil minimal. Enfin, certaines fonctionnalités avancées comme le déploiement en un clic supposent des environnements spécifiques (navigateur Pinokio ou Vercel), que vous utiliserez ou non. En résumé, LobeChat est idéal si vous souhaitez un alternative complète à ChatGPT qui s’exécute localement avec Ollama, et vous n’avez pas peur d’une configuration initiale un peu complexe.

LibreChat (Clone de ChatGPT avec support multi-fournisseurs)

LibreChat (anciennement connu sous le nom de ChatGPT-Clone ou UI) est un projet open source visant à reproduire et à étendre l’interface et les fonctionnalités de ChatGPT. Il peut être déployé localement (ou sur votre propre serveur) et prend en charge une variété de backends d’IA – y compris des modèles open source via Ollama. En substance, LibreChat fournit l’expérience de chat familière (interface de dialogue avec historique, messages utilisateur et assistant) tout en vous permettant d’insérer différents fournisseurs de modèles côté backend.

LibreChat prend en charge l’interaction avec des documents et le RAG via un add-on appelé RAG API et des services d’embeddings. Dans l’interface, vous pouvez utiliser des fonctionnalités comme « Chat with Files », qui vous permet de télécharger des documents et ensuite de poser des questions à leur sujet. En coulisses, cela utilise des embeddings et un magasin de vecteurs pour récupérer le contexte pertinent de vos fichiers. Cela signifie que vous pouvez obtenir un effet similaire à ChatGPT + connaissance personnalisée, tout en local. Le projet fournit même un dépôt séparé pour le service RAG si vous souhaitez l’héberger vous-même.

L’utilisation de LibreChat avec Ollama implique généralement de faire fonctionner le serveur LibreChat (par exemple via Node/Docker) et d’assurer qu’il peut atteindre le service Ollama. LibreChat a un paramètre « Endpoint personnalisé » où vous pouvez entrer une URL d’API compatible avec OpenAI. Puisque Ollama peut exposer une API locale compatible avec OpenAI, LibreChat peut être pointé vers http://localhost:11434 (ou où que Ollama écoute). En fait, LibreChat liste explicitement Ollama parmi ses fournisseurs d’IA pris en charge – aux côtés d’autres comme OpenAI, Cohere, etc. Une fois configuré, vous pouvez sélectionner le modèle (le modèle d’Ollama) dans un menu déroulant et chatter. LibreChat permet également de basculer de modèles ou de fournisseurs même au cours d’une conversation et prend en charge plusieurs presets de chat/contextes.

Points forts : L’avantage principal de LibreChat est l’ensemble riche de fonctionnalités construit autour de l’expérience de chat. Il inclut des choses comme la branche de conversation, la recherche de messages, le support intégré de l’Interpréteur de code (exécution de code en sandbox sécurisé), et l’intégration d’outils/agents. C’est essentiellement ChatGPT++, avec la capacité d’intégrer des modèles locaux. Pour quelqu’un qui apprécie l’interface de ChatGPT, LibreChat semblera très familier et nécessitera peu de courbe d’apprentissage. Le projet est actif et communautaire (comme le prouvent ses mises à jour fréquentes et les discussions), et il est assez flexible : vous pouvez vous connecter à de nombreux types de points de terminaison LLM ou même le faire fonctionner en mode multi-utilisateur avec l’authentification pour un environnement d’équipe.

Limitations : Avec ses nombreuses fonctionnalités, LibreChat peut être plus lourd à exécuter. L’installation peut impliquer de configurer une base de données pour stocker les chats et de configurer des variables d’environnement pour diverses APIs. Si vous activez toutes les composantes (RAG, agents, génération d’images, etc.), c’est une pile assez complexe. Pour un utilisateur unique qui n’a besoin que d’un chat basique avec un seul modèle local, LibreChat pourrait être plus que nécessaire. De plus, l’interface, bien qu’familière, n’est pas très spécialisée pour les questions/réponses de documents – elle fait le travail mais manque d’une interface dédiée « bibliothèque de documents » (les téléchargements sont généralement effectués dans un chat ou via une API). En résumé, LibreChat brille lorsque vous souhaitez un environnement complet du style ChatGPT avec une gamme de fonctionnalités exécuté localement, mais des solutions plus simples pourraient suffire pour des cas d’utilisation très ciblés.

AnythingLLM (Application tout-en-un de bureau ou serveur)

AnythingLLM est une application AI tout-en-un qui met l’accent sur le RAG et l’ergonomie. Elle vous permet de « chatter avec vos documents » à l’aide de modèles LLM open source ou même de modèles d’OpenAI, tout via une interface unifiée. Notamment, AnythingLLM est disponible à la fois comme application de bureau multiplateforme (pour Windows, Mac, Linux) et comme serveur auto-hébergé (via Docker). Cette flexibilité signifie que vous pouvez l’exécuter comme une application normale sur votre PC, ou la déployer pour plusieurs utilisateurs sur un serveur.

Le traitement des documents est au cœur d’AnythingLLM. Vous pouvez glisser-déposer des documents (PDF, TXT, DOCX, etc.) dans l’application, et elle les indexera automatiquement dans une base de données de vecteurs (elle vient avec LanceDB par défaut). Dans l’interface de chat, lorsqu’on pose des questions, elle récupérera des fragments pertinents de vos documents et fournira des réponses citées, afin que vous sachiez d’où provient l’information. En substance, elle construit une base de connaissances privée pour vous et permet à l’LLM de l’utiliser comme contexte. Vous pouvez organiser des documents en « espaces de travail » (par exemple, un espace de travail par projet ou sujet), isolant les contextes si nécessaire.

L’utilisation d’Ollama avec AnythingLLM est simple. Dans la configuration, vous sélectionnez Ollama comme fournisseur LLM. Si vous l’exécutez via Docker, vous définissez des variables d’environnement comme LLM_PROVIDER=ollama et fournissez OLLAMA_BASE_PATH (l’URL de votre instance Ollama). Le serveur AnythingLLM enverra alors toutes les requêtes de modèle à l’API d’Ollama. Ollama est officiellement pris en charge, et les documents notent que vous pouvez l’utiliser pour exécuter divers modèles open (comme Llama 2, Mistral, etc.) localement. En fait, les développeurs soulignent que la combinaison d’AnythingLLM avec Ollama déverrouille des capacités puissantes de RAG hors ligne : Ollama gère l’inférence du modèle, et AnythingLLM gère les embeddings et la logique d’interface/agent.

Points forts : AnythingLLM fournit une solution complète pour les Q&A privés et le chat. Les points forts clés incluent : une configuration facile pour le RAG (le lourd travail d’embedding et de stockage de vecteurs est automatisé), un support multi-documents avec citation claire des sources, et des fonctionnalités supplémentaires comme les agents AI (il a un générateur d’agents sans code où vous pouvez créer des workflows et des utilisations d’outils personnalisés). Il est également multi-utilisateur par défaut (surtout en mode serveur), avec des comptes d’utilisateurs et des permissions si nécessaire. L’interface est conçue pour être simple (boîte de chat + barre latérale de documents/espaces de travail) mais puissante sous le capot. Pour une utilisation personnelle, l’application de bureau est un grand avantage – vous obtenez une application native sans avoir besoin d’ouvrir un navigateur ou d’exécuter des commandes, et elle stocke les données localement par défaut.

Limitations : Comme elle intègre de nombreux composants (API LLM, modèles d’embedding, base de données de vecteurs, etc.), AnythingLLM peut être très gourmande en ressources. Lorsque vous ingérez des documents, il peut prendre du temps et de la mémoire pour générer des embeddings (il prend même en charge l’utilisation d’Ollama elle-même ou de modèles locaux pour les embeddings avec des modèles comme nomic-embed). L’application de bureau simplifie l’utilisation, mais si vous avez beaucoup de documents ou de très grands fichiers, préparez-vous à un traitement lourd en arrière-plan. Une autre limitation est que les utilisateurs avancés pourraient la trouver moins configurable qu’assembler leur propre stack – par exemple, elle utilise actuellement LanceDB ou Chroma ; si vous vouliez un autre magasin de vecteurs, vous devriez plonger dans la configuration ou le code. De plus, bien que le multi-fournisseur soit pris en charge, l’interface est vraiment orientée vers un seul modèle à la fois (vous basculeriez le paramètre de fournisseur global si vous vouliez utiliser un autre modèle). En résumé, AnythingLLM est une excellente solution prête à l’emploi pour le chat local avec des documents, surtout avec Ollama, mais c’est une application plus importante à exécuter par rapport aux interfaces minimales.

Chat-with-Notes (Interface de chat minimaliste)

Chat-with-Notes est une application minimaliste spécifiquement conçue pour chatter avec des fichiers texte locaux en utilisant des modèles gérés par Ollama. Il s’agit essentiellement d’un serveur web Flask léger que vous exécutez sur votre ordinateur, fournissant une simple page web où vous pouvez charger un document et commencer un chat à son sujet. L’objectif de ce projet est la simplicité : il ne dispose pas de nombreuses fonctionnalités supplémentaires, mais il effectue efficacement la tâche principale de répondre aux questions sur des documents à l’aide d’un LLM local.

L’utilisation de Chat-with-Notes commence par s’assurer que votre instance Ollama exécute un modèle (par exemple, vous pouvez démarrer Ollama avec ollama run llama2 ou un autre modèle). Ensuite, vous lancez l’application Flask (python app.py) et ouvrez le site web local. L’interface utilisateur vous demandera de charger un fichier (les formats pris en charge incluent le texte brut, Markdown, les fichiers de code, HTML, JSON et PDF). Une fois chargé, le contenu du texte du fichier est affiché, et vous pouvez poser des questions ou chatter avec l’IA à ce sujet. La conversation se déroule sous forme classique de bulles de chat. Si vous chargez un nouveau fichier au cours d’une conversation, l’application vous demandera si vous souhaitez démarrer un nouveau chat ou conserver le contexte actuel et simplement ajouter les informations du nouveau fichier. Ainsi, vous pouvez discuter de plusieurs fichiers de manière séquentielle si nécessaire. Il existe également des boutons pour effacer le chat ou exporter la conversation dans un fichier texte.

En coulisses, Chat-with-Notes interroge l’API Ollama pour générer des réponses. Ollama gère l’inférence du modèle, et Chat-with-Notes fournit simplement le prompt (qui inclut les parties pertinentes du texte chargé). Il n’utilise pas de base de données vectorielle ; au contraire, il envoie simplement le contenu entier du fichier (ou des morceaux de celui-ci) ainsi que votre question au modèle. Cette approche fonctionne le mieux pour des documents de taille raisonnable qui s’inscrivent dans la fenêtre de contexte du modèle.

Points forts : L’application est extrêmement simple à déployer et à utiliser. Il n’y a pas de configuration complexe – si vous avez Python et Ollama installés, vous pouvez le faire fonctionner en quelques minutes. L’interface est propre et minimaliste, se concentrant sur le contenu du texte et le Q&A. En raison de cette focalisation, elle garantit que tous les données restent locaux et uniquement en mémoire (aucune appel externe sauf vers Ollama sur localhost). C’est un excellent choix si vous souhaitez spécifiquement chatter avec des fichiers et n’avez pas besoin de conversations générales sans document.

Limites : La minimaliste de Chat-with-Notes signifie qu’elle manque de nombreuses fonctionnalités trouvées dans d’autres interfaces utilisateur. Par exemple, elle ne prend pas en charge l’utilisation de plusieurs modèles ou fournisseurs (elle est uniquement compatible avec Ollama par conception), et elle ne maintient pas une bibliothèque à long terme de documents – vous chargez les fichiers comme nécessaire par session, et il n’y a pas d’index vectoriel persistant. L’extension à de très grands documents pourrait être délicate sans ajustements manuels, car elle pourrait tenter d’inclure beaucoup de texte dans le prompt. De plus, l’interface utilisateur, bien que fonctionnelle, n’est pas aussi polie (pas de mode sombre, pas de mise en forme enrichie des réponses, etc.). En essence, cet outil est idéal pour des analyses rapides et ponctuelles de fichiers avec un modèle Ollama. Si vos besoins augmentent (par exemple, de nombreux documents ou un besoin d’interface utilisateur plus élaborée), vous pourriez dépasser Chat-with-Notes. Mais en tant que point de départ ou une solution personnelle « demandez-moi mon PDF » sur Ollama, c’est très efficace.

Conclusion

Chacune de ces interfaces utilisateur open source peut améliorer votre expérience avec les modèles locaux Ollama en fournissant une interface de chat conviviale et des fonctionnalités supplémentaires comme la réponse aux questions sur les documents. Le meilleur choix dépend de vos besoins et de votre confort technique :

- Pour une configuration rapide et une utilisation en navigateur : Page Assist est un excellent choix, s’intégrant directement à votre navigation web avec un minimum de tracas.

- Pour un environnement d’application web complet : Open WebUI ou LibreChat offrent des fonctionnalités étendues et une flexibilité multi-modèles, adaptés aux utilisateurs avancés ou aux configurations multi-utilisateurs.

- Pour une alternative polie à ChatGPT avec des plugins potentiels : LobeChat propose un bon équilibre entre utilité et fonctionnalités dans un package auto-hébergé.

- Pour des interactions centrées sur les documents : AnythingLLM propose une solution tout-en-un (particulièrement si vous préférez avoir une application de bureau), tandis que Chat-with-Notes propose une approche minimaliste pour les Q&A sur un seul document.

Tous ces outils étant activement maintenus, vous pouvez également vous attendre à des améliorations et un soutien communautaire. En choisissant l’une de ces interfaces utilisateur, vous pourrez chatter avec vos modèles locaux Ollama de manière pratique – qu’il s’agisse d’analyser des documents, de coder avec l’aide, ou simplement d’avoir un assistant conversationnel disponible sans dépendances cloud. Chaque solution ci-dessus est open source, donc vous pouvez la personnaliser davantage selon vos besoins ou même contribuer à son développement.

Bonne discussion avec votre LLM local !