Déplacer les modèles Ollama vers un autre emplacement

Les fichiers de modèles LLM d'Ollama prennent beaucoup de place.

Après avoir installé ollama, il est préférable de reconfigurer ollama pour qu’ils soient stockés dans un nouvel emplacement dès maintenant. Ainsi, après avoir tiré un nouveau modèle, il ne sera pas téléchargé vers l’ancien emplacement.

À propos d’Ollama

Ollama est une interface textuelle pour modèles d’IA LLM et une API capable d’héberger ceux-ci également. Pour une comparaison plus large entre Ollama, vLLM, Docker Model Runner, LocalAI et les fournisseurs de cloud, y compris les compromis en matière de coût et d’infrastructure, consultez Hébergement des LLM : Comparaison entre local, auto-hébergé et infrastructure cloud.

Installer Ollama

Allez sur https://ollama.com/download

Pour installer Ollama sur Linux :

curl -fsSL https://ollama.com/install.sh | sh

Ollama sous Windows est sur la page : https://ollama.com/download/windows Ollama pour Mac est également disponible : https://ollama.com/download/macOllamaSetup.exe

Télécharger, lister et supprimer les modèles Ollama

Pour télécharger certains modèles Ollama : Allez sur la bibliothèque Ollama (https://ollama.com/library) et trouvez le modèle dont vous avez besoin, vous y trouverez également les balises et les tailles des modèles.

Ensuite, exécutez :

ollama pull gemma2:latest

# Ou obtenez une version légèrement plus intelligente qui s'adapte bien à 16 Go de VRAM :

ollama pull gemma2:27b-instruct-q3_K_S

# Ou :

ollama pull llama3.1:latest

ollama pull llama3.1:8b-instruct-q8_0

ollama pull mistral-nemo:12b-instruct-2407-q6_K

ollama pull mistral-small:22b-instruct-2409-q4_0

ollama pull phi3:14b-medium-128k-instruct-q6_K

ollama pull qwen2.5:14b-instruct-q5_0

Pour vérifier les modèles Ollama présents dans le dépôt local :

ollama list

Pour supprimer un modèle inutile :

ollama rm qwen2:7b-instruct-q8_0 # par exemple

Emplacement des modèles Ollama

Par défaut, les fichiers de modèles sont stockés :

- Windows : C:\Users%username%.ollama\models

- Linux : /usr/share/ollama/.ollama/models

- macOS : ~/.ollama/models

Configuration du chemin des modèles Ollama sur Windows

Pour créer une variable d’environnement sur Windows, vous pouvez suivre ces instructions :

- Ouvrez les paramètres Windows.

- Allez dans Système.

- Sélectionnez À propos.

- Sélectionnez Paramètres système avancés.

- Allez sur l’onglet Avancé.

- Sélectionnez Variables d’environnement…

- Cliquez sur Nouveau…

- Et créez une variable appelée OLLAMA_MODELS pointant vers l’emplacement où vous souhaitez stocker les modèles.

Déplacer les modèles Ollama sur Linux

Modifiez les paramètres du service systemd d’Ollama

sudo systemctl edit ollama.service

ou

sudo xed /etc/systemd/system/ollama.service

Cela ouvrira un éditeur.

Pour chaque variable d’environnement, ajoutez une ligne Environment sous la section [Service] :

[Service]

Environment="OLLAMA_MODELS=/specialplace/ollama/models"

Enregistrez et quittez.

Il y a également des paramètres User et Group, ceux-ci doivent avoir accès à ce dossier.

Relancez systemd et redémarrez Ollama :

sudo systemctl daemon-reload

sudo systemctl restart ollama

si quelque chose a mal fonctionné

systemctl status ollama.service

sudo journalctl -u ollama.service

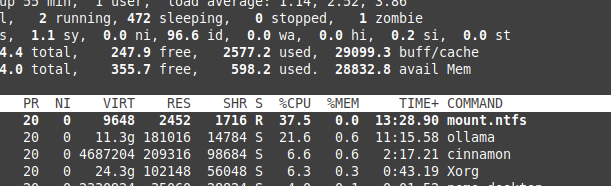

Stockage des fichiers sur NTFS et surcoût

Veuillez être conscient que si vous exécutez Linux et que vous gardez vos modèles sur une partition formatée NTFS, vos modèles chargeront beaucoup plus lentement, plus de 20 %.

Installer Ollama sur Windows dans un dossier spécifique

Avec les modèles

.\OllamaSetup.exe /DIR=D:\OllamaDir

Exposer l’API Ollama sur le réseau interne

Interne ici signifie réseau local.

Ajoutez à la configuration du service :

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

Pour voir comment Ollama s’intègre avec d’autres options locales et cloud LLM, consultez notre guide Hébergement des LLM : Comparaison entre local, auto-hébergé et infrastructure cloud.

Liens utiles

- Test : Comment Ollama utilise les performances du processeur Intel et les cœurs efficaces

- Comment Ollama gère les requêtes parallèles

- Performance des LLM et canaux PCIe : Considérations clés

- Comparaison de la vitesse des LLM

- Comparaison des capacités de résumé des LLM

- Rédiger des prompts efficaces pour les LLM

- Auto-hébergement de Perplexica avec Ollama

- Fournisseurs de LLM en cloud