Writefreely 联邦博客平台 - 自托管与托管成本对比

“托管成本估算与订阅的对比。”

以下是关于 Write.as / WriteFreely 的简要信息:它如何融入 fediverse,在哪里可以获取托管服务,使用趋势如何,以及如何自行托管(包括大致成本)。

“托管成本估算与订阅的对比。”

以下是关于 Write.as / WriteFreely 的简要信息:它如何融入 fediverse,在哪里可以获取托管服务,使用趋势如何,以及如何自行托管(包括大致成本)。

使用思考型大语言模型的具体示例

在本文中,我们将探讨两种连接您的 Python 应用程序到 Ollama 的方法:1. 通过 HTTP REST API;2. 通过 官方 Ollama Python 库。

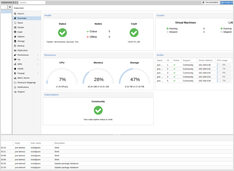

什么是 Proxmox?

Proxmox Virtual Environment (Proxmox VE) 是一个基于 Debian 的开源、类型 1 虚拟化管理程序和数据中心编排平台。

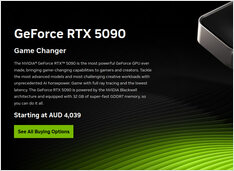

适合AI的消费级GPU价格 - RTX 5080 和 RTX 5090

一再地,让我们比较顶级消费级GPU的价格,这些GPU特别适合LLMs,也适用于AI整体。

具体来说,我正在查看

RTX-5080和RTX-5090价格。

它们的价格略有下降。

不太好看。

Ollama的GPT-OSS模型在处理结构化输出时经常出现问题,尤其是在与LangChain、OpenAI SDK、vllm等框架一起使用时。

从Ollama获取结构化输出的几种方法

大型语言模型(LLMs) 功能强大,但在生产环境中,我们很少希望得到自由形式的段落。 相反,我们希望获得可预测的数据:属性、事实或可以输入到应用程序中的结构化对象。 这就是LLM结构化输出。

尝试了 Kubuntu 和 KDE Neon,Kubuntu 更加稳定。

对于 KDE Plasma 粉丝来说,有两个 Linux 发行版在讨论中经常被提及:

Kubuntu 和 KDE Neon。

它们可能看起来相似——两者都以 KDE Plasma 作为默认桌面环境,都基于 Ubuntu,也都对新手友好。

我对ollama模型调度的测试 ```

在这里,我比较了新版本 Ollama 为模型分配的 VRAM 量与旧版本 Ollama 的情况。新版本表现更差。

在Linux中配置静态IP的注意事项

本指南将逐步指导您如何 在Ubuntu服务器上更改静态IP地址.

我对Ollama当前开发状态的看法

Ollama 已经迅速成为在本地运行大型语言模型(LLMs)最受欢迎的工具之一。

其简单的命令行界面(CLI)和流畅的模型管理功能,使其成为希望在云之外使用 AI 模型的开发人员的首选。

但与许多有前景的平台一样,已经出现了 Enshittification 的迹象:

替代的语音 over IP 通信平台

Mumble 是一款免费且开源的语音通信(VoIP)应用程序,主要用于实时语音交流。它采用客户端-服务器架构,用户通过连接到共享服务器来互相交谈。

2025年Ollama最突出的UI概览

本地托管的 Ollama 允许你在自己的机器上运行大型语言模型,但通过命令行使用它并不友好。

以下是几个提供 ChatGPT风格界面 的开源项目,它们可以连接到本地的 Ollama。

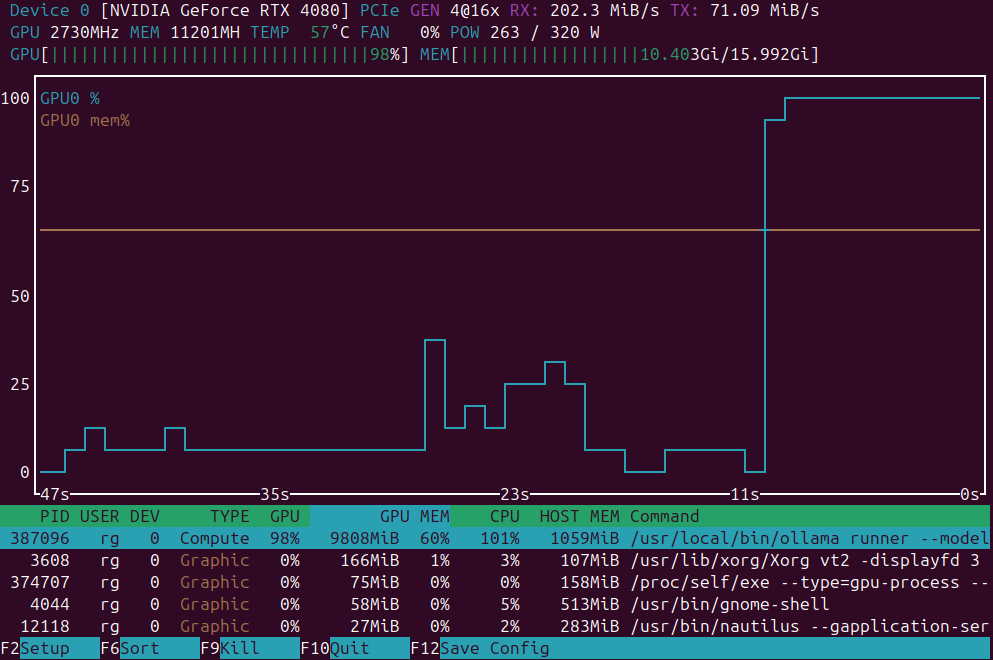

用于GPU负载监控的应用程序小列表

GPU负载监控应用: nvidia-smi vs nvtop vs nvitop vs KDE plasma systemmonitor.

在家庭实验室集群上安装轻量级 k3s Kubernetes

以下是逐步操作指南,介绍如何在裸金属服务器(1个主节点 + 2个工作节点)上**安装一个3节点K3s集群**。

Kubernetes 变体的简要概述

比较 自托管 Kubernetes 发行版,用于在裸机或家庭服务器上部署,重点关注安装简便性、性能、系统要求和功能集。

为我们的家庭实验室选择最佳的 Kubernetes 方案

我正在比较自托管的Kubernetes变体 ,这些变体适用于基于Ubuntu的homelab,包含3个节点(每个节点16GB RAM,4个核心),重点在于安装和维护的简便性,以及对持久卷和LoadBalancers的支持。