降低大语言模型成本:令牌优化策略

通过智能令牌优化,将大语言模型成本降低80%

令牌优化是区分成本效益高的LLM应用与耗费预算的实验的关键技能。

通过智能令牌优化,将大语言模型成本降低80%

令牌优化是区分成本效益高的LLM应用与耗费预算的实验的关键技能。

GPT-OSS 120b 在三个 AI 平台上的基准测试

我找到了一些关于GPT-OSS 120b在三个不同平台上运行的性能测试结果:NVIDIA DGX Spark、Mac Studio和RTX 4080。Ollama库中的GPT-OSS 120b模型大小为65GB,这意味着它无法装入RTX 4080(或更新的RTX 5080的16GB显存中。

使用 Python 示例构建 AI 助手的 MCP 服务器

模型上下文协议(MCP)正在革新AI助手与外部数据源和工具的交互方式。在本指南中,我们将探讨如何构建 MCP 服务器(Python),重点介绍网络搜索和爬取功能的示例。

用 Python 将 HTML 转换为干净、适合大语言模型处理的 Markdown

将HTML转换为Markdown是现代开发工作流程中的基本任务,特别是在为大型语言模型(LLMs)、文档系统或静态站点生成器(如Hugo)准备网页内容时。

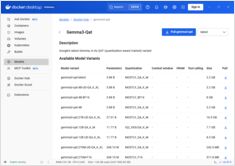

Docker Model Runner 命令快速参考

Docker Model Runner (DMR) 是 Docker 官方用于本地运行 AI 模型的解决方案,于 2025 年 4 月推出。此快速参考提供了所有关键命令、配置和最佳实践的快速查阅。

对比 Docker Model Runner 和 Ollama 本地大语言模型

在本地运行大型语言模型 (LLMs) 已成为隐私保护、成本控制和离线功能的重要趋势。 2025 年 4 月,Docker 推出了 Docker Model Runner (DMR),这是其用于 AI 模型部署的官方解决方案,标志着该领域的重大转变。

专用芯片正在让人工智能推理变得更加快速、廉价。

可用性、六个国家的真实零售价格以及与Mac Studio的对比。

NVIDIA DGX Spark 是真实存在的,将于 2025年10月15日 开售,目标用户是需要 本地大型语言模型(LLM)工作 的 CUDA 开发者,配备集成的 NVIDIA AI 套件。美国建议零售价为 3,999美元;由于增值税和渠道因素,英国/德国/日本 的零售价更高。澳大利亚/韩元 的公开标价 尚未广泛发布。

比较这两个模型的速度、参数和性能

以下是 Qwen3:30b 和 GPT-OSS:20b 的比较,重点聚焦于指令遵循和性能参数、规格和速度:

使用思考型大语言模型的具体示例

在本文中,我们将探讨两种连接您的 Python 应用程序到 Ollama 的方法:1. 通过 HTTP REST API;2. 通过 官方 Ollama Python 库。

不太好看。

Ollama的GPT-OSS模型在处理结构化输出时经常出现问题,尤其是在与LangChain、OpenAI SDK、vllm等框架一起使用时。

略有不同的 API 需要特殊处理。

以下是结构化输出在主流大语言模型(LLM)提供商之间的对比,以及一些Python示例:

从Ollama获取结构化输出的几种方法

大型语言模型(LLMs) 功能强大,但在生产环境中,我们很少希望得到自由形式的段落。 相反,我们希望获得可预测的数据:属性、事实或可以输入到应用程序中的结构化对象。 这就是LLM结构化输出。

我对ollama模型调度的测试 ```

在这里,我比较了新版本 Ollama 为模型分配的 VRAM 量与旧版本 Ollama 的情况。新版本表现更差。

我对Ollama当前开发状态的看法

Ollama 已经迅速成为在本地运行大型语言模型(LLMs)最受欢迎的工具之一。

其简单的命令行界面(CLI)和流畅的模型管理功能,使其成为希望在云之外使用 AI 模型的开发人员的首选。

但与许多有前景的平台一样,已经出现了 Enshittification 的迹象:

2025年Ollama最突出的UI概览

本地托管的 Ollama 允许你在自己的机器上运行大型语言模型,但通过命令行使用它并不友好。

以下是几个提供 ChatGPT风格界面 的开源项目,它们可以连接到本地的 Ollama。