Runner de Modelo Docker vs Ollama (2026): Qual é Melhor para LLMs Locais?

Compare Docker Model Runner e Ollama para LLM local

Executar grandes modelos de linguagem (LLMs) localmente tornou-se cada vez mais popular por motivos de privacidade, controle de custos e capacidades offline. O cenário mudou significativamente em abril de 2025, quando o Docker introduziu Docker Model Runner (DMR), sua solução oficial para implantação de modelos de IA.

Agora, três abordagens competem pela atenção dos desenvolvedores: o Model Runner nativo do Docker, soluções de terceiros containerizadas (vLLM, TGI) e a plataforma standalone Ollama.

Para uma visão mais ampla que inclui provedores de nuvem e trade-offs de infraestrutura, veja LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

TL;DR – Docker Model Runner vs Ollama

Esta comparação se concentra em executar grandes modelos de linguagem (LLMs) localmente usando Docker ou runtimes standalone, abrangendo desempenho, suporte a GPU, compatibilidade com API e cenários de implantação em produção.

- Melhor para fluxos de trabalho nativos do Docker: Docker Model Runner

- Melhor para simplicidade e prototipagem rápida: Ollama

- Melhor para Kubernetes & orquestração: Configurações baseadas em Docker

- Melhor para desenvolvimento em única máquina: Ollama

Se você já está usando o Docker intensamente, o DMR faz sentido.

Se você quer a forma mais rápida de executar LLMs localmente, o Ollama é mais simples.

Se você está comparando mais do que apenas Docker Model Runner e Ollama, veja nossa análise completa de Ollama vs vLLM vs LM Studio e outras ferramentas locais de LLM. Este guia compara a maturidade da API, suporte a hardware, chamada de ferramentas e prontidão para produção entre mais de 12 runtimes locais de LLM.

Docker Model Runner vs Ollama: Comparação Direta

Com a entrada oficial do Docker no espaço de execução de LLMs, a comparação torna-se mais interessante. Aqui está como o DMR e o Ollama se comparam lado a lado:

| Feature | Docker Model Runner | Ollama |

|---|---|---|

| Instalação | Guia de AI no Docker Desktop ou docker-model-plugin |

Comando único: curl | sh |

| Estilo de Comando | docker model pull/run/package |

ollama pull/run/list |

| Formato do Modelo | GGUF (OCI Artifacts) | GGUF (nativo) |

| Distribuição do Modelo | Docker Hub, repositórios OCI | Registro Ollama |

| Configuração de GPU | Automática (mais simples do que o Docker tradicional) | Automática |

| API | Compatível com OpenAI | Compatível com OpenAI |

| Integração com Docker | Nativa (é o Docker) | Executa em Docker se necessário |

| Suporte a Compose | Nativo | Via imagem Docker |

| Curva de Aprendizado | Baixa (para usuários do Docker) | Mais baixa (para todos) |

| Parceiros do Ecossistema | Google, Hugging Face, VMware | LangChain, CrewAI, Open WebUI |

| Melhor Para | Fluxos de trabalho nativos do Docker | Simplicidade standalone |

Insight Principal: O DMR traz fluxos de trabalho do Docker para a implantação de LLMs, enquanto o Ollama permanece agnóstico a frameworks com operação standalone mais simples. Sua infraestrutura existente importa mais do que diferenças técnicas.

O Docker Model Runner é melhor que o Ollama?

Depende do seu fluxo de trabalho.

- Escolha Docker Model Runner (DMR) se sua equipe já depende intensamente do Docker, artefatos OCI e orquestração de containers.

- Escolha Ollama se quiser a forma mais simples de executar LLMs localmente com mínima configuração e prototipagem rápida.

Para a maioria das configurações de única máquina, o Ollama é mais fácil de usar.

Para pipelines de CI/CD nativos do Docker e fluxos de trabalho de container em empresas, o DMR se integra de forma mais natural.

Como executar um LLM no Docker: DMR vs Ollama

Se o seu objetivo é simplesmente executar um LLM dentro do Docker, tanto o Docker Model Runner quanto o Ollama em containers do Docker podem atingir isso.

O Docker Model Runner usa comandos nativos docker model pull e docker model run, empacotando modelos como artefatos OCI.

O Ollama também pode ser executado dentro do Docker usando a imagem de container oficial ollama/ollama, expondo uma API compatível com OpenAI na porta 11434.

A diferença principal está na integração de fluxo de trabalho:

- O DMR se encaixa naturalmente em pipelines de CI/CD nativos do Docker.

- O Ollama no Docker oferece gerenciamento mais simples de modelos com flexibilidade de orquestração do Docker.

Entendendo os Model Runners do Docker

Model runners baseados no Docker usam containerização para empacotar motores de inferência de LLMs junto com suas dependências. O cenário inclui tanto a solução oficial do Docker quanto frameworks de terceiros.

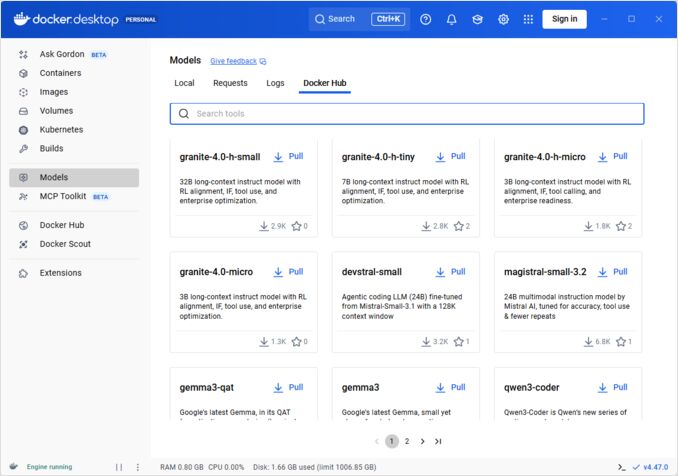

Docker Model Runner (DMR) - Solução Oficial

Em abril de 2025, o Docker introduziu Docker Model Runner (DMR), um produto oficial projetado para simplificar a execução de modelos de IA localmente usando a infraestrutura do Docker. Isso representa o compromisso do Docker em tornar a implantação de modelos de IA tão simples quanto a implantação de containers.

Principais Recursos do DMR:

- Integração Nativa com Docker: Usa comandos familiares do Docker (

docker model pull,docker model run,docker model package) - Empacotamento como Artefatos OCI: Modelos são empacotados como Artefatos OCI, permitindo a distribuição através do Docker Hub e outros repositórios

- API Compatível com OpenAI: Substituição direta para endpoints do OpenAI, simplificando a integração

- Aceleração com GPU: Suporte nativo a GPU sem configuração complexa de nvidia-docker

- Suporte ao Formato GGUF: Funciona com formatos populares de modelos quantizados

- Integração com Docker Compose: Configurar e implantar modelos facilmente usando ferramentas padrão do Docker

- Suporte a Testcontainers: Integra-se facilmente com frameworks de teste

Instalação:

- Docker Desktop: Ativar via guia AI nas configurações

- Docker Engine: Instalar o pacote

docker-model-plugin

Exemplo de Uso:

# Puxar um modelo do Docker Hub

docker model pull ai/smollm2

# Executar inferência

docker model run ai/smollm2 "Explique o Docker Model Runner"

# Empacotar modelo personalizado

docker model package --gguf /caminho/para/modelo.gguf --push myorg/mymodel:latest

Para uma referência completa dos comandos docker model, opções de empacotamento, flags de configuração e exemplos práticos, veja nossa detalhada Docker Model Runner Cheatsheet: Comandos & Exemplos. Ele abrange o puxamento de modelos, empacotamento, configuração e melhores práticas para implantar LLMs localmente com Docker.

O DMR se associa com Google, Hugging Face e VMware Tanzu para expandir o ecossistema de modelos de IA disponível através do Docker Hub. Se você é novo no Docker ou precisa de um refrescador sobre comandos do Docker, nossa Docker Cheatsheet oferece um guia abrangente para operações essenciais do Docker.

Soluções de Terceiros no Docker

Além do DMR, o ecossistema inclui frameworks estabelecidos:

- Contêineres vLLM: Servidor de inferência de alta-throughput otimizado para processamento em lote

- Text Generation Inference (TGI): Solução de produção da Hugging Face

- Contêineres llama.cpp: Implementação leve em C++ com suporte a quantização

- Contêineres personalizados: Wrapping PyTorch, Transformers ou frameworks proprietários

Vantagens da Abordagem Docker

Flexibilidade e Agnóstico a Frameworks: Contêineres do Docker podem executar qualquer framework de LLM, desde PyTorch até ONNX Runtime, dando aos desenvolvedores controle total sobre a pilha de inferência.

Isolamento de Recursos: Cada contêiner opera em ambientes isolados com limites definidos de recursos (CPU, memória, GPU), evitando conflitos de recursos em implantações de múltiplos modelos.

Suporte a Orquestração: O Docker se integra de forma nativa com Kubernetes, Docker Swarm e plataformas de nuvem para escalabilidade, balanceamento de carga e alta disponibilidade.

Controle de Versão: Diferentes versões de modelos ou frameworks podem coexistir no mesmo sistema sem conflitos de dependências.

Desvantagens da Abordagem Docker

Complexidade: Exige compreensão de containerização, montagens de volume, configuração de rede e pass-through de GPU (nvidia-docker).

Sobrecarga: Embora mínima, o Docker adiciona uma camada fina de abstração que ligeiramente impacta o tempo de inicialização e o uso de recursos.

Carga de Configuração: Cada implantação requer configuração cuidadosa de Dockerfiles, variáveis de ambiente e parâmetros de tempo de execução.

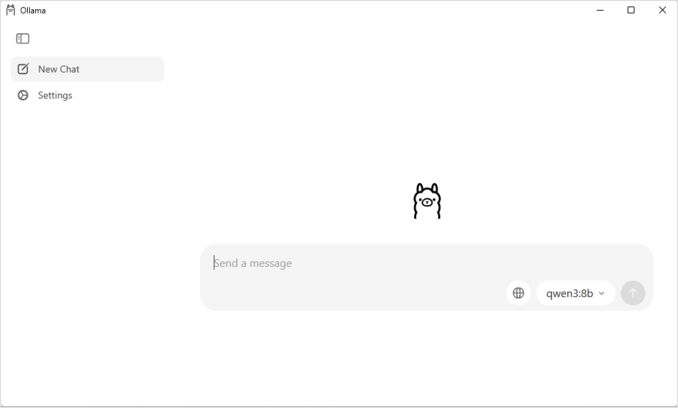

Entendendo o Ollama

Ollama é uma aplicação projetada especificamente para executar LLMs localmente, com simplicidade como seu princípio central. Ele oferece:

- Binário nativo para Linux, macOS e Windows

- Biblioteca de modelos integrada com instalação em um único comando

- Detecção e otimização automáticas de GPU

- API RESTful compatível com o formato do OpenAI

- Gerenciamento de contexto e estado dos modelos

Vantagens do Ollama

Simplicidade: A instalação é direta (curl | sh no Linux), e executar modelos requer apenas ollama run llama2. Para uma referência completa dos comandos da CLI do Ollama, como ollama serve, ollama run, ollama ps e fluxos de trabalho de gerenciamento de modelos, veja nossa Ollama CLI Cheatsheet.

Desempenho Otimizado: Baseado em llama.cpp, o Ollama é altamente otimizado para velocidade de inferência com suporte a quantização (Q4, Q5, Q8).

Gerenciamento de Modelos: Registro de modelos integrado com comandos como ollama pull, ollama list e ollama rm simplifica o ciclo de vida dos modelos.

Experiência do Desenvolvedor: API limpa, documentação extensa e ecossistema crescente de integrações (LangChain, CrewAI, etc.). A versatilidade do Ollama se estende a casos de uso especializados, como reclassificação de documentos de texto com modelos de embedding.

Eficiência de Recursos: Gerenciamento automático de memória e desligamento de modelos quando ociosos conserva recursos do sistema.

Desvantagens do Ollama

Bloqueio de Framework: Principalmente suporta modelos compatíveis com llama.cpp, limitando a flexibilidade para frameworks como vLLM ou motores de inferência proprietários.

Limitada Personalização: Configurações avançadas (quantização personalizada, fluxos de CUDA específicos) são menos acessíveis do que em ambientes de Docker.

Desafios de Orquestração: Embora o Ollama possa executar em contêineres, ele carece de suporte nativo para recursos avançados de orquestração, como escalabilidade horizontal.

Comparação de Desempenho

Velocidade de Inferência

Docker Model Runner: Desempenho comparável ao Ollama, pois ambos suportam modelos quantizados GGUF. Para Llama 2 7B (Q4), espere 20-30 tokens/segundo na CPU e 50-80 tokens/segundo em GPUs médias. Sobrecarga mínima de contêiner.

Ollama: Utiliza backend altamente otimizado de llama.cpp com quantização eficiente. Para Llama 2 7B (Q4), espere 20-30 tokens/segundo na CPU e 50-80 tokens/segundo em GPUs médias. Nenhuma sobrecarga de containerização. Para detalhes sobre como o Ollama gerencia inferência paralela, veja nossa análise sobre como o Ollama lida com solicitações paralelas.

Docker (vLLM): Otimizado para processamento em lote com processamento contínuo. Solicitações individuais podem ser ligeiramente mais lentas, mas a throughput excels sob carga de alta concorrência (100+ tokens/segundo por modelo com processamento em lote).

Docker (TGI): Similar ao vLLM com excelente desempenho de processamento em lote. Adiciona recursos como streaming e geração token por token.

Uso de Memória

Docker Model Runner: Similar ao Ollama com carregamento automático de modelos. Modelos GGUF Q4 normalmente usam 4-6GB de RAM. Sobrecarga de contêiner mínima (dezenas de MB).

A configuração do tamanho do contexto pode impactar significativamente o uso de memória e o comportamento do modelo. Por padrão, algumas imagens CUDA do Docker Model Runner definem um limite de 4096 tokens, mesmo se valores mais altos forem especificados no docker-compose. Para etapas detalhadas sobre como substituir esse comportamento e empacotar modelos com tamanhos de contexto personalizados, veja nosso guia sobre configurar o tamanho do contexto no Docker Model Runner.

Ollama: Gerenciamento automático de memória carrega modelos sob demanda e desliga-os quando ociosos. Um modelo 7B Q4 normalmente usa 4-6GB de RAM. Mais eficiente para cenários de único modelo.

Soluções Tradicionais de Docker: O uso de memória depende do framework. O vLLM aloca memória de GPU previamente para desempenho otimizado, enquanto contêineres baseados em PyTorch podem usar mais RAM para pesos do modelo e cache KV (8-14GB para modelos 7B).

Tempo de Inicialização

Docker Model Runner: A inicialização do contêiner adiciona ~1 segundo, mais o carregamento do modelo (2-5 segundos). Total: 3-6 segundos para modelos médios.

Ollama: Inicialização quase instantânea com carregamento do modelo levando 2-5 segundos para modelos médios. Experiência de inicialização fria mais rápida.

Soluções Tradicionais de Docker: A inicialização do contêiner adiciona 1-3 segundos, mais o tempo de carregamento do modelo. O pré-aquecimento de contêineres mitiga isso em implantações de produção.

Recomendações para Casos de Uso

Escolha Docker Model Runner Quando

- Fluxo de trabalho baseado em Docker: Sua equipe já usa o Docker extensivamente

- Ferramentas unificadas: Deseja uma única ferramenta (Docker) para contêineres e modelos

- Distribuição de artefatos OCI: Precisa de integração com repositórios empresariais

- Integração com Testcontainers: Testando recursos de IA em pipelines de CI/CD

- Preferência por Docker Hub: Deseja distribuição de modelos por canais familiares

Escolha Ollama Quando

- Prototipagem rápida: Experimentação rápida com diferentes modelos

- Agnóstico a frameworks: Não está vinculado ao ecossistema do Docker

- Máxima simplicidade: Mínima configuração e sobrecarga de manutenção

- Implantações em única máquina: Executando em laptops, estações de trabalho ou VMs únicas

- Grande biblioteca de modelos: Acesso a extensa biblioteca de modelos pré-configurados

Escolha Soluções de Terceiros no Docker Quando

- Implantações em produção: Necessidade de orquestração e monitoramento avançados

- Serving de múltiplos modelos: Executando diferentes frameworks (vLLM, TGI) simultaneamente

- Orquestração em Kubernetes: Escalando em clusters com balanceamento de carga

- Frameworks personalizados: Usando Ray Serve ou motores de inferência proprietários

- Controle rigoroso de recursos: Impondo limites granulares de CPU/GPU por modelo

Abordagens Híbridas: Melhor de Ambos os Mundos

Você não está limitado a uma única abordagem. Considere esses estratégias híbridas:

Opção 1: Docker Model Runner + Contêineres Tradicionais

Use DMR para modelos padrão e contêineres de terceiros para frameworks especializados:

# Puxe um modelo padrão com DMR

docker model pull ai/llama2

# Execute vLLM para cenários de alta-throughput

docker run --gpus all vllm/vllm-openai

Opção 2: Ollama em Docker

Execute Ollama dentro de contêineres de Docker para capacidades de orquestração:

docker run -d \

--name ollama \

--gpus all \

-v ollama:/root/.ollama \

-p 11434:11434 \

ollama/ollama

Isso oferece:

- Gerenciamento intuitivo de modelos do Ollama

- Capacidades de orquestração e isolamento do Docker

- Implantação no Kubernetes com manifestos padrão

Opção 3: Misturar e Usar por Caso de Uso

- Desenvolvimento: Ollama para iterações rápidas

- Ambiente de staging: Docker Model Runner para testes de integração

- Produção: vLLM/TGI no Kubernetes para escalar

Compatibilidade da API

Todas as soluções modernas convergem para APIs compatíveis com OpenAI, simplificando a integração:

API do Docker Model Runner: Endpoints compatíveis com OpenAI são servidos automaticamente ao executar modelos. Nenhuma configuração adicional é necessária.

# Modelos executam com API exposta automaticamente

docker model run ai/llama2

# Use endpoint compatível com OpenAI

curl http://localhost:8080/v1/chat/completions -d '{

"model": "llama2",

"messages": [{"role": "user", "content": "Por que o céu é azul?"}]

}'

API do Ollama: Endpoints compatíveis com OpenAI tornam o Ollama uma substituição direta para aplicações que usam o SDK do OpenAI. Streaming é totalmente suportado.

curl http://localhost:11434/api/generate -d '{

"model": "llama2",

"prompt": "Por que o céu é azul?"

}'

APIs de Soluções de Terceiros no Docker: vLLM e TGI oferecem endpoints compatíveis com OpenAI, enquanto contêineres personalizados podem implementar APIs proprietárias.

A convergência em compatibilidade com OpenAI significa que você pode alternar entre soluções com mínimos ajustes de código.

Gerenciamento de Recursos

Aceleração com GPU

Docker Model Runner: Suporte nativo a GPU sem configuração complexa de nvidia-docker. Detecta e usa automaticamente GPUs disponíveis, significativamente simplificando a experiência de GPU do Docker em comparação com contêineres tradicionais.

Se você está usando GPUs NVIDIA e deseja configurar corretamente a aceleração CUDA, veja nosso guia detalhado sobre adicionar suporte a GPU NVIDIA ao Docker Model Runner. Ele aborda a configuração do daemon do Docker, instalação do NVIDIA Container Toolkit e como verificar se seu LLM está realmente usando a memória da GPU em vez de recuar para inferência na CPU.

# Aceleração com GPU funciona automaticamente

docker model run ai/llama2

Ollama: Detecção automática de GPU em GPUs NVIDIA compatíveis com CUDA. Nenhuma configuração além da instalação do driver é necessária.

Contêineres Tradicionais do Docker: Requer nvidia-docker runtime e alocação explícita de GPU:

docker run --gpus all my-llm-container

Fallback para CPU

Ambos se recuperam automaticamente para inferência na CPU quando GPUs não estão disponíveis, embora o desempenho diminua significativamente (5-10x mais lento para modelos grandes). Para insights sobre o desempenho apenas com CPU em processadores modernos, leia nosso teste sobre como o Ollama usa o desempenho da CPU Intel e núcleos eficientes.

Suporte a Multi-GPU

Ollama: Suporta paralelismo de tensor em múltiplas GPUs para modelos grandes.

Docker: Depende do framework. vLLM e TGI suportam inferência com múltiplas GPUs com configuração apropriada.

Comunidade e Ecossistema

Docker Model Runner: Lançado em abril de 2025 com forte apoio empresarial. Parcerias com Google, Hugging Face e VMware Tanzu AI Solutions garantem disponibilidade ampla de modelos. Integração com a grande comunidade de desenvolvedores do Docker (milhões de usuários) fornece acesso imediato ao ecossistema. Ainda está construindo recursos específicos da comunidade como um novo produto.

Ollama: Comunidade em rápido crescimento com mais de 50K estrelas no GitHub. Ecossistema de integração forte (LangChain, LiteLLM, Open WebUI, CrewAI) e comunidade ativa no Discord. Ferramentas de terceiros e tutoriais extensos disponíveis. Documentação e recursos de comunidade mais maduros. Para uma visão abrangente das interfaces disponíveis, veja nosso guia sobre interfaces de chat open-source para instâncias locais do Ollama. Como com qualquer projeto open-source em rápido crescimento, é importante monitorar a direção do projeto - leia nossa análise sobre primeiros sinais de enshittification do Ollama para entender preocupações potenciais.

Soluções de Terceiros no Docker: vLLM e TGI têm ecossistemas maduros com suporte empresarial. Estudos de caso de produção extensos, guias de otimização e padrões de implantação de Hugging Face e contribuidores da comunidade.

Considerações de Custo

Docker Model Runner: Gratuito com Docker Desktop (pessoal/educacional) ou Docker Engine. O Docker Desktop requer assinatura para organizações maiores (250+ funcionários ou $10M+ de receita). Modelos distribuídos pelo Docker Hub seguem a política de preços do Docker (repositórios públicos gratuitos, repositórios privados pagos).

Ollama: Totalmente gratuito e open-source sem custos de licença, independentemente do tamanho da organização. Os custos de recursos dependem apenas do hardware.

Soluções de Terceiros no Docker: Gratuitas para frameworks de código aberto (vLLM, TGI). Potenciais custos para plataformas de orquestração de contêineres (ECS, GKE) e armazenamento de repositórios privados.

Considerações de Segurança

Docker Model Runner: Utiliza o modelo de segurança do Docker com isolamento de contêineres. Modelos empacotados como artefatos OCI podem ser verificados e assinados. A distribuição pelo Docker Hub permite controle de acesso e varredura de vulnerabilidades para usuários empresariais.

Ollama: Executa como um serviço local com API exposta por padrão no localhost. A exposição de rede requer configuração explícita. O registro de modelos é confiável (curado pelo Ollama), reduzindo riscos de cadeia de suprimentos.

Soluções Tradicionais de Docker: Isolamento de rede é embutido. Varredura de segurança de contêineres (Snyk, Trivy) e assinatura de imagens são práticas padrão em ambientes de produção.

Todos os soluções exigem atenção a:

- Proveniência do modelo: Modelos não confiáveis podem conter código malicioso ou backdoors

- Autenticação da API: Implementar autenticação/autorização em implantações de produção

- Limitação de taxa: Prevenir abuso e esgotamento de recursos

- Exposição de rede: Garantir que APIs não sejam inadvertidamente expostas para a internet

- Privacidade de dados: Modelos processam dados sensíveis; garantir conformidade com regulamentações de proteção de dados

Caminhos de Migração

De Ollama para Docker Model Runner

O suporte do Docker Model Runner a GGUF torna a migração simples:

- Ative o Docker Model Runner no Docker Desktop ou instale o

docker-model-plugin - Converta referências de modelos:

ollama run llama2→docker model pull ai/llama2edocker model run ai/llama2 - Atualize endpoints da API de

localhost:11434para o endpoint do DMR (geralmentelocalhost:8080) - Ambos usam APIs compatíveis com OpenAI, então o código da aplicação requer alterações mínimas

De Docker Model Runner para Ollama

Migre para Ollama para operação standalone mais simples:

- Instale o Ollama:

curl -fsSL https://ollama.ai/install.sh | sh. Para uma lista completa de comandos da CLI do Ollama e opções de configuração, consulte a Ollama CLI cheatsheet. - Puxe modelos equivalentes:

ollama pull llama2 - Atualize endpoints da API para

localhost:11434do Ollama - Teste com

ollama run llama2para verificar a funcionalidade

De Contêineres Tradicionais do Docker para DMR

Simplifique sua configuração de LLM no Docker:

- Ative o Docker Model Runner

- Substitua os Dockerfiles personalizados pelos comandos

docker model pull - Remova a configuração de nvidia-docker (o DMR lida com GPU automaticamente)

- Use

docker model runem vez de comandos complexos dedocker run

De Qualquer Solução para Ollama em Contêineres do Docker

Abordagem melhor de ambos os mundos:

docker pull ollama/ollama- Execute:

docker run -d --gpus all -v ollama:/root/.ollama -p 11434:11434 ollama/ollama - Use comandos do Ollama como de costume:

docker exec -it ollama ollama pull llama2 - Obtenha orquestração do Docker com simplicidade do Ollama

Monitoramento e Observabilidade

Ollama: Métricas básicas via API (/api/tags, /api/ps). Ferramentas de terceiros como Open WebUI fornecem dashboards.

Docker: Integração completa com Prometheus, Grafana, stack ELK e serviços de monitoramento em nuvem. Métricas de contêiner (CPU, memória, GPU) estão disponíveis com facilidade.

Conclusão

O cenário de implantação local de LLMs evoluiu significativamente com a introdução do Docker Model Runner (DMR) em 2025. A escolha agora depende de seus requisitos específicos:

- Para desenvolvedores buscando integração com Docker: O DMR oferece integração nativa com fluxos de trabalho do Docker com comandos

docker model - Para máxima simplicidade: O Ollama continua sendo a solução mais simples com gerenciamento de modelos em um único comando

- Para produção e empresas: Ambos, DMR e soluções de terceiros (vLLM, TGI) em Docker oferecem orquestração, monitoramento e escalabilidade

- Para o melhor de ambos: Execute o Ollama em contêineres do Docker para combinar simplicidade com infraestrutura de produção

A introdução do DMR reduz a lacuna entre o Docker e o Ollama em termos de usabilidade. O Ollama ainda vence em simplicidade para prototipagem rápida, enquanto o DMR se destaca para equipes já investidas em fluxos de trabalho do Docker. Ambas as abordagens são ativamente desenvolvidas, prontas para produção e o ecossistema está maduro o suficiente para que a migração entre elas seja relativamente indolor.

Conclusão Final: Se você já está usando o Docker extensivamente, o DMR é a escolha natural. Se você quer a experiência mais simples possível, independentemente da infraestrutura, escolha o Ollama. Para comparar essas opções locais com APIs de nuvem e outras configurações de auto-hospedagem, consulte nosso guia LLM Hosting: Local, Self-Hosted & Cloud Infrastructure Compared.

Links Úteis

Docker Model Runner

- Página Oficial do Docker Model Runner

- Documentação do Docker Model Runner

- Guia de Introdução ao Docker Model Runner

- Blog de Anúncio do Docker Model Runner

Ollama

Outras Soluções do Docker

- Documentação do vLLM

- Inferência de Geração de Texto da Hugging Face

- Repositório do llama.cpp no GitHub

- NVIDIA Container Toolkit