Open WebUI: zelfgehoste LLM-interface

Zelfgehoste alternatief voor ChatGPT voor lokale LLMs

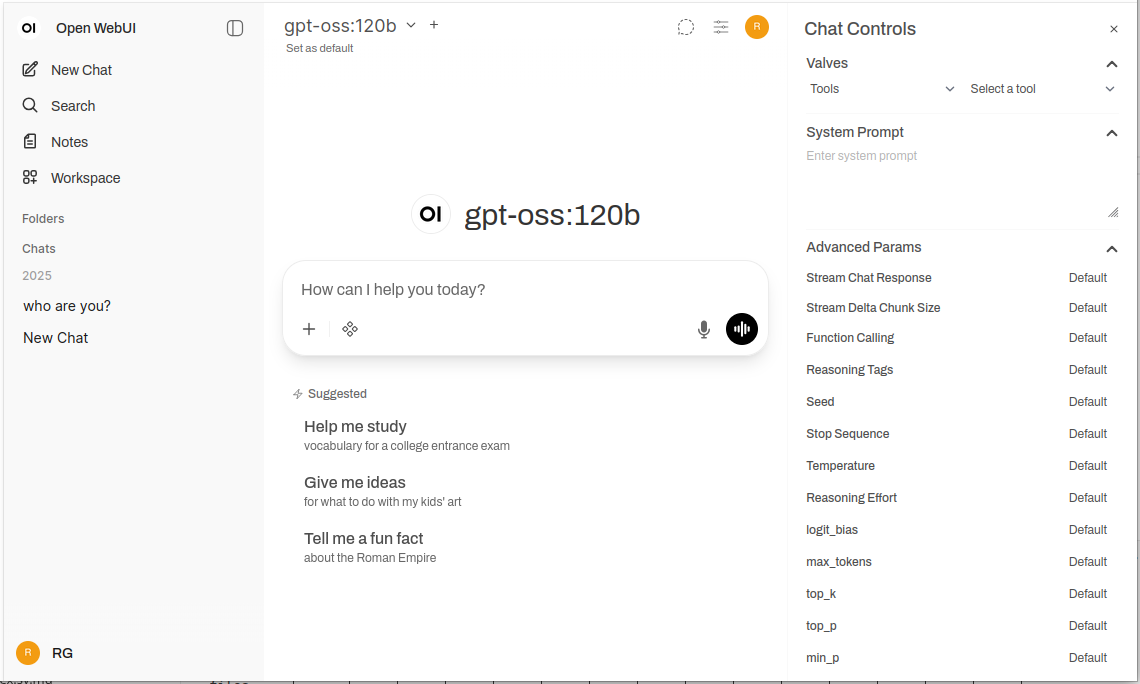

Open WebUI is een krachtig, uitbreidbaar en functierijk zelfgehost webinterface voor het communiceren met grote taalmodellen.

Het ondersteunt Ollama en elke OpenAI-compatibele API, waarmee de vertrouwde ChatGPT-ervaring naar je infrastructuur komt met volledige privacy, offline mogelijkheden en enterprise-gegradeerde functies. Voor een bredere vergelijking van lokale en cloud LLM-backends—Ollama, vLLM, Docker Model Runner, LocalAI en cloudproviders—zie LLM Hosting: Lokal, Zelfgehost & Cloud Infrastructuur Vergelijking.

Wat is Open WebUI?

Open WebUI is een open-source, zelfgehoste webtoepassing die een moderne chatinterface biedt voor het communiceren met grote taalmodellen. In tegenstelling tot cloudgebaseerde AI-diensten, draait Open WebUI volledig op je infrastructuur, waardoor je volledig controle hebt over je gegevens, gesprekken en modelkeuze.

Hoewel Open WebUI vaak wordt gebruikt met Ollama (en soms informeel wordt genoemd als een “Ollama WebUI”), is het eigenlijk een backend-onafhankelijke platform. Het kan verbinden met Ollama’s API voor lokale modeluitvoering, maar ondersteunt ook elke OpenAI-compatibele endpoint—waaronder vLLM, LocalAI, LM Studio, Text Generation WebUI en zelfs cloudproviders. Deze flexibiliteit maakt Open WebUI een omvattende oplossing die meerdere backends ondersteunt, RAG (Retrieval-Augmented Generation) voor documentchat, meervoudige gebruikersauthenticatie, spraakfunctionaliteiten en uitgebreide aanpassingsmogelijkheden. Of je nu modellen draait op een laptop, een thuisserver of een Kubernetes-cluster, Open WebUI schaalbaar is om jouw behoeften te voldoen.

Waarom Open WebUI kiezen?

Privacy First: Alle gegevens blijven op je infrastructuur—geen gesprekken, documenten of prompts verlaten je netwerk tenzij je expliciet externe APIs configureert.

Offline Capable: Ideaal voor geïsoleerde omgevingen, beperkte netwerken of situaties waarbij internettoegang onbetrouwbaar of verboden is. Wanneer je lokaal draaiende modellen gebruikt via Ollama of vLLM, bereik je volledige onafhankelijkheid van cloudservices.

Feature-Rich: Hoewel het zelfgehost is, kan Open WebUI concurreren met commerciële aanbiedingen met documentupload en RAG, gespreksgeschiedenis met semantische zoekopdrachten, promptsjablonen en delen, modelbeheer, spraakinvoer/uitvoer, mobiele responsieve ontwerp en donker/licht thema’s.

Multi-User Support: Ingebouwde authenticatie met rolgebaseerd toegangsbeheer (admin, gebruiker, wachtend), gebruikersbeheer dashboard, gespreksisolatie en gedeelde prompts en modellen over teams.

Snelle Installatiegids

De snelste manier om met Open WebUI te beginnen is met Docker. Deze sectie behandelt de meest voorkomende implementatiescenario’s.

Basisinstallatie (Verbinden met bestaande Ollama)

Als je al Ollama draait op je systeem, gebruik dan deze opdracht:

docker run -d \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

Dit draait Open WebUI op poort 3000, met persistentie van gegevens in een Docker volume. Toegang krijg je via http://localhost:3000.

Geïntegreerde installatie (Open WebUI + Ollama)

Voor een volledige all-in-one installatie met Ollama ingebouwd:

docker run -d \

-p 3000:8080 \

--gpus all \

-v ollama:/root/.ollama \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:ollama

De --gpus all vlag activeert GPU-toegang voor snellere inferentie. Omitteer deze als je alleen CPU gebruikt.

Docker Compose Setup

Voor productieimplementaties biedt Docker Compose betere onderhoudbaarheid:

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

ports:

- "11434:11434"

volumes:

- ollama:/root/.ollama

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

open-webui:

image: ghcr.io/open-webui/open-webui:main

ports:

- "3000:8080"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

volumes:

- open-webui:/app/backend/data

depends_on:

- ollama

restart: always

volumes:

ollama:

open-webui:

Implementeer met docker-compose up -d.

Kubernetes Implementatie

Voor enterprise-implementaties biedt Open WebUI Helm-diagrammen:

helm repo add open-webui https://helm.openwebui.com/

helm repo update

helm install open-webui open-webui/open-webui \

--set ollama.enabled=true \

--set ingress.enabled=true \

--set ingress.host=chat.yourdomain.com

Dit maakt een productiebereid implementatie met persistente opslag, gezondheidsschakelingen en optionele ingangskonfiguratie.

Diepe Inzichten in Kernfuncties

RAG en Document Chat

De RAG-implementatie van Open WebUI stelt je in staat om documenten te uploaden en het model te laten verwijzen naar hen in gesprekken. Het systeem verdeelt documenten automatisch, genereert embeddingen, slaat ze op in een vectordatabase en haalt relevante context op wanneer je vragen stelt.

Ondersteunde formaten: PDF, DOCX, TXT, Markdown, CSV en meer via ingebouwde parsers.

Gebruik: Klik op de ‘+’-knop in een chat, selecteer ‘Bestanden uploaden’, kies je documenten en begin met vragen stellen. Het model zal relevante passages en paginanummers in zijn antwoorden citeren.

Configuratie: Je kunt de chunkgrootte, overlappend, embeddingmodel en retrievalparameters aanpassen in de beheerinstellingen voor optimale prestaties met je documenttypen.

Multi-gebruikersauthenticatie en beheer

Open WebUI bevat een compleet authenticatiesysteem dat geschikt is voor team- en organisatiegebruik:

- Lokale authenticatie: Gebruikersnaam/wachtwoord met beveiligde wachtwoordhashing

- OAuth/OIDC-integratie: Verbind met bestaande identiteitsproviders (Google, GitHub, Keycloak, enz.)

- LDAP/Active Directory: Enterprise directory-integratie

- Rolgebaseerd toegangsbeheer: Admin (volledige controle), Gebruiker (standaardtoegang), Wachtend (vereist goedkeuring)

Beheerders kunnen gebruikers beheren, gebruik monitoren, modeltoegang per gebruiker/groep configureren en conversieretentiebeleid instellen.

Spraakinvoer en -uitvoer

Ingebouwde ondersteuning voor spraakinteractie maakt Open WebUI toegankelijk en handig:

- Speech-to-text: Gebruikt Web Speech API of geconfigureerde externe STT-diensten

- Text-to-speech: Meerdere TTS-engines ondersteund (browsergebaseerd, Coqui TTS, ElevenLabs, enz.)

- Taalondersteuning: Werkt met meerdere talen afhankelijk van je TTS/STT-configuratie

Prompt Engineering Tools

Open WebUI biedt robuuste tools voor promptbeheer:

- Promptbibliotheek: Sla vaakgebruikte prompts op als sjablonen

- Variabelen en placeholders: Maak herbruikbare prompts met dynamisch inhoud

- Promptdelen: Deel effectieve prompts met je team

- Promptversiebeheer: Volg veranderingen en verbeteringen over tijd

Modelbeheer

Eenvoudige modelswitching en beheer via de UI:

- Modelcatalogus: Blader en haal modellen direct op uit de Ollama-bibliotheek

- Aangepaste modellen: Upload en configureer aangepaste GGUF-modellen

- Modelparameters: Pas temperatuur, top-p, contextlengte en andere samplingparameters aan per conversatie

- Modelmetadata: Bekijk modeldetails, grootte, kwantificatie en functionaliteiten

Configuratie en Aanpassing

Omgevingsvariabelen

Belangrijke configuratieopties via omgevingsvariabelen:

# Backend URL (Ollama of other OpenAI-compatible API)

OLLAMA_BASE_URL=http://localhost:11434

# Enable authentication

WEBUI_AUTH=true

# Default user role (user, admin, pending)

DEFAULT_USER_ROLE=pending

# Enable user signup

ENABLE_SIGNUP=true

# Admin email (auto-create admin account)

WEBUI_ADMIN_EMAIL=admin@example.com

# Database (default SQLite, or PostgreSQL for production)

DATABASE_URL=postgresql://user:pass@host:5432/openwebui

# Enable RAG

ENABLE_RAG=true

# Embedding model for RAG

RAG_EMBEDDING_MODEL=sentence-transformers/all-MiniLM-L6-v2

Verbinding met alternatieve backends

Open WebUI werkt met elke OpenAI-compatibele API. Stel de basis-URL in in Instellingen → Verbindingen:

- vLLM:

http://localhost:8000/v1 - LocalAI:

http://localhost:8080 - LM Studio:

http://localhost:1234/v1 - Text Generation WebUI:

http://localhost:5000/v1 - OpenAI:

https://api.openai.com/v1(vereist API-sleutel) - Azure OpenAI: Aangepaste endpoint-URL

Reverse Proxy Configuratie

Voor productieimplementaties, draai Open WebUI achter een reverse proxy:

Nginx voorbeeld:

server {

listen 443 ssl http2;

server_name chat.yourdomain.com;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# WebSocket support

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}

Traefik voorbeeld (Docker labels):

labels:

- "traefik.enable=true"

- "traefik.http.routers.openwebui.rule=Host(`chat.yourdomain.com`)"

- "traefik.http.routers.openwebui.entrypoints=websecure"

- "traefik.http.routers.openwebui.tls.certresolver=letsencrypt"

- "traefik.http.services.openwebui.loadbalancer.server.port=8080"

Prestatieoptimalisatie

Database Tuning

Voor multi-gebruikersimplementaties, schakel over van SQLite naar PostgreSQL:

# Install dependencies

pip install psycopg2-binary

# Configure database URL

DATABASE_URL=postgresql://openwebui:password@postgres:5432/openwebui

PostgreSQL verwerkt concurrente gebruikers beter en biedt verbeterde queryprestaties voor conversiezoekopdrachten en RAG-acties.

Embedding Model Selectie

RAG-prestaties hangen sterk af van je keuze voor embeddingmodel:

- Snel/Resourcebeperkt:

all-MiniLM-L6-v2(384 dimensies, ~80MB) - Balans:

all-mpnet-base-v2(768 dimensies, ~420MB) - Beste kwaliteit:

bge-large-en-v1.5(1024 dimensies, ~1.3GB)

Configureer in Instellingen → RAG → Embeddingmodel.

Cachestrategieën

Activeer conversiecache om herhaalde API-aanroepen te verminderen:

- Modelcache: Ollama cacheert geladen modellen automatisch in het geheugen

- Reactiecache: Open WebUI kan identieke prompts cacheën (configurabel)

- Embeddingcache: Hergebruik embeddings voor eerder verwerkte documenten

Veiligheidsrichtlijnen

Wanneer je Open WebUI implementeert in productie, volg dan deze veiligheidsrichtlijnen:

- Authenticatie inschakelen: Nooit Open WebUI zonder authenticatie draaien op openbare netwerken

- HTTPS gebruiken: Altijd implementeren achter een reverse proxy met TLS/SSL

- Regelmatige updates: Houd Open WebUI en Ollama up-to-date voor veiligheidspatches

- Toegang beperken: Gebruik firewallregels om toegang te beperken tot vertrouwde netwerken

- API-sleutels beveiligen: Als je verbinding maakt met externe APIs, gebruik omgevingsvariabelen, nooit harcode sleutels

- Auditlogboeken: Schakel auditlogboeken in en bewaak toeganglogboeken voor verdachte activiteit

- Data back-ups: Regelmatig back-ups maken van de

/app/backend/datavolume - Database-encryptie: Schakel encryptie in rust aan voor PostgreSQL in productie

- Beperking van snelheid: Configureer snelheidslimieten om misbruik te voorkomen

- Inhoudsfiltering: Implementeer inhoudspolitieken die geschikt zijn voor je organisatie

Toepassingen en werkelijke gevallen

Persoonlijk Kennisassistent

Combineer Open WebUI met lokale modellen en RAG om een privé kennisbank te creëren. Upload je aantekeningen, onderzoeksrapporten, projectdocumentatie en persoonlijke documenten. Vraag er conversatief naar zonder gegevens naar cloudservices te sturen—ideaal voor onderzoekers, studenten en kenniswerkers die privacy waarderen.

Ontwikkelteamcolaboratie

Implementeer Open WebUI voor je ontwikkelteam met gedeelde toegang tot technische documentatie, API-specificaties en codebasisinformatie. De RAG-functie laat ontwikkelaars snel relevante informatie vinden over duizenden pagina’s documentatie, terwijl conversiegeschiedenis helpt bij het volgen van architecturale beslissingen en technische discussies.

Intern Chatbot voor bedrijven

Organisaties kunnen Open WebUI achter hun firewall implementeren met SSO-integratie, waarmee medewerkers toegang krijgen tot een AI-assistent die toegang heeft tot interne wikis, beleidsregels en procedures. Rolgebaseerd toegangsbeheer zorgt ervoor dat gevoelige informatie juist gesectioneerd blijft, terwijl beheercontroles governance en compliance behouden.

Onderwijs en opleiding

Onderwijsinstellingen gebruiken Open WebUI om studenten en docenten AI-ondersteuning te bieden zonder privacyzorgen. Upload cursusmateriaal, boeken en collegeaantekeningen voor contextuele vragen. Het multi-gebruikerssysteem stelt het volgen van gebruik mogelijk terwijl studentengegevens privé blijven.

Gezondheidszorg en juridische toepassingen

In gereguleerde industrieën waar dataprivacy kritisch is, maakt Open WebUI AI-ondersteunde workflows mogelijk terwijl HIPAA of GDPR-compliantie wordt behouden. Medische professionals kunnen drugdatabanken en behandelingprotocollen opvragen, terwijl juridische teams case law en contracten zoeken—allemaal zonder dat gegevens buiten beheerde infrastructuur komen.

Air-Gapped en Offlineomgevingen

Overheidsinstanties, onderzoeksinstellingen en beveiligde operatiecentra gebruiken Open WebUI in air-gapped netwerken. De volledige offlinefunctionaliteit zorgt ervoor dat AI-ondersteuning beschikbaar blijft zelfs zonder internetconnectiviteit, essentieel voor geheimhoudingsomgevingen of afgelegen locaties.

Probleemoplossing van algemene problemen

Verbindingsproblemen

Probleem: Open WebUI kan geen verbinding maken met Ollama

Oplossing: Controleer of Ollama draait (curl http://localhost:11434), controleer de OLLAMA_BASE_URL omgevingsvariabele en zorg ervoor dat firewallregels de verbinding toestaan. Voor Docker-implementaties, gebruik dienstnamen (http://ollama:11434) in plaats van localhost.

Probleem: Modellen verschijnen niet in de UI

Oplossing: Bevestig dat modellen zijn geïnstalleerd (ollama list), vernieuw de modellijst in Open WebUI-instellingen en controleer de browserconsole op API-fouten.

RAG en Documentuploadproblemen

Probleem: Documentupload mislukt

Oplossing: Controleer bestandsgroottebeperkingen in instellingen, bevestig ondersteunde bestandsformaat, zorg ervoor dat er voldoende schijfruimte is in het datavolume en controleer containerlogboeken op parsingfouten.

Probleem: RAG-antwoorden verwijzen niet naar geüploade documenten

Oplossing: Bevestig dat het embeddingmodel gedownload en draait, controleer chunkgrootte-instellingen (probeer kleinere chunks voor betere granulariteit), verhoog het aantal opgehaalde chunks in RAG-instellingen en zorg ervoor dat de query relevant is voor documentinhoud.

Prestatieproblemen

Probleem: Snelheidsslechte prestaties

Oplossing: Schakel GPU-accelleratie in als beschikbaar, verminder modelgrootte of gebruik gekwantificeerde versies, verhoog OLLAMA_NUM_PARALLEL voor concurrente aanvragen en toekortkomend RAM aan Docker-containers.

Probleem: Geheugenfouten

Oplossing: Gebruik kleinere modellen (7B in plaats van 13B parameters), verminder contextlengte in modelparameters, beperk concurrente gebruikers of voeg meer RAM/swapruimte toe aan je systeem.

Authenticatie en toegang

Probleem: Niet kunnen inloggen of adminaccount aanmaken

Oplossing: Stel WEBUI_AUTH=true, configureer WEBUI_ADMIN_EMAIL om een admin automatisch aan te maken, wis browsercookies en cache en controleer containerlogboeken op databasefouten.

Probleem: Gebruikers kunnen zich niet registreren

Oplossing: Bevestig ENABLE_SIGNUP=true, controleer DEFAULT_USER_ROLE instelling (gebruik user voor automatische goedkeuring of pending voor handmatige goedkeuring) en zorg ervoor dat de database schrijfbaar is.

Alternatieven voor Open WebUI

Hoewel Open WebUI uitstekend is in het bieden van een zelfgehoste interface met sterke Ollama-integratie, bieden verschillende alternatieven andere aanpakken voor hetzelfde probleemgebied. Je keuze hangt af van of je meerdere providerflexibiliteit, gespecialiseerde documentverwerking, extreme eenvoud of enterprisefunctionaliteiten nodig hebt.

LibreChat onderscheidt zich als de meest provider-onafhankelijke oplossing, met native ondersteuning voor OpenAI, Anthropic, Azure OpenAI, Google Vertex AI, AWS Bedrock en Ollama in één interface. Zijn pluginarchitectuur en enterprisefunctionaliteiten zoals meervoudige huurders, gedetailleerde toegangscontrole en gebruikquota maken het ideaal voor organisaties die meerdere AI-providers willen ondersteunen of complexe audittraces nodig hebben. De tegenwicht is complexiteit—LibreChat vereist meer setup-effort en zwaardere resources dan Open WebUI, en de Ollama-ondersteuning voelt secundair ten opzichte van cloudproviders. Als je team Claude gebruikt voor schrijven, GPT-4 voor coding en lokale modellen voor privacygevoelige werk, schijnt LibreChat’s geïntegreerde interface.

Voor documentintensieve workflows, AnythingLLM neemt een kennisbank-first aanpak die gaat verder dan basis RAG. Zijn werkruimtemodel organiseert documenten en conversaties in geïsoleerde omgevingen, terwijl geavanceerde ophalenfunctionaliteiten inclusief hybride zoekopdrachten, herordening en citatievolging zijn. Dataconnectors halen content op van GitHub, Confluence en Google Drive, en agentfunctionaliteiten bevorderen meervoudige redenering en werkstroomautomatisering. Dit maakt AnythingLLM uitstekend geschikt voor consultancybedrijven die meerdere cliëntkennisbanken beheren of ondersteuneteams die werken met uitgebreide documentatie. De chatinterface is minder gepolijst dan Open WebUI, maar als het queryn van grote documentcollecties je primaire behoefte is, rechtvaardigen de geavanceerde ophalenfunctionaliteiten de steilere leercurve.

LobeChat prioriteert gebruikerservaring boven functie diepgang, met een slanke, mobiele vriendelijke interface met progressieve webapp-voorzieningen. Zijn moderne ontwerp, soepele animaties en sterke spraak/multimodale ondersteuning maken het populair bij designers en niet-technische gebruikers die een AI-assistent willen die naadloos werkt over apparaten. De PWA-implementatie biedt een app-achtige mobiele ervaring die Open WebUI niet evenaart. Echter, enterprisefunctionaliteiten zijn beperkt, de plugin-ecosysteem is kleiner en RAG-functionaliteiten zijn achterstand op zowel Open WebUI als AnythingLLM.

Voor gebruikers die voorkeur geven aan desktopapplicaties, Jan.ai biedt cross-platform installers (Windows, macOS, Linux) met zero-configuration lokale modelbeheer. Er is geen behoefte om Ollama apart te installeren of met Docker te werken—Jan bundelt alles in een native app met systeemvakondersteuning en één-klik modeldownloads. Deze “het werkt gewoon” filosofie maakt Jan ideaal voor het geven van lokale LLMs aan familieleden of collega’s die niet comfortabel zijn met command-line tools. De tegenwicht is geen meervoudige gebruikersondersteuning, minder geavanceerde functionaliteiten en geen remote toegangsfunctionaliteit.

Chatbox beslaat het lichtgewicht niche—een minimale cross-platform client die OpenAI, Claude, Gemini en lokale APIs ondersteunt met zeer lage resourceoverhead. Het is perfect voor ontwikkelaars die snel verschillende API-providers willen testen of gebruikers met beperkte hardware. De setupwrijving is klein, maar sommige functies zijn abonnementsgesloten, het is niet volledig open-source en RAG-ondersteuning is beperkt.

Een aantal Ollama-specifieke minimale UIs bestaan voor gebruikers die “net genoeg” interface willen: Hollama beheert meerdere Ollama-servers over verschillende machines, Ollama UI biedt basischat en PDF-upload met extreem eenvoudige implementatie, en Oterm biedt een verrassend krachtige terminalgebaseerde interface voor SSH-sessies en tmux-werkstromen. Deze geven functies op voor eenvoud en snelheid.

Voor organisaties die leveranciersondersteuning nodig hebben, bieden commerciële opties zoals TypingMind Team, BionicGPT en Dust.tt zelfgehosting met professionele ondersteuning, compliancecertificaten en SLAs. Ze geven open-source vrijheid op voor gegarandeerde uptime, beveiligingsaudits en aansprakelijkheid—geschikt wanneer je organisatie enterprise-grade ondersteuningscontracten nodig heeft.

Slim kiezen: Open WebUI raakt het juiste middenpunt voor de meeste zelfgehoste Ollama-implementaties, balancerend tussen uitgebreide functionaliteiten en beheersbare complexiteit. Kies LibreChat wanneer providerflexibiliteit essentieel is, AnythingLLM voor geavanceerde documentworkflows, LobeChat voor mobiel-first of designbewuste gebruikers, Jan voor niet-technische desktopgebruikers of commerciële opties wanneer je leveranciersondersteuning nodig hebt. Voor de meeste technische gebruikers die lokale modellen draaien, maakt Open WebUI’s actieve ontwikkeling, sterke community en uitstekende RAG-implementatie het aanbevolen startpunt.

Toekomstige ontwikkelingen en roadmap

Open WebUI blijft snel ontwikkelen met verschillende opwindende functies op de roadmap:

Verbeterde multimodale ondersteuning: Betere verwerking van beelden, visuele modellen en multimodale conversaties met modellen zoals LLaVA en Bakllava.

Versterkte agentfunctionaliteiten: Functieoproepen, toolgebruik en meervoudige redeneringsworkflows vergelijkbaar met AutoGPT patronen.

Beter mobiele apps: Native iOS en Android applicaties buiten de huidige PWA-implementatie voor verbeterde mobiele ervaring.

Geavanceerde RAG-functionaliteiten: Grafisch gebaseerde RAG, semantische chunking, meervoudige query retrieval en parent-document retrieval voor betere context.

Samenwerkingfunctionaliteiten: Gedeelde conversaties, teamworkspaces en real-time samenwerking op prompts en documenten.

Enterprise integraties: Dieper SSO-ondersteuning, SCIM-provisionering, geavanceerde auditlogboeken en complianceverslagen voor gereguleerde industrieën.

Het project behoudt achterwaartse compatibiliteit en semantische versienummering, waardoor upgrades eenvoudig zijn. Het actieve GitHub-repository ziet dagelijks commits en responsieve probleembeheer.

Conclusie

Open WebUI is uitgegroeid van een eenvoudige Ollama-frontend tot een uitgebreid platform voor zelfgehoste AI-interacties. Zijn combinatie van privacy, functionaliteiten en eenvoudige implementatie maakt het een uitstekke keuze voor individuen, teams en organisaties die lokale LLMs willen gebruiken zonder capaciteiten te verliezen.

Of je nu een ontwikkelaar bent die modellen test, een organisatie die interne AI-tools bouwt of een individu die privacy prioriteert, biedt Open WebUI de basis voor krachtige, zelfgehoste AI-workflows. De actieve community, regelmatige updates en uitbreidbare architectuur zorgen ervoor dat het blijft een leidinggevende optie in de zelfgehoste AI-ruimte.

Begin met de basis Docker-installatie, experimenteer met RAG door een paar documenten te uploaden, probeer verschillende modellen van de Ollama-bibliotheek en verkennen geleidelijk geavanceerde functionaliteiten terwijl je behoeften groeien. De leercurve is mild, maar het plafond is hoog—Open WebUI schaalt van persoonlijke laptop tot enterprise Kubernetes-cluster.

Voor diegenen die alternatieven vergelijken, is de Ollama-first ontwerp van Open WebUI, evenwichtige functionaliteiten en actieve ontwikkeling de aanbevolen startpunt voor de meeste zelfgehoste LLM-implementaties. Je kunt altijd migreren naar meer gespecialiseerde oplossingen als specifieke behoeften zich ontwikkelen, maar veel gebruikers vinden de functionaliteiten van Open WebUI voldoende voor hun hele reis van experimenten tot productie.

Om te zien hoe Open WebUI’s typische backends (Ollama, vLLM, enz.) passen bij Docker Model Runner, LocalAI en cloudproviders, raadpleeg onze [LLM Hosting: Lokal, Zelfgehost & Cloud Infrastructuur Vergelijking](https://www.glukhov.org/nl/llm-hosting/ “Compleet gids voor LLM hosting in 2026. Vergelijk Ollama, vLL段.

Nuttige links

Wanneer je je Open WebUI-omgeving instelt, is het nuttig om de bredere ecosystem van lokale LLM-hosting en implementatieopties te begrijpen. De uitgebreide gids Lokale LLM-hosting: Compleet 2025-gids - Ollama, vLLM, LocalAI, Jan, LM Studio & Meer vergelijkt 12+ lokale LLM-tools inclusief Ollama, vLLM, LocalAI en meer, waarmee je de optimale backend kunt kiezen voor je Open WebUI-implementatie op basis van API-maturiteit, toolcallingfunctionaliteiten en prestatiebenchmarks.

Voor high-performance productieimplementaties waar doorstroming en latentie kritisch zijn, verkrijgbaar de vLLM Quickstart: High-Performance LLM Serving gids, die vLLM setup met Docker, OpenAI API compatibiliteit en PagedAttention optimalisatie behandelt. Dit is vooral waardevol als Open WebUI meerdere concurrente gebruikers serveert en Ollama’s prestaties een bottleneck worden.

Het begrijpen hoe je backend concurrente aanvragen verwerkt is cruciaal voor capaciteitsplanning. Het artikel Hoe Ollama Concurrente Aanvragen Verwerkt legt uit Ollama’s aanvraagwachtrij, GPU-geheugenbeheer en concurrente uitvoeringsmodel, waarmee je passende limieten en verwachtingen kunt configureren voor je Open WebUI-implementatie’s meervoudige gebruikersscenario’s.

Externe bronnen

Voor officiële documentatie en communityondersteuning, verwijzen naar deze externe bronnen: