Cross-Modale Embeddingen: Bruggen tussen AI-modellen

Vereenig tekst, afbeeldingen en audio in gedeelde embedding-ruimtes

Cross-modale ingebedden stellen een doorbraak voor in de kunstmatige intelligentie, waardoor begrip en redeneren mogelijk worden over verschillende gegefstypen binnen een gedeelde representatie-ruimte.

Deze technologie voedt moderne multimodale toepassingen van beeldzoekopdrachten tot inhoudsgeneratie.

Dit beeld komt uit het artikel:

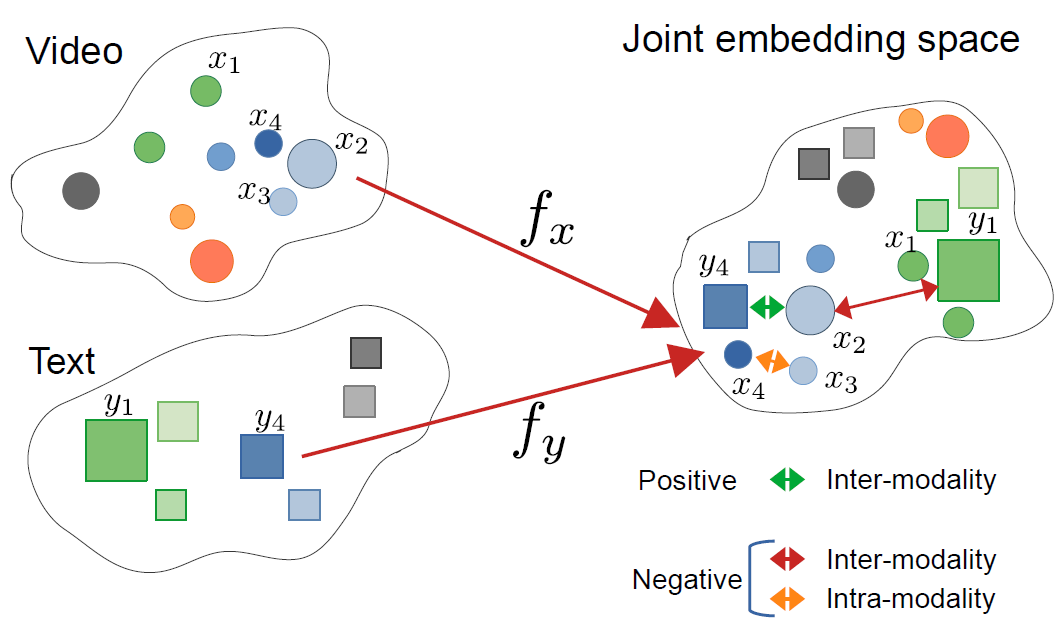

CrossCLR: cross-modal contrastive learning for multi-modal video representations, by Mohammadreza Zolfaghari and others

Dit beeld komt uit het artikel:

CrossCLR: cross-modal contrastive learning for multi-modal video representations, by Mohammadreza Zolfaghari and others

Begrijpen van cross-modale ingebedden

Cross-modale ingebedden zijn vectorrepresentaties die informatie van verschillende modaliteiten—zoals tekst, beelden, geluid en video—coderen in een gedeelde ingebedde ruimte. In tegenstelling tot traditionele enkel-modale ingebedden leren cross-modale benaderingen een gedeelde representatie waarin semantisch vergelijkbare concepten samenkluiten, ongeacht hun oorspronkelijke formaat.

Wat zijn cross-modale ingebedden?

Aan hun kern oplossen cross-modale ingebedden een cruciale uitdaging in de AI: hoe informatie te vergelijken en te relateren over verschillende gegefstypen. Een traditionele beeldclassificator kan alleen met beelden werken, terwijl een tekstmodel alleen tekst verwerkt. Cross-modale ingebedden bruggen deze kloof door verschillende modaliteiten te projecteren in een gemeenschappelijke vectorruimte waar:

- Een beeld van een kat en het woord “kat” hebben vergelijkbare ingebedde vectoren

- Semantische relaties worden behouden over modaliteiten

- Afstandsmaten (cosinus-afstand, Euclidische afstand) meten cross-modale gelijkenis

Deze gedeelde representatie maakt krachtige mogelijkheden mogelijk zoals het zoeken naar beelden met tekstquery’s, het genereren van beschrijvingen van beelden of zelfs nul-shot classificatie zonder taakspecifieke training.

De architectuur achter cross-modale leren

Moderne cross-modale systemen gebruiken meestal dubbel-encoderarchitecturen met contrastieve leerdoelen:

Dubbele encoders: Afzonderlijke neurale netwerken coderen elk gegefstype. Bijvoorbeeld, CLIP gebruikt:

- Een visuele transformer (ViT) of ResNet voor beelden

- Een transformergebaseerde tekstencoder voor taal

Contrastieve leren: Het model leert door de gelijkenis te maximaliseren tussen overeenkomstige paren (bijvoorbeeld beeld en beschrijving) en de gelijkenis te minimaliseren tussen niet-overeenkomstige paren. De contrastieve verliesfunctie kan worden uitgedrukt als:

$$ \mathcal{L} = -\log \frac{\exp(\text{sim}(v_i, t_i) / \tau)}{\sum_{j=1}^{N} \exp(\text{sim}(v_i, t_j) / \tau)} $$

waarbij $v_i$ de beeldingebedde is, $t_i$ de tekstingebedde is, $\text{sim}$ de gelijkenis is (meestal cosinus), en $\tau$ een temperatuurparameter is.

Belangrijke technologieën en modellen

CLIP: Pionier van visuele taalbegrip

OpenAI’s CLIP (Contrastive Language-Image Pre-training) revolutioneerde het veld door het op te trainen op 400 miljoen beeld-tekstparen van internet. De modelarchitectuur bestaat uit:

import torch

from transformers import CLIPProcessor, CLIPModel

from PIL import Image

# Laad vooraf getrainde CLIP model

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

# Voorbereid invoer

image = Image.open("example.jpg")

texts = ["een foto van een kat", "een foto van een hond", "een foto van een vogel"]

# Verwerk en krijg ingebedden

inputs = processor(text=texts, images=image, return_tensors="pt", padding=True)

# Krijg cross-modale gelijkenis scores

outputs = model(**inputs)

logits_per_image = outputs.logits_per_image

probs = logits_per_image.softmax(dim=1)

print(f"Kansen: {probs}")

CLIP’s belangrijkste innovatie was schaal en eenvoud. Door op grote webgegevens te trainen zonder handmatige annotaties, bereikte het opvallende nul-shot overdrachtsmogelijkheden. Hoe verschilt CLIP van traditionele visuele modellen? In tegenstelling tot beheerdersclassificatoren die op vaste labelsets worden getraind, leert CLIP van natuurlijke taalbegeleiding, waardoor het aanpasbaar is aan elke visuele concept beschrijvingbaar in tekst.

ImageBind: Uitbreiden naar zes modaliteiten

Meta’s ImageBind breidt cross-modale ingebedden uit tot naast visuele en taalmodaliteiten, met inbegrip van:

- Audio (omgevingsgeluiden, spraak)

- Diepte-informatie

- Thermische beeldvorming

- IMU (bewegingsensor) gegevens

Dit creëert een echt multimodale ingebedde ruimte waarin alle zes de modaliteiten worden uitgelijnd. Het belangrijkste inzicht is dat beelden dienen als een “bindende” modus—door beelden te combineren met andere modaliteiten en bestaande visuele taaluitlijning te gebruiken, creëert ImageBind een gedeelde ruimte zonder dat alle mogelijke modusparen tijdens het trainen nodig zijn.

Open-source alternatieven

Het ecosysteem is uitgebreid met verschillende open-source implementaties:

OpenCLIP: Een gemeenschapimplementatie die grotere modellen en diverse trainingsrecepten biedt:

import open_clip

model, _, preprocess = open_clip.create_model_and_transforms(

'ViT-L-14',

pretrained='laion2b_s32b_b82k'

)

tokenizer = open_clip.get_tokenizer('ViT-L-14')

LAION-5B modellen: Opgetraind op de enorme open LAION-5B dataset, bieden ze alternatieven voor proprietaire modellen met vergelijkbare of betere prestaties.

Voor ontwikkelaars die geïnteresseerd zijn in state-of-the-art open-source tekstingebedde oplossingen, bieden de Qwen3 Embedding & Reranker Modellen op Ollama uitstekende multilingual prestaties met eenvoudige lokale implementatie.

Implementatiestrategieën

Bouwen van een cross-modale zoeksysteem

Een praktische implementatie van cross-modale ingebedden voor semantische zoekopdrachten omvat verschillende componenten. Wat zijn de belangrijkste toepassingen van cross-modale ingebedden? Ze voeden gebruikscases van e-commerce productzoekopdrachten tot inhoudsmoderatie en creatieve tools.

import numpy as np

from typing import List, Tuple

import faiss

from transformers import CLIPModel, CLIPProcessor

class CrossModalSearchEngine:

def __init__(self, model_name: str = "openai/clip-vit-base-patch32"):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.image_index = None

self.image_metadata = []

def encode_images(self, images: List) -> np.ndarray:

"""Encode images into embeddings"""

inputs = self.processor(images=images, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_image_features(**inputs)

return embeddings.cpu().numpy()

def encode_text(self, texts: List[str]) -> np.ndarray:

"""Encode text queries into embeddings"""

inputs = self.processor(text=texts, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_text_features(**inputs)

return embeddings.cpu().numpy()

def build_index(self, image_embeddings: np.ndarray):

"""Build FAISS index for efficient similarity search"""

dimension = image_embeddings.shape[1]

# Normalize embeddings for cosine similarity

faiss.normalize_L2(image_embeddings)

# Create index (using HNSW for large-scale deployment)

self.image_index = faiss.IndexHNSWFlat(dimension, 32)

self.image_index.hnsw.efConstruction = 40

self.image_index.add(image_embeddings)

def search(self, query: str, k: int = 10) -> List[Tuple[int, float]]:

"""Search for images using text query"""

query_embedding = self.encode_text([query])

faiss.normalize_L2(query_embedding)

distances, indices = self.image_index.search(query_embedding, k)

return list(zip(indices[0], distances[0]))

# Usage example

engine = CrossModalSearchEngine()

# Build index from image collection

image_embeddings = engine.encode_images(image_collection)

engine.build_index(image_embeddings)

# Search with text

results = engine.search("zonsopgang over bergen", k=5)

Fijnafstemming voor domein-specifieke taken

Hoewel vooraf getrainde modellen goed werken voor algemene doeleinden, profiteren domein-specifieke toepassingen van fijnafstemming:

from transformers import CLIPModel, CLIPProcessor, AdamW

import torch.nn as nn

class FineTuneCLIP:

def __init__(self, model_name: str, num_epochs: int = 10):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.num_epochs = num_epochs

def contrastive_loss(self, image_embeddings, text_embeddings, temperature=0.07):

"""Compute InfoNCE contrastive loss"""

# Normalize embeddings

image_embeddings = nn.functional.normalize(image_embeddings, dim=1)

text_embeddings = nn.functional.normalize(text_embeddings, dim=1)

# Compute similarity matrix

logits = torch.matmul(image_embeddings, text_embeddings.T) / temperature

# Labels are diagonal (matching pairs)

labels = torch.arange(len(logits), device=logits.device)

# Symmetric loss

loss_i = nn.functional.cross_entropy(logits, labels)

loss_t = nn.functional.cross_entropy(logits.T, labels)

return (loss_i + loss_t) / 2

def train(self, dataloader, learning_rate=5e-6):

"""Fine-tune on domain-specific data"""

optimizer = AdamW(self.model.parameters(), lr=learning_rate)

self.model.train()

for epoch in range(self.num_epochs):

total_loss = 0

for batch in dataloader:

images, texts = batch['images'], batch['texts']

# Process inputs

inputs = self.processor(

text=texts,

images=images,

return_tensors="pt",

padding=True

)

# Forward pass

outputs = self.model(**inputs, return_loss=True)

loss = outputs.loss

# Backward pass

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_loss += loss.item()

avg_loss = total_loss / len(dataloader)

print(f"Epoch {epoch+1}/{self.num_epochs}, Loss: {avg_loss:.4f}")

Overwegingen voor productieimplementatie

Optimaliseren van inferentieprestaties

Hoe kan ik cross-modale ingebedden optimaliseren voor productie? Prestatieoptimalisatie is cruciaal voor reële implementatie:

Modelquantisatie: Verminder modelgrootte en verhoog inferentiesnelheid:

import torch

from torch.quantization import quantize_dynamic

# Dynamische quantisatie voor CPU-inferentie

quantized_model = quantize_dynamic(

model,

{torch.nn.Linear},

dtype=torch.qint8

)

ONNX-conversie: Exporteer naar ONNX voor optimaliseerde inferentie:

import torch.onnx

dummy_input = processor(text=["voorbeeld"], return_tensors="pt")

torch.onnx.export(

model,

tuple(dummy_input.values()),

"clip_model.onnx",

input_names=['input_ids', 'attention_mask'],

output_names=['output'],

dynamic_axes={

'input_ids': {0: 'batch_size'},

'attention_mask': {0: 'batch_size'}

}

)

Batchverwerking: Maximaliseer GPU-gebruik via batchverwerking:

def batch_encode(items: List, batch_size: int = 32):

"""Process items in batches for efficiency"""

embeddings = []

for i in range(0, len(items), batch_size):

batch = items[i:i+batch_size]

batch_embeddings = encode_batch(batch)

embeddings.append(batch_embeddings)

return np.concatenate(embeddings, axis=0)

Schaalbare vectoropslag

Voor grote toepassingen zijn vectordatabases essentieel. Welke frameworks ondersteunen cross-modale ingebedde implementaties? Buiten de modellen zelf, is infrastructuur belangrijk:

FAISS (Facebook AI Similarity Search): Efficiënte gelijkeniszoekopdrachtenbibliotheek

- Ondersteunt miljarden vectoren

- Verschillende indexsoorten (plat, IVF, HNSW)

- GPU-acceleratie beschikbaar

Milvus: Open-source vectordatabase

from pymilvus import connections, Collection, FieldSchema, CollectionSchema, DataType

# Definieer schema

fields = [

FieldSchema(name="id", dtype=DataType.INT64, is_primary=True, auto_id=True),

FieldSchema(name="embedding", dtype=DataType.FLOAT_VECTOR, dim=512),

FieldSchema(name="metadata", dtype=DataType.JSON)

]

schema = CollectionSchema(fields, description="Beeldingebedden")

# Creëer collectie

collection = Collection("beelden", schema)

# Creëer index

index_params = {

"metric_type": "IP", # Inwendig product (cosinusgelijkenis)

"index_type": "IVF_FLAT",

"params": {"nlist": 1024}

}

collection.create_index("embedding", index_params)

Pinecone/Weaviate: Beheerde vectordatabase-diensten die makkelijke schaalbaarheid en onderhoud bieden.

Geavanceerde gebruikscases en toepassingen

Nul-shot classificatie

Cross-modale ingebedden maken classificatie mogelijk zonder taakspecifieke training. Deze mogelijkheid gaat verder dan traditionele computer visionbenaderingen—bijvoorbeeld, als je geïnteresseerd bent in meer gespecialiseerde objectdetectie met TensorFlow, dat een aanvullende beheerdersleerbenadering voor specifieke detectietaken vertegenwoordigt.

def zero_shot_classify(image, candidate_labels: List[str], model, processor):

"""Classificeer beeld in willekeurige categorieën"""

# Creëer tekstprompts

text_inputs = [f"een foto van een {label}" for label in candidate_labels]

# Krijg ingebedden

inputs = processor(

text=text_inputs,

images=image,

return_tensors="pt",

padding=True

)

outputs = model(**inputs)

# Bereken waarschijnlijkheid

logits = outputs.logits_per_image

probs = logits.softmax(dim=1)

# Retourneer gerangschikte voorspellingen

sorted_indices = probs.argsort(descending=True)[0]

return [(candidate_labels[idx], probs[0][idx].item()) for idx in sorted_indices]

# Voorbeeldgebruik

labels = ["kat", "hond", "vogel", "vis", "paard"]

predictions = zero_shot_classify(image, labels, model, processor)

print(f"Topvoorspelling: {predictions[0]}")

Multimodale RAG (Retrieval-Augmented Generation)

Het combineren van cross-modale ingebedden met taalmodellen creëert krachtige multimodale RAG-systemen. Nadat je relevante documenten hebt opgehaald, kan herordenen met ingebedde modellen de kwaliteit van de resultaten aanzienlijk verbeteren door de opgehaalde kandidaten opnieuw te ordenen op basis van relevantie:

class MultimodalRAG:

def __init__(self, clip_model, llm_model):

self.clip = clip_model

self.llm = llm_model

self.knowledge_base = []

def add_documents(self, images, texts, metadata):

"""Voeg multimodale documenten toe aan kennisbank"""

image_embeds = self.clip.encode_images(images)

text_embeds = self.clip.encode_text(texts)

# Sla gecombineerde informatie op

for i, (img_emb, txt_emb, meta) in enumerate(

zip(image_embeds, text_embeds, metadata)

):

self.knowledge_base.append({

'image_embedding': img_emb,

'text_embedding': txt_emb,

'metadata': meta,

'index': i

})

def retrieve(self, query: str, k: int = 5):

"""Haal relevante multimodale inhoud op"""

query_embedding = self.clip.encode_text([query])[0]

# Bereken gelijkenissen

similarities = []

for doc in self.knowledge_base:

# Gemiddelde gelijkenis over modaliteiten

img_sim = np.dot(query_embedding, doc['image_embedding'])

txt_sim = np.dot(query_embedding, doc['text_embedding'])

combined_sim = (img_sim + txt_sim) / 2

similarities.append((combined_sim, doc))

# Retourneer top-k

similarities.sort(reverse=True)

return [doc for _, doc in similarities[:k]]

def answer_query(self, query: str):

"""Beantwoord query met behulp van opgehaalde multimodale context"""

retrieved_docs = self.retrieve(query)

# Construeer context uit opgehaalde documenten

context = "\n".join([doc['metadata']['text'] for doc in retrieved_docs])

# Genereer antwoord met LLM

prompt = f"Context:\n{context}\n\nVraag: {query}\n\nAntwoord:"

answer = self.llm.generate(prompt)

return answer, retrieved_docs

Als je productie RAG-systemen implementeert in Go, vind je deze gids over herordenen van tekstdocumenten met Ollama en Qwen3 Embedding model in Go mogelijk erg nuttig voor het optimaliseren van ophaalkwaliteit.

Inhoudsmoderatie en veiligheid

Cross-modale ingebedden excelleren bij het detecteren van ongepaste inhoud over modaliteiten:

class ContentModerator:

def __init__(self, model, processor):

self.model = model

self.processor = processor

# Definieer veiligheidscategorieën

self.unsafe_categories = [

"gewelddadige inhoud",

"volwassen inhoud",

"haatvolle beelden",

"grafische geweld",

"expliciete materialen"

]

self.safe_categories = [

"veilig voor werk",

"gezinsvriendelijk",

"educatieve inhoud"

]

def moderate_image(self, image, threshold: float = 0.3):

"""Controleer of beeld onveilige inhoud bevat"""

# Combineer alle categorieën

all_categories = self.unsafe_categories + self.safe_categories

text_inputs = [f"beeld bevattend {cat}" for cat in all_categories]

# Krijg voorspellingen

inputs = self.processor(

text=text_inputs,

images=image,

return_tensors="pt"

)

outputs = self.model(**inputs)

probs = outputs.logits_per_image.softmax(dim=1)[0]

# Controleer onveilige categorieën

unsafe_scores = probs[:len(self.unsafe_categories)]

max_unsafe_score = unsafe_scores.max().item()

return {

'is_safe': max_unsafe_score < threshold,

'confidence': 1 - max_unsafe_score,

'flagged_categories': [

self.unsafe_categories[i]

for i, score in enumerate(unsafe_scores)

if score > threshold

]

}

Beste praktijken en veelvoorkomende valkuilen

Gegevensvoorverwerking

Propere voorverwerking is cruciaal voor optimale prestaties:

from torchvision import transforms

# Standaard CLIP-voorverwerking

clip_transform = transforms.Compose([

transforms.Resize(224, interpolation=transforms.InterpolationMode.BICUBIC),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(

mean=[0.48145466, 0.4578275, 0.40821073],

std=[0.26862954, 0.26130258, 0.27577711]

)

])

Het hanteren van bias en eerlijkheid

Cross-modale modellen kunnen bias overnemen van trainingsgegevens:

Mitigatiestrategieën:

- Evalueren op diverse demografische groepen

- Gebruik debiasingtechnieken tijdens fijnafstemming

- Implementeer eerlijkheidsgerechte ophaal

- Regelmatige audit en monitoring in productie

Ingebedde kwaliteitsbeoordeling

Monitor ingebedde kwaliteit in productie:

def assess_embedding_quality(embeddings: np.ndarray):

"""Bereken metrieken voor ingebedde kwaliteit"""

# Bereken gemiddelde paarsgewijze afstand

distances = np.linalg.norm(

embeddings[:, None] - embeddings[None, :],

axis=2

)

avg_distance = distances.mean()

# Controleer clustering (lage intra-cluster afstand)

from sklearn.cluster import KMeans

kmeans = KMeans(n_clusters=10)

labels = kmeans.fit_predict(embeddings)

# Bereken silhouette score

from sklearn.metrics import silhouette_score

score = silhouette_score(embeddings, labels)

return {

'avg_pairwise_distance': avg_distance,

'silhouette_score': score

}

Docker-implementatievoorbeeld

Pak je cross-modale toepassing in voor eenvoudige implementatie:

FROM nvidia/cuda:11.8.0-cudnn8-runtime-ubuntu22.04

# Installeer Python en afhankelijkheden

RUN apt-get update && apt-get install -y python3-pip

WORKDIR /app

# Installeer vereisten

COPY requirements.txt .

RUN pip3 install --no-cache-dir -r requirements.txt

# Kopieer toepassingscode

COPY . .

# Expose API-poort

EXPOSE 8000

# Voer API-server uit

CMD ["uvicorn", "api:app", "--host", "0.0.0.0", "--port", "8000"]

# api.py - FastAPI-server voor cross-modale ingebedden

from fastapi import FastAPI, File, UploadFile

from pydantic import BaseModel

import torch

from PIL import Image

import io

app = FastAPI()

# Laad model bij opstarten

@app.on_event("startup")

async def load_model():

global model, processor

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

if torch.cuda.is_available():

model = model.cuda()

class TextQuery(BaseModel):

text: str

@app.post("/embed/text")

async def embed_text(query: TextQuery):

inputs = processor(text=[query.text], return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_text_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/embed/image")

async def embed_image(file: UploadFile = File(...)):

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(images=image, return_tensors="pt")

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_image_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/similarity")

async def compute_similarity(

text: TextQuery,

file: UploadFile = File(...)

):

# Krijg beide ingebedden

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(text=[text.text], images=image, return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

outputs = model(**inputs)

similarity = outputs.logits_per_image[0][0].item()

return {"similarity": similarity}

Toekomstige richtingen

Het veld van cross-modale ingebedden ontwikkelt zich snel:

Grotere modale dekking: Toekomstige modellen zullen waarschijnlijk extra modaliteiten zoals aanraking (haptische feedback), geur en smaakdata opnemen voor echt omvattende multimodale begrip.

Verbeterde efficiëntie: Onderzoek naar distillatie en efficiënte architecturen maakt krachtige cross-modale modellen toegankelijk op randapparaten.

Betere uitlijning: Geavanceerde technieken voor het uitlijnen van modaliteiten met meer precisie, inclusief cyclische consistentieverliezen en adversariale training.

Compositieel begrip: Overgang van eenvoudig objectherkenning naar het begrip van complexe relaties en samenstellingen over modaliteiten.

Tijdsafhankelijke modellering: Betere verwerking van video en tijdsreeksen met expliciete tijdsafhankelijke redenering in ingebedde ruimtes.

Nuttige links

- OpenAI CLIP Repository

- OpenCLIP: Open Source Implementatie

- Hugging Face Transformers Documentatie

- Meta ImageBind

- LAION-5B Dataset

- FAISS Documentatie

- Milvus Vector Database

- Pinecone Vector Database

- Paper: Learning Transferable Visual Models From Natural Language Supervision

- Paper: ImageBind: One Embedding Space To Bind Them All

- Concrete Reinforcement Bar Caps object detection met TensorFlow

- Herordenen met ingebedde modellen

- Herordenen van tekstdocumenten met Ollama en Qwen3 Embedding model - in Go

- Qwen3 Embedding & Reranker Modellen op Ollama: State-of-the-Art Prestaties

Cross-modale ingebedden stellen een paradigma verschuiving voor in hoe AI-systemen informatie verwerken en begrijpen. Door de barrières tussen verschillende gegefstypen te doorbreken, maken deze technieken meer natuurlijke en krachtige AI-toepassingen mogelijk. Of je nu zoeksystemen, inhoudsmoderatiemiddelen of creatieve toepassingen bouwt, het beheersen van cross-modale ingebedden opent een wereld van mogelijkheden voor innovatie in multimodale AI.