FLUX.1-dev GGUF Q8 uitvoeren in Python

Versnel FLUX.1-dev met GGUF-quantisatie

FLUX.1-dev is een krachtig tekst-naar-afbeelding model dat indrukwekkende resultaten produceert, maar zijn geheugengebruik van 24GB+ maakt het lastig om te draaien op veel systemen. GGUF-quantisatie van FLUX.1-dev biedt een oplossing, met een verminderings van het geheugengebruik met ongeveer 50% terwijl de afbeeldingskwaliteit goed behouden blijft.

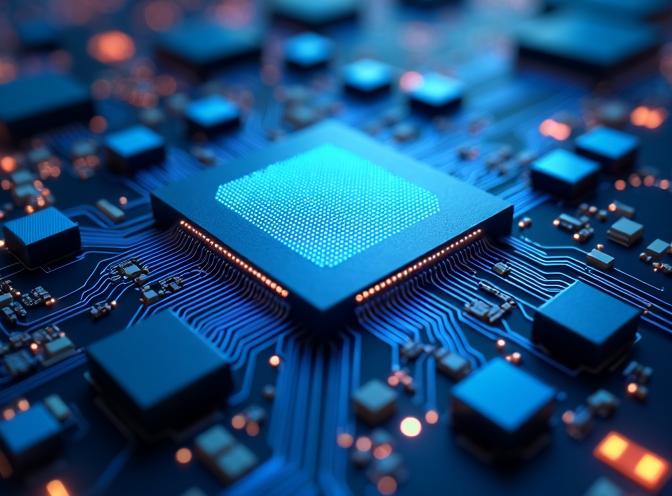

Deze afbeelding is gegenereerd met behulp van het Q8-gequantiseerde FLUX.1-dev model in GGUF-formaat, wat aantoont dat de kwaliteit behouden blijft zelfs met een verminderde geheugengebruik.

Deze afbeelding is gegenereerd met behulp van het Q8-gequantiseerde FLUX.1-dev model in GGUF-formaat, wat aantoont dat de kwaliteit behouden blijft zelfs met een verminderde geheugengebruik.

Wat is GGUF-quantisatie?

GGUF (GPT-Generated Unified Format) is een quantisatieformaat dat oorspronkelijk is ontwikkeld voor taalmodellen, maar nu ook ondersteund wordt voor diffusiemodellen zoals FLUX. Quantisatie verkleint de modelgrootte door gewichten op te slaan in lagere precisieformaten (8-bit, 6-bit of 4-bit) in plaats van volledige 16-bit of 32-bit precisie.

Voor FLUX.1-dev kan de transformercomponent (het grootste deel van het model) gequantiseerd worden, wat het geheugengebruik van ongeveer 24GB verlaagt tot 12GB met Q8_0-quantisatie, of zelfs lager met agressievere quantisatie niveaus.

Voordelen van GGUF-quantisatie

De belangrijkste voordelen van het gebruik van GGUF-gequantiseerde FLUX-modellen zijn:

- Verlaagd geheugengebruik: Verminder de VRAM-vereisten met de helft, waardoor FLUX.1-dev toegankelijk wordt op meer hardware

- Behouden kwaliteit: Q8_0-quantisatie behoudt de afbeeldingskwaliteit met minimale zichtbare verschillen

- Snellere laadtijd: Gequantiseerde modellen laden sneller vanwege hun kleinere bestandsgrootte

- Lagere energieverbruik: Verminderd geheugengebruik leidt tot lagere energieverbruik tijdens het infereren

In onze testen gebruikt de gequantiseerde model ongeveer 12-15GB VRAM in vergelijking met 24GB+ voor het volledige model, terwijl de generatietijd gelijk blijft.

Installatie en instelling

Om GGUF-gequantiseerde FLUX.1-dev te gebruiken, heb je de gguf package nodig, naast de standaard diffusers afhankelijkheden. Als je al FLUX voor tekst-naar-afbeelding generatie gebruikt, ben je al bekend met de basisinstelling.

Als je uv gebruikt als je Python pakketbeheerder, kun je de benodigde pakketten installeren met:

uv pip install -U diffusers torch transformers gguf

Of met standaard pip:

pip install -U diffusers torch transformers gguf

Implementatie

Het belangrijkste verschil bij het gebruik van GGUF-gequantiseerde modellen is dat je de transformer apart laadt met FluxTransformer2DModel.from_single_file() met GGUFQuantizationConfig, en deze vervolgens doorgeeft aan de pipeline. Als je een snelle verwijzing nodig hebt voor Python syntaxis, controleer dan de Python Cheat Sheet. Hier is een volledig werkend voorbeeld:

import os

import torch

from diffusers import FluxPipeline, FluxTransformer2DModel, GGUFQuantizationConfig

# Pad

gguf_model_path = "/pad/naar/flux1-dev-Q8_0.gguf"

base_model_path = "/pad/naar/FLUX.1-dev-config" # Alleen configuratiebestanden

# Laad GGUF-gequantiseerde transformer

print(f"Laad GGUF-gequantiseerde transformer vanaf: {gguf_model_path}")

transformer = FluxTransformer2DModel.from_single_file(

gguf_model_path,

quantization_config=GGUFQuantizationConfig(compute_dtype=torch.bfloat16),

config=base_model_path,

subfolder="transformer",

torch_dtype=torch.bfloat16,

)

# Maak pipeline met gequantiseerde transformer

print(f"Maak pipeline met basismodel: {base_model_path}")

pipe = FluxPipeline.from_pretrained(

base_model_path,

transformer=transformer,

torch_dtype=torch.bfloat16,

)

# Schakel CPU-offloading in (vereist voor GGUF)

pipe.enable_model_cpu_offload()

# Opmerking: enable_sequential_cpu_offload() is niet compatibel met GGUF

# Genereer afbeelding

prompt = "Een toekomstige stadsschouw met zonsondergang en neonlichten"

image = pipe(

prompt,

height=496,

width=680,

guidance_scale=3.5,

num_inference_steps=60,

max_sequence_length=512,

generator=torch.Generator("cpu").manual_seed(42)

).images[0]

image.save("output.jpg")

Belangrijke overwegingen

Model configuratiebestanden

Bij het gebruik van GGUF-quantisatie heb je nog steeds de modelconfiguratiebestanden van het originele FLUX.1-dev model nodig. Deze omvatten:

model_index.json- Pipelinestructuur- Componentconfiguratiebestanden (transformer, text_encoder, text_encoder_2, vae, scheduler)

- Tokenizerbestanden

- Textencoder en VAE gewichten (die niet gequantiseerd zijn)

De transformer gewichten komen uit het GGUF-bestand, maar alle andere componenten vereisen de originele modelbestanden.

CPU-offloading compatibiliteit

Belangrijk: enable_sequential_cpu_offload() is niet compatibel met GGUF-gequantiseerde modellen en zal een KeyError: None fout veroorzaken. Ik gebruik gewoon enable_model_cpu_offload() in plaats daarvan bij het werken met gequantiseerde transformers.

Quantisatie niveaus

Beschikbare quantisatie niveaus voor FLUX.1-dev omvatten:

- Q8_0: Beste kwaliteit, ~14-15GB geheugen (aangeraden)

- Q6_K: Goed evenwicht, ~12GB geheugen

- Q4_K: Maximaal comprimeren, ~8GB geheugen (ik veronderstel dat het de kwaliteit negatief beïnvloedt)

Voor de meeste toepassingen biedt Q8_0 het beste evenwicht tussen geheugensparing en afbeeldingskwaliteit.

Prestatievergelijking

In onze testen met identieke prompts en instellingen:

| Model | VRAM-gebruik | Generatietijd | Kwaliteit |

|---|---|---|---|

| Volledig FLUX.1-dev | 24GB? | Ik heb geen GPU met zo veel geheugen | Uitstekend (ik denk) |

| Volledig FLUX.1-dev | ~3GB met sequential_cpu_offload() | ~329s | Uitstekend |

| GGUF Q8_0 | ~14-15GB | ~98s !!! | Uitstekend |

| GGUF Q6_K | ~10-12GB | ~116s | Zeer goed |

De gequantiseerde model, omdat het minder CPU-offloading vereist, heeft meer dan drie keer zo snelle generatiesnelheid terwijl het aanzienlijk minder geheugen gebruikt, waardoor het praktisch is voor systemen met beperkt VRAM.

Ik heb beide modellen getest met de prompt

Een toekomstige dichtbijopname van een transformer inferentie ASIC-chip met ingewikkelde schakelingen, gloeiend blauw licht uit dichte matrixvermenigvuldigingsunits en lage-precisie ALUs, omringd door on-chip SRAM buffers en quantisatiepijplijnen, weergegeven in hypergedetailleerde fotorealistische stijl met een koud, klinisch verlichtingsschema.

Het voorbeeldresultaat van FLUX.1-dev Q8 is het omslagblad van dit artikel - zie hierboven.

Het voorbeeldresultaat van het niet-gequantiseerde FLUX.1-dev is hieronder:

Ik zie weinig verschil in kwaliteit.

Conclusie

GGUF-quantisatie maakt FLUX.1-dev toegankelijk voor een breder bereik aan hardware, terwijl de hoge kwaliteit van de afbeeldingsgeneratie behouden blijft. Door het geheugengebruik met ongeveer 50% te verminderen, kun je state-of-the-art tekst-naar-afbeelding generatie draaien op goedkoper hardware zonder aanzienlijke kwaliteitsverlies.

De implementatie is eenvoudig met de diffusers bibliotheek, en vereist slechts minimale wijzigingen in de standaard FLUX pipeline instelling. Voor de meeste gebruikers biedt Q8_0-quantisatie het optimale evenwicht tussen geheugenefficiëntie en afbeeldingskwaliteit.

Als je werkt met FLUX.1-Kontext-dev voor afbeeldingvergroting, kunnen vergelijkbare quantisatiemethoden in de toekomst beschikbaar komen.

Gerelateerde artikelen

- Flux tekst naar afbeelding - gids voor het gebruiken van FLUX.1-dev voor tekst-naar-afbeelding generatie

- FLUX.1-Kontext-dev: Afbeeldingvergrotings AI Model

- uv - Nieuwe Python Pakket, Project en Omgevingsbeheerder

- Python Cheat Sheet

Referenties

- HuggingFace Diffusers GGUF Documentatie - Officiële documentatie over het gebruik van GGUF met diffusers

- Unsloth FLUX.1-dev-GGUF - Vooraf gequantiseerde GGUF modellen voor FLUX.1-dev

- Black Forest Labs FLUX.1-dev - Originele FLUX.1-dev model repository

- GGUF Formaat Specificatie - Technische details over het GGUF formaat