Chat-UI's voor lokale Ollama-instanties

Korte overzicht van de meest opvallende UI's voor Ollama in 2025

Locally geïnstalleerde Ollama stelt u in staat om grote taalmodellen op uw eigen computer te draaien, maar het gebruik ervan via de opdrachtnaam is niet gebruikersvriendelijk. Hier zijn verschillende open-source projecten die ChatGPT-stijl interfaces bieden die verbinding maken met een lokale Ollama.

Deze UI’s ondersteunen conversatief chatten, vaak met functies zoals document upload voor retrieval-augmented generation (RAG), en draaien als web- of desktoptoepassingen. Hieronder volgt een vergelijking van de belangrijkste opties, gevolgd door gedetailleerde secties over elk van hen.

Vergelijking van Ollama-compatibele UI’s

| UI-tool | Platform | Documentondersteuning | Ollama-integratie | Voordelen | Nadelen |

|---|---|---|---|---|---|

| Page Assist | Browseruitbreiding (Chrome, Firefox) | Ja – bestanden toevoegen voor analyse | Verbindt met lokale Ollama via uitbreidingsconfiguratie | In-browser chat; eenvoudige modelbeheer en webpagina contextintegratie. | Alleen in de browser; vereist het installeren/configureren van een uitbreiding. |

| Open WebUI | Webapp (zelfgehost; Docker/PWA) | Ja – ingebouwde RAG (documenten uploaden of toevoegen aan bibliotheek) | Directe Ollama API-ondersteuning of gebundelde server (configuratie van basis-URL) | Veel functies (multi-LLM, offline, beeldgeneratie); mobielvriendelijk (PWA). | Installatie is zwaarder (Docker/K8s); brede scope kan te veel zijn voor eenvoudig gebruik. |

| LobeChat | Webapp (zelfgehost; PWA-ondersteuning) | Ja – “Knowledge Base” met bestandupload (PDF, beelden, enz.) | Ollama ondersteunt als één van meerdere AI-backends (vereist het inschakelen van Ollama’s API-toegang) | Slechte ChatGPT-achtige UI; spraakchat, plugins en multi-modelondersteuning. | Complexe functie-set; vereist omgevingsinstellingen (bijv. cross-origin voor Ollama). |

| LibreChat | Webapp (zelfgehost; meervoudige gebruiker) | Ja – “Chat met bestanden” via RAG (via embeddings) | Compatibel met Ollama en veel andere leveranciers (switchbaar per chat) | Bekende ChatGPT-stijl interface; rijke functies (agents, code interpreter, enz.). | Installatie/configuratie kan ingewikkeld zijn; groot project kan meer zijn dan nodig voor basisgebruik. |

| AnythingLLM | Desktopapp (Windows, Mac, Linux) of web (Docker) | Ja – ingebouwde RAG: drag-and-drop documenten (PDF, DOCX, enz.) met citaten | Ollama wordt ondersteund als een LLM-leverancier (instellen in configuratie of Docker-omgeving) | Alles-in-één UI (privé ChatGPT met uw documenten); geen code agent builder, meervoudige gebruikersondersteuning. | Hogere resourcegebruik (embeddings DB, enz.); desktopapp ontbreekt sommige meervoudige gebruikersfuncties. |

| Chat-with-Notes | Webapp (lichtgewicht Flask-server) | Ja – tekst/PDF-bestanden uploaden en chatten met hun inhoud | Gebruikt Ollama voor alle AI-antwoorden (vereist dat Ollama lokaal draait) | Zeer eenvoudige opzet en interface gericht op documentvragen; gegevens blijven lokaal. | Basis UI en functionaliteit; enkel gebruiker, één document tegelijk (geen geavanceerde functies). |

Elke tool is actief onderhouden en open source. Nu volgen we de details van elk van deze opties, inclusief hoe ze werken met Ollama, opvallende functies en afwegingen.

Page Assist (Browseruitbreiding)

Page Assist is een open-source browseruitbreiding die lokale LLM chat naar uw browser brengt. Het ondersteunt Chromium-gebaseerde browsers en Firefox, met een ChatGPT-achtige zijbalk of tab waarin u kunt chatten met een model. Page Assist kan verbinding maken met lokale Ollama als de AI-leverancier, of andere lokale backends, via zijn instellingen. Opvallend is dat het u toelaat om bestanden (bijv. PDFs of tekst) toe te voegen zodat de AI ze binnen de chat kan analyseren, waardoor basis RAG workflows mogelijk worden. U kunt het zelfs laten helpen met de inhoud van de huidige webpagina of webzoeken naar informatie.

De opzet is eenvoudig: installeer de uitbreiding van de Chrome Web Store of Firefox Add-ons, zorg dat Ollama draait, en selecteer Ollama als de lokale AI-leverancier in de instellingen van Page Assist. De interface bevat functies zoals chatgeschiedenis, modelselectie en een optionele deelbare URL voor uw chatresultaten. Een webinterface is ook beschikbaar via een toetsenkorteling als u een volledige tabchatervaring prefereert.

Voordelen: Page Assist is lichtgewicht en handig – omdat het in de browser woont, is er geen aparte server om te draaien. Het is ideaal voor browsingscontexten (u kunt het openen op elke webpagina) en ondersteunt internetzoekintegratie en bestandsbijlagen om de conversatie te verrijken. Het biedt ook handige functies zoals toetsenkortingen voor nieuwe chat en het wisselen van de zijbalk.

Nadelen: Omdat het een uitbreiding is, is het beperkt tot een browseromgeving. De UI is eenvoudiger en iets minder functierijk dan volledige standalone chattoepassingen. Bijvoorbeeld, meervoudige gebruikersbeheer of geavanceerde agentplugins zijn niet in het bereik. Bovendien kan de initiële opzet vereisen dat u de uitbreiding bouwt/laadt als er geen vooraf gepakkette versie beschikbaar is voor uw browser (het project biedt bouwinstructies via Bun of npm). Over het algemeen is Page Assist het beste voor individueel gebruik wanneer u snel toegang wilt tot Ollama-gemotoriseerde chat tijdens het webbrowsen, met gematigde RAG-mogelijkheden.

Open WebUI (zelfgehoste webtoepassing)

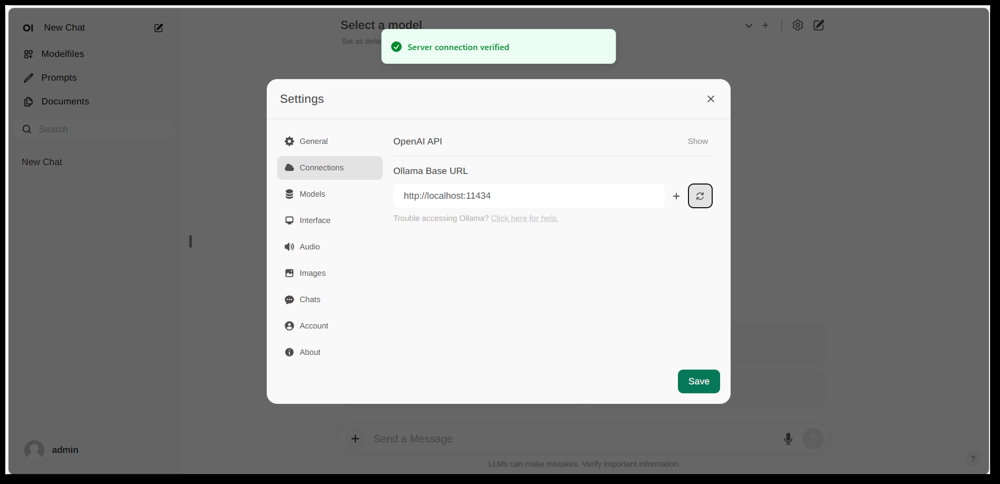

Open WebUI’s instellingeninterface, met een Ollama-verbinding geconfigureerd (basis-URL ingesteld op de lokale Ollama API). De UI bevat een documentsectie, waardoor RAG workflows mogelijk zijn.

Open WebUI is een krachtige, algemene chatfront-end die oorspronkelijk is gemaakt om te werken met Ollama, en nu uitgebreid is naar het ondersteunen van verschillende LLM-backends. Het draait als een zelfgehoste webtoepassing en wordt meestal geïmplementeerd via Docker of Kubernetes voor eenvoudige opzet. Zodra het draait, toegankelijk via uw browser (met ondersteuning voor het installeren als een Progressive Web App op mobiele apparaten).

Open WebUI biedt een volledige chatinterface met meervoudige gebruikersondersteuning, modelbeheer en uitgebreide functies. Belangrijk is dat het ingebouwde RAG-mogelijkheden heeft – u kunt documenten uploaden of importeren in een documentbibliotheek en dan vragen stellen met retrievalverrijking. De interface stelt u in staat om documenten direct in een chatgesprek te laden of een blijvende bibliotheek van kennis te onderhouden. Het ondersteunt zelfs het uitvoeren van webzoeken en het injecteren van resultaten in het gesprek voor up-to-date informatie.

Ollama-integratie: Open WebUI verbindt met Ollama via de API. U kunt ofwel de Open WebUI Docker-container naast een Ollama-server draaien en een omgevingsvariabele instellen om naar de Ollama-URL te wijzen, ofwel een speciale Docker-afbeelding gebruiken die Ollama bundelt met de webinterface. In de praktijk, na het starten van de containers, bezoekt u Open WebUI in uw browser en ziet u “Server connection verified” als het correct is geconfigureerd (zoals weergegeven in de afbeelding hierboven). Dit betekent dat de UI gereed is om uw lokale Ollama-modellen te gebruiken voor chat. Open WebUI ondersteunt ook OpenAI API-compatibele eindpunten, dus het kan interface met LM Studio, OpenRouter, enz., naast Ollama.

Voordelen: Dit is één van de rijkste en flexibelste UI’s. Het ondersteunt meerdere gelijktijdige modellen en conversatiegedeeltes, aangepaste “personages” of systeemmeldingen, beeldgeneratie en meer. De RAG-uitvoering is robuust – u krijgt een volledige UI voor het beheren van documenten en zelfs het configureren van welk vectoropslag- of zoekservice moet worden gebruikt voor retrieval. Open WebUI wordt ook actief ontwikkeld (met een uitgebreide gemeenschap, zoals aangegeven door zijn hoge sterrenaantal op GitHub) en is ontworpen voor uitbreidbaarheid en schaalbaarheid. Het is een goede keuze als u een volledige, alles-in-één chatinterface wilt voor lokale modellen, vooral in een scenario met meerdere gebruikers of complexe gebruiksscenario’s.

Nadelen: Met veel kracht komt ook meer complexiteit. Open WebUI kan te veel zijn voor eenvoudig persoonlijk gebruik – het implementeren van Docker-containers en het beheren van de configuratie kan intimiderend zijn als u niet bekend bent met deze technologieën. Het verbruikt meer resources dan een lichte toepassing, omdat het een webserver draait, een optionele database voor chatgeschiedenis, enz. Bovendien, functies zoals rolgebaseerd toegangsbeheer en gebruikersbeheer, terwijl nuttig, wijzen erop dat het gericht is op een serveropstelling – een enkele gebruiker op een thuiscomputer zou mogelijk niet allemaal nodig hebben. Kortom, de opzet is zwaarder en de interface kan complex overkomen als u alleen een basis ChatGPT-klon wilt. Maar voor wie wel de breedte van functies nodig heeft (of wil wisselen tussen Ollama en andere modelleveranciers in één UI), is Open WebUI een topkandidaat.

LobeChat (ChatGPT-achtig kader met plugins)

LobeChat interface banner met “Ollama Supported” en meerdere lokale modellen. LobeChat laat u een slanke ChatGPT-achtige webapp implementeren met Ollama of andere leveranciers, met functies zoals spraakinput en plugins.

LobeChat is een open-source chatkader dat zich richt op een geperfekteerde gebruikerservaring en flexibiliteit. Het is essentieel een ChatGPT-achtige webtoepassing die u zelf kunt hosten, met ondersteuning voor meerdere AI-leveranciers – van OpenAI en Anthropic tot open modellen via Ollama. LobeChat is ontworpen met privacy in gedachten (u draait het zelf) en heeft een moderne interface die conveniences bevat zoals conversatiegeheugen, spraakconversatiemodus en zelfs tekst-naar-beeldgeneratie via plugins.

Een van de belangrijkste functies van LobeChat is zijn Knowledge Base-functionaliteit. U kunt documenten uploaden (in formaten zoals PDFs, beelden, audio, video) en een knowledge base aanmaken die kan worden gebruikt tijdens de chat. Dit betekent dat u vragen kunt stellen over de inhoud van uw bestanden – een RAG workflow die LobeChat standaard ondersteunt. De UI biedt beheer van deze bestanden/knowledge bases en stelt u in staat om hun gebruik in het gesprek aan- of uit te schakelen, wat een rijkere Q&A-ervaring biedt dan de basis LLM.

Om LobeChat te gebruiken met Ollama, implementeert u de LobeChat-app (bijvoorbeeld via een geleverde Docker-afbeelding of script) en configureert u Ollama als de backend. LobeChat herkent Ollama als een eerste klasse leverancier – het biedt zelfs een een-klik implementatiescript via de Pinokio AI-browser als u dat gebruikt. In de praktijk zult u mogelijk Ollama’s instellingen moeten aanpassen (zoals het inschakelen van CORS zoals aangegeven in LobeChat’s documentatie) zodat LobeChat’s webfrontend toegang kan krijgen tot de Ollama HTTP API. Zodra geconfigureerd, kunt u in de LobeChat UI een Ollama-gehost model selecteren en er met het chatten, inclusief het vragen van uw geüploade documenten.

Voordelen: LobeChat’s UI wordt vaak geprezen voor het zijn schoon en gebruikersvriendelijk, dicht bij het uiterlijk en gevoel van ChatGPT (wat de adoptie kan vergemakkelijken). Het voegt waarde toe met extra’s zoals sprakinput/output voor gesproken conversaties en een plug-insysteem om functionaliteit uit te breiden (zoals ChatGPT’s plug-ins, waardoor dingen zoals webbrowsing of beeldgeneratie mogelijk zijn). Meervoudige modelondersteuning betekent dat u gemakkelijk kunt wisselen tussen bijvoorbeeld een Ollama lokale model en een OpenAI API model in dezelfde interface. Het ondersteunt ook installatie als een mobielvriendelijke PWA, zodat u uw lokale chat op de goeie kan bereiken.

Nadelen: Het instellen van LobeChat kan complexer zijn dan enkele alternatieven. Het is een full-stack toepassing (vaak met Docker Compose), dus er is wat overhead. In het bijzonder vereist het instellen van Ollama-integratie het inschakelen van cross-origin aanvragen aan de kant van Ollama en het zorgen dat poorten overeenkomen – een eenmalige taak, maar technisch. Bovendien, terwijl LobeChat erg krachtig is, zijn niet alle functies nodig voor elke gebruiker; bijvoorbeeld, als u geen meervoudige leveranciersondersteuning of plug-ins nodig hebt, kan de interface overbodig overkomen vergeleken met een minimale tool. Tot slot, bepaalde geavanceerde functies zoals de een-klik implementatie veronderstellen specifieke omgevingen (Pinokio-browser of Vercel), die u wel of niet gebruikt. Over het algemeen is LobeChat ideaal als u een volledig uitgeruste ChatGPT-achtige alternatief wilt dat lokaal draait met Ollama, en u geen probleem hebt met een beetje initiële configuratie om daar te komen.

LibreChat (ChatGPT-klon met meervoudige leveranciersondersteuning)

LibreChat (vormelijk bekend als ChatGPT-Clone of UI) is een open-source project dat gericht is op het repliceren en uitbreiden van de ChatGPT-interface en functionaliteit. Het kan lokaal worden geïmplementeerd (of op uw eigen server) en ondersteunt een verscheidenheid aan AI-backends – waaronder open-source modellen via Ollama. Essentieel biedt LibreChat de bekende chatervaring (gespreksinterface met geschiedenis, gebruikers- en assistentenberichten) terwijl het u toelaat om verschillende modelleveranciers op de backend in te schakelen.

LibreChat ondersteunt documentinteractie en RAG via een add-on genaamd de RAG API en embeddingdiensten. In de interface kunt u functies gebruiken zoals “Chat met bestanden”, wat u toelaat om bestanden te uploaden en dan vragen over hen te stellen. Achter de schermen gebruikt dit embeddings en een vectoropslag om relevante context uit uw bestanden op te halen. Dit betekent dat u een vergelijkbare effect kan bereiken als ChatGPT + aangepaste kennis, alles lokaal. Het project biedt zelfs een aparte repo voor de RAG-service als u die zelf wilt hosten.

Het gebruik van LibreChat met Ollama omvat doorgaans het draaien van de LibreChat-server (bijvoorbeeld via Node/Docker) en het zorgen dat deze de Ollama-service kan bereiken. LibreChat heeft een “Aangepast eindpunt” instelling waarin u een OpenAI-compatibele API-URL kunt invoeren. Aangezien Ollama een lokale API kan blootstellen die OpenAI-compatibel is, kan LibreChat worden gericht op http://localhost:11434 (of waar Ollama luistert). In feite lijst LibreChat expliciet Ollama onder zijn ondersteunde AI-leveranciers – naast anderen zoals OpenAI, Cohere, enz. Zodra geconfigureerd, kunt u het model (Ollama’s model) selecteren in een dropdown en chatten. LibreChat stelt ook het wisselen van modellen of leveranciers zelfs midden in het gesprek toe en ondersteunt meervoudige chatvoorinstellingen/contexts.

Voordelen: Het belangrijkste voordeel van LibreChat is de rijke set functies die rond de chatervaring zijn gebouwd. Het bevat dingen zoals gespreksverzakking, berichtzoeken, ingebouwde Code Interpreter-ondersteuning (veilig sandboxed codeuitvoering), en tool/agent-integraties. Het is essentieel ChatGPT++, met de mogelijkheid om lokale modellen te integreren. Voor iemand die de UI van ChatGPT leuk vindt, zal LibreChat zeer bekend voelen en vereist weinig leercurve. Het project is actief en gemeenschapsgericht (zoals aangetoond door zijn frequente updates en discussies), en het is vrij flexibel: u kunt verbinding maken met veel soorten LLM-eindpunten of het zelfs draaien met meervoudige gebruikers en authenticatie voor een teamomgeving.

Nadelen: Met zijn veel functies kan LibreChat zwaarder te draaien zijn. De installatie kan het instellen van een database voor het opslaan van gesprekken en het configureren van omgevingsvariabelen voor verschillende APIs vereisen. Als u alle componenten (RAG, agents, beeldgeneratie, enz.) inschakelt, is het een vrij complexe stack. Voor een enkele gebruiker die alleen een basischat met één lokale model nodig heeft, kan LibreChat meer zijn dan nodig. Bovendien, terwijl de UI bekend is, is het niet zeer gespecialiseerd voor document QA – het doet het werk maar mist een specifieke “documentbibliotheek” interface (uploads worden meestal binnen een chat of via API uitgevoerd). Kortom, LibreChat straalt wanneer u een volledige ChatGPT-achtige omgeving met een breed scala aan functies wilt die lokaal draait, maar eenvoudigere oplossingen kunnen voldoen voor nauwkeurig gerichte gebruiksscenario’s.

AnythingLLM (Alles-in-één desktop- of serverapp)

AnythingLLM is een alles-in-één AI-toepassing die zich richt op RAG en gebruiksgemak. Het stelt u in staat om “te chatten met uw documenten” via open-source LLMs of zelfs OpenAI’s modellen, alles via één geïntegreerde interface. Opvallend is dat AnythingLLM beschikbaar is als een cross-platform desktopapp (voor Windows, Mac, Linux) en als een zelfgehoste webserver (via Docker). Deze flexibiliteit betekent dat u het als een normale toepassing op uw PC kunt draaien, of het kunt implementeren voor meerdere gebruikers op een server.

Documentbehandeling is het kernstuk van AnythingLLM. U kunt documenten drag-and-drop (PDF, TXT, DOCX, enz.) in de app, en het zal ze automatisch indexeren in een vectordatabase (het heeft LanceDB standaard). In de chatinterface, wanneer u vragen stelt, zal het relevante stukken uit uw documenten ophalen en geciteerde antwoorden geven, zodat u weet welk bestand en welk deel de informatie is gekomen. Essentieel bouwt het een privé kennisbank voor u en laat het LLM het gebruiken als context. U kunt documenten organiseren in “workspaces” (bijvoorbeeld één workspace per project of onderwerp), isolerend contexten waar nodig.

Het gebruik van Ollama met AnythingLLM is eenvoudig. In de configuratie kiest u Ollama als de LLM-leverancier. Als u via Docker draait, stelt u omgevingsvariabelen in zoals LLM_PROVIDER=ollama en geeft u de OLLAMA_BASE_PATH (de URL naar uw Ollama-instantie). De AnythingLLM-server zal dan alle modelvragen naar de Ollama API sturen. Ollama wordt officieel ondersteund, en de documentatie noemt aan dat u het kunt gebruiken om verschillende open modellen (zoals Llama 2, Mistral, enz.) lokaal te draaien. In feite benadrukken de ontwikkelaars dat het combineren van AnythingLLM met Ollama krachtige offline RAG-mogelijkheden ontsluit: Ollama verwerkt de modelinference, en AnythingLLM verwerkt embeddings en de UI/agentlogica.

Voordelen: AnythingLLM biedt een comprehensieve oplossing voor privé Q&A en chat. Belangrijke voordelen zijn: een eenvoudige opzet voor RAG (de zware werkzaamheden van embedding en opslag van vectoren zijn geautomatiseerd), ondersteuning voor meerdere documenten met duidelijke bronvermelding, en extra functies zoals AI Agents (het heeft een no-code agentbuilder waarin u aangepaste workflows en toolgebruik kunt maken). Het is ook meervoudig gebruikersvriendelijk (vooral in servermodus), met gebruikersaccounts en toegangsbeheer indien nodig. De interface is ontworpen om eenvoudig te zijn (chattbox + zijbalk van documenten/workspaces) maar krachtig onder de scherm. Voor persoonlijk gebruik is de desktopapp een groot voordeel – u krijgt een native-gevoelde app zonder dat u een browser hoeft te openen of commando’s moet uitvoeren, en het slaat standaard gegevens lokaal op.

Nadelen: Omdat het veel componenten integreert (LLM API, embeddingmodellen, vector DB, enz.), kan AnythingLLM resourceintensief zijn. Wanneer u documenten verwerkt, kan het tijd en geheugen kosten om embeddings te genereren (het ondersteunt zelfs het gebruik van Ollama of lokale modellen voor embeddings met modellen zoals nomic-embed). De desktopapp vereenvoudigt het gebruik, maar als u veel documenten of zeer grote bestanden heeft, verwacht u zware verwerking in de achtergrond. Een ander nadeel is dat geavanceerde gebruikers het mogelijk minder configureerbaar vinden dan hun eigen stack samenstellen – bijvoorbeeld, het gebruikt momenteel LanceDB of Chroma; als u een andere vectoropslag wil, moet u in de configuratie of code duiken. Ook, terwijl meervoudige leveranciers worden ondersteund, is de interface echt gericht op één model tegelijk (u zou de globale leverancierinstelling wisselen als u een ander model wil gebruiken). Samengevat, AnythingLLM is een uitstekende uit de doos oplossing voor lokale documentchat, vooral met Ollama, maar het is een grotere toepassing om te draaien vergeleken met minimale UIs.

Chat-with-Notes (Minimalist Document Chat UI)

Chat-with-Notes is een minimalistische toepassing die specifiek is ontworpen om te chatten met lokale tekstbestanden met behulp van modellen die worden beheerd door Ollama. Het is essentieel een lichte Flask-webserver die je op je PC draait, waarmee je een eenvoudige webpagina kunt openen waarop je een document kunt uploaden en daarna over dat document kunt chatten. Het doel van dit project is eenvoudigheid: het heeft niet veel extra functies, maar het doet wel het kernwerk van document-vraag-antwoord met een lokale LLM.

Het gebruik van Chat-with-Notes begint met het zorgen dat je Ollama-instantie een model draait (bijvoorbeeld kun je Ollama starten met ollama run llama2 of een ander model). Vervolgens start je de Flask-app (python app.py) en open je de lokale website. De gebruikersinterface zal je vragen om een bestand te uploaden (ondersteunde formaten zijn platte tekst, Markdown, codebestanden, HTML, JSON en PDF’s). Zodra het bestand is geüpload, wordt de tekstinhoud ervan weergegeven, en kun je vragen stellen of chatten met de AI over die inhoud. Het gesprek vindt plaats in een typisch chatbubbelformaat. Als je tijdens een gesprek een nieuw bestand uploadt, zal de app vragen of je een nieuw gesprek wilt starten of de huidige gesprekscontext behouden en alleen de informatie van het nieuwe bestand toevoegen. Op die manier kun je indien nodig opeenvolgend over meerdere bestanden praten. Er zijn ook knoppen om het gesprek te wissen of het gesprek te exporteren naar een tekstbestand.

Achter de schermen gebruikt Chat-with-Notes de Ollama API om antwoorden te genereren. Ollama zorgt voor de modelinference, en Chat-with-Notes levert alleen de prompt (die relevante delen van de geüploade tekst bevat). Het gebruikt geen vectordatabase; in plaats daarvan stuurt het gewoon de volledige inhoud van het bestand (of stukken daarvan) samen met je vraag naar het model. Deze aanpak werkt het beste voor redelijk grote documenten die passen in het contextvenster van het model.

Voordelen: De app is extreem gemakkelijk in te zetten en te gebruiken. Er is geen ingewikkelde configuratie – als je Python en Ollama hebt ingesteld, kun je het binnen een paar minuten draaien. De interface is netjes en minimalistisch, met een focus op de tekstinhoud en het Q&A. Omdat het zo gericht is, zorgt het ervoor dat alle gegevens lokaal blijven en alleen in het geheugen (geen externe oproepen behalve naar Ollama op localhost). Het is een uitstekende keuze als je specifiek wilt chatten met bestanden en geen algemene conversatie zonder een document nodig hebt.

Nadelen: De minimalisme van Chat-with-Notes betekent dat het veel functies mist die je vindt in andere interfaces. Bijvoorbeeld, het ondersteunt geen gebruik van meerdere modellen of providers (het is alleen Ollama-gericht), en het onderhoudt geen lange-termijnbibliothek van documenten – je uploadt bestanden per sessie wanneer je ze nodig hebt, en er is geen blijvende vectorindex. Schalen naar zeer grote documenten kan lastig zijn zonder handmatige aanpassingen, omdat het mogelijk veel tekst in de prompt wil opnemen. Ook is de gebruikersinterface, hoewel functioneel, niet zo glimlachend (geen donkere modus, geen rijke tekstformattering van antwoorden, enz.). In essentie is dit gereedschap ideaal voor snelle, enkele analyses van bestanden met een Ollama-model. Als je behoeften groeien (bijvoorbeeld veel documenten of een knapper UI), dan kun je mogelijk de grenzen van Chat-with-Notes overschrijden. Maar als een startpunt of een persoonlijk “vraag mijn PDF”-oplossing bovenop Ollama, is het zeer effectief.

Conclusie

Elke van deze open-source gebruikersinterfaces kan je ervaring met lokale Ollama-modellen verbeteren door een gebruikersvriendelijke chatinterface en extra functionaliteiten zoals documentvraag-antwoord te bieden. De beste keuze hangt af van je eisen en technische comfort:

- Voor snelle opzet en gebruik in de browser: Page Assist is een goede keuze, omdat het direct in je webbrowsing is geïntegreerd met minimale moeite.

- Voor een volledig uitgeruste webapp-omgeving: Open WebUI of LibreChat bieden uitgebreide functionaliteiten en flexibiliteit met meerdere modellen, geschikt voor powergebruikers of multi-gebruikersopstellingen.

- Voor een gepolijste ChatGPT-achtige alternatief met pluginpotentie: LobeChat biedt een mooi evenwicht tussen gebruiksvriendelijkheid en functionaliteiten in een zelfgehoste pakket.

- Voor documentgerichte interacties: AnythingLLM biedt een alles-in-één-oplossing (vooral als je een desktopapp waarderen), terwijl Chat-with-Notes een minimalistische aanpak biedt voor single-document Q&A.

Aangezien al deze tools actief worden onderhouden, kun je ook rekenen op verbeteringen en communityondersteuning. Door er één van te kiezen, kun je gemakkelijk chatten met je lokaal Ollama-gehoste modellen – of het nu gaat om documentanalyse, coderen met hulp, of gewoon conversatie-AI beschikbaar zonder cloudafhankelijkheid. Elke oplossing hierboven is open source, dus je kunt ze verder aanpassen aan jouw behoeften of zelfs bijdragen aan hun ontwikkeling.

Veel plezier met chatten met je lokale LLM!