Verplaats Ollama-modellen naar een andere locatie

Ollama LLM-modelbestanden nemen veel ruimte in beslag

Na het installeren van ollama is het beter om ollama direct opnieuw in te stellen om ze op te slaan in een nieuwe locatie. Zo krijgen we nieuwe modellen niet gedownload naar de oude locatie.

Over Ollama

Ollama is een tekstgebaseerde frontend voor LLM AI-modellen en een API die ook die kan hosten.

Installeer Ollama

Ga naar https://ollama.com/download

Om Ollama te installeren op Linux:

curl -fsSL https://ollama.com/install.sh | sh

Ollama op Windows staat op de pagina: https://ollama.com/download/windows Ollama voor Mac is daar ook: https://ollama.com/download/macOllamaSetup.exe

Download, lijst en verwijder Ollama-modellen

Om enkele Ollama-modellen te downloaden: Ga naar de Ollama-bibliotheek (https://ollama.com/library) en zoek het model dat je nodig hebt, daar vind je ook modeltags en -groottes.

Daarna voer je uit:

ollama pull gemma2:latest

# Of krijg een iets slimmer model dat nog steeds mooi past in 16GB VRAM:

ollama pull gemma2:27b-instruct-q3_K_S

# Of:

ollama pull llama3.1:latest

ollama pull llama3.1:8b-instruct-q8_0

ollama pull mistral-nemo:12b-instruct-2407-q6_K

ollama pull mistral-small:22b-instruct-2409-q4_0

ollama pull phi3:14b-medium-128k-instruct-q6_K

ollama pull qwen2.5:14b-instruct-q5_0

Om de modellen te controleren die Ollama lokaal heeft opgeslagen:

ollama list

Om een ongebruikt model te verwijderen:

ollama rm qwen2:7b-instruct-q8_0 # bijvoorbeeld

Locatie van Ollama-modellen

Standaard worden de modelbestanden opgeslagen:

- Windows: C:\Users%username%.ollama\models

- Linux: /usr/share/ollama/.ollama/models

- macOS: ~/.ollama/models

Instellen van de Ollama-modellenlocatie op Windows

Om een omgevingsvariabele op Windows aan te maken, volg je deze instructies:

- Open Windows-instellingen.

- Ga naar Systeem.

- Selecteer Overzicht.

- Selecteer Geavanceerde systeeminstellingen.

- Ga naar het Geavanceerde tabblad.

- Selecteer Omgevingsvariabelen…

- Klik op Nieuw…

- En maak een variabele aan genaamd OLLAMA_MODELS die wijst naar waar je de modellen wilt opslaan

Verplaats Ollama-modellen op Linux

Bewerk de parameters van de ollama systemd-service

sudo systemctl edit ollama.service

of

sudo xed /etc/systemd/system/ollama.service

Dit opent een editor.

Voor elke omgevingsvariabele, voeg een regel Environment toe onder het gedeelte [Service]:

[Service]

Environment="OLLAMA_MODELS=/specialplace/ollama/models"

Sla op en sluit af.

Er zijn ook User- en Group-parameters, deze moeten toegang hebben tot deze map.

Herlaad systemd en herstart Ollama:

sudo systemctl daemon-reload

sudo systemctl restart ollama

als iets misging

systemctl status ollama.service

sudo journalctl -u ollama.service

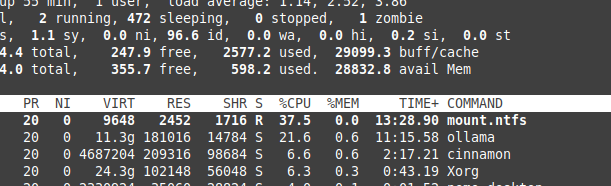

Opslag van bestanden op NTFS overhead

Wees ervan bewust dat als je Linux draait en je modellen op een NTFS-formateerde partitie houdt, je modellen veel langzamer laden, meer dan 20% langzamer.

Installeer Ollama op Windows in een specifieke map

Met de modellen

.\OllamaSetup.exe /DIR=D:\OllamaDir

Exposeer Ollama API naar het interne netwerk

Intern betekent hier lokaal netwerk.

Voeg toe aan de serviceconfiguratie:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

Nuttige links

- Test: Hoe Ollama Intel CPU-prestaties en Efficiënte Kernen gebruikt

- Hoe Ollama Parallelle Verzoeken Afhandelt

- Testen van Deepseek-r1 op Ollama

- LLM-prestaties en PCIe-lanes: Belangrijke Overwegingen

- Detectie van logische fouten met LLMs

- LLM-snelheidsprestatiesvergelijking

- Vergelijking van LLM-samenvattingsvermogen

- Effectief schrijven van prompts voor LLMs

- Zelfhosten van Perplexica - met Ollama

- Conda Cheat Sheet

- Docker Cheat Sheet

- Cloud LLM Providers

- Qwen3 Embedding & Reranker Modellen op Ollama: State-of-the-Art Prestaties