Hardware

LLM-selvvärdighet och AI-soveränitet

Styra data och modeller med självvärdbaserade LLM:er

Self-hosting av LLM:er behåller data, modeller och inferens under din kontroll - en praktisk väg till AI-soveränitet för grupper, företag och länder. Här: vad soverän AI är, vilka aspekter och metoder som används för att bygga den, hur LLM-self-hosting passar in, och hur länder hanterar utmaningen.

Bästa LLM:erna för Ollama på GPU med 16GB VRAM

LLM-hastighetstest på RTX 4080 med 16 GB VRAM

Körning av stora språkmodeller lokalt ger dig integritet, möjlighet att använda dem offline och noll kostnader för API:er. Detta benchmark visar exakt vad man kan förvänta sig från 9 populära LLMs på Ollama på en RTX 4080.

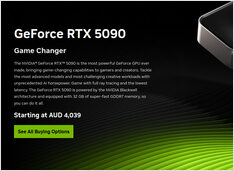

GPU- och RAM-priser stiger i Australien: RTX 5090 upp 15%, RAM upp 38% - januari 2026

Januari 2025 GPU- och RAM-prischeck

Idag tittar vi på de högsta nivåerna av konsumentspelkort och RAM-moduler. Specifikt tittar jag på RTX-5080 och RTX-5090-priser, och 32GB (2x16GB) DDR5 6000.

De bästa Linux-terminal-emulatorerna: Jämförelse 2026

Välj rätt terminal för din Linux-arbetsflöde

En av de viktigaste verktygen för Linux-användare är terminalsimulatorer.

DGX Spark AU-priser: 6 249–7 999 dollar hos stora detaljhandlare

Riktiga AUD-priser från australiska detaljhandlare nu

The

NVIDIA DGX Spark

(GB10 Grace Blackwell) är nu

tillgänglig i Australien

hos stora PC-handlare med lokalt lager.

Om du följt med i

global DGX Spark-priser och tillgänglighet,

så kommer du att vara intresserad att veta att australiska priser ligger mellan 6 249 till 7 999 AUD beroende på lagringskonfiguration och handlare.

Self-Hosting Cognee: LLM-prestandatest

Testa Cognee med lokala LLMs - verkliga resultat

Cognee är en Pythonramverk för att bygga kunskapsgrafik från dokument med hjälp av LLMs. Men fungerar det med självvärddade modeller?

Ubuntu förlorade nätverket efter kernel-uppdatering

Hur jag löste nätverksproblem i Ubuntu

Efter att ha installerat en ny kernel automatiskt, har Ubuntu 24.04 förlorat ethernetnätverket. Detta frustrerande problem uppstod för mig en andra gång, så jag dokumenterar lösningen här för att hjälpa andra som stöter på samma problem.

RAM-pris i Australien - December 2025

Kort inlägg, noterar bara priset

Med denna galna RAM-prisvolatilitet, för att bilda och ha en bättre bild, låt oss först spåra RAM-priset i Australien.

RAM-prisstegring: Upp till 619% år 2025

RAM-priser stiger med 163-619% när AI-nachfrågan belastar tillgången

Minnetmarknaden upplever ovanligt prisvolatilitet i slutet av 2025, med RAM-priser som skjuter i höjden dramatiskt över alla segment.

Nvidia RTX 5080 och RTX 5090-priser i Australien - november 2025

Priser på AI-lämpliga konsument-GPU:er - RTX 5080 och RTX 5090

Låt oss jämföra priser för toppnivå-konsument-GPUs som är lämpliga för LLMs i synnerhet och AI i allmänhet. Specifikt tittar jag på RTX-5080 och RTX-5090-priser.

AI-infrastruktur på konsumenthårdvara

Distribuera företags-AI på budget-hårdvara med öppna modeller

Demokratiseringen av AI är här. Med öppna källkods-LLMs som Llama 3, Mixtral och Qwen som nu konkurrerar med proprietära modeller kan team bygga kraftfull AI-infrastruktur med konsumenthårdvara - sänka kostnader samtidigt som full kontroll bibehålls över datasekretess och distribution.

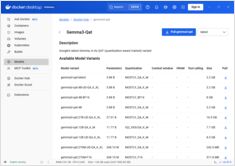

Lägg till stöd för NVIDIA GPU i Docker Model Runner

Aktivera GPU-beskleuning för Docker Model Runner med stöd för NVIDIA CUDA

Docker Model Runner är Docks officiella verktyg för att köra AI-modeller lokalt, men aktivering av NVidia GPU-accelerering i Docker Model Runner kräver specifik konfiguration.

NVIDIA DGX Spark vs Mac Studio vs RTX-4080: Ollama Prestandajämförelse

GPT-OSS 120b-benchmarks på tre AI-plattformar

Jag grävde fram några intressanta prestandatester av GPT-OSS 120b som körs på Ollama över tre olika plattformar: NVIDIA DGX Spark, Mac Studio och RTX 4080. GPT-OSS 120b-modellen från Ollama-biblioteket väger 65GB, vilket innebär att den inte passar i de 16GB VRAM som finns i en RTX 4080 (eller den nyare RTX 5080).

Docker Model Runner Cheatsheet: Kommandon & Exempel

Snabbreferens för Docker Model Runner-kommandon

Docker Model Runner (DMR) är Docks officiella lösning för att köra AI-modeller lokalt, introducerad i april 2025. Den här snabbreferensen ger en översikt över alla viktiga kommandon, konfigurationer och bästa praxis.

GNOME Boxes: En omfattande guide till funktioner, utmaningar och alternativ

Enkel hantering av virtuella maskiner för Linux med GNOME Boxes

I dagens datormiljö har virtualisering blivit avgörande för utveckling, testning och körning av flera operativsystem. För Linux-användare som söker ett enkelt och intuitivt sätt att hantera virtuella maskiner, sticker GNOME Boxes ut som ett lättviktigt och användarvänligt alternativ som prioriterar enkelhet utan att offra funktionalitet.