NVIDIA DGX Spark vs Mac Studio vs RTX-4080: Ollama Prestandajämförelse

GPT-OSS 120b-benchmarks på tre AI-plattformar

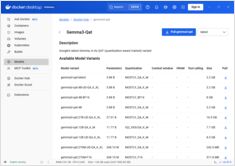

Jag grävde fram några intressanta prestandatester av GPT-OSS 120b som körs på Ollama över tre olika plattformar: NVIDIA DGX Spark, Mac Studio och RTX 4080. GPT-OSS 120b-modellen från Ollama-biblioteket väger 65GB, vilket innebär att den inte passar i de 16GB VRAM som finns i en RTX 4080 (eller den nyare RTX 5080).