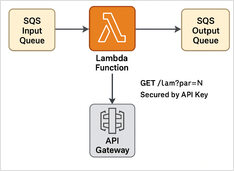

Bygga en Dual-Mode AWS Lambda med Python och Terraform

Steg-för-steg-exempel

Här har vi ett Python Lambda-exempel på SQS-meddelandehantering + REST API med API-nyckelskydd + Terraform-skript för att distribuera det för serverlös körning.

Steg-för-steg-exempel

Här har vi ett Python Lambda-exempel på SQS-meddelandehantering + REST API med API-nyckelskydd + Terraform-skript för att distribuera det för serverlös körning.

Jämföra hastighet, parametrar och prestanda hos dessa två modeller

Här är en jämförelse mellan Qwen3:30b och GPT-OSS:20b fokuserande på instruktionssäljning och prestandaparametrar, specifikationer och hastighet.

Uppskattade värdningskostnadsberäkningar jämfört med prenumeration.

Här är en snabb information om Write.as / WriteFreely - hur det passar in i fediversumet, var man kan få hanterad värd, hur användningstrenden ser ut och hur man själv värdar (plus grova kostnadsberäkningar).

+ Specifika exempel med hjälp av tänkande LLMs

I detta inlägg kommer vi att utforska två sätt att ansluta din Python-applikation till Ollama: 1. Via HTTP REST API; 2. Via den officiella Ollama Python-biblioteket.

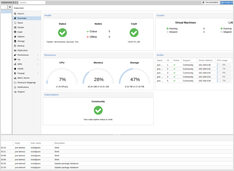

Vad är Proxmox?

Proxmox Virtual Environment (Proxmox VE) är en öppen källkod, typ-1 hypervisor och datacenter-orkestreringsplattform byggd på Debian.

Vad man ska göra med `canonical`, `lang` och `hreflang`

Översätt din Hugo-website kan förbättra din ranking på Google och Bing - men bara om det översatta innehållet är av hög kvalitet, lokaliserat och korrekt strukturerat för multilingual SEO.

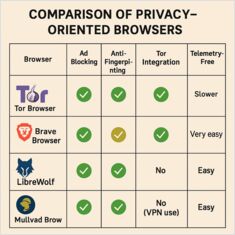

Inkluderar installationsanvisningar för Windows, Linux och Mac

Online-privat är ett hett ämne. Från målinriktade annonser till tysta spårningsverktyg delar många vanliga webbläsare mer om dig än du kanske vill. Lyckligtvis finns det flera integritetssäkrade webbläsare som hjälper dig att hålla dig säker och anonym.

Priser på konsument-GPU:er lämpliga för AI - RTX 5080 och RTX 5090

Låt oss jämföra priser för toppnivå-konsument-GPUs som är lämpliga för LLMs i synnerhet och AI i allmänhet. Specifikt tittar jag på RTX-5080 och RTX-5090-priser. De har något sjunkit.

Hur man utvecklar en Amazon Alexa-färdighet - instruktioner.

I denna artikel kommer vi att göra en djupdykning i Alexa-skillsutveckling, testning och publicering. Vi kommer också att täcka designprinciper, tekniska överväganden och bästa praxis för att säkerställa att din skill erbjuder ett engagerande och naturligt användarupplevelse.

Ingenstans särskilt fin.

Ollama’s GPT-OSS modeller har återkommande problem med att hantera strukturerad utdata, särskilt när de används med ramverk som LangChain, OpenAI SDK, vllm och andra.

Lätt olika API:er kräver en särskild tillvägagångssätt.

Här är en sida vid sida jämförelse av stöd för strukturerad utdata (att få tillförlitligt JSON tillbaka) över populära LLM-leverantörer (https://www.glukhov.org/sv/post/2025/10/structured-output-comparison-popular-llm-providers/ “strukturerad utdata över populära LLM-leverantörer”), plus minimala Python exempel

Några sätt att få strukturerad utdata från Ollama

Stora språkmodeller (LLMs) är kraftfulla, men i produktion vill vi sällan ha fritt formulerade stycken. Istället vill vi ha förutsägbart data: attribut, fakta eller strukturerade objekt som du kan mata in i en app. Det är LLM Strukturerad Utdata.

Snabbreferens till PostgreSQL

En snabbreferens för daglig PostgreSQL-arbete: anslutningar, SQL-syntax, psql-meta-kommandon, prestanda, JSON, fönsterfunktioner och mer.

Använda pandoc, python eller onlineverktyg för konvertering till MD

Konvertera Word-dokument till Markdown-format är en mycket vanlig uppgift för tekniska skrivare, utvecklare och innehållsskapare som vill flytta sitt innehåll till plattformar med Markdown (t.ex. GitHub, GitLab, statiska webbplatsgeneratorer som Hugo). Den här guiden är en del av vår Dokumentationsverktyg i 2026: Markdown, LaTeX, PDF & Skrivningsflöden hub.

En praktisk, kodtung syn på ORM i GO

De mest framträdande ORM:er för GO är GORM, Ent, Bun och sqlc. Här är en liten jämförelse mellan dem med exempel på CRUD-operationer i ren GO.

Lite statistik om Jabber / XMPP

Jabber (nu vanligtvis kallat XMPP) är ett öppet kommunikationsprotokoll och en samling klientprogram som möjliggör omedelbar meddelandetjänst, röst/video-samtal, konferenser, skärmdelning och närvaroegenskaper för individer och organisationer.