将 Ollama 模型移动到不同位置

Ollama LLM 模型文件占用大量空间

目录

在安装 ollama之后,最好立即重新配置 ollama,以便将模型存储在新位置。这样,当我们拉取新模型时,它就不会被下载到旧位置。

关于 Ollama

Ollama 是一个基于文本的 LLM AI 模型 前端,也可以用来托管这些模型的 API。

安装 Ollama

前往 https://ollama.com/download

在 Linux 上安装 Ollama:

curl -fsSL https://ollama.com/install.sh | sh

Windows 上的 Ollama 在此页面:https://ollama.com/download/windows

Mac 上的 Ollama 也在此处:https://ollama.com/download/macOllamaSetup.exe

下载、列出和删除 Ollama 模型

要下载一些 Ollama 模型:

前往 Ollama 仓库(https://ollama.com/library)并找到你需要的模型,

你还可以在那里找到模型标签和大小。

然后运行:

ollama pull gemma2:latest

# 或者获取一个更智能一点但仍能很好地适应 16GB 显存的模型:

ollama pull gemma2:27b-instruct-q3_K_S

# 或者:

ollama pull llama3.1:latest

ollama pull llama3.1:8b-instruct-q8_0

ollama pull mistral-nemo:12b-instruct-2407-q6_K

ollama pull mistral-small:22b-instruct-2409-q4_0

ollama pull phi3:14b-medium-128k-instruct-q6_K

ollama pull qwen2.5:14b-instruct-q5_0

要检查 Ollama 本地仓库中的模型:

ollama list

要删除一些不需要的模型:

ollama rm qwen2:7b-instruct-q8_0 # 例如

Ollama 模型位置

默认情况下,模型文件存储在以下位置:

- Windows: C:\Users%username%.ollama\models

- Linux: /usr/share/ollama/.ollama/models

- macOS: ~/.ollama/models

在 Windows 上配置 Ollama 模型路径

要在 Windows 上创建环境变量,可以按照以下步骤操作:

- 打开 Windows 设置。

- 前往系统。

- 选择“关于”。

- 选择“高级系统设置”。

- 转到“高级”选项卡。

- 选择“环境变量…”。

- 点击“新建…”。

- 创建一个名为 OLLAMA_MODELS 的变量,指向你希望存储模型的位置。

在 Linux 上移动 Ollama 模型

编辑 ollama 的 systemd 服务参数

sudo systemctl edit ollama.service

或

sudo xed /etc/systemd/system/ollama.service

这将打开一个编辑器。

对于每个环境变量,在 [Service] 部分下添加一行 Environment:

[Service]

Environment="OLLAMA_MODELS=/specialplace/ollama/models"

保存并退出。

还有 User 和 Group 参数,这些必须有权访问此文件夹。

重新加载 systemd 并重启 Ollama:

sudo systemctl daemon-reload

sudo systemctl restart ollama

如果出现问题:

systemctl status ollama.service

sudo journalctl -u ollama.service

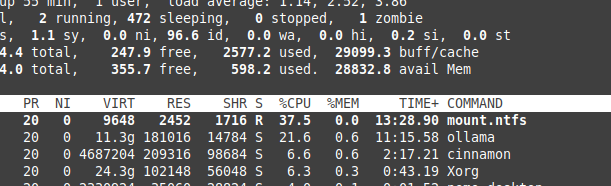

NTFS 分区上的文件存储开销

请注意,如果你在运行 Linux 并将模型存储在 NTFS 格式的分区上,

你的模型加载速度会比平常慢 20% 以上。

在 Windows 上将 Ollama 安装到特定文件夹

连同模型一起:

.\OllamaSetup.exe /DIR=D:\OllamaDir

将 Ollama API 暴露给内部网络

这里的“内部”指的是本地网络。

添加到服务配置中:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"