Öppen WebUI: Eget värd LLM-gränssnitt

Egenvärd ChatGPT-alternativ för lokala LLMs

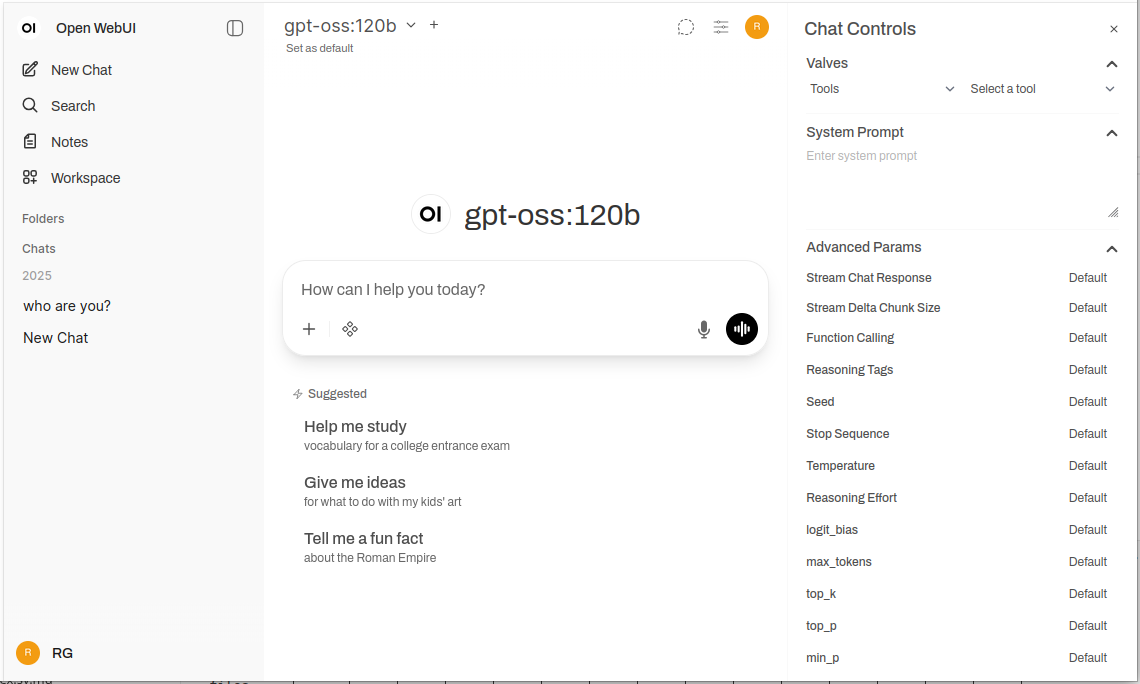

Öppna WebUI är ett kraftfullt, utökligt och funktionstomt självvärddat webbgränssnitt för att interagera med stora språkmodeller.

Det stöder Ollama och alla OpenAI-kompatibla API:er, vilket bringar den bekanta ChatGPT-upplevelsen till din infrastruktur med fullständig integritet, offline-förmåga och företagsnivå funktioner. För en bredare jämförelse av lokala och molnbaserade LLM-bakändar – Ollama, vLLM, Docker Model Runner, LocalAI och molnleverantörer – se LLM Hosting: Lokal, självvärddad & molninfrastruktur jämförd.

Vad är Open WebUI?

Open WebUI är ett öppen källkod, självvärddat webbprogram som ger en modern chattgränssnitt för att interagera med stora språkmodeller. Skiljer sig från molnbaserade AI-tjänster, kör Open WebUI helt på din infrastruktur, vilket ger dig full kontroll över dina data, samtal och modellval.

Även om Open WebUI ofta används med Ollama (och ibland informellt kallas för “Ollama WebUI”) är det i själva verket en plattform som är oberoende av bakänden. Det kan ansluta till Ollamas API för lokal modellkörning, men det stöder också alla OpenAI-kompatibla slutpunkter – inklusive vLLM, LocalAI, LM Studio, Text Generation WebUI och till och med molnleverantörer. Denna flexibilitet gör att Open WebUI är en omfattande lösning som stöder flera bakändar, RAG (Retrieval-Augmented Generation) för dokumentchatt, flera användarautentisering, röstfunktioner och omfattande anpassningsalternativ. Oavsett om du kör modeller på en laptop, en hemmaserver eller en Kubernetes-kluster, skalar Open WebUI för att möta dina behov.

Varför välja Open WebUI?

Integritet först: All data förblir på din infrastruktur – inga samtal, dokument eller promptar lämnar din nätverk om du inte explicit konfigurerar externa API:er.

Offline-förmåga: Perfekt för miljöer utan nätverk, begränsade nätverk eller situationer där internetåtkomst är oförlitlig eller förbjuden. När du parar det med lokalt körda modeller via Ollama eller vLLM uppnår du fullständig oberoende från molntjänster.

Funktionstomt: Trots att det är självvärddat, rivaliserar Open WebUI kommersiella erbjudanden med dokumentuppladdning och RAG, samtalshistorik med semantisk sökning, promptmallar och delning, modellhantering, röstin-/utgång, mobilanpassad design och mörk/lysande teman.

Stöd för flera användare: Inbyggd autentiseringssystem med rollbaserad åtkomstkontroll (admin, användare, väntande), användarhanteringsskärm, samtalsskydd, och delade promptar och modeller över team.

Snabbinstallationsguide

Den snabbaste sättet att komma igång med Open WebUI är att använda Docker. Detta avsnitt täcker de vanligaste distributionsscenario.

Grundläggande installation (ansluta till befintlig Ollama)

Om du redan har Ollama körande på din system, använd detta kommando:

docker run -d \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

Detta kör Open WebUI på port 3000, sparar data i en Docker-volym. Kom till http://localhost:3000.

Paketerad installation (Open WebUI + Ollama)

För en komplett all-in-one installation med Ollama inkluderad:

docker run -d \

-p 3000:8080 \

--gpus all \

-v ollama:/root/.ollama \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:ollama

Flaggan --gpus all aktiverar GPU-åtkomst för snabbare inferens. Omittera den om du kör CPU-endast.

Docker Compose Setup

För produktionsdistributioner, ger Docker Compose bättre underhållbarhet:

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

ports:

- "11434:11434"

volumes:

- ollama:/root/.ollama

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

open-webui:

image: ghcr.io/open-webui/open-webui:main

ports:

- "3000:8080"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

volumes:

- open-webui:/app/backend/data

depends_on:

- ollama

restart: always

volumes:

ollama:

open-webui:

Distribuera med docker-compose up -d.

Kubernetes Deployment

För företagsdistributioner, tillhandahåller Open WebUI Helm-diagram:

helm repo add open-webui https://helm.openwebui.com/

helm repo update

helm install open-webui open-webui/open-webui \

--set ollama.enabled=true \

--set ingress.enabled=true \

--set ingress.host=chat.yourdomain.com

Detta skapar en produktionsklar distribution med varaktig lagring, hälsokontroller och valfri ingresskonfiguration.

Djupdykning i kärnfunktioner

RAG och dokumentchatt

Open WebUIs RAG-implementering gör att du kan ladda upp dokument och låta modellen hänvisa till dem i samtal. Systemet skär automatiskt upp dokumenten, genererar inbäddningar, lagrar dem i en vektordatabas och hämtar relevant kontext när du ställer frågor.

Stödda format: PDF, DOCX, TXT, Markdown, CSV och mer via inbyggda parser.

Användning: Klicka på ‘+’-knappen i en chatt, välj ‘Ladda upp filer’, välj dina dokument och börja ställa frågor. Modellen kommer att citera relevanta passager och sidnummer i sina svar.

Konfiguration: Du kan justera chunkstorlek, överlapp, inbäddningsmodell och hämtningparametrar i admininställningarna för optimal prestanda med dina dokumenttyper.

Multi-user autentisering och hantering

Open WebUI innehåller ett komplett autentiseringssystem lämpligt för team och organisationsanvändning:

- Lokal autentisering: Användarnamn/lösenord med säker lösenordshashning

- OAuth/OIDC-integration: Anslut till befintliga identitetsleverantörer (Google, GitHub, Keycloak, etc.)

- LDAP/Active Directory: Företagskatalogintegritet

- Rollbaserad åtkomst: Admin (full kontroll), Användare (standardåtkomst), Väntande (kräver godkännande)

Admins kan hantera användare, övervaka användning, konfigurera modellåtkomst per användare/grupp och sätta samtalsbevarandeprinciper.

Röstin- och utgång

Inbyggd stöd för röstinteraktion gör att Open WebUI är tillgänglig och bekväm:

- Röst-till-text: Använder Web Speech API eller konfigurerade externa STT-tjänster

- Text-till-röst: Många TTS-motorer stöds (browserbaserade, Coqui TTS, ElevenLabs, etc.)

- Språkstöd: Fungerar med flera språk beroende på din TTS/STT-konfiguration

Promptengineeringverktyg

Open WebUI tillhandahåller robusta verktyg för prompthantering:

- Promptbibliotek: Spara ofta använda promptar som mallar

- Variabler och platshållare: Skapa återanvändbara promptar med dynamiskt innehåll

- Promptdelning: Dela effektiva promptar med ditt team

- Promptversionering: Spåra förändringar och förbättringar över tid

Modellhantering

Enkel modellbyte och hantering genom UI:

- Modellkatalog: Bläddra och hämta modeller direkt från Ollamas bibliotek

- Anpassade modeller: Ladda upp och konfigurera anpassade GGUF-modeller

- Modellparametrar: Justera temperatur, top-p, kontextlängd och andra samplingparametrar per samtal

- Modellmetadata: Visa modellinformation, storlek, kvantifiering och funktioner

Konfiguration och anpassning

Miljövariabler

Viktiga konfigurationsalternativ via miljövariabler:

# Bakänd URL (Ollama eller annan OpenAI-kompatibel API)

OLLAMA_BASE_URL=http://localhost:11434

# Aktivera autentisering

WEBUI_AUTH=true

# Standardanvändarroll (användare, admin, väntande)

DEFAULT_USER_ROLE=pending

# Aktivera användarregistrering

ENABLE_SIGNUP=true

# Admin e-post (skapa automatiskt adminkonto)

WEBUI_ADMIN_EMAIL=admin@example.com

# Databas (standard SQLite, eller PostgreSQL för produktionsanvändning)

DATABASE_URL=postgresql://user:pass@host:5432/openwebui

# Aktivera RAG

ENABLE_RAG=true

# Inbäddningsmodell för RAG

RAG_EMBEDDING_MODEL=sentence-transformers/all-MiniLM-L6-v2

Anslutning till alternativa bakändar

Open WebUI fungerar med alla OpenAI-kompatibla API:er. Konfigurera bas-URL:en i Inställningar → Anslutningar:

- vLLM:

http://localhost:8000/v1 - LocalAI:

http://localhost:8080 - LM Studio:

http://localhost:1234/v1 - Text Generation WebUI:

http://localhost:5000/v1 - OpenAI:

https://api.openai.com/v1(kräver API-nyckel) - Azure OpenAI: Anpassad slutpunkts-URL

Reverseproxykonfiguration

För produktionsdistributioner, kör Open WebUI bakom en reverseproxy:

Nginx-exempel:

server {

listen 443 ssl http2;

server_name chat.yourdomain.com;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# WebSocket-stöd

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}

Traefik-exempel (Docker etiketter):

labels:

- "traefik.enable=true"

- "traefik.http.routers.openwebui.rule=Host(`chat.yourdomain.com`)"

- "traefik.http.routers.openwebui.entrypoints=websecure"

- "traefik.http.routers.openwebui.tls.certresolver=letsencrypt"

- "traefik.http.services.openwebui.loadbalancer.server.port=8080"

Prestandaoptimering

Databaskonfiguration

För flera användare, byt från SQLite till PostgreSQL:

# Installera beroenden

pip install psycopg2-binary

# Konfigurera databas-URL

DATABASE_URL=postgresql://openwebui:password@postgres:5432/openwebui

PostgreSQL hanterar flera användare bättre och ger förbättrad frågeprestanda för samtalssökning och RAG-åtgärder.

Inbäddningsmodellval

RAG-prestanda beror starkt på ditt val av inbäddningsmodell:

- Snabb/Resurserbegränsad:

all-MiniLM-L6-v2(384 dimensioner, ~80MB) - Balanserad:

all-mpnet-base-v2(768 dimensioner, ~420MB) - Bästa kvalitet:

bge-large-en-v1.5(1024 dimensioner, ~1.3GB)

Konfigurera i Inställningar → RAG → Inbäddningsmodell.

Cachestrategier

Aktivera samtalscachering för att minska upprepade API-anrop:

- Modellcachering: Ollama cachar automatiskt laddade modeller i minnet

- Svars cachering: Open WebUI kan cacha identiska promptar (konfigurerbart)

- Inbäddningscachering: Återanvänd inbäddningar för tidigare bearbetade dokument

Säkerhetsrekommendationer

När du distribuerar Open WebUI i produktion, följ dessa säkerhetsriktlinjer:

- Aktivera autentisering: Aldrig kör Open WebUI utan autentisering på offentliga nätverk

- Använd HTTPS: Alltid distribuera bakom en reverseproxy med TLS/SSL

- Regelbundna uppdateringar: Håll Open WebUI och Ollama uppdaterade för säkerhetsreparationer

- Begränsa åtkomst: Använd brandväggsregler för att begränsa åtkomsten till tillitssäkra nätverk

- Säkra API-nycklar: Om du ansluter till externa API:er, använd miljövariabler, aldrig hårdkoda nycklar

- Övervakningsloggar: Aktivera och övervaka åtkomstloggar för misstänkt aktivitet

- Säkerhetskopiera data: Regelbundna säkerhetskopior av volymen

/app/backend/data - Databaskryptering: Aktivera kryptering vid vila för PostgreSQL i produktion

- Begränsning av förfrågningar: Konfigurera begränsning av förfrågningar för att förhindra missbruk

- Innehållsfiltrering: Implementera innehållspolitiker som är lämpliga för din organisation

Användningsfall och verkliga tillämpningar

Personlig kunskapsassistent

Kombinera Open WebUI med lokala modeller och RAG för att skapa en privat kunskapsbank. Ladda upp dina anteckningar, forskningspapper, projektinformation och personliga dokument. Fråga dem konversationellt utan att skicka data till molntjänster – perfekt för forskare, studenter och kunskapsarbetare som värderar integritet.

Utvecklarlagar samarbete

Distribuera Open WebUI för din utvecklarlag med gemensam åtkomst till teknisk dokumentation, API-specifikationer och kodbasinformation. RAG-funktionen gör att utvecklare snabbt hittar relevant information över tusentals sidor av dokument, medan samtalshistorik hjälper till att spåra arkitekturbeslut och tekniska diskussioner.

Företagsintern chatbot

Organisationer kan distribuera Open WebUI bakom deras brandvägg med SSO-integrering, vilket ger medarbetare en AI-assistent som har åtkomst till interna wikis, principer och procedurer. Rollbaserad åtkomst säkerställer att känslig information hålls korrekt segmenterad, medan adminkontroller upprätthåller styre och efterlevnad.

Utbildning och träning

Utbildningsinstitutioner använder Open WebUI för att ge studenter och lärare AI-hjälp utan integritetsproblem. Ladda upp kursmaterial, läroböcker och föreläsningsanteckningar för kontextuella frågor och svar. Den multi-användarsystemet gör att användning kan spåras medan studentdata hålls privata.

Hälso- och rättstjänsttillämpningar

I reglerade branscher där dataintegritet är kritisk, gör Open WebUI möjligt AI-hjälpade arbetsflöden medan man upprätthåller HIPAA eller GDPR-kompatibilitet. Medicinska personal kan fråga läkemedelsdatabaser och behandlingsprotokoll, medan rättstjänstteam kan söka efter fallrätt och kontrakt – allt utan att data lämnar kontrollerad infrastruktur.

Isolerade och offline-miljöer

Regeringsinstitutioner, forskningsfaciliteter och säkra operationscentra använder Open WebUI i isolerade nätverk. Den fullständiga offline-förmågan säkerställer att AI-hjälp är tillgänglig även utan internetanslutning, vilket är kritiskt för klassificerade miljöer eller fjärrplatser.

Felsökning av vanliga problem

Anslutningsproblem

Problem: Open WebUI kan inte ansluta till Ollama

Lösning: Verifiera att Ollama körs (curl http://localhost:114线), kontrollera miljövariabeln OLLAMA_BASE_URL och se till att brandväggsregler tillåter anslutningen. För Docker-distributioner, använd tjänstnamn (http://ollama:11434) istället för localhost.

Problem: Modeller visas inte i UI

Lösning: Bekräfta att modeller är installerade (ollama list), uppdatera modelllistan i Open WebUI-inställningar och kontrollera webbläsarkonsolen för API-fel.

RAG och dokumentuppladdningsproblem

Problem: Dokumentuppladdning misslyckas

Lösning: Kontrollera filstorleksgränser i inställningar, bekräfta stödda filformat, se till att det finns tillräckligt med diskutrymme i datavolymen och granska behållarloggar för parserfel.

Problem: RAG-svar refererar inte till uppladdade dokument

Lösning: Verifiera att inbäddningsmodellen är nedladdad och kör, kontrollera chunkstorleksinställningar (försök med mindre chunkar för bättre granularitet), öka antalet hämtade chunkar i RAG-inställningar och se till att frågan är relevant till dokumentinnehållet.

Prestandaproblem

Problem: Långsam respons

Lösning: Aktivera GPU-acceleration om tillgänglig, minska modellstorlek eller använd kvantifierade versioner, öka OLLAMA_NUM_PARALLEL för parallella förfrågningar och tilldela mer RAM till Docker-behållare.

Problem: Minnesfel

Lösning: Använd mindre modeller (7B istället för 13B parametrar), minska kontextlängd i modellparametrar, begränsa samtidiga användare eller lägg till mer RAM/swap till din system.

Autentisering och åtkomst

Problem: Kan inte logga in eller skapa adminkonto

Lösning: Ställ in WEBUI_AUTH=true, konfigurera WEBUI_ADMIN_EMAIL för att skapa admin automatiskt, rensa webbläsarens cookies och cache och kontrollera behållarloggar för databasfel.

Problem: Användare kan inte registrera sig

Lösning: Verifiera att ENABLE_SIGNUP=true, kontrollera DEFAULT_USER_ROLE-inställningen (använd användare för automatisk godkännande eller väntande för manuell godkännande) och se till att databasen är skrivbar.

Alternativ till Open WebUI

Även om Open WebUI är utmärkt för att tillhandahålla en självvärddad gränssnitt med stark Ollama-integrering, erbjuder flera alternativ olika tillvägagångssätt till samma problemområde. Din val beror på om du behöver flera leverantörsflexibilitet, specialiserad dokumenthantering, extrema enkelhet eller företagsfunktioner.

LibreChat utmärker sig som den mest leverantörsagokrata lösningen, med inbyggd stöd för OpenAI, Anthropic, Azure OpenAI, Google Vertex AI, AWS Bedrock och Ollama i ett enda gränssnitt. Dess pluginarkitektur och företagsfunktioner som flera hyllning, detaljerade åtkomstkontroller och användningskvoter gör det idealiskt för organisationer som behöver stödja flera AI-leverantörer eller kräver avancerade översynsloggar. Den kostnaden är komplexitet – LibreChat kräver mer inställningsarbete och tungare resurser än Open WebUI, och dess Ollama-stöd känns sekundärt till molnleverantörer. Om din team använder Claude för skrivning, GPT-4 för kodning och lokala modeller för integritetskänsliga arbete, lyser LibreChats enhetliga gränssnitt.

För dokumentintensiva arbetsflöden, AnythingLLM tar en kunskapsbank-först tillvägagångssätt som går bortom grundläggande RAG. Dess arbetsplatsmodell organiserar dokument och samtal i isolerade miljöer, medan avancerade hämtningssystem inkluderar hybrid sökning, omrankning och citatövervakning. Dataanslutare hämtar innehåll från GitHub, Confluence och Google Drive, och agentfunktioner möjliggör flerstegsresonemang och arbetsflödesautomatisering. Detta gör AnythingLLM utmärkt för konsultföretag som hanterar flera klientkunskapsbankar eller supportteam som arbetar med omfattande dokumentation. Chattgränssnittet är mindre polerat än Open WebUI, men om du frågar stora dokumentsamlingar är den avancerade hämtningssystemet värt den större inlärningskurvan.

LobeChat prioriterar användarupplevelse över funktiondjup, med ett slät, mobilanpassat gränssnitt med progressive web app-funktioner. Dess moderna design, smida animationer och stark röst/multimodalstöd gör det populärt med designare och icke-tekniska användare som vill ha en AI-assistent som fungerar sömlöst över enheter. Den PWA-implementeringen ger en applikation-liknande mobilupplevelse som Open WebUI inte matchar. Dock är företagsfunktioner begränsade, pluginökosystemet är mindre och RAG-funktioner ligger bakom både Open WebUI och AnythingLLM.

För användare som föredrar desktopapplikationer, Jan.ai tillhandahåller tvärvägsinstallationsprogram (Windows, macOS, Linux) med nollkonfiguration för lokal modellhantering. Det finns ingen behov att installera Ollama separat eller hantera Docker – Jan packar allt i en nativ app med systemtraystöd och enkla modellnedladdningar. Detta “det fungerar” filosofi gör Jan idealisk för att ge lokala LLM:er till familjemedlemmar eller kollegor som inte är bekväma med kommandoradstöd. Kompromisserna är ingen flera användarstöd, färre avancerade funktioner och ingen fjärråtkomstförmåga.

Chatbox tar upp den lättviktiga nischen – en minimal tvärvägsklient som stöder OpenAI, Claude, Gemini och lokala API:er med mycket låg resursoverhead. Det är perfekt för utvecklare som behöver snabbt testa olika API-leverantörer eller användare med resurserbegränsad hårdvara. Inställningsfrictionen är minimal, men vissa funktioner är prenumerationsbegränsade, det är inte helt öppen källkod och RAG-stöd är begränsat.

Flera Ollama-specifika minimala gränssnitt finns för användare som vill ha “bara tillräckligt” gränssnitt: Hollama hanterar flera Ollama-servrar över olika datorer, Ollama UI tillhandahåller grundläggande chatt och PDF-uppladdning med extremt enkel distribution, och Oterm erbjuder en förvånansvärt kapabel terminalbaserad gränssnitt för SSH-sessioner och tmux-arbetsflöden. Dessa ger upp funktioner för enkelhet och hastighet.

För organisationer som kräver leverantörsstöd, kommerciella alternativ som TypingMind Team, BionicGPT och Dust.tt erbjuder självvärddad med professionellt stöd, kompliancecertifieringar och SLA. De byter öppen källkodsfrihet för säker uppgiftstid, säkerhetsgranskningar och ansvar – lämpligt när din organisation behöver företagsnivå stödavtal.

Välj visst: Open WebUI träffar den perfekta punkten för de flesta självvärdda Ollama-distributioner, balanserar omfattande funktioner med hanterbar komplexitet. Välj LibreChat när leverantörsflexibilitet är avgörande, AnythingLLM för avancerade dokumentarbetsflöden, LobeChat för mobilförst eller designmedvetna användare, Jan för icke-tekniska desktopanvändare eller kommersiella alternativ när du behöver leverantörsstöd. För de flesta tekniska användare som kör lokala modeller, gör Open WebUIs aktiv utveckling, stark community och utmärkt RAG-implementering det rekommenderade utgångspunkten.

Framtida utveckling och roadmap

Open WebUI fortsätter snabb utveckling med flera spännande funktioner på roadmap:

Förbättrad multimodalstöd: Bättre hantering av bilder, visionsmodeller och multimodal samtal med modeller som LLaVA och Bakllava.

Förbättrad agentfunktioner: Funktionssamtal, verktygsspel och flerstegsresonemangssystem liknande AutoGPT-mönster.

Bättre mobilappar: Nativ iOS- och Android-appar utöver den aktuella PWA-implementeringen för förbättrad mobilupplevelse.

Avancerade RAG-funktioner: Grafbaserad RAG, semantisk chunkning, flerfrågshämtning och föräldradokumenthämtning för bättre kontext.

Samarbetsfunktioner: Delade samtal, teamarbetsplatser och realtidsarbete på promptar och dokument.

Företagsintegreringar: Djupare SSO-stöd, SCIM-provisionering, avancerade översynsloggar och kompliancerapportering för reglerade branscher.

Projektet upprätthåller bakåtkompatibilitet och semantisk versionering, vilket gör uppgraderingar enkla. Den aktiva GitHub-repositoriet ser dagliga commitar och reaktiva issuehantering.

Slutsats

Open WebUI har utvecklats från en enkel Ollama-frontend till en omfattande plattform för självvärdda AI-interaktioner. Dess kombination av integritet, funktioner och enkel distribution gör det till ett utmärkt val för individer, team och organisationer som vill utnyttja lokala LLM:er utan att ge upp funktioner.

Oavsett om du är en utvecklare som testar modeller, en organisation som bygger inre AI-verktyg eller en enskild som prioriterar integritet, tillhandahåller Open WebUI grunden för kraftfulla, självvärdda AI-arbetsflöden. Den aktiva communityn, regelbundna uppdateringar och utökbara arkitekturen säkerställer att det kommer att vara en ledande alternativ i självvärdda AI-området.

Börja med den grundläggande Docker-installationen, experimentera med RAG genom att ladda upp några dokument, prova olika modeller från Ollamas bibliotek och gradvis utforska avancerade funktioner som dina behov växer. Lärningskurvan är mild, men taket är högt – Open WebUI skalar från personlig laptop till företagskuberneteskluster.

För de som jämför alternativ, gör Open WebUIs Ollama-först design, balanserad funktionssnitt och aktiv utveckling det rekommenderade utgångspunkten för de flesta självvärdda LLM-distributioner. Du kan alltid migrera till mer specialiserade lösningar om specifika behov uppstår, men många användare hittar Open WebUIs funktioner tillräckliga för deras hela resa från experiment till produktion. För att se hur Open WebUIs typiska bakändar (Ollama, vLLM, etc.) passar med Docker Model Runner, LocalAI och molnleverantörer, kontrollera vår LLM Hosting: Lokal, självvärddad & molninfrastruktur jämförd guide.

Några användbara länkar

När du sätter upp din Open WebUI-miljö kommer du att få nytta av att förstå den bredare ekosystemet av lokala LLM-värd och distributionsalternativ. Den omfattande guiden Lokal LLM Hosting: Komplett 2025 Guide - Ollama, vLLM, LocalAI, Jan, LM Studio & Mer jämför 12+ lokala LLM-verktyg inklusive Ollama, vLLM, LocalAI och andra, vilket hjälper dig att välja optimal bakända för din Open WebUI-distribution baserat på API-mognad, verktygsanropsförmåga och prestandajämförelser.

För högprestanda produktionsdistributioner där genomströmning och latens är kritiska, utforska guiden vLLM Quickstart: High-Performance LLM Serving som täcker vLLM setup med Docker, OpenAI API kompatibilitet och PagedAttention optimering. Detta är särskilt värdefullt om Open WebUI tjänar flera samtidiga användare och Ollamas prestanda blir en fläck.

Förstå hur din bakända hanterar parallella förfrågningar är avgörande för kapacitetsplanering. Artikeln Hur Ollama Hanterar Parallella Förfrågningar förklarar Ollamas förfrågningsschemat, GPU-minneshantering och parallell exekveringsmodell, vilket hjälper dig att konfigurera lämpliga gränser och förväntningar för din Open WebUI-distribution i flera användar scenarier.

Externa resurser

För officiell dokumentation och communitystöd, hänvisa till dessa externa resurser: