Korsmodala inbäddningar: Broar mellan AI-modaliteter

Förena text, bilder och ljud i gemensamma inbäddningsutrymmen

Korsmodal inbäddning representerar en genombrottsteknik inom artificiell intelligens, som möjliggör förståelse och resonemang över olika datatyper inom ett gemensamt representationsutrymme.

Denna teknik driver moderna multimodala applikationer från bildsökning till innehållsgenerering.

Detta bild är från artikeln:

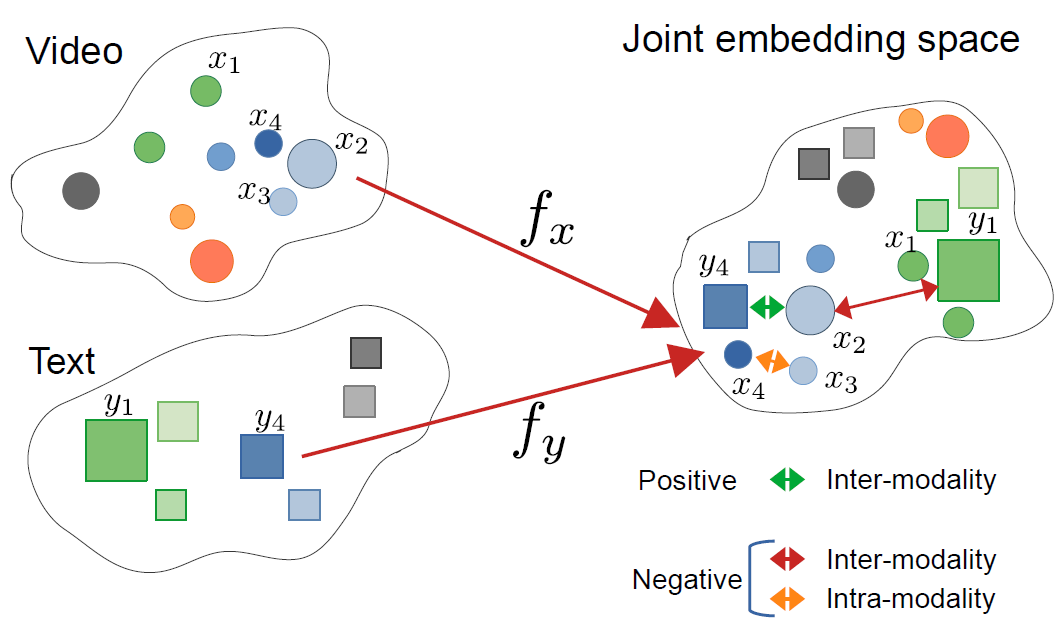

CrossCLR: korsmodal kontrastivt lärande för multimodala videorepresentationer, av Mohammadreza Zolfaghari och andra

Detta bild är från artikeln:

CrossCLR: korsmodal kontrastivt lärande för multimodala videorepresentationer, av Mohammadreza Zolfaghari och andra

Förståelse av korsmodal inbäddning

Korsmodal inbäddning är vektorrepresentationer som kodar information från olika modaliteter - såsom text, bilder, ljud och video - i ett gemensamt inbäddningsutrymme. Till skillnad från traditionella enskilda modalitetsinbäddningar lär sig korsmodala metoder en enhetlig representation där semantiskt liknande begrepp klustrar ihop sig oavsett deras ursprungliga format.

Vad är korsmodal inbäddning?

I sin kärna löser korsmodal inbäddning en kritisk utmaning inom AI: hur man jämför och relaterar information över olika datatyper. En traditionell bildklassificerare kan bara arbeta med bilder, medan en textmodell bara hanterar text. Korsmodal inbäddning brygger denna klyfta genom att projicera olika modaliteter i ett gemensamt vektorutrymme där:

- En bild av en katt och ordet “katt” har liknande inbäddningsvektorer

- Semantiska relationer bevaras över modaliteter

- Avståndsmått (cosinuslikhet, euklidisk distans) mäter korsmodal likhet

Denna enhetliga representation möjliggör kraftfulla funktioner som att söka bilder med textfrågor, generera bildtexter eller till och med nollskottklassificering utan uppgiftspecifik träning.

Arkitekturen bakom korsmodalt lärande

Moderna korsmodala system använder vanligtvis dubbla encoder-arkitekturer med kontrastivt lärande:

Dubbla encoders: Separata neurala nätverk kodar varje modalitet. Till exempel använder CLIP:

- En visionstransformator (ViT) eller ResNet för bilder

- En transformerbaserad textencoder för språk

Kontrastivt lärande: Modellen lär sig genom att maximera likheten mellan matchande par (t.ex. bild och dess bildtext) samtidigt som likheten mellan icke-matchande par minimeras. Den kontrastiva förlustfunktionen kan uttryckas som:

[ \mathcal{L} = -\log \frac{\exp(\text{sim}(v_i, t_i) / \tau)}{\sum_{j=1}^{N} \exp(\text{sim}(v_i, t_j) / \tau)} ]

där (v_i) är bildinbäddningen, (t_i) är textinbäddningen, (\text{sim}) är likhet (vanligtvis cosinus), och (\tau) är en temperaturparameter.

Nyckelteknologier och modeller

CLIP: Banbrytande för vision-språkförståelse

OpenAIs CLIP (Contrastive Language-Image Pre-training) revolutionerade fältet genom att träna på 400 miljoner bild-textpar från internet. Modellarkitekturen består av:

import torch

from transformers import CLIPProcessor, CLIPModel

from PIL import Image

# Ladda förtränad CLIP-modell

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

# Förbereda indata

image = Image.open("example.jpg")

texts = ["en foto av en katt", "en foto av en hund", "en foto av en fågel"]

# Bearbeta och få inbäddningar

inputs = processor(text=texts, images=image, return_tensors="pt", padding=True)

# Få korsmodal likhetspoäng

outputs = model(**inputs)

logits_per_image = outputs.logits_per_image

probs = logits_per_image.softmax(dim=1)

print(f"Sannolikheter: {probs}")

CLIP:s nyckelinnovation var skala och enkelhet. Genom att träna på massiv webbskalig data utan manuell märkning uppnådde den imponerande nollskottsoverföringsförmåga. Hur skiljer sig CLIP från traditionella visionsmodeller? Till skillnad från övervakade klassificerare tränade på fasta etikettuppsättningar lär sig CLIP från naturlig språksupervision, vilket gör den anpassningsbar till vilken visuell koncept som helst som kan beskrivas i text.

ImageBind: Utökning till sex modaliteter

Metas ImageBind utökar korsmodal inbäddning bortom vision och språk för att inkludera:

- Ljud (miljö ljud, tal)

- Djupinformation

- Termisk bildgivning

- IMU (rörelsesensor) data

Detta skapar ett verkligt multimodalt inbäddningsutrymme där alla sex modaliteter är sammanhängande. Den centrala insikten är att bilder fungerar som en “bindande” modalitet - genom att para ihop bilder med andra modaliteter och utnyttja befintlig vision-språkjustering skapar ImageBind ett enhetligt utrymme utan att kräva alla möjliga modalitetspar under träning.

Öppna källalternativ

Ekosystemet har expanderat med flera öppna källimplementeringar:

OpenCLIP: En communityimplementering som erbjuder större modeller och olika träningsrecept:

import open_clip

model, _, preprocess = open_clip.create_model_and_transforms(

'ViT-L-14',

pretrained='laion2b_s32b_b82k'

)

tokenizer = open_clip.get_tokenizer('ViT-L-14')

LAION-5B Modeller: Tränade på den massiva öppna LAION-5B-datamängden, som erbjuder alternativ till proprietära modeller med jämförbar eller bättre prestanda.

För utvecklare som är intresserade av state-of-the-art öppna källtextinbäddningslösningar, erbjuder de Qwen3 Embedding & Reranker Modeller på Ollama utmärkt flerspråkig prestanda med enkel lokal distribution.

Implementeringsstrategier

Bygga ett korsmodalt söksystem

En praktisk implementering av korsmodal inbäddning för semantisk sökning involverar flera komponenter. Vilka är de huvudsakliga tillämpningarna av korsmodal inbäddning? De driver användningsområden från e-handelsproduktsökning till innehållsmoderering och kreativa verktyg.

import numpy as np

from typing import List, Tuple

import faiss

from transformers import CLIPModel, CLIPProcessor

class CrossModalSearchEngine:

def __init__(self, model_name: str = "openai/clip-vit-base-patch32"):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.image_index = None

self.image_metadata = []

def encode_images(self, images: List) -> np.ndarray:

"""Kodning av bilder till inbäddningar"""

inputs = self.processor(images=images, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_image_features(**inputs)

return embeddings.cpu().numpy()

def encode_text(self, texts: List[str]) -> np.ndarray:

"""Kodning av textfrågor till inbäddningar"""

inputs = self.processor(text=texts, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_text_features(**inputs)

return embeddings.cpu().numpy()

def build_index(self, image_embeddings: np.ndarray):

"""Bygg FAISS-index för effektiv likhetssökning"""

dimension = image_embeddings.shape[1]

# Normalisera inbäddningar för cosinuslikhet

faiss.normalize_L2(image_embeddings)

# Skapa index (använd HNSW för stora skalor)

self.image_index = faiss.IndexHNSWFlat(dimension, 32)

self.image_index.hnsw.efConstruction = 40

self.image_index.add(image_embeddings)

def search(self, query: str, k: int = 10) -> List[Tuple[int, float]]:

"""Sök efter bilder med textfråga"""

query_embedding = self.encode_text([query])

faiss.normalize_L2(query_embedding)

distances, indices = self.image_index.search(query_embedding, k)

return list(zip(indices[0], distances[0]))

# Användningsexempel

engine = CrossModalSearchEngine()

# Bygg index från bildsamling

image_embeddings = engine.encode_images(image_collection)

engine.build_index(image_embeddings)

# Sök med text

results = engine.search("solnedgång över bergen", k=5)

Finjustering för domänspecifika uppgifter

Medan förtränade modeller fungerar bra för allmänna ändamål, gynnas domänspecifika applikationer av finjustering:

from transformers import CLIPModel, CLIPProcessor, AdamW

import torch.nn as nn

class FineTuneCLIP:

def __init__(self, model_name: str, num_epochs: int = 10):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.num_epochs = num_epochs

def contrastive_loss(self, image_embeddings, text_embeddings, temperature=0.07):

"""Beräkna InfoNCE kontrastiv förlust"""

# Normalisera inbäddningar

image_embeddings = nn.functional.normalize(image_embeddings, dim=1)

text_embeddings = nn.functional.normalize(text_embeddings, dim=1)

# Beräkna likhetsmatris

logits = torch.matmul(image_embeddings, text_embeddings.T) / temperature

# Etiketter är diagonal (matchande par)

labels = torch.arange(len(logits), device=logits.device)

# Symmetrisk förlust

loss_i = nn.functional.cross_entropy(logits, labels)

loss_t = nn.functional.cross_entropy(logits.T, labels)

return (loss_i + loss_t) / 2

def train(self, dataloader, learning_rate=5e-6):

"""Finjustera på domänspecifik data"""

optimizer = AdamW(self.model.parameters(), lr=learning_rate)

self.model.train()

for epoch in range(self.num_epochs):

total_loss = 0

for batch in dataloader:

images, texts = batch['images'], batch['texts']

# Bearbeta indata

inputs = self.processor(

text=texts,

images=images,

return_tensors="pt",

padding=True

)

# Framåtpass

outputs = self.model(**inputs, return_loss=True)

loss = outputs.loss

# Bakåtpass

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_loss += loss.item()

avg_loss = total_loss / len(dataloader)

print(f"Epoch {epoch+1}/{self.num_epochs}, Förlust: {avg_loss:.4f}")

Produktionsdistributionsöverväganden

Optimering av inferensprestanda

Hur kan jag optimera korsmodala inbäddningar för produktion? Prestandaoptimering är avgörande för verklig distribution:

Modellkvantisering: Minska modellstorlek och öka inferenshastighet:

import torch

from torch.quantization import quantize_dynamic

# Dynamisk kvantisering för CPU-inferens

quantized_model = quantize_dynamic(

model,

{torch.nn.Linear},

dtype=torch.qint8

)

ONNX-konvertering: Exportera till ONNX för optimerad inferens:

import torch.onnx

dummy_input = processor(text=["sample"], return_tensors="pt")

torch.onnx.export(

model,

tuple(dummy_input.values()),

"clip_model.onnx",

input_names=['input_ids', 'attention_mask'],

output_names=['output'],

dynamic_axes={

'input_ids': {0: 'batch_size'},

'attention_mask': {0: 'batch_size'}

}

)

Batchbehandling: Maximera GPU-utnyttjande genom batchning:

def batch_encode(items: List, batch_size: int = 32):

"""Behandla objekt i batcher för effektivitet"""

embeddings = []

for i in range(0, len(items), batch_size):

batch = items[i:i+batch_size]

batch_embeddings = encode_batch(batch)

embeddings.append(batch_embeddings)

return np.concatenate(embeddings, axis=0)

Skalbar vektordatabas

För stora applikationer är vektordatabaser avgörande. Vilka ramverk stöder korsmodala inbäddningsimplementeringar? Utöver modellerna själva är infrastrukturen viktig:

FAISS (Facebook AI Similarity Search): Effektiv likhetssökningsbibliotek

- Stöder miljarder vektorer

- Flera indextyper (flat, IVF, HNSW)

- GPU-acceleration tillgänglig

Milvus: Öppen källkod vektordatabas

from pymilvus import connections, Collection, FieldSchema, CollectionSchema, DataType

# Definiera schema

fields = [

FieldSchema(name="id", dtype=DataType.INT64, is_primary=True, auto_id=True),

FieldSchema(name="embedding", dtype=DataType.FLOAT_VECTOR, dim=512),

FieldSchema(name="metadata", dtype=DataType.JSON)

]

schema = CollectionSchema(fields, description="Bildinbäddningar")

# Skapa samling

collection = Collection("images", schema)

# Skapa index

index_params = {

"metric_type": "IP", # Inre produkt (kosinuslikhet)

"index_type": "IVF_FLAT",

"params": {"nlist": 1024}

}

collection.create_index("embedding", index_params)

Pinecone/Weaviate: Hanterade vektordatabas tjänster som erbjuder enkel skalning och underhåll.

Avancerade användningsområden och applikationer

Nollskottklassificering

Korsmodala inbäddningar möjliggör klassificering utan uppgiftspecifik träning. Denna funktion sträcker sig bortom traditionella datorseende metoder - till exempel, om du är intresserad av mer specialiserad objektdetektion med TensorFlow, representerar det en komplementär övervakad inlärningsmetod för specifika detekteringsuppgifter.

def zero_shot_classify(image, candidate_labels: List[str], model, processor):

"""Klassificera bild i godtyckliga kategorier"""

# Skapa textprompts

text_inputs = [f"a photo of a {label}" for label in candidate_labels]

# Hämta inbäddningar

inputs = processor(

text=text_inputs,

images=image,

return_tensors="pt",

padding=True

)

outputs = model(**inputs)

# Beräkna sannolikheter

logits = outputs.logits_per_image

probs = logits.softmax(dim=1)

# Returnera rankade förutsägelser

sorted_indices = probs.argsort(descending=True)[0]

return [(candidate_labels[idx], probs[0][idx].item()) for idx in sorted_indices]

# Exempelanvändning

labels = ["cat", "dog", "bird", "fish", "horse"]

predictions = zero_shot_classify(image, labels, model, processor)

print(f"Top prediction: {predictions[0]}")

Multimodal RAG (Retrieval-Augmented Generation)

Kombinationen av korsmodala inbäddningar med språkmodeller skapar kraftfulla multimodala RAG-system. När du har hämtat relevanta dokument kan omrankning med inbäddningsmodeller betydligt förbättra kvaliteten på resultaten genom att omordna hämtade kandidater baserat på relevans:

class MultimodalRAG:

def __init__(self, clip_model, llm_model):

self.clip = clip_model

self.llm = llm_model

self.knowledge_base = []

def add_documents(self, images, texts, metadata):

"""Lägg till multimodala dokument i kunskapsbasen"""

image_embeds = self.clip.encode_images(images)

text_embeds = self.clip.encode_text(texts)

# Lagra kombinerad information

for i, (img_emb, txt_emb, meta) in enumerate(

zip(image_embeds, text_embeds, metadata)

):

self.knowledge_base.append({

'image_embedding': img_emb,

'text_embedding': txt_emb,

'metadata': meta,

'index': i

})

def retrieve(self, query: str, k: int = 5):

"""Hämta relevant multimodal innehåll"""

query_embedding = self.clip.encode_text([query])[0]

# Beräkna likheter

similarities = []

for doc in self.knowledge_base:

# Genomsnittlig likhet över modaliteter

img_sim = np.dot(query_embedding, doc['image_embedding'])

txt_sim = np.dot(query_embedding, doc['text_embedding'])

combined_sim = (img_sim + txt_sim) / 2

similarities.append((combined_sim, doc))

# Returnera top-k

similarities.sort(reverse=True)

return [doc for _, doc in similarities[:k]]

def answer_query(self, query: str):

"""Svara på fråga med hjälp av hämtad multimodal kontext"""

retrieved_docs = self.retrieve(query)

# Skapa kontext från hämtade dokument

context = "\n".join([doc['metadata']['text'] for doc in retrieved_docs])

# Generera svar med LLM

prompt = f"Context:\n{context}\n\nQuestion: {query}\n\nAnswer:"

answer = self.llm.generate(prompt)

return answer, retrieved_docs

Om du implementerar produktions-RAG-system i Go, kan du hitta den här guiden om omrankning av textdokument med Ollama och Qwen3 Embedding-modell i Go särskilt användbar för att optimera hämtningskvaliteten.

Innehållsmoderering och säkerhet

Korsmodala inbäddningar utmärker sig vid upptäckten av olämpligt innehåll över modaliteter:

class ContentModerator:

def __init__(self, model, processor):

self.model = model

self.processor = processor

# Definiera säkerhetskategorier

self.unsafe_categories = [

"violent content",

"adult content",

"hateful imagery",

"graphic violence",

"explicit material"

]

self.safe_categories = [

"safe for work",

"family friendly",

"educational content"

]

def moderate_image(self, image, threshold: float = 0.3):

"""Kontrollera om bilden innehåller osäkert innehåll"""

# Kombinera alla kategorier

all_categories = self.unsafe_categories + self.safe_categories

text_inputs = [f"image containing {cat}" for cat in all_categories]

# Hämta förutsägelser

inputs = self.processor(

text=text_inputs,

images=image,

return_tensors="pt"

)

outputs = self.model(**inputs)

probs = outputs.logits_per_image.softmax(dim=1)[0]

# Kontrollera osäkra kategorier

unsafe_scores = probs[:len(self.unsafe_categories)]

max_unsafe_score = unsafe_scores.max().item()

return {

'is_safe': max_unsafe_score < threshold,

'confidence': 1 - max_unsafe_score,

'flagged_categories': [

self.unsafe_categories[i]

for i, score in enumerate(unsafe_scores)

if score > threshold

]

}

Bästa praxis och vanliga fallgropar

Datapreprocessering

Rätt preprocessering är avgörande för optimal prestanda:

from torchvision import transforms

# Standard CLIP-preprocessering

clip_transform = transforms.Compose([

transforms.Resize(224, interpolation=transforms.InterpolationMode.BICUBIC),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(

mean=[0.48145466, 0.4578275, 0.40821073],

std=[0.26862954, 0.26130258, 0.27577711]

)

])

Hantering av bias och rättvisa

Korsmodala modeller kan ärva bias från träningsdata:

Minskningstekniker:

- Utvärdera på olika demografiska grupper

- Använd debiasing-tekniker under finjustering

- Implementera rättvishetsmedveten hämtning

- Regelbunden revision och övervakning i produktion

Bedömning av inbäddningskvalitet

Övervaka inbäddningskvalitet i produktion:

def assess_embedding_quality(embeddings: np.ndarray):

"""Beräkna mått för inbäddningskvalitet"""

# Beräkna genomsnittligt parvis avstånd

distances = np.linalg.norm(

embeddings[:, None] - embeddings[None, :],

axis=2

)

avg_distance = distances.mean()

# Kontrollera för kluster (lågt intra-klusteravstånd)

from sklearn.cluster import KMeans

kmeans = KMeans(n_clusters=10)

labels = kmeans.fit_predict(embeddings)

# Beräkna silhouette-score

from sklearn.metrics import silhouette_score

score = silhouette_score(embeddings, labels)

return {

'avg_pairwise_distance': avg_distance,

'silhouette_score': score

}

Docker Deployment Example

Paketera din korsmodalapplikation för enkel distribution:

FROM nvidia/cuda:11.8.0-cudnn8-runtime-ubuntu22.04

# Installera Python och beroenden

RUN apt-get update && apt-get install -y python3-pip

WORKDIR /app

# Installera krav

COPY requirements.txt .

RUN pip3 install --no-cache-dir -r requirements.txt

# Kopiera applikationskod

COPY . .

# Exponera API-port

EXPOSE 8000

# Kör API-server

CMD ["uvicorn", "api:app", "--host", "0.0.0.0", "--port", "8000"]

# api.py - FastAPI-server för korsmodalembeddingar

from fastapi import FastAPI, File, UploadFile

from pydantic import BaseModel

import torch

from PIL import Image

import io

app = FastAPI()

# Ladda modell vid start

@app.on_event("startup")

async def load_model():

global model, processor

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

if torch.cuda.is_available():

model = model.cuda()

class TextQuery(BaseModel):

text: str

@app.post("/embed/text")

async def embed_text(query: TextQuery):

inputs = processor(text=[query.text], return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_text_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/embed/image")

async def embed_image(file: UploadFile = File(...)):

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(images=image, return_tensors="pt")

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_image_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/similarity")

async def compute_similarity(

text: TextQuery,

file: UploadFile = File(...)

):

# Hämta båda embeddingarna

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(text=[text.text], images=image, return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

outputs = model(**inputs)

similarity = outputs.logits_per_image[0][0].item()

return {"similarity": similarity}

Framtida riktningar

Fältet för korsmodalembeddingar utvecklas fortfarande snabbt:

Större modalitetsbehandling: Framtida modeller kommer troligen att inkludera ytterligare modaliteter som beröring (haptisk återkoppling), lukt och smak för en verkligt omfattande multimodal förståelse.

Förbättrad effektivitet: Forskning om destillation och effektiva arkitekturer kommer att göra kraftfulla korsmodalmodeller tillgängliga på enhetsnivå.

Bättre sammanställning: Avancerade tekniker för att sammanställa modaliteter mer exakt, inklusive cykelkonsistensförluster och motstridig träning.

Kompositionell förståelse: Gå bortom enkel objekterkänning till att förstå komplexa relationer och sammansättningar över modaliteter.

Temporär modellering: Bättre hantering av videodata och tidsserier med explicit temporär resonemang i embeddingsrymden.

Användbara länkar

- OpenAI CLIP Repository

- OpenCLIP: Open Source Implementation

- Hugging Face Transformers Documentation

- Meta ImageBind

- LAION-5B Dataset

- FAISS Documentation

- Milvus Vector Database

- Pinecone Vector Database

- Paper: Learning Transferable Visual Models From Natural Language Supervision

- Paper: ImageBind: One Embedding Space To Bind Them All

- Concrete Reinforcement Bar Caps object detection with tensorflow

- Reranking with embedding models

- Reranking text documents with Ollama and Qwen3 Embedding model - in Go

- Qwen3 Embedding & Reranker Models on Ollama: State-of-the-Art Performance

Korsmodalembeddingar representerar ett paradigmskifte i hur AI-system bearbetar och förstår information. Genom att bryta ner barriärerna mellan olika datatyper möjliggör dessa tekniker mer naturliga och kapabla AI-applikationer. Oavsett om du bygger söksystem, innehållsmoderationsverktyg eller kreativa applikationer, öppnar mästandet av korsmodalembeddingar upp en värld av möjligheter för innovation inom multimodal AI.