Kör FLUX.1-dev GGUF Q8 i Python

Accelerera FLUX.1-dev med GGUF-kvantisering

FLUX.1-dev är en kraftfull text-till-bild-modell som producerar imponerande resultat, men dess minneskrav på 24GB+ gör den svår att köra på många system. GGUF-kvantisering av FLUX.1-dev erbjuder en lösning, reducerar minnesanvändningen med cirka 50% samtidigt som bildkvaliteten bibehålls.

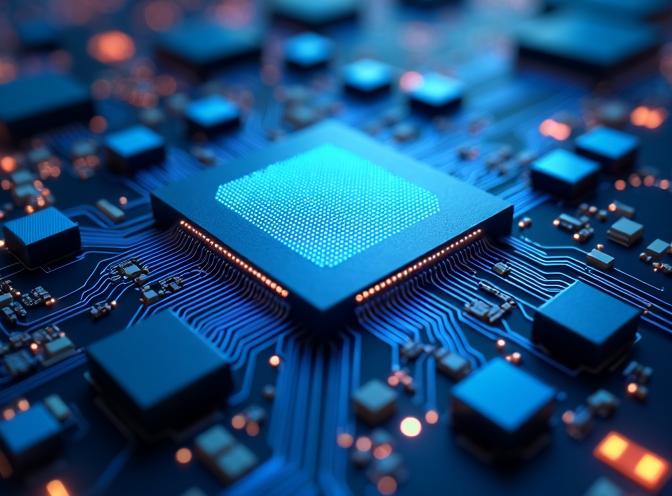

Den här bilden genererades med den Q8-kvantiserade FLUX.1-dev-modellen i GGUF-format, vilket visar att kvaliteten bevaras även med reducerad minnesanvändning.

Den här bilden genererades med den Q8-kvantiserade FLUX.1-dev-modellen i GGUF-format, vilket visar att kvaliteten bevaras även med reducerad minnesanvändning.

Vad är GGUF-kvantisering?

GGUF (GPT-Generated Unified Format) är ett kvantiseringsformat som ursprungligen utvecklades för språkmodeller men nu stöds för diffusionsmodeller som FLUX. Kvantisering minskar modellstorleken genom att lagra vikter i lägre precision (8-bit, 6-bit eller 4-bit) istället för full 16-bit eller 32-bit precision.

För FLUX.1-dev kan transformerkomponenten (modellens största del) kvantiseras, vilket reducerar minnesanvändningen från cirka 24GB till 12GB med Q8_0-kvantisering, eller ännu lägre med mer aggressiva kvantiseringsnivåer.

Fördelar med GGUF-kvantisering

De främsta fördelarna med att använda GGUF-kvantiserade FLUX-modeller inkluderar:

- Minskad minnesanvändning: Halverar VRAM-kraven, vilket gör FLUX.1-dev tillgänglig på mer hårdvara

- Bibehållen kvalitet: Q8_0-kvantisering bevarar bildkvaliteten med minimala synliga skillnader

- Snabbare laddning: Kvantiserade modeller laddas snabbare på grund av mindre filstorlekar

- Lägre energiförbrukning: Mindre minnesanvändning leder till lägre strömförbrukning under inferens

I våra tester använde den kvantiserade modellen cirka 12-15GB VRAM jämfört med 24GB+ för den fullständiga modellen, medan genereringstiden förblev liknande.

Installation och uppsättning

För att använda GGUF-kvantiserad FLUX.1-dev behöver du paketet gguf utöver standarddiffusorns beroenden. Om du redan använder FLUX för text-till-bild-generering, är du bekant med grundläggande uppsättning.

Om du använder uv som ditt Python-pakethanteringssystem, kan du installera de nödvändiga paketen med:

uv pip install -U diffusers torch transformers gguf

Eller med standard pip:

pip install -U diffusers torch transformers gguf

Implementering

Den viktigaste skillnaden när du använder GGUF-kvantiserade modeller är att du laddar transformern separat med FluxTransformer2DModel.from_single_file() med GGUFQuantizationConfig, sedan skickar den till pipeline. Om du behöver en snabb referens för Python-syntax, kolla Python Cheatsheet. Här är ett komplett fungerande exempel:

import os

import torch

from diffusers import FluxPipeline, FluxTransformer2DModel, GGUFQuantizationConfig

# Sökvägar

gguf_model_path = "/sökväg/till/flux1-dev-Q8_0.gguf"

base_model_path = "/sökväg/till/FLUX.1-dev-config" # Endast konfigureringsfiler

# Ladda GGUF-kvantiserad transformer

print(f"Laddar GGUF-kvantiserad transformer från: {gguf_model_path}")

transformer = FluxTransformer2DModel.from_single_file(

gguf_model_path,

quantization_config=GGUFQuantizationConfig(compute_dtype=torch.bfloat16),

config=base_model_path,

subfolder="transformer",

torch_dtype=torch.bfloat16,

)

# Skapa pipeline med kvantiserad transformer

print(f"Skapar pipeline med basmodell: {base_model_path}")

pipe = FluxPipeline.from_pretrained(

base_model_path,

transformer=transformer,

torch_dtype=torch.bfloat16,

)

# Aktivera CPU-avlastning (krävs för GGUF)

pipe.enable_model_cpu_offload()

# Obs: enable_sequential_cpu_offload() är INTE kompatibelt med GGUF

# Generera bild

prompt = "En futuristisk stadsskyline vid solnedgång med neonljus"

image = pipe(

prompt,

height=496,

width=680,

guidance_scale=3.5,

num_inference_steps=60,

max_sequence_length=512,

generator=torch.Generator("cpu").manual_seed(42)

).images[0]

image.save("output.jpg")

Viktiga överväganden

Modellkonfigurationsfiler

När du använder GGUF-kvantisering behöver du fortfarande modellkonfigurationsfilerna från den ursprungliga FLUX.1-dev-modellen. Dessa inkluderar:

model_index.json- Pipeline-struktur- Komponentkonfigurationer (transformer, text_encoder, text_encoder_2, vae, scheduler)

- Tokenizer-filer

- Text encoder- och VAE-vikter (dessa kvantiseras inte)

Transformer-vikterna kommer från GGUF-filen, men alla andra komponenter kräver originalmodellens filer.

CPU-avlastningskompatibilitet

Viktigt: enable_sequential_cpu_offload() är inte kompatibelt med GGUF-kvantiserade modeller och kommer att orsaka ett KeyError: None-fel. Jag använder bara enable_model_cpu_offload() istället när jag arbetar med kvantiserade transformers.

Kvantiseringsnivåer

Tillgängliga kvantiseringsnivåer för FLUX.1-dev inkluderar:

- Q8_0: Bäst kvalitet, ~14-15GB minne (rekommenderas)

- Q6_K: Bra balans, ~12GB minne

- Q4_K: Maximalt komprimerad, ~8GB minne (jag antar att det påverkar kvaliteten negativt)

För de flesta användningsområden ger Q8_0 den bästa balansen mellan minnessparande och bildkvalitet.

Prestanda jämförelse

I våra tester med identiska prompts och inställningar:

| Modell | VRAM-användning | Genereringstid | Kvalitet |

|---|---|---|---|

| Fullständig FLUX.1-dev | 24GB? | Jag har inte en GPU som är så stor | Utmärkt (jag tror) |

| Fullständig FLUX.1-dev | ~3GB med sequential_cpu_offload() | ~329s | Utmärkt |

| GGUF Q8_0 | ~14-15GB | ~98s !!! | Utmärkt |

| GGUF Q6_K | ~10-12GB | ~116s | Mycket bra |

Den kvantiserade modellen, eftersom den nu kräver mindre CPU-avlastning, har mer än 3 gånger snabbare genereringstid samtidigt som den använder betydligt mindre minne, vilket gör den praktisk för system med begränsad VRAM.

Jag testade båda modellerna med prompten

En futuristisk närbild av en transformer-inferens-ASIC-chip med intricerad kretsdesign, blå ljus som strålar från täta matrismultiplikationsenheter och lågprecisionens ALU:er, omgivna av on-chip SRAM-buffrar och kvantiseringspipelines, renderad i hyperdetaljerad fotorealistisk stil med ett kallt, kliniskt belysningsschema.

Exempelutdata från FLUX.1-dev Q8 är omslagsbilden till den här posten - se ovan.

Exempelutdata från icke-kvantiserad FLUX.1-dev finns nedan:

Jag ser inte mycket skillnad i kvalitet.

Slutsats

GGUF-kvantisering gör FLUX.1-dev tillgänglig för en bredare uppsättning hårdvara samtidigt som den bibehåller den höga bildkvalitet som modellen är känd för. Genom att reducera minneskraven med cirka 50% kan du köra state-of-the-art text-till-bild-generering på mer prisvärt hårdvara utan betydande kvalitetsförlust.

Implementeringen är enkel med diffusers-biblioteket och kräver endast små ändringar i standard-FLUX-pipeline-inställningen. För de flesta användare ger Q8_0-kvantisering den optimala balansen mellan minneseffektivitet och bildkvalitet.

Om du arbetar med FLUX.1-Kontext-dev för bildförstärkning, kan liknande kvantiseringstekniker bli tillgängliga i framtiden.

Relaterade artiklar

- Flux text till bild - guide till användning av FLUX.1-dev för text-till-bild-generering

- FLUX.1-Kontext-dev: Bildförstärkning AI-modell

- uv - Nytt Python-paket-, projekt- och miljöhanteringssystem

- Python Cheatsheet

Referenser

- HuggingFace Diffusers GGUF Dokumentation - Officiell dokumentation om användning av GGUF med diffusers

- Unsloth FLUX.1-dev-GGUF - Förkvantiserade GGUF-modeller för FLUX.1-dev

- Black Forest Labs FLUX.1-dev - Originalmodellens FLUX.1-dev-repository

- GGUF Format Specification - Tekniska detaljer om GGUF-formatet