Docker Model Runner vs Ollama: Vem ska väljas?

Jämför Docker Model Runner och Ollama för lokal LLM

Att köra stora språkmodeller (LLMs) lokalt har blivit allt mer populärt för skydd av integritet, kostnadskontroll och möjlighet att använda modeller offline. Landskapsbilden förändrades markant i april 2025 när Docker introducerade Docker Model Runner (DMR), sin officiella lösning för distribution av AI-modeller.

Nu konkurrerar tre olika tillvägagångssätt om utvecklarens uppmärksamhet: Docks egen Model Runner, tredjepartscontainerlösningar (vLLM, TGI) och den oberoende plattformen Ollama. För en bredare översikt som även inkluderar molntjänstgivare och infrastrukturtradeoffar, se LLM Hosting: Lokalt, självvärd och molninfrastruktur jämförd.

Förstå Docker Model Runners

Modellkörare baserade på Docker använder containerisering för att paketera LLM-inferensmotorer tillsammans med deras beroenden. Landskapsbilden inkluderar både Docks officiella lösning och tredjepartsramverk.

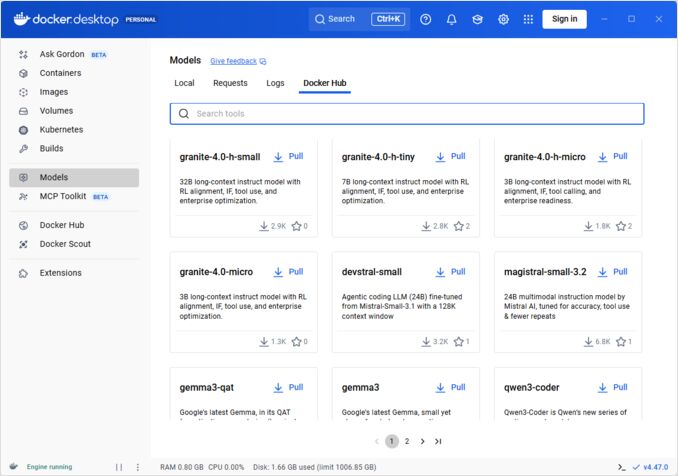

Docker Model Runner (DMR) - Officiell lösning

I april 2025 introducerade Docker Docker Model Runner (DMR), ett officiellt produktsom är designat för att förenkla körning av AI-modeller lokalt med Docks infrastruktur. Detta visar Docks engagemang att göra AI-modelldistribution lika smidig som containerdistribution.

Viktiga funktioner hos DMR:

- Inbyggd Docker-integrering: Använder kända Docker-kommandon (

docker model pull,docker model run,docker model package) - OCI-artefakt-paket: Modeller paketeras som OCI-artefakter, vilket möjliggör distribution via Docker Hub och andra registre

- OpenAI-kompatibel API: En direkt ersättning för OpenAI-slutpunkter, vilket förenklar integrationen

- GPU-accellerering: Inbyggd GPU-stöd utan komplexa nvidia-docker-konfigurationer

- GGUF-formatstöd: Fungerar med populära kvantiserade modellformat

- Docker Compose-integrering: Enkelt att konfigurera och distribuera modeller med standardverktyg för Docker

- Testcontainers-stöd: Samverkar sömlöst med testramverk

Installation:

- Docker Desktop: Aktivera via AI-fliken i inställningarna

- Docker Engine: Installera paketet

docker-model-plugin

Exempel på användning:

# Hämta en modell från Docker Hub

docker model pull ai/smollm2

# Kör inferens

docker model run ai/smollm2 "Förklara Docker Model Runner"

# Packa en anpassad modell

docker model package --gguf /path/to/model.gguf --push myorg/mymodel:latest

DMR samarbetar med Google, Hugging Face och VMware Tanzu för att utöka AI-modellökosystemet tillgängligt via Docker Hub. Om du är nybörjare på Docker eller behöver en påminnelse om Docker-kommandon, så ger vår Docker Cheat Sheet en omfattande guide till viktiga Docker-åtgärder.

Tredjeparts Docker-lösningar

Utöver DMR inkluderar ekosystemet etablerade ramverk:

- vLLM-kontainer: Höghastighetsinferensserver optimerad för batchbearbetning

- Text Generation Inference (TGI): Hugging Face:s produktionsklara lösning

- llama.cpp-kontainer: Lättviktig C++-implementering med kvantisering

- Anpassade kontainer: Inkludera PyTorch, Transformers eller proprietära ramverk

Fördelar med Docker-approchen

Flexibilitet och ramverksneutralt: Docker-kontainer kan köra vilket LLM-ramverk som helst, från PyTorch till ONNX Runtime, vilket ger utvecklare full kontroll över inferensstacken.

Resourciskiljning: Varje kontainer fungerar i isolerade miljöer med definierade resursgränser (CPU, minne, GPU), vilket förhindrar resurskonflikter vid flermodelldistributioner.

Orkestreringsstöd: Docker integrerar sömlöst med Kubernetes, Docker Swarm och molntjänster för skalning, belastningsutjämning och hög tillgänglighet.

Versionshantering: Olika modellversioner eller ramverk kan existera på samma system utan beroendekonflikter.

Nackdelar med Docker-approchen

Komplexitet: Kräver förståelse för containerisering, volymmonteringar, nätverkskonfiguration och GPU-överföring (nvidia-docker).

Överhuvud: Även om den är minimal, lägger Docker till en tunn abstraktionslager som lätt påverkar starttiden och resursanvändningen.

Konfigurationsbelastning: Varje distribution kräver noggrann konfiguration av Dockerfiles, miljövariabler och körningsparametrar.

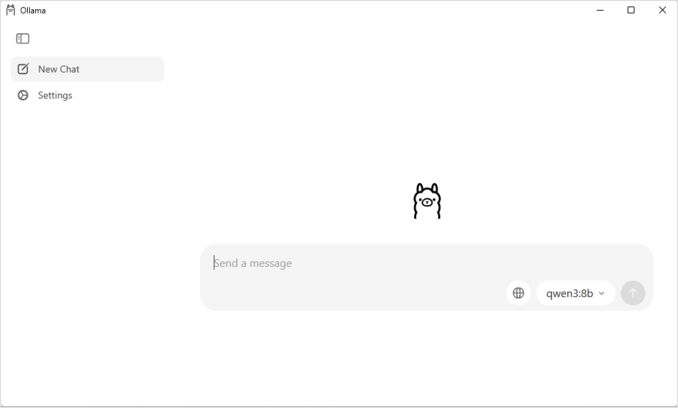

Förstå Ollama

Ollama är ett syftebyggt program för att köra LLMs lokalt, designat med enkhet som sin centrala princip. Det ger:

- Nativ binär för Linux, macOS och Windows

- Inbyggd modellbibliotek med enkommandoinstallation

- Automatisk GPU-upptäckt och optimering

- RESTful API som är kompatibel med OpenAI:s format

- Modellkontext och tillståndshantering

Fördelar med Ollama

Enkelhet: Installationen är enkel (curl | sh på Linux), och körning av modeller kräver bara ollama run llama2. För en omfattande lista över Ollama-kommandon och användningsmönster, se vår Ollama cheat sheet.

Optimerad prestanda: Byggd på llama.cpp, är Ollama mycket optimerad för inferenshastighet med stöd för kvantisering (Q4, Q5, Q8).

Modellhantering: Inbyggd modellregister med kommandon som ollama pull, ollama list och ollama rm förenklar modellens livscykel.

Utvecklarens upplevelse: Ren API, omfattande dokumentation och växande ekosystem av integreringar (LangChain, CrewAI, osv.). Ollamas mångsidighet sträcker sig till specialiserade användningsfall som omklassificering av textdokument med inbäddningsmodeller.

Resursnytta: Automatisk minnehantering och modellavlastning när den är inaktiv sparar systemresurser.

Nackdelar med Ollama

Ramverkslås: Huvudsakligen stöder modeller som är kompatibla med llama.cpp, vilket begränsar flexibiliteten för ramverk som vLLM eller anpassade inferensmotorer.

Begränsad anpassning: Avancerade konfigurationer (anpassad kvantisering, specifika CUDA-strömmar) är mindre tillgängliga än i Docker-miljöer.

Orkestreringsutmaningar: Även om Ollama kan köras i kontainer, saknar den inbyggd stöd för avancerade orkestreringsfunktioner som horisontell skalning.

Prestandajämförelse

Inferenshastighet

Docker Model Runner: Prestanda jämförbar med Ollama eftersom båda stöder GGUF-kvantiserade modeller. För Llama 2 7B (Q4), förvänta dig 20-30 token/sekund på CPU och 50-80 token/sekund på mellanåriga GPU:er. Minimal containeröverhuvud.

Ollama: Utgår från en mycket optimerad llama.cpp-bakgrund med effektiv kvantisering. För Llama 2 7B (Q4), förvänta dig 20-30 token/sekund på CPU och 50-80 token/sekund på mellanåriga GPU:er. Inga containeriseringsoverhuvud. För detaljer om hur Ollama hanterar parallella förfrågningar, se vår analys om hur Ollama hanterar parallella förfrågningar.

Docker (vLLM): Optimerad för batchbearbetning med kontinuerlig batchbearbetning. Enkla förfrågningar kan vara något långsammare, men genomströmmningen är utmärkt vid hög parallell last (100+ token/sekund per modell med batchbearbetning).

Docker (TGI): Liknande vLLM med utmärkt batchbearbetningsprestanda. Lägger till funktioner som strömning och token-och-token-generering.

Minnesanvändning

Docker Model Runner: Liknande Ollama med automatisk modellladdning. GGUF Q4-modeller använder typiskt 4-6 GB minne. Containeröverhuvud är minimalt (tio till hundratals MB).

Ollama: Automatisk minnehantering laddar modeller efter behov och avlastar dem när de är inaktiva. En 7B Q4-modell använder typiskt 4-6 GB minne. Mest effektiv för enskilda modellscenarier.

Traditionella Docker-lösningar: Minnesanvändning beror på ramverket. vLLM fördelar GPU-minne för optimal prestanda, medan PyTorch-baserade kontainer kan använda mer minne för modellvikt och KV-cache (8-14 GB för 7B-modeller).

Starttid

Docker Model Runner: Containerstart lägger till cirka 1 sekund, plus modellladdning (2-5 sekunder). Total: 3-6 sekunder för medelstora modeller.

Ollama: Nästan omedelbar start med modellladdning som tar 2-5 sekunder för medelstora modeller. Snabbaste kallstartupplevelse.

Traditionella Docker: Containerstart lägger till 1-3 sekunder, plus modellladdningstid. Förvärmning av kontainer minskar detta i produktionsdistributioner.

Docker Model Runner vs Ollama: Direkt jämförelse

Med Docks officiella innehåll i LLM-runner-området blir jämförelsen mer intressant. Här är hur DMR och Ollama står mot varandra:

| Egenskap | Docker Model Runner | Ollama |

|---|---|---|

| Installation | Docker Desktop AI-fliken eller docker-model-plugin |

Ett kommando: curl | sh |

| Kommandostil | docker model pull/run/package |

ollama pull/run/list |

| Modellformat | GGUF (OCI-artefakter) | GGUF (nativ) |

| Modelldistribution | Docker Hub, OCI-registre | Ollama-registret |

| GPU-konfiguration | Automatisk (enklare än traditionell Docker) | Automatisk |

| API | OpenAI-kompatibel | OpenAI-kompatibel |

| Docker-integrering | Inbyggd (är Docker) | Kör i Docker om det behövs |

| Compose-stöd | Inbyggd | Via Docker-bild |

| Lärandekurva | Låg (för Docker-användare) | Lägst (för alla) |

| Ekosystempartner | Google, Hugging Face, VMware | LangChain, CrewAI, Open WebUI |

| Bäst för | Docker-egna arbetsflöden | Enkel oberoende drift |

Nyckelinsikt: DMR introducerar Docker-arbetsflöden i LLM-distribution, medan Ollama förblir ramverksneutralt med enklare oberoende drift. Din befintliga infrastruktur spelar en större roll än tekniska skillnader.

Användningsfallsförslag

Välj Docker Model Runner när

- Docker-först arbetsflöde: Din team använder Docker omfattande

- Enheterverktyg: Du vill ha ett verktyg (Docker) för behållare och modeller

- OCI-artefaktdistribution: Du behöver företagsregisterversionering

- Testcontainers-integrering: Du testar AI-funktioner i CI/CD

- Docker Hub-preference: Du vill distribuera modeller via bekanta kanaler

Välj Ollama när

- Snabb prototyper: Snabb experimentering med olika modeller

- Ramverksneutralt: Inte kopplad till Docker-ekosystemet

- Absolut enkelhet: Minimalkonfiguration och underhållsöverhuvud

- Enkelserverdistributioner: Körning på datorer, arbetsstationer eller enskilda VM:er

- Stor modellbibliotek: Tillgång till omfattande förkonfigurerade modellregistret

Välj tredjeparts Docker-lösningar när

- Produktionsdistributioner: Behov av avancerad orkestrering och övervakning

- Multi-modellservering: Körning av olika ramverk (vLLM, TGI) samtidigt

- Kubernetes-orkestrering: Skalning över kluster med belastningsutjämning

- Anpassade ramverk: Använda Ray Serve eller proprietära inferensmotorer

- Strikt resurshantering: Kräver detaljerad CPU/GPU-limitering per modell

Hybridmetoder: Bästa av båda världarna

Du är inte begränsad till en enda metod. Betrakta dessa hybridstrategier:

Alternativ 1: Docker Model Runner + Traditionella behållare

Använd DMR för standardmodeller och tredjepartsbehållare för specialiserade ramverk:

# Hämta en standardmodell med DMR

docker model pull ai/llama2

# Kör vLLM för höghastighetsfall

docker run --gpus all vllm/vllm-openai

Alternativ 2: Ollama i Docker

Kör Ollama inuti Docker-behållare för orkestreringsförmåga:

docker run -d \

--name ollama \

--gpus all \

-v ollama:/root/.ollama \

-p 11434:11434 \

ollama/ollama

Detta ger:

- Ollamas intuitiva modellhantering

- Docks orkestrerings- och isoleringsförmåga

- Kubernetesdistribution med standardmanifest

Alternativ 3: Blanda efter användningsfall

- Utveckling: Ollama för snabb iteration

- Staging: Docker Model Runner för integrationsprov

- Produktion: vLLM/TGI i Kubernetes för skalning

API-kompatibilitet

Alla moderna lösningar konvergerar mot OpenAI-kompatibla API:er, vilket förenklar integrationen:

Docker Model Runner API: OpenAI-kompatibla slutpunkter serveras automatiskt när modeller köras. Inga ytterligare konfigurationer krävs.

# Modeller köras med API som automatiskt exponeras

docker model run ai/llama2

# Använd OpenAI-kompatibel slutpunkt

curl http://localhost:8080/v1/chat/completions -d '{

"model": "llama2",

"messages": [{"role": "user", "content": "Varför är himlen blå?"}]

}'

Ollama API: OpenAI-kompatibla slutpunkter gör att det blir en direkt ersättning för program som använder OpenAI:s SDK. Strömning stöds fullt ut.

curl http://localhost:11434/api/generate -d '{

"model": "llama2",

"prompt": "Varför är himlen blå?"

}'

Tredjeparts Docker-API:er: vLLM och TGI erbjuder OpenAI-kompatibla slutpunkter, medan anpassade behållare kan implementera egna API:er.

Konvergensen mot OpenAI-kompatibilitet innebär att du kan byta mellan lösningar med minimala kodändringar.

Resurshantering

GPU-accellerering

Docker Model Runner: Inbyggd GPU-stöd utan komplexa nvidia-docker-konfigurationer. Identifierar och använder tillgängliga GPU:er automatiskt, vilket betydligt förenklar Docker GPU-upplevelsen jämfört med traditionella behållare.

# GPU-accellerering fungerar automatiskt

docker model run ai/llama2

Ollama: Automatisk GPU-upptäckt på CUDA-kompatibla NVIDIA-GPU:er. Inga konfigurationer krävs utöver drivrutininstallation.

Traditionella Docker-behållare: Kräver nvidia-docker-körningsmiljö och explicit GPU-allokerings:

docker run --gpus all my-llm-container

CPU-fallback

Båda faller tillbaka till CPU-inferens när GPU:er inte är tillgängliga, även om prestandan minskar betydligt (5-10 gånger långsammare för stora modeller). För insikter i CPU-endast-prestanda på moderna processorer, läs vår test om hur Ollama använder Intel CPU-prestanda och effektiva kärnor.

Multi-GPU-stöd

Ollama: Stöder tensorparallellitet över flera GPU:er för stora modeller.

Docker: Beroende av ramverket. vLLM och TGI stöder multi-GPU-inferens med korrekt konfiguration.

Gemenskap och ekosystem

Docker Model Runner: Lanserades april 2025 med starkt företagsstöd. Samarbeten med Google, Hugging Face och VMware Tanzu AI Solutions säkerställer bred tillgänglighet av modeller. Integration med Docks stora utvecklarecommunity (miljoner användare) ger omedelbar tillgång till ekosystemet. Ännu byggande av gemenskapsrelaterade resurser som ett nytt produkt.

Ollama: Snabbt växande gemenskap med över 50 000 GitHub-stjärnor. Stark integrationsekosystem (LangChain, LiteLLM, Open WebUI, CrewAI) och aktiv Discord-gemenskap. Extensiva tredjepartsverktyg och tutorier tillgängliga. Mer mognad i dokumentation och gemenskapsresurser. För en omfattande översikt över tillgängliga gränssnitt, se vår guide till öppen källkod chat UI för lokala Ollama-instanser. Som med alla snabbt växande öppen källkodsprojekt är det viktigt att övervaka projektets riktning - läs vår analys av tida tecken på Ollama enshittification för att förstå potentiella oro.

Tredjeparts Docker-lösningar: vLLM och TGI har mognad ekosystem med företagsstöd. Extensiva produktionsfallstudier, optimeringsguider och distributionsmönster från Hugging Face och gemenskapsbidragare.

Kostnadskonsekvenser

Docker Model Runner: Gratis med Docker Desktop (personlig/utbildning) eller Docker Engine. Docker Desktop kräver prenumeration för större organisationer (250+ anställda eller 10M USD+ intäkter). Modeller distribueras via Docker Hub enligt Docks registratorpriser (gratis publika repo, betalda privata repo).

Ollama: Komplett gratis och öppen källkod med inga licenskostnader oavsett organisationens storlek. Resurskostnader beror endast på hårdvara.

Tredjeparts Docker-lösningar: Gratis för öppen källkodsramverk (vLLM, TGI). Potentiella kostnader för behållarorkestreringsplattformar (ECS, GKE) och privata registratorlager.

Säkerhetsaspekter

Docker Model Runner: Utgår från Docks säkerhetsmodell med behållarisolering. Modeller paketeras som OCI-artefakter som kan skannas och signeras. Distribution via Docker Hub möjliggör åtkomstkontroll och skadlig skanning för företagsanvändare.

Ollama: Kör som en lokal tjänst med API exponerad på localhost som standard. Nätverksexponering kräver explicit konfiguration. Modellregistret är tillitvärt (Ollama-validerat), vilket minskar kedjans risker.

Traditionella Docker-lösningar: Nätverksisolering är inbyggd. Behållarsäkerhetskontroll (Snyk, Trivy) och bildsignering är standardpraxis i produktionsmiljöer.

Alla lösningar kräver uppmärksamhet till:

- Modellens ursprung: Otillitliga modeller kan innehålla skadlig kod eller bakdörrar

- API-autentisering: Implementera autentisering/åtkomstkontroll i produktionsdistributioner

- Begränsning av frekvens: Förhindra missbruk och resursutmattning

- Nätverksutlämning: Se till att API:er inte oavsiktligt exponeras till internet

- Dataintegritet: Modeller behandlar känslig data; säkerställ komplianst med dataskyddsregler

Migreringsvägar

Från Ollama till Docker Model Runner

Docker Model Runner:s GGUF-stöd gör migrationen enkel:

- Aktivera Docker Model Runner i Docker Desktop eller installera

docker-model-plugin - Konvertera modellreferenser:

ollama run llama2→docker model pull ai/llama2ochdocker model run ai/llama2 - Uppdatera API-slutpunkter från

localhost:11434till DMR-slutpunkt (vanligtvislocalhost:8080) - Båda använder OpenAI-kompatibla API:er, så krävs minimala förändringar i applikationskoden

Från Docker Model Runner till Ollama

Flytta till Ollama för enklare oberoende drift:

- Installera Ollama:

curl -fsSL https://ollama.ai/install.sh | sh - Hämta motsvarande modeller:

ollama pull llama2 - Uppdatera API-slutpunkter till Ollamas

localhost:11434 - Testa med

ollama run llama2för att bekräfta funktionen

Från traditionella Docker-behållare till DMR

Förenkla din Docker-LLM-konfiguration:

- Aktivera Docker Model Runner

- Ersätt anpassade Dockerfiles med

docker model pull-kommandon - Ta bort nvidia-docker-konfiguration (DMR hanterar GPU automatiskt)

- Använd

docker model runistället för komplexadocker run-kommandon

Från någon lösning till Ollama i Docker

Bästa av båda världarna:

docker pull ollama/ollama- Kör:

docker run -d --gpus all -v ollama:/root/.ollama -p 11434:11434 ollama/ollama - Använd Ollama-kommandon som vanligt:

docker exec -it ollama ollama pull llama2 - Få Docker-orkestrering med Ollamas enkelhet

Övervakning och insikter

Ollama: Grunden i mått via API (/api/tags, /api/ps). Tredjepartsverktyg som Open WebUI ger dashboards.

Docker: Full integrering med Prometheus, Grafana, ELK stack och molnövervakningstjänster. Behållarmått (CPU, minne, GPU) är tillgängliga.

Slutsats

Landskapsbilden för lokalt LLM-distribution har utvecklats markant med Docks introduktion av Docker Model Runner (DMR) 2025. Valet nu beror på dina specifika krav:

- För utvecklare som söker Docker-integrering: DMR ger inbyggd Docker-arbetsflödesintegrering med

docker model-kommandon - För maximal enkelhet: Ollama är fortfarande den enklaste lösningen med sin enkommandomodellhantering

- För produktion och företag: Både DMR och tredjepartslösningar (vLLM, TGI) i Docker erbjuder orkestrering, övervakning och skalbarhet

- För bästa av båda: Kör Ollama i Docker-behållare för att kombinera enkelhet med produktionsinfrastruktur

Introduktionen av DMR minskar skillnaden mellan Docker och Ollama i termer av användbarhet. Ollama vinner fortfarande på enkelhet för snabb prototyper, medan DMR utmärker sig för grupper som redan investerar i Docker-arbetsflöden. Båda metoder utvecklas aktivt, är produktionsklara och ekosystemet är mognat tillräckligt för att byta mellan dem är relativt smärtfritt.

Sammanfattning: Om du redan använder Docker omfattande, är DMR den naturliga valen. Om du vill den absolut enklare upplevelsen oavsett infrastruktur, välj Ollama. För att jämföra dessa lokala alternativ med molntjänster och andra självvärd konfigurationer, se vår LLM Hosting: Lokalt, självvärd och molninfrastruktur jämförd guide.

Nyttafulla länkar

Docker Model Runner

- Docker Model Runner Officiell Sida

- Docker Model Runner Dokumentation

- Docker Model Runner Startguide

- Docker Model Runner Blogg om introduktionen