Chattgränssnitt för lokala Ollama-instanser

Snabb översikt över de mest framträdande UI:erna för Ollama år 2025

Lokalt värd Ollama möjliggör att köra stora språkmodeller på din egen dator, men att använda den via kommandoraden är inte användarvänligt. Här är flera öppen källkodprojekt som tillhandahåller ChatGPT-stilgränssnitt som ansluter till en lokal Ollama.

Dessa gränssnitt stöder konversationell chatt, ofta med funktioner som dokumentuppladdning för retrieval-augmented generation (RAG), och kör som webb- eller skrivbordsprogram. Nedan följer en jämförelse av viktiga alternativ, följt av detaljerade avsnitt om varje. För en bredare bild av hur lokal Ollama passar in med vLLM, Docker Model Runner, LocalAI och molntjänstgivare – inklusive kostnad och infrastrukturväxel – se LLM Hosting: Lokal, självvärd och molninfrastruktur jämförd.

Jämförelse av Ollama-kompatibla gränssnitt

| Gränssnittsverktyg | Plattform | Dokumentstöd | Ollama-integrering | Styrkor | Begränsningar |

|---|---|---|---|---|---|

| Page Assist | Webbläsarextension (Chrome, Firefox) | Ja – lägg till filer för analys | Ansluter till lokal Ollama via extensionkonfiguration | Inbyggd chatt i webbläsaren; enkel modellhantering och webbsidokontextintegration | Endast webbläsare; kräver installation/konfigurering av en extension |

| Open WebUI | Webbapp (självvärd; Docker/PWA) | Ja – inbyggd RAG (ladda upp dokument eller lägg till i biblioteket) | Direkt stöd för Ollama API eller paketerad server (konfigurera bas-URL) | Funktionstäckning (flera LLM, offline, bildgenerering); mobilvänlig (PWA) | Inställning är tungare (Docker/K8s); omfattande omfång kan vara för mycket för enkla användningsfall |

| LobeChat | Webbapp (självvärd; PWA-stöd) | Ja – “Kunskapsbank” med filuppladdning (PDF, bilder, osv.) | Stöder Ollama som en av flera AI-bakändar (kräver att Ollama:s API-åtkomst aktiveras) | Smidig ChatGPT-liknande gränssnitt; röstchatt, plugin, och flermodellstöd | Komplex funktionssätt; kräver miljökonfigurering (t.ex. cross-origin för Ollama) |

| LibreChat | Webbapp (självvärd; fleranvändare) | Ja – “Chatt med filer” med RAG (via embeddings) | Kompatibel med Ollama och många andra leverantörer (kan byta per chatt) | Bekant ChatGPT-stilgränssnitt; rika funktioner (agenter, kodtolkare, osv.) | Installation/konfiguration kan vara inblandad; stort projekt kan vara mer än nödvändigt för grundläggande användning |

| AnythingLLM | Skrivbordsapp (Windows, Mac, Linux) eller webb (Docker) | Ja – inbyggd RAG: dra och släpp dokument (PDF, DOCX, osv.) med referenser | Ollama stöds som en LLM-leverantör (konfigureras i konfig eller Docker-miljö) | All-in-one-gränssnitt (privat ChatGPT med dina dokument); ingen-kod agentbyggare, fleranvändarstöd | Hög resurshantering (embeddings-databas, osv.); skrivbordsappen saknar vissa fleranvändarfunktioner |

| Chat-with-Notes | Webbapp (lättviktig Flask-server) | Ja – ladda upp text/PDF-filer och chatta med deras innehåll | Använder Ollama för alla AI-svar (kräver att Ollama kör lokalt) | Mycket enkel inställning och gränssnitt fokuserat på dokumentfrågor; data förblir lokal | Grundläggande gränssnitt och funktioner; enanvändare, ett dokument i taget (inga avancerade funktioner) |

Varje av dessa verktyg är aktivt underhålls och öppen källkod. Nästa, vi går in i detaljer om varje alternativ, inklusive hur de fungerar med Ollama, notabla funktioner och växelverkan.

Page Assist (Webbläsarextension)

Page Assist är en öppen källkod webbläsarextension som bringar lokal LLM-chatt till din webbläsare. Den stöder Chromium-baserade webbläsare och Firefox, med en ChatGPT-liknande sidoflank eller flik där du kan samtala med en modell. Page Assist kan ansluta till lokalt körande Ollama som AI-leverantör, eller andra lokala bakändar, genom dess inställningar. Noterbart, det låter dig lägga till filer (t.ex. PDF eller text) för AI att analysera inom chatt, vilket möjliggör grundläggande RAG-arbetsflöden. Du kan till och med låta det hjälpa till med innehållet i den aktuella webbsidan eller utföra webbsökningar för information.

Inställning är enkel: installera extensionen från Chrome Web Store eller Firefox Add-ons, se till att Ollama kör, och välj Ollama som lokal AI-leverantör i Page Assist inställningar. Gränssnittet innehåller funktioner som chatthistorik, modellval och en valfri delbar URL för dina chattresultat. En webbgränssnitt är också tillgänglig via en tangentbordssnabbtangent om du föredrar en fullflik chattupplevelse.

Styrkor: Page Assist är lättviktig och bekväm – eftersom den finns i webbläsaren, finns det ingen separat server att köra. Den är bra för surfkontext (du kan öppna den på någon webbsida) och stöder internet sökintegrering och filuppladdning för att rikta upp konversationen. Den tillhandahåller även användbara funktioner som tangentbordssnabbtangent för ny chatt och att växla sidoflank.

Begränsningar: Eftersom det är en extension, är det begränsat till en webbläsarmiljö. Gränssnittet är enklare och något mindre funktionstäckande än fullständiga oberoende chattappar. Till exempel, fleranvändarhantering eller avancerade agentplugin är inte i omfång. Dessutom kan initial inställning kräva bygga/ladda extensionen om en förpackad version inte finns tillgänglig för din webbläsare (projektet tillhandahåller bygginstruktioner med Bun eller npm). Sammanfattningsvis, Page Assist är bäst för enskild användning när du vill ha snabb tillgång till Ollama-drivna chatt medan du surfar, med måttlig RAG-förmåga.

Open WebUI (självvärd webbapplikation)

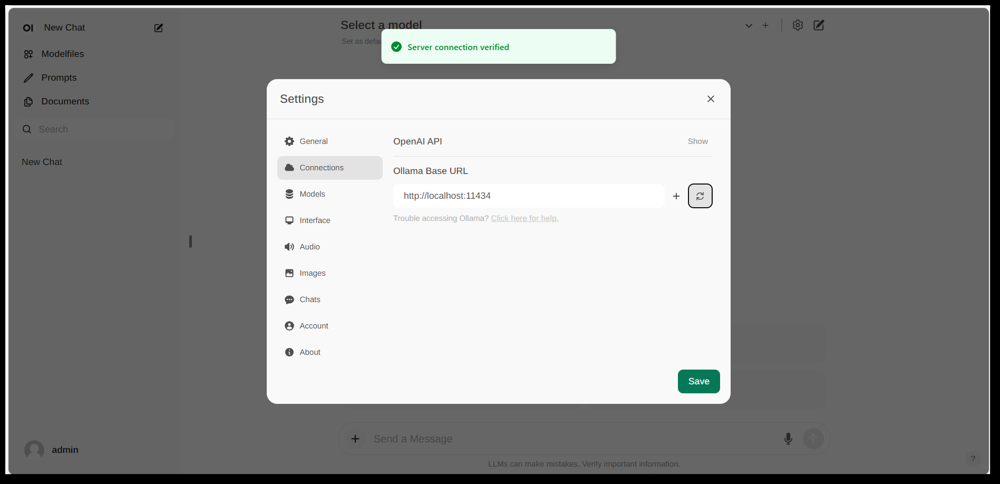

Open WebUI:s inställningsgränssnitt, visar en Ollama anslutning som konfigurerats (bas-URL satt till lokal Ollama API). Gränssnittet innehåller en Dokumentsektion, vilket möjliggör RAG-arbetsflöden.

Open WebUI är en kraftfull, allmänt syfte chattfrontände som ursprungligen skapats för att fungera med Ollama, och nu utökats för att stödja olika LLM-bakändar. Den kör som en självvärd webbapplikation och är vanligtvis distribuerad via Docker eller Kubernetes för enkel inställning. När den körs, kommer du att komma åt den genom din webbläsare (med stöd för att installera den som en Progressiv webbapplikation på mobila enheter).

Open WebUI erbjuder en full chattgränssnitt med fleranvändarstöd, modellhantering och omfattande funktioner. Kritiskt, den har inbyggda RAG-förmågor – du kan ladda upp eller importera dokument till en dokumentbibliotek och sedan ställa frågor med hämtning förstärkning. Gränssnittet möjliggör laddning av dokument direkt i en chattsession eller att behålla en bestående bibliotek av kunskap. Den stöder även att utföra webbsökningar och injicera resultat i konversationen för aktuell information.

Ollama-integrering: Open WebUI ansluter till Ollama genom dess API. Du kan antingen köra Open WebUI Docker-container tillsammans med en Ollama-server och sätta en miljövariabel för att peka till Ollama:s URL, eller använda en särskild Docker-bild som bundet Ollama med webbgränssnittet. I praktiken, efter att ha startat behållarna, kommer du besöka Open WebUI i din webbläsare och se “Server connection verified” om den är korrekt konfigurerad (som visas i bilden ovan). Detta betyder att gränssnittet är redo att använda dina lokala Ollama-modeller för chatt. Open WebUI stöder även OpenAI API-kompatibla slutpunkter, så den kan interagera med LM Studio, OpenRouter, osv., i addition till Ollama.

Styrkor: Detta är en av de ** mest funktionstäckande och flexibla gränssnitten**. Den stöder flera samtidiga modeller och konversationsström, anpassade “roller” eller systemprompter, bildgenerering och mer. RAG-implementeringen är robust – du får ett fullständigt gränssnitt för att hantera dokument och även konfigurera vilken vektorlager eller söktjänst som ska användas för hämtning. Open WebUI är också aktivt utvecklat (med en omfattande gemenskap, som indikeras av dess höga stjärntal på GitHub) och designad för utökbarhet och skalning. Det är ett bra val om du vill ha en omfattande, all-in-one chattgränssnitt för lokala modeller, särskilt i en scenario med flera användare eller komplexa användningsfall.

Begränsningar: Med stor kraft kommer större komplexitet. Open WebUI kan vara överdrivet för enkla personliga användningar – att distribuera Docker-behållare och hantera konfigurationen kan vara skräddarsytt om du inte är bekant. Den använder fler resurser än en lättviktig app, eftersom den kör en webbserver, valfri databas för chatthistorik, osv. Dessutom, funktioner som rollbaserad åtkomstkontroll och användarhantering, även om användbara, indikerar att den är inriktad på en serverinställning – en enskild användare på en hemma PC kanske inte behöver allt. I kort, inställningen är tyngre och gränssnittet kan känna sig komplex om du bara behöver en grundläggande ChatGPT-kopia. Men för de som behöver dess bredd av funktioner (eller vill enkelt byta mellan Ollama och andra modellleverantörer i ett gränssnitt), är Open WebUI ett toppval.

LobeChat (ChatGPT-liknande ramverk med plugin)

LobeChat:s gränssnittsbanner visar “Ollama Supported” och flera lokala modeller. LobeChat låter dig distribuera en slick ChatGPT-liknande webbapp med Ollama eller andra leverantörer, med funktioner som röstinput och plugin.

LobeChat är ett öppen källkod chattramverk som betonar en polerad användarupplevelse och flexibilitet. Det är i grunden en ChatGPT-liknande webbapplikation som du kan självvärd, med stöd för flera AI-leverantörer – från OpenAI och Anthropic till öppna modeller via Ollama. LobeChat är designad med integritet i åtanke (du kör det själv) och har en modern gränssnitt som inkluderar bekvämligheter som konversationsminne, röstkonversationsläge och även text-till-bildgenerering via plugin.

En av LobeChat:s nyckelfunktioner är dess Kunskapsbank möjlighet. Du kan ladda upp dokument (i format som PDF, bilder, ljud, video) och skapa en kunskapsbank som kan användas under chatt. Detta innebär att du kan ställa frågor om innehållet i dina filer – en RAG-arbetsflöde som LobeChat stöder som standard. Gränssnittet tillhandahåller hantering av dessa filer/kunskapsbankar och tillåter att växla deras användning i konversationen, vilket ger en rikare Q&A-upplevelse än den grundläggande LLM.

För att använda LobeChat med Ollama, kommer du att distribuera LobeChat-appen (till exempel via en tillhandahållen Docker-bild eller skript) och konfigurera Ollama som bakänden. LobeChat identifierar Ollama som en första klass leverantör – det tillhandahåller även en enklicks distributionsskript via Pinokio AI-webbläsare om du använder den. I praktiken kan du behöva justera Ollamas inställningar (t.ex. aktivera CORS enligt LobeChat:s dokumentation) så att LobeChats webbgränssnitt kan komma åt Ollamas HTTP-API. När konfigurerad, kan du välja en Ollama-verklig modell i LobeChat-gränssnittet och samtala med den, inklusive att fråga dina uppladdade dokument.

Styrkor: LobeChats gränssnitt prasas ofta för att vara ren och användarvänligt, nära ChatGPTs utseende och känsla (vilket kan underlätta adoption). Den tillhandahåller värde med extra funktioner som röstinput/output för talbaserade samtal och en plugin-system för att utöka funktioner (lika som ChatGPTs plugin, vilket möjliggör saker som webbläsning eller bildgenerering). Flermodellstöd innebär att du enkelt kan växla mellan, säg, en lokal Ollama-modell och en OpenAI API-modell i samma gränssnitt. Den stöder även installation som en mobilvänlig PWA, så du kan komma åt din lokala chatt på vägen.

Begränsningar: Att inställa LobeChat kan vara mer komplex än vissa alternativ. Det är en fullstack-applikation (ofta körs med Docker Compose), så det finns viss överhuvud. Särskilt, att konfigurera Ollama-integrering kräver att aktivera cross-origin förfrågningar på Ollamas sida och säkerställa att portar matchar – en enkel uppgift, men teknisk. Dessutom, även om LobeChat är mycket kraftfull, kan inte alla funktioner behövas för varje användare; till exempel, om du inte behöver flerleverantörsstöd eller plugin, kan gränssnittet känna sig överbelastat jämfört med en minimal verktyg. Slutligen, vissa avancerade funktioner som enklicks distribution antar specifika miljöer (Pinokio webbläsare eller Vercel), vilka du kan eller inte kan använda. Sammanfattningsvis, LobeChat är ideal om du vill ha en fullt utrustad ChatGPT-alternativ som körs lokalt med Ollama, och du inte bryr dig om lite initial konfiguration för att nå dit.

LibreChat (ChatGPT-kopia med flerleverantörsstöd)

LibreChat (tidigare känd som ChatGPT-Clone eller UI) är ett öppen källkod projekt som syftar till att replikera och utöka ChatGPTs gränssnitt och funktioner. Den kan distribueras lokalt (eller på din egen server) och stöder en mängd AI-bakändar – inklusive öppen källkod modeller via Ollama. I grunden, LibreChat tillhandahåller den bekanta chattupplevelsen (dialoggränssnitt med historia, användar- och assistentmeddelanden) medan du kan plugga in olika modellleverantörer på bakänden.

LibreChat stöder dokumentinteraktion och RAG genom en tillägg som kallas RAG API och inbäddningstjänster. I gränssnittet kan du använda funktioner som “Chatt med filer”, vilket tillåter dig att ladda upp filer och sedan ställa frågor om dem. Under kulisserna använder detta inbäddningar och en vektorlager för att hämta relevant kontext från dina filer. Detta innebär att du kan uppnå en liknande effekt som ChatGPT + anpassad kunskap, allt lokalt. Projektet tillhandahåller även ett separat repo för RAG-tjänsten om du vill självvärd den.

Att använda LibreChat med Ollama innebär vanligtvis att köra LibreChat-servern (till exempel via Node/Docker) och säkerställa att den kan nå Ollama-tjänsten. LibreChat har en “Anpassad slutpunkt” inställning där du kan mata in en OpenAI-kompatibel API-URL. Eftersom Ollama kan exponera en lokal API som är OpenAI-kompatibel, kan LibreChat pekas till http://localhost:11434 (eller var Ollama lyssnar). I själva verket listar LibreChat explicit Ollama bland sina stödda AI-leverantörer – tillsammans med andra som OpenAI, Cohere, osv. När konfigurerad, kan du välja modellen (Ollamas modell) i en dropdown och chatta fritt. LibreChat tillåter även att växla modeller eller leverantörer även under konversationen och stöder flera chattinställningar/kontexter.

Styrkor: Den primära fördelen med LibreChat är den rika uppsättningen funktioner som byggs runt chattupplevelsen. Den inkluderar saker som konversationsgrenar, sökning i meddelanden, inbyggd kodtolkare stöd (säker sandboxed kodkörning) och verktyg/agentintegrationer. Det är i grunden ChatGPT++, med möjligheten att integrera lokala modeller. För någon som gillar ChatGPTs gränssnitt, kommer LibreChat känna sig mycket bekant och kräver liten inlärningskurva. Projektet är aktivt och gemenskapsdrivet (som bevisas av dess ofta uppdateringar och diskussioner), och det är mycket flexibelt: du kan ansluta till många typer av LLM-slutpunkter eller även köra det fleranvändare med autentisering för en teaminställning.

Begränsningar: Med dess många funktioner kan LibreChat vara tyngre att köra. Installationen kan innebära att ställa in en databas för att lagra chattar och konfigurera miljövariabler för olika API:er. Om du aktiverar alla komponenter (RAG, agenter, bildgenerering, osv.), är det en ganska komplett stack. För en enskild användare som bara behöver en grundläggande chatt med en lokal modell, kan LibreChat vara mer än nödvändigt. Dessutom, gränssnittet, även om bekant, är inte särskilt specialiserat för dokument QA – det gör jobbet men saknar en dedikerad “dokumentbibliotek” gränssnitt (uppladdningar görs vanligtvis inom en chatt eller via API). I kort, LibreChat skiner när du vill ha en full ChatGPT-liknande miljö med ett brett spektrum av funktioner som körs lokalt, men enklare lösningar kan räcka till för nylig fokuserade användningsfall.

AnythingLLM (All-in-one desktop eller serverapp)

AnythingLLM är en all-in-one AI-applikation som betonar RAG och enkelhet. Den låter dig “chatta med dina dokument” med hjälp av antingen öppen källkod LLM eller till och med OpenAIs modeller, allt genom ett enda enhetligt gränssnitt. Noterbart, AnythingLLM är tillgänglig både som en korsplattform desktopapp (för Windows, Mac, Linux) och som en självvärd webbserver (via Docker). Den här flexibiliteten innebär att du kan köra den som en vanlig applikation på din dator, eller distribuera den för flera användare på en server.

Dokumenthantering är i centrum av AnythingLLM. Du kan dra och släppa dokument (PDF, TXT, DOCX, osv.) i appen, och den kommer automatiskt att indexera dem till en vektorlager (den kommer med LanceDB som standard). I chattgränssnittet, när du ställer frågor, kommer den att hämta relevant delar från dina dokument och ge citerade svar, så du vet vilken fil och sektion informationen kommer ifrån. I grunden, bygger den en privat kunskapsbank för dig och låter LLM använda den som kontext. Du kan organisera dokument i “arbetsområden” (t.ex. ett arbetsområde per projekt eller ämne), isolerar kontexter som behövs.

Att använda Ollama med AnythingLLM är enkelt. I konfigurationen väljer du Ollama som LLM-leverantör. Om du kör via Docker, sätter du miljövariabler som LLM_PROVIDER=ollama och tillhandahåller OLLAMA_BASE_PATH (URL till din Ollama-instans). AnythingLLM-servern kommer sedan att skicka alla modellfrågor till Ollamas API. Ollama är officiellt stödd, och dokumenten noterar att du kan utnyttja det för att köra olika öppna modeller (t.ex. Llama 2, Mistral, osv.) lokalt. I själva verket, betonar utvecklarna att kombinera AnythingLLM med Ollama öppnar upp kraftfulla offline RAG-förmågor: Ollama hanterar modellinference, och AnythingLLM hanterar inbäddningar och UI/agentlogik.

Styrkor: AnythingLLM tillhandahåller en omfattande lösning för privat Q&A och chatt. Viktiga styrkor inkluderar: enkel inställning för RAG (den tunga jobbet med inbäddning och lagring av vektorer är automatiserad), flerdokumentstöd med tydlig referering av källor, och ytterligare funktioner som AI-agenter (den har en ingen-kod agentbyggare där du kan skapa anpassade arbetsflöden och verktygsanvändning). Den är även fleranvändare från början (särskilt i serverläge), med användarkonton och behörighet om det behövs. Gränssnittet är designat för att vara enkelt (chattbox + sidoflank av dokument/arbetsområden) men kraftfullt under stolen. För personlig användning är desktopappen ett stort plus – du får en nativ känsla av appen utan att behöva öppna en webbläsare eller köra kommandon, och den lagrar data lokalt som standard.

Begränsningar: Eftersom den integrerar många komponenter (LLM API, inbäddningsmodeller, vektorlager, osv.), kan AnythingLLM vara resursintensiv. När du importerar dokument, kan det ta tid och minne att generera inbäddningar (den stöder även att använda Ollama själv eller lokala modeller för inbäddningar med modeller som nomic-embed). Desktopappen förenklar användningen, men om du har många dokument eller mycket stora filer, förvänta dig vissa tunga bearbetningar i bakgrunden. En annan begränsning är att avancerade användare kan hitta den mindre konfigurerbar än att sammansätta sin egen stack – till exempel, den använder just nu LanceDB eller Chroma; om du ville en annan vektorlager, skulle du behöva dyka in i konfig eller kod. Dessutom, även om flerleverantörsstöd är tillgängligt, är gränssnittet verkligen inriktat på en modell i taget (du skulle växla den globala leverantörsinställningen om du vill använda en annan modell). Sammanfattningsvis, AnythingLLM är en utmärkt laddningsklar lösning för lokal dokumentchatt, särskilt med Ollama, men det är en större applikation att köra jämfört med minimala gränssnitt.

Chat-with-Notes (Minimal dokumentchattgränssnitt)

Chat-with-Notes är en minimalistisk applikation som specifikt byggts för att chatta med lokala textfiler med hjälp av Ollama-hanterade modeller. Det är i grunden en lättviktig Flask-webbserver som du kör på din dator, vilket tillhandahåller en enkel webbsida där du kan ladda upp ett dokument och börja en chatt om det. Målet med detta projekt är enkelhet: det har inte många extra funktioner, men det gör det grundläggande jobbet av att svara på frågor om dokument med en lokal LLM.

Att använda Chat-with-Notes innebär först att säkerställa att din Ollama-instans kör en modell (till exempel kan du starta Ollama med ollama run llama2 eller en annan modell). Sedan startar du Flask-applikationen (python app.py) och öppnar den lokala webbsidan. Gränssnittet kommer att be dig att ladda upp en fil (stödda format inkluderar ren text, Markdown, kodfiler, HTML, JSON och PDF). När uppladdad visas textinnehållet i filen, och du kan ställa frågor eller chatta med AI om det innehållet. Konversationen sker i en typisk chathubbformat. Om du laddar upp en ny fil under en konversation, kommer appen att fråga om du vill starta en ny chatt eller behålla den aktuella chattkontexten och bara lägga till den nya filens information. På detta sätt kan du tala om flera filer i följd om det behövs. Det finns även knappar för att rensa chatt eller exportera konversationen till en textfil.

Under kulisserna frågar Chat-with-Notes Ollama API för att generera svar. Ollama hanterar modellinference, och Chat-with-Notes tillhandahåller bara prompten (vilket inkluderar relevanta delar av den uppladdade texten). Den använder inte en vektorlager; istället skickar den helt enkelt hela filinnehållet (eller delar av det) tillsammans med din fråga till modellen. Den här metoden fungerar bäst för dokument av anpassningsbar storlek som passar in i modellens kontextfönster.

Styrkor: Applikationen är extremt enkel att distribuera och använda. Det finns ingen komplex konfiguration – om du har Python och Ollama inställda, kan du få det att köra inom ett par minuter. Gränssnittet är ren och minimal, fokuserat på textinnehållet och Q&A. Eftersom det är så fokuserat, säkerställer det att alla data förblir lokal och endast i minnet (ingen externa anrop utom till Ollama på localhost). Det är ett bra val om du specifikt vill chatta med filer och inte behöver allmän konversation utan ett dokument.

Begränsningar: Den minimalismen i Chat-with-Notes innebär att den saknar många funktioner som finns i andra gränssnitt. Till exempel, den stöder inte att använda flera modeller eller leverantörer (den är Ollama-only av design), och den håller inte en långvarig bibliotek av dokument – du laddar upp filer som behövs per session, och det finns ingen bestående vektorindex. Skalning till mycket stora dokument kan vara svårt utan manuella justeringar, eftersom det kan försöka inkludera mycket text i prompten. Dessutom, gränssnittet, även om funktionsdugligt, är inte lika polerat (ingen mörkmod, ingen rik textformatering av svar, osv.). I essens, detta verktyg är ideal om du vill ha snabba, enkel gång analyser av filer med en Ollama-modell. Om dina behov växer (t.ex. många dokument, eller önskan efter en färre gränssnitt), kan du växa över Chat-with-Notes. Men som ett startpunkt eller en personlig “fråga min PDF”-lösning på topp av Ollama, är det mycket effektiv.

Slutsats

Var och en av dessa öppen källkod gränssnitt kan förbättra din upplevelse med lokala Ollama-modeller genom att tillhandahålla en användarvänlig chattgränssnitt och extra funktioner som dokumentfråga-svar. Det bästa valet beror på dina krav och tekniska komfort:

- För snabb inställning och webbläsarebaserad användning: Page Assist är ett bra val, integrerat direkt i din webbläsare med minimala problem.

- För en fullt utrustad webbapplikationsmiljö: Open WebUI eller LibreChat erbjuder omfattande funktioner och flermodellflexibilitet, lämplig för avancerade användare eller fleranvändarinstallationer.

- För en polerad ChatGPT-alternativ med pluginpotential: LobeChat erbjuder en bra balans mellan användbarhet och funktioner i en självvärd paket.

- För dokumentfokuserade interaktioner: AnythingLLM levererar en all-in-one-lösning (särskilt om du gillar att ha en desktopapp), medan Chat-with-Notes erbjuder en minimalistisk metod för enkel dokument Q&A.

Eftersom alla dessa verktyg är aktivt underhålls, kan du även förvänta dig förbättringar och gemenskapsstöd. Genom att välja ett av dessa gränssnitt, kommer du att kunna chatta med dina lokalt värd Ollama-modeller på ett bekvämt sätt – oavsett om det är att analysera dokument, kodning med assistans eller bara ha konversationell AI tillgänglig utan molnberoenden. Varje lösning ovan är öppen källkod, så du kan ytterligare anpassa dem till dina behov eller till och med bidra till deras utveckling. För att se hur lokal Ollama plus dessa gränssnitt passar in med andra lokala och molnalternativ, se vår LLM Hosting: Lokal, självvärd och molninfrastruktur jämförd guide.

Lycka till med att chatta med din lokala LLM!