Farfalle vs Perplexica

Jämförelse av två självhämtade AI-sökmotorer

Läcker mat är också en njutning för ögonen. Men i den här posten kommer vi att jämföra två AI-baserade söksystem, Farfalle och Perplexica.

Förresten, denna pastaform kallas också “farfalle”.

Men här jämför jag bara hur dessa två system fungerar. Inte pastas formerna.

OK. Koncentrera dig!

Se även Perplexica installation och konfiguration - med ollama och Installera och konfigurera Ollama.

Perplexica

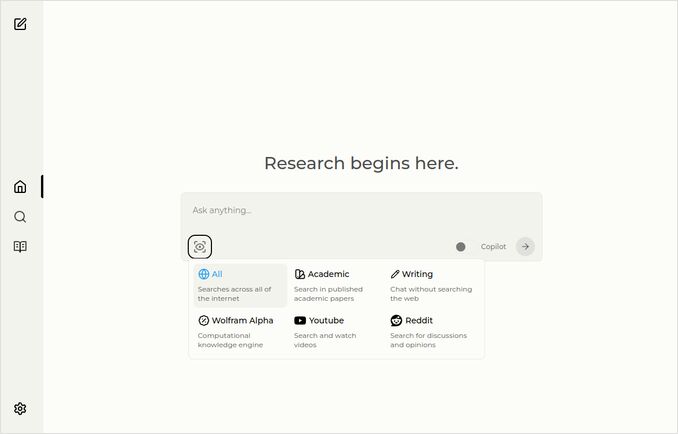

Här är startsidan med källval rullgardinsmeny.

- Perplexica är implementerat i

- TypeScript och React.Js (UI)

- TypeScript och Express.Js (Backend)

- inkluderar också konfiguration för SearxNG metasökmotor

- Har ett Copilot-läge

- Har möjlighet att använda vilken som helst Ollama-värdad LLM som chatt- eller embeddingsmodell

- Har tre små interna embeddingsmodeller

Farfalle

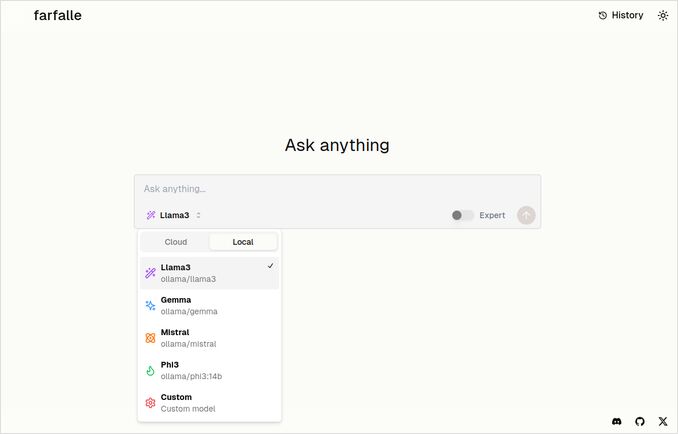

- Farfalle är implementerat i

- TypeScript och React.Js (UI)

- Python Fastapi (Backend)

- inkluderar också referens för SearxNG metasökmotor. Inte mycket konfiguration för detta, ganska standard docker-image.

- Har ett Expert-läge som bör förbereda flera förfrågningar från den ursprungliga och kombinera svaren. Men detta fungerade inte i vårt test.

- Har möjlighet att använda fyra Ollama-värdade LLMs som chattmodell (llama3, mistral, gemma, phi3). Det är ett bra urval av alternativ, men jag skulle föredra att det var mer flexibelt och tillät användning av vilken modell som helst som Ollama serverar.

- Inga alternativ för embeddingsmodell

Jämförelse gjord av Perplexica och Farfalle själva

Jag har kört samma förfrågan Jämför farfalle och perplexica baserat på robusthet, community, support och LLM-stöd

Både Perplexica och Farfalle använde llama3-modellen värdad lokalt på ollama. Fullständigt namn på modellen är llama3 8b q4.

Tro inte 100% på vad svaren säger, se bara textlängden, strukturen och den övergripande svarskvaliteten.

Jag skulle tro cirka 70%…

Perplexica jämförelsesvar

Jämförelse av Farfalle och Perplexica

Robusthet

Farfalle: 8/10 - Farfalle är en populär AI-sökmotor känd för sin pålitlighet och förmåga att hantera komplexa förfrågningar. Den har en stark grund i naturlig språkbehandling (NLP) och maskininlärning (ML). Även om den inte är perfekt, är Farfalles robusthet väl etablerad.

Perplexica: 9/10 - Perplexica är byggd på Meta AIs Phi-3-modell, som är designad för robusthet. Den har testats för att ge exakta svar även när den möter tvetydiga eller oklara förfrågningar. Dess förmåga att omformulera frågor och anpassa sig till olika sammanhang gör den till en robust sökmotor.

Community

Farfalle: 7/10 - Farfalle har en dedikerad användargrupp som uppskattar dess förmågor. Även om den inte har samma nivå av användning som Perplexica, är Farfalles användarbas fortfarande betydande.

Perplexica: 8.5/10 - Perplexica har fått bred erkännande för sitt innovativa tillvägagångssätt för sökmotorer. Dess community växer snabbt, med många användare som uppskattar dess förmåga att ge exakta och relevanta resultat.

Support

Farfalle: 6.5/10 - Farfalle erbjuder grundläggande support genom FAQs, dokumentation och forum. Även om det inte är lika omfattande som Perplexicas support, är Farfalles användarbas generellt självhjälpande.

Perplexica: 9/10 - Perplexica erbjuder omfattande supportresurser, inklusive detaljerad dokumentation, FAQs och communityforum. Dess utvecklare är aktivt engagerade i communityn, vilket säkerställer att användarna får snabb och effektiv hjälp.

LLMs Stödda

Farfalle: Nej - Farfalle är en fristående AI-sökmotor som inte förlitar sig på stora språkmodeller (LLMs) för sina förmågor.

Perplexica: Ja - Perplexica är byggd på Meta AIs Phi-3-modell, som är en LLM. Detta tillåter Perplexica att utnyttja kraften i djupinlärning för mer exakta och relevanta resultat.

Sammanlagd poäng Farfalle: 22/30 Perplexica: 34.5/40

Baserat på dessa kriterier verkar Perplexica ha en liten fördel över Farfalle när det gäller robusthet, communitysupport och LLM-integration. Båda sökmotorerna har dock sina styrkor, och valet beror slutligen på dina specifika behov och preferenser.

Rekommendation Om du letar efter en pålitlig AI-sökmotor med starka NLP-förmågor, kan Perplexica vara det bättre valet. Om du föredrar ett mer rakt på sak tillvägagångssätt för sökning, kan Farfalle fortfarande ge utmärkta resultat.

Farfalle jämförelsesvar

Jämförelse av Farfalle och Perplexica

Farfalle och Perplexica är två AI-drivna sökmotorer som har fått uppmärksamhet på senare tid. Här är en jämförelse av dessa två projekt baserat på robusthet, community, support och LLM-stöd (Large Language Model).

Robusthet

- Farfalle är designat för att vara self-hosted med lokala eller molnbaserade LLMs, vilket gör det till ett mer robust alternativ för användare som vill ha kontroll över sin sökmotor.

- Perplexica, å andra sidan, är en open-source-alternativ till Perplexity AI och förbättras kontinuerligt av dess utvecklare.

Community

- Perplexica har en dedikerad community av utvecklare och användare som bidrar till dess utveckling och ger support

- Farfalles community är mindre, men den har fortfarande en närvaro på GitHub

Support

- Perplexica erbjuder regelbundna uppdateringar och förbättringar, samt en Discord-kanal för att diskutera ämnen utanför vanlig support

- Farfalles support är begränsad till GitHub-ärenden och pull requests

LLM-stöd Både Farfalle och Perplexica stöder LLMs. Perplexica använder Ollama, en lokal LLM, medan Farfalle stöder både lokala och molnbaserade LLMs.

Sammanfattningsvis är Farfalle mer robust på grund av sin self-hosted-design, medan Perplexica har en starkare community och bättre support. Båda projekten stöder LLMs, men Perplexica använder specifikt Ollama.

Slutsats

Vad är skillnaden mellan Perplexica och Farfalle?

Svaren:

- Förutom några faktiska fel, tycker båda systemen att Perplexica är bättre än Farfalle, vilket jag skulle vilja hålla med om.

- Jag gillar verkligen Farfalle UI, även om de är ganska lika

- Jag gillar idén med Farfalles expertläge även om det inte fungerade i mitt miljö

- Jag stötte på 3 buggar när jag körde Farfalle. Perplexicas kod är mer polerad

- När den är konfigurerad, körde Perplexica utan några fel

- Perplexica tillåter användning av vilken som helst Ollama-värdad modell. Och Farfalle tillåter bara användning av Gemma, Llama3, Mistral och Phi3 (fördefinierade versioner, som är lite utdaterade).

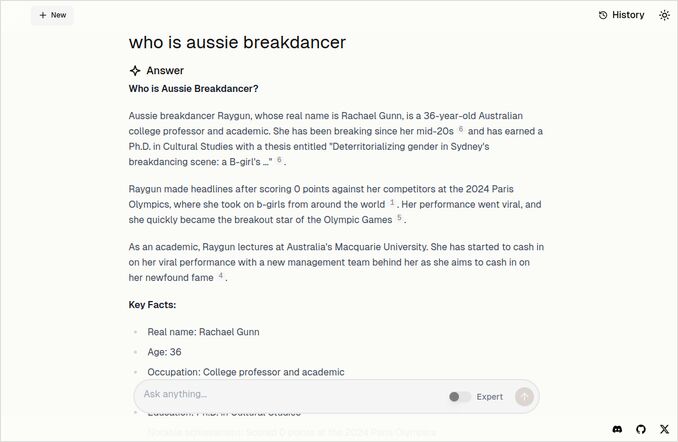

- Jag gillar Farfalles svar mer. Titta på Farfalle-bilden nedan. Rakt på sak utan “Enligt den tillhandahållna kontexten”…

Fler exempel

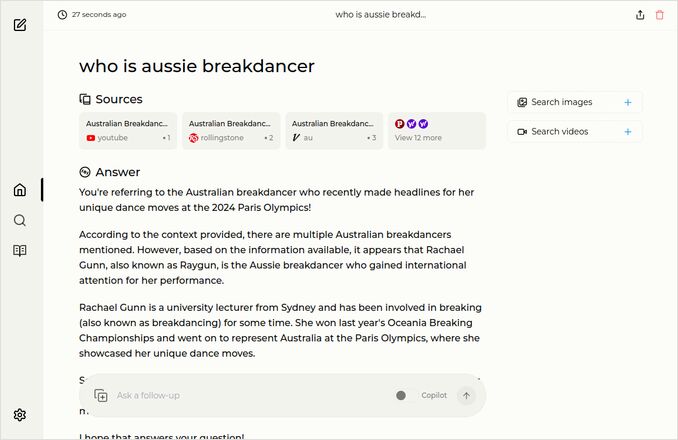

Dessa visar svar på samma fråga om den australiensiska breakdansaren. Du vet, den med doktorsexamen som fick 0 (noll) poäng och troligen fick breakdansen borttagen från det olympiska programmet.

Farfalle svar

Perplexica svar

Om du läser upp (eller ner) till detta sista stycke, Tack för att du har samma intressen som jag. Det är verkligen spännande tider. Ha en bra dag!

Användbara länkar

- Sökning vs Deepsearch vs Deep Research

- Test: Hur Ollama använder Intel CPU-prestanda och effektiva kärnor

- Hur Ollama hanterar parallella förfrågningar

- Self-hosting Perplexica - med Ollama

- Jämförelse av LLM-sammanfattningsförmåga

- Att skriva effektiva promptar för LLMs

- Testning av logiska fallaciers detektering av nya LLMs: gemma2, qwen2 och mistral Nemo

- Ollama cheatsheet

- Markdown Cheatsheet

- Cloud LLM-providere

- Qwen3 Embedding & Reranker Modeller på Ollama: State-of-the-Art-prestanda