Flytta Ollama-modeller till en annan plats

Ollama LLM-modellfilerna tar mycket utrymme

Efter att ha installerat ollama är det bättre att omkonfigurera ollama direkt så att de lagras i en ny plats. Så efter att vi hämtar en ny modell, kommer den inte att laddas ner till den gamla platsen.

Om Ollama

Ollama är en textbaserad frontend till LLM AI-modeller och en API som också kan värdas dem. För en bredare jämförelse mellan Ollama och vLLM, Docker Model Runner, LocalAI och molntjänstleverantörer – inklusive kostnads- och infrastrukturväxel – se LLM-värdning: Lokal, självvärdad och molninfrastruktur jämförd.

Installera Ollama

Gå till https://ollama.com/download

För att installera Ollama på Linux:

curl -fsSL https://ollama.com/install.sh | sh

Ollama på Windows finns på sidan: https://ollama.com/download/windows Ollama för Mac finns också där: https://ollama.com/download/macOllamaSetup.exe

Ladda ner, lista och ta bort Ollama-modeller

För att ladda ner vissa Ollama-modeller: Gå till Ollama-bibliotek (https://ollama.com/library) och hitta den modell du behöver, där kan du också hitta modelltaggar och storlekar.

Sedan kör du:

ollama pull gemma2:latest

# Eller få en lite smartare som fortfarande passar in i 16GB VRAM:

ollama pull gemma2:27b-instruct-q3_K_S

# Eller:

ollama pull llama3.1:latest

ollama pull llama3.1:8b-instruct-q8_0

ollama pull mistral-nemo:12b-instruct-2407-q6_K

ollama pull mistral-small:22b-instruct-2409-q4_0

ollama pull phi3:14b-medium-128k-instruct-q6_K

ollama pull qwen2.5:14b-instruct-q5_0

För att kontrollera vilka modeller Ollama har i lokal databas:

ollama list

För att ta bort någon onödig modell:

ollama rm qwen2:7b-instruct-q8_0 # till exempel

Plats för Ollama-modeller

Som standard lagras modellfilerna:

- Windows: C:\Users%username%.ollama\models

- Linux: /usr/share/ollama/.ollama/models

- macOS: ~/.ollama/models

Konfigurera Ollama-modellplats på Windows

För att skapa en miljövariabel på Windows kan du följa dessa instruktioner:

- Öppna Windows-inställningar.

- Gå till System.

- Välj Om

- Välj Avancerade systeminställningar.

- Gå till Avancerat fliken.

- Välj Miljövariabler…

- Klicka på Ny…

- Skapa en variabel som heter OLLAMA_MODELS som pekar till var du vill att modellerna ska lagras

Flytta Ollama-modeller på Linux

Redigera ollama systemd-tjänstparametrar

sudo systemctl edit ollama.service

eller

sudo xed /etc/systemd/system/ollama.service

Detta kommer öppna en redigerare.

För varje miljövariabel, lägg till en rad Environment under avsnittet [Service]:

[Service]

Environment="OLLAMA_MODELS=/specialplace/ollama/models"

Spara och avsluta.

Det finns också en User och Group parametrar, dessa måste ha åtkomst till den här mappen.

Ladda om systemd och starta om Ollama:

sudo systemctl daemon-reload

sudo systemctl restart ollama

om något gick fel

systemctl status ollama.service

sudo journalctl -u ollama.service

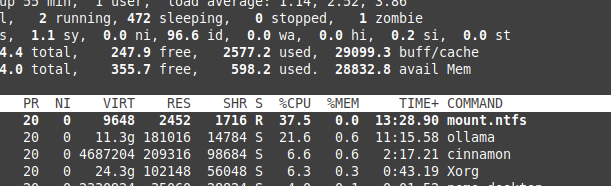

Filöverföring på NTFS-överhuvud

Vänligen vara medveten om att om du kör Linux och behåller dina modeller på en NTFS-formaterad partition, så kommer dina modeller att laddas ner mycket – mer än 20% långsammare.

Installera Ollama på Windows till en specifik mapp

Tillsammans med modellerna

.\OllamaSetup.exe /DIR=D:\OllamaDir

Exponera Ollama API till intern nätverk

Intern här betyder lokalt nätverk.

Lägg till i tjänstkonfiguration:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

För att se hur Ollama passar ihop med andra lokala och molna LLM alternativ, se vår LLM-värdning: Lokal, självvärdad och molninfrastruktur jämförd guide.

Några användbara länkar

- Test: Hur Ollama använder Intel CPU-prestanda och effektiva kärnor

- Hur Ollama hanterar parallella begäranden

- LLM-prestanda och PCIe-lan: Viktiga överväganden

- LLM-hastighetsprestandajämförelse

- Jämförelse av LLM-sammanfattningseffektivitet

- Skriv effektiva prompter för LLMs

- Selvvärdning av Perplexica – med Ollama

- Moln LLM-leverantörer