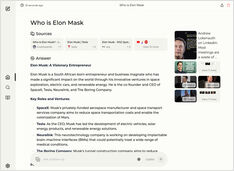

Antarmuka Chat untuk Instans Ollama Lokal

Gambaran singkat tentang antarmuka pengguna (UI) paling menonjol untuk Ollama pada tahun 2025

Ollama yang dihosting secara lokal memungkinkan Anda menjalankan model bahasa besar di mesin Anda sendiri, tetapi menggunakan Ollama melalui baris perintah tidak ramah pengguna.

Berikut beberapa proyek open-source yang menyediakan antarmuka gaya ChatGPT yang menghubungkan ke Ollama lokal.