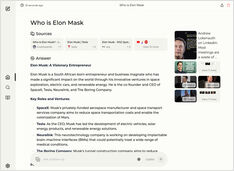

स्थानीय ओल्लामा इंस्टेंस के लिए चैट यूआई

2025 में ओल्लामा के लिए सबसे प्रमुख यूआई का त्वरित अवलोकन

स्थानीय रूप से होस्टेड Ollama आपको अपने मशीन पर बड़े भाषा मॉडल चलाने की अनुमति देता है, लेकिन कमांड-लाइन के माध्यम से इसका उपयोग करना उपयोगकर्ता-मित्र नहीं है। यहाँ कुछ ओपन-सोर्स प्रोजेक्ट्स हैं जो ChatGPT-स्टाइल इंटरफेस प्रदान करते हैं जो स्थानीय Ollama से कनेक्ट होते हैं।