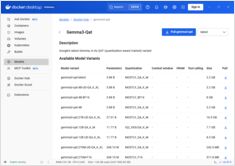

डॉकर मॉडल रनर चीटशीट: कमांड्स और उदाहरण

डॉकर मॉडल रनर कमांड्स के लिए त्वरित संदर्भ

डॉकर मॉडल रनर (डीएमआर) डॉकर का आधिकारिक समाधान है जो स्थानीय रूप से एआई मॉडल चलाने के लिए है, जो अप्रैल 2025 में पेश किया गया था। यह चीटशीट सभी आवश्यक कमांड्स, कॉन्फ़िगरेशन, और बेस्ट प्रैक्टिसेस के लिए एक तेज़ संदर्भ प्रदान करता है।