डॉकर मॉडल रनर में NVIDIA GPU समर्थन जोड़ना

डॉकर मॉडल रनर के लिए एनवीडिया CUDA समर्थन के साथ GPU त्वरण सक्षम करें

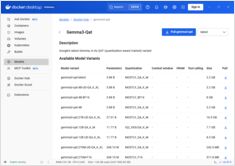

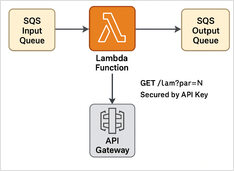

डॉकर मॉडल रनर डॉकर का आधिकारिक टूल है जो स्थानीय रूप से AI मॉडल चलाने के लिए है, लेकिन डॉकर मॉडल रनर में NVidia GPU त्वरक सक्षम करना के लिए विशेष कॉन्फ़िगरेशन की आवश्यकता होती है।