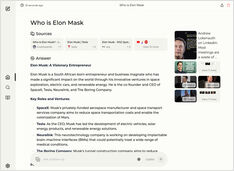

واجهات المحادثة لمحليات Ollama

نظرة سريعة على أكثر واجهات المستخدم بارزة لـ Ollama في عام 2025

يتيح Ollama المضيف محليًا تشغيل نماذج لغات كبيرة على جهازك الخاص، ولكن استخدامه عبر سطر الأوامر ليس ودودًا للمستخدم.

هناك عدة مشاريع مفتوحة المصدر توفر واجهات تشبه ChatGPT تربط مع Ollama المحلي.