كيف يتعامل Ollama مع الطلبات المتزامنة

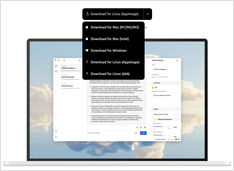

تهيئة ollama لتنفيذ طلبات متوازية.

عندما يتلقى خادم Ollama طلبين في نفس الوقت، فإن سلوكه يعتمد على إعداداته وموارد النظام المتاحة.

تهيئة ollama لتنفيذ طلبات متوازية.

عندما يتلقى خادم Ollama طلبين في نفس الوقت، فإن سلوكه يعتمد على إعداداته وموارد النظام المتاحة.

ما هذا البرمجة المعاصرة المعززة بالذكاء الاصطناعي؟

البرمجة بالطريقة المُلهمة هي نهج برمجي يُحركه الذكاء الاصطناعي، حيث يصف المطورون الوظائف المرغوبة بلغة طبيعية، مما يسمح لل أدوات الذكاء الاصطناعي بإنشاء الكود تلقائيًا.

كل مجموعة من أدوات MM* في نهاية دورة الحياة...

لقد استخدمت MMDetection (mmengine، mdet، mmcv) إلى حد كبير،

ولكن الآن يبدو أنه خارج اللعبة.

هذا أمر مأساوي. كنت أحب مكتبة النماذج الخاصة به.

مقارنة نموذجين من deepseek-r1 بنموذجين أساسيين

نموذج DeepSeek الجيل الأول من نماذج الاستدلال التي تقدم أداءً مماثلاً لأداء نموذج OpenAI-o1، وتشمل ستة نماذج كثيفة تم استخلاصها من DeepSeek-R1 بناءً على Llama وQwen.

أعدت تجميع قائمة الأوامر هذه لـ Ollama منذ بضع وقت مضى...

هنا قائمة بأهم أوامر Ollama (قائمة أوامر Ollama)

جمعتها منذ فترة.

أتمنى أن تكون مفيدة لك أيضًا هنا.

الجولة التالية من اختبارات النماذج الكبيرة

لم تمرّ فترة طويلة منذ إصداره. دعنا ن迎头赶上 وTest how Mistral Small performs comparing to other LLMs.

كود بايثون لإعادة الترتيب في RAG

إعادة الترتيب هو خطوة ثانية في توليد المحتوى المعزز بالاسترجاع (RAG) الأنظمة, بين الاسترجاع والتكوين.

نموذج الذكاء الاصطناعي الرائع الجديد لتوليد صورة من النص

في الآونة الأخيرة أصدرت مختبرات Black Forest مجموعة من نماذج الذكاء الاصطناعي لتحويل النص إلى صورة. تُقال إن هذه النماذج تنتج صورًا ذات جودة أعلى بكثير. لنحاول استخدامها

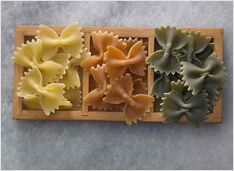

مقارنة بين محركي بحث الذكاء الاصطناعي الذاتيين

الطعام الرائع هو متعة للعين أيضًا. لكن في هذه المقالة، سنقارن بين نظامي بحث قائمين على الذكاء الاصطناعي، Farfalle و Perplexica.

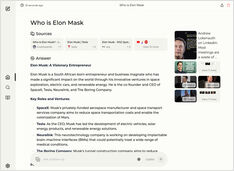

هل ترغب في تشغيل خدمة من نوع كوبيلو محليًا؟ سهل جدًا!

هذا أمر مثير للغاية! بدلاً من الاتصال بـ copilot أو perplexity.ai وإخبار العالم بأكمله بما تبحث عنه، يمكنك الآن تشغيل خدمة مشابهة على جهاز الكمبيوتر أو الحاسوب المحمول الخاص بك!

اختبار اكتشاف الأخطاء المنطقية

في الآونة الأخيرة، شهدنا إصدار عدد من النماذج الجديدة من LLMs. أوقات مثيرة. لنختبر ونرى كيف تؤدي الأداء عند اكتشاف الخطا المنطقية.

ليس هناك الكثير可供选择 ولكن ما زال هناك...

عندما بدأت بتجربة النماذج الكبيرة للغة (LLMs)، كانت واجهات المستخدم الخاصة بها في التطوير النشط، و اليوم أصبحت بعضها جيدة حقًا.

يتطلب بعض التجريب ولكن

ما زال هناك بعض الأساليب الشائعة لكتابة محفزات جيدة بحيث لا يشعر النموذج اللغوي الضخم (LLM) بالارتباك عند محاولة فهم ما تريده منه.

الكود البرمجي لبايثون المطلوب بشكل متكرر

أحيانًا أحتاج إلى هذا ولكن لا أستطيع العثور عليه فورًا.

لذلك أحتفظ بهم جميعًا هنا.

يتطلب التصنيف والتدريب بعض التصاق الأجزاء

عندما قمت تدريب مكتشف كائنات الذكاء الاصطناعي في وقت ما - كان LabelImg أداة مفيدة للغاية، لكن تصدير البيانات من Label Studio إلى تنسيق COCO لم يكن مقبولاً من قبل إطار عمل MMDetection..

8 نسخة من llama3 (Meta+) و5 نسخ من phi3 (Microsoft) من نماذج LLM

اختبار كيف تؤثر النماذج ذات عدد مختلف من المعلمات والكم量化 على الأداء.