क्रॉस-मोडल एम्बेडिंग्स: एआई मोडलिटीज़ को जोड़ने वाला पुल

पाठ, छवियों और ऑडियो को साझा एम्बेडिंग स्पेस में एकीकृत करें

क्रॉस-मोडल एम्बेडिंग्स (https://www.glukhov.org/hi/post/2025/11/using-cross-modal-embeddings/ “क्रॉस-मोडल एम्बेडिंग्स”) कृत्रिम बुद्धिमत्ता में एक महत्वपूर्ण प्रगति का प्रतिनिधित्व करते हैं, जो एक संयुक्त प्रतिनिधित्व स्थान में विभिन्न डेटा प्रकारों को समझने और तर्क करने की अनुमति देते हैं।

यह तकनीक आधुनिक मल्टीमोडल अनुप्रयोगों को सक्षम बनाती है, जो छवि खोज से लेकर सामग्री उत्पादन तक है।

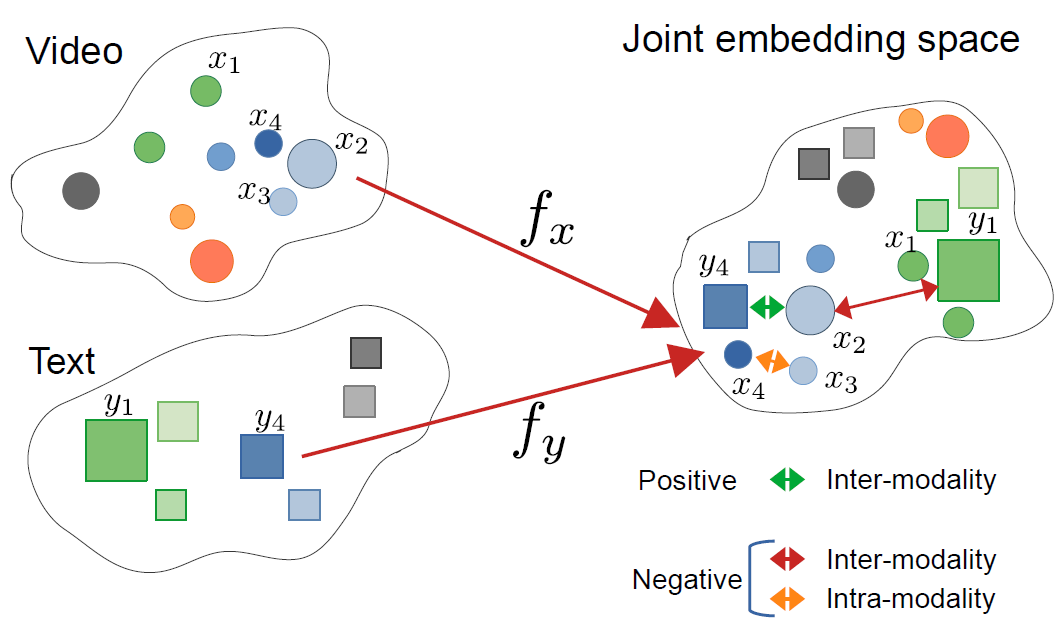

इस छवि का स्रोत है लेख:

CrossCLR: cross-modal contrastive learning for multi-modal video representations, by Mohammadreza Zolfaghari और अन्य

इस छवि का स्रोत है लेख:

CrossCLR: cross-modal contrastive learning for multi-modal video representations, by Mohammadreza Zolfaghari और अन्य

क्रॉस-मोडल एम्बेडिंग्स को समझना

क्रॉस-मोडल एम्बेडिंग्स वेक्टर प्रतिनिधित्व हैं जो विभिन्न मोडलिटीज—जैसे टेक्स्ट, छवियाँ, ऑडियो, और वीडियो—को एक साझा एम्बेडिंग स्पेस में एन्कोड करते हैं। पारंपरिक एकल-मोडलिटी एम्बेडिंग्स के विपरीत, क्रॉस-मोडल दृष्टिकोण एक संयुक्त प्रतिनिधित्व सीखते हैं जहां सेमांटिक रूप से समान अवधारणाएं उनके मूल प्रारूप के बावजूद एक साथ क्लस्टर होती हैं।

क्रॉस-मोडल एम्बेडिंग्स क्या हैं?

अपनी कोर में, क्रॉस-मोडल एम्बेडिंग्स AI में एक महत्वपूर्ण चुनौती को हल करते हैं: विभिन्न डेटा प्रकारों के बीच जानकारी की तुलना और संबंध स्थापित करना। एक पारंपरिक छवि वर्गीकरणकर्ता केवल छवियों के साथ काम कर सकता है, जबकि एक टेक्स्ट मॉडल केवल टेक्स्ट को संभाल सकता है। क्रॉस-मोडल एम्बेडिंग्स इस अंतराल को भरते हैं एक सामान्य वेक्टर स्पेस में विभिन्न मोडलिटीज को प्रोजेक्ट करके जहां:

- एक बिल्ली की छवि और शब्द “बिल्ली” के पास समान एम्बेडिंग वेक्टर होते हैं

- सेमांटिक संबंध विभिन्न मोडलिटीज के बीच संरक्षित रहते हैं

- दूरी मापदंड (कोसाइन समानता, यूक्लिडियन दूरी) क्रॉस-मोडल समानता को मापते हैं

इस संयुक्त प्रतिनिधित्व से शक्तिशाली क्षमताएं सक्षम होती हैं जैसे छवियों को टेक्स्ट क्वेरीज का उपयोग करके खोजना, छवियों से कैप्शन उत्पन्न करना, या यहां तक कि ज़ीरो-शॉट वर्गीकरण बिना टास्क-स्पेसिफिक ट्रेनिंग के।

क्रॉस-मोडल लर्निंग के पीछे का आर्किटेक्चर

आधुनिक क्रॉस-मोडल सिस्टम आमतौर पर ड्यूल-एन्कोडर आर्किटेक्चर के साथ कॉन्ट्रास्टिव लर्निंग ऑब्जेक्टिव्स का उपयोग करते हैं:

ड्यूल एन्कोडर्स: अलग-अलग न्यूरल नेटवर्क प्रत्येक मोडलिटी को एन्कोड करते हैं। उदाहरण के लिए, CLIP का उपयोग करता है:

- छवियों के लिए एक विज़न ट्रांसफॉर्मर (ViT) या ResNet

- भाषा के लिए एक ट्रांसफॉर्मर-आधारित टेक्स्ट एन्कोडर

कॉन्ट्रास्टिव लर्निंग: मॉडल मिलान वाले जोड़ों (जैसे, छवि और उसका कैप्शन) के बीच समानता को अधिकतम करने और न मिलान वाले जोड़ों के बीच समानता को कम करने से सीखता है। कॉन्ट्रास्टिव लॉस फंक्शन को इस प्रकार व्यक्त किया जा सकता है:

[ \mathcal{L} = -\log \frac{\exp(\text{sim}(v_i, t_i) / \tau)}{\sum_{j=1}^{N} \exp(\text{sim}(v_i, t_j) / \tau)} ]

जहां (v_i) छवि एम्बेडिंग है, (t_i) टेक्स्ट एम्बेडिंग है, (\text{sim}) समानता (आमतौर पर कोसाइन) है, और (\tau) एक टेम्परेचर पैरामीटर है।

प्रमुख तकनीकें और मॉडल

CLIP: विज़न-लैंग्वेज समझ का अग्रणी

OpenAI का CLIP (Contrastive Language-Image Pre-training) ने 400 मिलियन इंटरनेट से इमेज-टेक्स्ट जोड़ों पर ट्रेनिंग करके क्षेत्र को क्रांतिकारी बना दिया। मॉडल आर्किटेक्चर में शामिल है:

import torch

from transformers import CLIPProcessor, CLIPModel

from PIL import Image

# प्री-ट्रेन्ड CLIP मॉडल लोड करें

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

# इनपुट्स तैयार करें

image = Image.open("example.jpg")

texts = ["एक बिल्ली की फोटो", "एक कुत्ते की फोटो", "एक पक्षी की फोटो"]

# प्रोसेस और एम्बेडिंग्स प्राप्त करें

inputs = processor(text=texts, images=image, return_tensors="pt", padding=True)

# क्रॉस-मोडल समानता स्कोर प्राप्त करें

outputs = model(**inputs)

logits_per_image = outputs.logits_per_image

probs = logits_per_image.softmax(dim=1)

print(f"प्रायिकताएं: {probs}")

CLIP का मुख्य नवाचार स्केल और सरलता थी। मैन्युअल एनोटेशन्स के बिना वेब-स्केल डेटा पर ट्रेनिंग करके, यह उल्लेखनीय ज़ीरो-शॉट ट्रांसफर क्षमताएं प्राप्त कीं। CLIP पारंपरिक विज़न मॉडल से कैसे अलग है? जबकि सुपरवाइज्ड क्लासिफायर्स फिक्स्ड लेबल सेट्स पर ट्रेनिंग की जाती हैं, CLIP नैचुरल लैंग्वेज सुपरविजन से सीखता है, जिससे इसे किसी भी विज़ुअल कॉन्सेप्ट के लिए अनुकूलन क्षमता मिलती है जो टेक्स्ट में वर्णित किया जा सकता है।

ImageBind: छह मोडलिटीज तक विस्तार

Meta का ImageBind क्रॉस-मोडल एम्बेडिंग्स को विज़न और भाषा से परे विस्तारित करता है जिसमें शामिल हैं:

- ऑडियो (पर्यावरणीय ध्वनियाँ, भाषण)

- गहराई जानकारी

- थर्मल इमेजिंग

- IMU (मोशन सेंसर) डेटा

इससे एक वास्तव में मल्टीमोडल एम्बेडिंग स्पेस बनता है जहां सभी छह मोडलिटीज एलाइन होते हैं। मुख्य अंतर्दृष्टि यह है कि छवियाँ एक “बाइंडिंग” मोडलिटी के रूप में कार्य करती हैं—छवियों को अन्य मोडलिटीज के साथ जोड़कर और मौजूदा विज़न-लैंग्वेज एलाइनमेंट का लाभ उठाकर, ImageBind एक संयुक्त स्पेस बनाता है बिना ट्रेनिंग के सभी संभावित मोडलिटी जोड़ों की आवश्यकता के।

ओपन-सोर्स विकल्प

इकोसिस्टम ने कई ओपन-सोर्स इम्प्लीमेंटेशन्स के साथ विस्तार किया है:

OpenCLIP: एक समुदाय इम्प्लीमेंटेशन जो बड़े मॉडल और विविध ट्रेनिंग रेसिपी प्रदान करता है:

import open_clip

model, _, preprocess = open_clip.create_model_and_transforms(

'ViT-L-14',

pretrained='laion2b_s32b_b82k'

)

tokenizer = open_clip.get_tokenizer('ViT-L-14')

LAION-5B मॉडल: विशाल ओपन LAION-5B डेटासेट पर ट्रेनिंग किए गए, जो प्रोप्रायटरी मॉडल के साथ तुलनीय या बेहतर प्रदर्शन के साथ विकल्प प्रदान करते हैं।

स्टेट-ऑफ-द-आर्ट ओपन-सोर्स टेक्स्ट एम्बेडिंग समाधानों के लिए, [Qwen3 Embedding & Reranker Models on Ollama](https://www.glukhov.org/hi/post/2025/06/qwen3-embedding-qwen3-reranker-on-ollama/ “Qwen3 embedding और reranker models बहुभाषी NLP में स्टेट-ऑफ-द-आर्ट प्रदर्शन के साथ क्रांतिकारी बदलाव ला रहे हैं, और उनके Ollama के साथ एकीकरण या Hugging Face और GitHub के माध्यम से स्थानीय डिप्लॉयमेंट का पता लगाएं।) बहुभाषी प्रदर्शन के साथ उत्कृष्ट विकल्प प्रदान करते हैं जिसमें आसान स्थानीय डिप्लॉयमेंट है।

इम्प्लीमेंटेशन रणनीतियाँ

एक क्रॉस-मोडल खोज सिस्टम बनाना

क्रॉस-मोडल एम्बेडिंग्स के लिए सेमांटिक खोज के लिए एक व्यावहारिक इम्प्लीमेंटेशन में कई घटक शामिल होते हैं। क्रॉस-मोडल एम्बेडिंग्स के मुख्य अनुप्रयोग क्या हैं? वे ई-कॉमर्स उत्पाद खोज से लेकर सामग्री मॉडरेशन और क्रिएटिव टूल्स तक के उपयोग मामलों को सक्षम बनाते हैं।

import numpy as np

from typing import List, Tuple

import faiss

from transformers import CLIPModel, CLIPProcessor

class CrossModalSearchEngine:

def __init__(self, model_name: str = "openai/clip-vit-base-patch32"):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.image_index = None

self.image_metadata = []

def encode_images(self, images: List) -> np.ndarray:

"""छवियों को एम्बेडिंग्स में एन्कोड करें"""

inputs = self.processor(images=images, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_image_features(**inputs)

return embeddings.cpu().numpy()

def encode_text(self, texts: List[str]) -> np.ndarray:

"""टेक्स्ट क्वेरीज को एम्बेडिंग्स में एन्कोड करें"""

inputs = self.processor(text=texts, return_tensors="pt", padding=True)

with torch.no_grad():

embeddings = self.model.get_text_features(**inputs)

return embeddings.cpu().numpy()

def build_index(self, image_embeddings: np.ndarray):

"""समानता खोज के लिए कुशल FAISS इंडेक्स बनाएं"""

dimension = image_embeddings.shape[1]

# कोसाइन समानता के लिए एम्बेडिंग्स को नॉर्मलाइज़ करें

faiss.normalize_L2(image_embeddings)

# इंडेक्स बनाएं (बड़े पैमाने पर डिप्लॉयमेंट के लिए HNSW का उपयोग करें)

self.image_index = faiss.IndexHNSWFlat(dimension, 32)

self.image_index.hnsw.efConstruction = 40

self.image_index.add(image_embeddings)

def search(self, query: str, k: int = 10) -> List[Tuple[int, float]]:

"""टेक्स्ट क्वेरी का उपयोग करके छवियों की खोज करें"""

query_embedding = self.encode_text([query])

faiss.normalize_L2(query_embedding)

distances, indices = self.image_index.search(query_embedding, k)

return list(zip(indices[0], distances[0]))

# उपयोग उदाहरण

engine = CrossModalSearchEngine()

# छवि संग्रह से इंडेक्स बनाएं

image_embeddings = engine.encode_images(image_collection)

engine.build_index(image_embeddings)

# टेक्स्ट के साथ खोज करें

results = engine.search("पर्वतों पर सूर्यास्त", k=5)

डोमेन-स्पेसिफिक टास्क्स के लिए फाइन-ट्यूनिंग

हालांकि प्री-ट्रेन्ड मॉडल सामान्य उद्देश्यों के लिए अच्छी तरह से काम करते हैं, डोमेन-स्पेसिफिक अनुप्रयोगों को फाइन-ट्यूनिंग से लाभ होता है:

from transformers import CLIPModel, CLIPProcessor, AdamW

import torch.nn as nn

class FineTuneCLIP:

def __init__(self, model_name: str, num_epochs: int = 10):

self.model = CLIPModel.from_pretrained(model_name)

self.processor = CLIPProcessor.from_pretrained(model_name)

self.num_epochs = num_epochs

def contrastive_loss(self, image_embeddings, text_embeddings, temperature=0.07):

"""InfoNCE कॉन्ट्रास्टिव लॉस कंप्यूट करें"""

# एम्बेडिंग्स को नॉर्मलाइज़ करें

image_embeddings = nn.functional.normalize(image_embeddings, dim=1)

text_embeddings = nn.functional.normalize(text_embeddings, dim=1)

# समानता मैट्रिक्स कंप्यूट करें

logits = torch.matmul(image_embeddings, text_embeddings.T) / temperature

# लेबल डायगोनल (मिलान वाले जोड़े) हैं

labels = torch.arange(len(logits), device=logits.device)

# सिमेट्रिक लॉस

loss_i = nn.functional.cross_entropy(logits, labels)

loss_t = nn.functional.cross_entropy(logits.T, labels)

return (loss_i + loss_t) / 2

def train(self, dataloader, learning_rate=5e-6):

"""डोमेन-स्पेसिफिक डेटा पर फाइन-ट्यून करें"""

optimizer = AdamW(self.model.parameters(), lr=learning_rate)

self.model.train()

for epoch in range(self.num_epochs):

total_loss = 0

for batch in dataloader:

images, texts = batch['images'], batch['texts']

# इनपुट्स प्रोसेस करें

inputs = self.processor(

text=texts,

images=images,

return_tensors="pt",

padding=True

)

# फॉरवर्ड पास

outputs = self.model(**inputs, return_loss=True)

loss = outputs.loss

# बैकवर्ड पास

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_loss += loss.item()

avg_loss = total_loss / len(dataloader)

print(f"इपोक {epoch+1}/{self.num_epochs}, लॉस: {avg_loss:.4f}")

उत्पादन तैनाती विचार

इन्फरेंस प्रदर्शन को अनुकूलित करना

क्रॉस-मोडल एम्बेडिंग्स को उत्पादन के लिए कैसे अनुकूलित किया जाए? प्रदर्शन अनुकूलन वास्तविक दुनिया में तैनाती के लिए महत्वपूर्ण है:

मॉडल क्वांटाइजेशन: मॉडल आकार को कम करें और इन्फरेंस स्पीड बढ़ाएं:

import torch

from torch.quantization import quantize_dynamic

# CPU इन्फरेंस के लिए डायनामिक क्वांटाइजेशन

quantized_model = quantize_dynamic(

model,

{torch.nn.Linear},

dtype=torch.qint8

)

ONNX कन्वर्शन: अनुकूलित इन्फरेंस के लिए ONNX में निर्यात करें:

import torch.onnx

dummy_input = processor(text=["sample"], return_tensors="pt")

torch.onnx.export(

model,

tuple(dummy_input.values()),

"clip_model.onnx",

input_names=['input_ids', 'attention_mask'],

output_names=['output'],

dynamic_axes={

'input_ids': {0: 'batch_size'},

'attention_mask': {0: 'batch_size'}

}

)

बैच प्रोसेसिंग: बैचिंग के माध्यम से GPU उपयोग को अधिकतम करें:

def batch_encode(items: List, batch_size: int = 32):

"""प्रदर्शन के लिए आइटम्स को बैच में प्रोसेस करें"""

embeddings = []

for i in range(0, len(items), batch_size):

batch = items[i:i+batch_size]

batch_embeddings = encode_batch(batch)

embeddings.append(batch_embeddings)

return np.concatenate(embeddings, axis=0)

स्केलेबल वेक्टर स्टोरेज

बड़े पैमाने पर अनुप्रयोगों के लिए, वेक्टर डेटाबेस आवश्यक हैं। कौन से फ्रेमवर्क क्रॉस-मोडल एम्बेडिंग इम्प्लीमेंटेशन का समर्थन करते हैं? मॉडल के अलावा, इन्फ्रास्ट्रक्चर भी महत्वपूर्ण है:

FAISS (Facebook AI Similarity Search): कुशल समानता खोज लाइब्रेरी

- अरबों वेक्टर का समर्थन

- कई इंडेक्स प्रकार (फ्लैट, IVF, HNSW)

- GPU त्वरण उपलब्ध

Milvus: ओपन-सोर्स वेक्टर डेटाबेस

from pymilvus import connections, Collection, FieldSchema, CollectionSchema, DataType

# स्कीमा परिभाषित करें

fields = [

FieldSchema(name="id", dtype=DataType.INT64, is_primary=True, auto_id=True),

FieldSchema(name="embedding", dtype=DataType.FLOAT_VECTOR, dim=512),

FieldSchema(name="metadata", dtype=DataType.JSON)

]

schema = CollectionSchema(fields, description="Image embeddings")

# कलेक्शन बनाएं

collection = Collection("images", schema)

# इंडेक्स बनाएं

index_params = {

"metric_type": "IP", # इनर प्रोडक्ट (कोसाइन समानता)

"index_type": "IVF_FLAT",

"params": {"nlist": 1024}

}

collection.create_index("embedding", index_params)

Pinecone/Weaviate: आसान स्केलिंग और रखरखाव के साथ प्रबंधित वेक्टर डेटाबेस सेवाएं प्रदान करने वाले।

उन्नत उपयोग मामले और अनुप्रयोग

जीरो-शॉट क्लासिफिकेशन

क्रॉस-मोडल एम्बेडिंग्स बिना टास्क-स्पेसिफिक ट्रेनिंग के क्लासिफिकेशन की अनुमति देते हैं। यह क्षमता पारंपरिक कंप्यूटर विजन दृष्टिकोणों से आगे बढ़ती है—for instance, अगर आप टेंसरफ्लो के साथ ऑब्जेक्ट डिटेक्शन में रुचि रखते हैं, तो यह विशेष डिटेक्शन टास्क्स के लिए एक पूरक सुपरवाइज्ड लर्निंग दृष्टिकोण का प्रतिनिधित्व करता है।

def zero_shot_classify(image, candidate_labels: List[str], model, processor):

"""इमेज को अर्जुन श्रेणियों में वर्गीकृत करें"""

# टेक्स्ट प्रॉम्प्ट्स बनाएं

text_inputs = [f"a photo of a {label}" for label in candidate_labels]

# एम्बेडिंग्स प्राप्त करें

inputs = processor(

text=text_inputs,

images=image,

return_tensors="pt",

padding=True

)

outputs = model(**inputs)

# प्रोबेबिलिटीज कंप्यूट करें

logits = outputs.logits_per_image

probs = logits.softmax(dim=1)

# रैंकेड प्रेडिक्शंस वापस करें

sorted_indices = probs.argsort(descending=True)[0]

return [(candidate_labels[idx], probs[0][idx].item()) for idx in sorted_indices]

# उदाहरण उपयोग

labels = ["cat", "dog", "bird", "fish", "horse"]

predictions = zero_shot_classify(image, labels, model, processor)

print(f"टॉप प्रेडिक्शन: {predictions[0]}")

मल्टीमोडल RAG (Retrieval-Augmented Generation)

क्रॉस-मोडल एम्बेडिंग्स को भाषा मॉडल्स के साथ मिलाकर शक्तिशाली मल्टीमोडल RAG सिस्टम बनाए जा सकते हैं। एक बार जब आप संबंधित दस्तावेज़ प्राप्त कर लेते हैं, तो एम्बेडिंग मॉडल्स के साथ रीरैंकिंग रिट्रीवल किए गए उम्मीदवारों को प्रासंगिकता के आधार पर पुनर्व्यवस्थित करके परिणामों की गुणवत्ता को महत्वपूर्ण रूप से सुधार सकता है:

class MultimodalRAG:

def __init__(self, clip_model, llm_model):

self.clip = clip_model

self.llm = llm_model

self.knowledge_base = []

def add_documents(self, images, texts, metadata):

"""ज्ञान आधार में मल्टीमोडल दस्तावेज़ जोड़ें"""

image_embeds = self.clip.encode_images(images)

text_embeds = self.clip.encode_text(texts)

# संयुक्त जानकारी संग्रहित करें

for i, (img_emb, txt_emb, meta) in enumerate(

zip(image_embeds, text_embeds, metadata)

):

self.knowledge_base.append({

'image_embedding': img_emb,

'text_embedding': txt_emb,

'metadata': meta,

'index': i

})

def retrieve(self, query: str, k: int = 5):

"""प्रासंगिक मल्टीमोडल सामग्री प्राप्त करें"""

query_embedding = self.clip.encode_text([query])[0]

# समानताएं कंप्यूट करें

similarities = []

for doc in self.knowledge_base:

# मोडलिटीज के माध्यम से औसत समानता

img_sim = np.dot(query_embedding, doc['image_embedding'])

txt_sim = np.dot(query_embedding, doc['text_embedding'])

combined_sim = (img_sim + txt_sim) / 2

similarities.append((combined_sim, doc))

# टॉप-k वापस करें

similarities.sort(reverse=True)

return [doc for _, doc in similarities[:k]]

def answer_query(self, query: str):

"""प्राप्त मल्टीमोडल संदर्भ का उपयोग करके प्रश्न का उत्तर दें"""

retrieved_docs = self.retrieve(query)

# प्राप्त दस्तावेज़ों से संदर्भ बनाएं

context = "\n".join([doc['metadata']['text'] for doc in retrieved_docs])

# LLM के साथ उत्तर जनरेट करें

prompt = f"Context:\n{context}\n\nQuestion: {query}\n\nAnswer:"

answer = self.llm.generate(prompt)

return answer, retrieved_docs

अगर आप Go में उत्पादन RAG सिस्टम लागू कर रहे हैं, तो Ollama और Qwen3 Embedding model के साथ Go में टेक्स्ट दस्तावेज़ रीरैंकिंग रिट्रीवल गुणवत्ता को अनुकूलित करने के लिए विशेष रूप से उपयोगी पाएंगे।

सामग्री मॉडरेशन और सुरक्षा

क्रॉस-मोडल एम्बेडिंग्स मोडलिटीज के माध्यम से अनुपयुक्त सामग्री का पता लगाने में उत्कृष्ट हैं:

class ContentModerator:

def __init__(self, model, processor):

self.model = model

self.processor = processor

# सुरक्षा श्रेणियां परिभाषित करें

self.unsafe_categories = [

"violent content",

"adult content",

"hateful imagery",

"graphic violence",

"explicit material"

]

self.safe_categories = [

"safe for work",

"family friendly",

"educational content"

]

def moderate_image(self, image, threshold: float = 0.3):

"""चेक करें कि इमेज में असुरक्षित सामग्री है या नहीं"""

# सभी श्रेणियों को मिलाएं

all_categories = self.unsafe_categories + self.safe_categories

text_inputs = [f"image containing {cat}" for cat in all_categories]

# प्रेडिक्शंस प्राप्त करें

inputs = self.processor(

text=text_inputs,

images=image,

return_tensors="pt"

)

outputs = self.model(**inputs)

probs = outputs.logits_per_image.softmax(dim=1)[0]

# असुरक्षित श्रेणियों की जांच करें

unsafe_scores = probs[:len(self.unsafe_categories)]

max_unsafe_score = unsafe_scores.max().item()

return {

'is_safe': max_unsafe_score < threshold,

'confidence': 1 - max_unsafe_score,

'flagged_categories': [

self.unsafe_categories[i]

for i, score in enumerate(unsafe_scores)

if score > threshold

]

}

सर्वोत्तम प्रथाएं और सामान्य गलतियाँ

डेटा प्रीप्रोसेसिंग

उत्तम प्रदर्शन के लिए उचित प्रीप्रोसेसिंग महत्वपूर्ण है:

from torchvision import transforms

# स्टैंडर्ड CLIP प्रीप्रोसेसिंग

clip_transform = transforms.Compose([

transforms.Resize(224, interpolation=transforms.InterpolationMode.BICUBIC),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(

mean=[0.48145466, 0.4578275, 0.40821073],

std=[0.26862954, 0.26130258, 0.27577711]

)

])

बायस और न्यायसंगतता का सामना करना

क्रॉस-मोडल मॉडल्स ट्रेनिंग डेटा से बायस को विरासत में ले सकते हैं:

मिटिगेशन रणनीतियां:

- विविध जनसांख्यिकीय समूहों पर मूल्यांकन करें

- फाइन-ट्यूनिंग के दौरान डिबायसिंग तकनीकों का उपयोग करें

- फेयरनेस-आवरे रिट्रीवल लागू करें

- उत्पादन में नियमित ऑडिटिंग और निगरानी

एम्बेडिंग गुणवत्ता आकलन

उत्पादन में एम्बेडिंग गुणवत्ता का निगरानी करें:

def assess_embedding_quality(embeddings: np.ndarray):

"""एम्बेडिंग गुणवत्ता के लिए मेट्रिक्स कंप्यूट करें"""

# औसत युग्मित दूरी कंप्यूट करें

distances = np.linalg.norm(

embeddings[:, None] - embeddings[None, :],

axis=2

)

avg_distance = distances.mean()

# क्लस्टरिंग की जांच करें (कम इंट्रा-क्लस्टर दूरी)

from sklearn.cluster import KMeans

kmeans = KMeans(n_clusters=10)

labels = kmeans.fit_predict(embeddings)

# सिल्हुएट स्कोर कंप्यूट करें

from sklearn.metrics import silhouette_score

score = silhouette_score(embeddings, labels)

return {

'avg_pairwise_distance': avg_distance,

'silhouette_score': score

}

डॉकर डिप्लॉयमेंट उदाहरण

अपने क्रॉस-मोडल एप्लिकेशन को आसान डिप्लॉयमेंट के लिए पैकेज करें:

FROM nvidia/cuda:11.8.0-cudnn8-runtime-ubuntu22.04

# Python और डिपेंडेंसियों का इंस्टॉलेशन

RUN apt-get update && apt-get install -y python3-pip

WORKDIR /app

# रिक्वायरेमेंट्स का इंस्टॉलेशन

COPY requirements.txt .

RUN pip3 install --no-cache-dir -r requirements.txt

# एप्लिकेशन कोड को कॉपी करें

COPY . .

# API पोर्ट को एक्सपोज करें

EXPOSE 8000

# API सर्वर को रन करें

CMD ["uvicorn", "api:app", "--host", "0.0.0.0", "--port", "8000"]

# api.py - क्रॉस-मोडल एम्बेडिंग्स के लिए FastAPI सर्वर

from fastapi import FastAPI, File, UploadFile

from pydantic import BaseModel

import torch

from PIL import Image

import io

app = FastAPI()

# स्टार्टअप पर मॉडल लोड करें

@app.on_event("startup")

async def load_model():

global model, processor

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

if torch.cuda.is_available():

model = model.cuda()

class TextQuery(BaseModel):

text: str

@app.post("/embed/text")

async def embed_text(query: TextQuery):

inputs = processor(text=[query.text], return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_text_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/embed/image")

async def embed_image(file: UploadFile = File(...)):

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(images=image, return_tensors="pt")

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

with torch.no_grad():

embeddings = model.get_image_features(**inputs)

return {"embedding": embeddings.cpu().numpy().tolist()}

@app.post("/similarity")

async def compute_similarity(

text: TextQuery,

file: UploadFile = File(...)

):

# दोनों एम्बेडिंग्स प्राप्त करें

image = Image.open(io.BytesIO(await file.read()))

inputs = processor(text=[text.text], images=image, return_tensors="pt", padding=True)

if torch.cuda.is_available():

inputs = {k: v.cuda() for k, v in inputs.items()}

outputs = model(**inputs)

similarity = outputs.logits_per_image[0][0].item()

return {"similarity": similarity}

भविष्य की दिशाएँ

क्रॉस-मोडल एम्बेडिंग्स का क्षेत्र तेजी से विकसित हो रहा है:

बड़े मोडैलिटी कवरेज: भविष्य के मॉडल संभवतः स्पर्श (हैप्टिक फीडबैक), गंध, और स्वाद डेटा जैसे अतिरिक्त मोडैलिटीज को शामिल करेंगे ताकि वास्तव में व्यापक मल्टीमोडल समझ हो सके।

सुधारित दक्षता: डिस्टिलेशन और कुशल आर्किटेक्चर में अनुसंधान शक्तिशाली क्रॉस-मोडल मॉडल्स को एज डिवाइसों पर सुलभ बनाएगा।

बेहतर एलाइनमेंट: मोडैलिटीज को अधिक सटीक रूप से एलाइन करने के लिए उन्नत तकनीकों, जिसमें साइकिल कन्सिस्टेंसी लॉस और एडवर्सेरियल ट्रेनिंग शामिल हैं।

कंपोजिशनल अंडरस्टैंडिंग: साधारण वस्तु पहचान से परे जाकर मोडैलिटीज के बीच जटिल संबंधों और कंपोजिशनों को समझने की ओर बढ़ना।

टेम्पोरल मॉडलिंग: एम्बेडिंग स्पेस में स्पष्ट टेम्पोरल रीज़निंग के साथ वीडियो और टाइम-सिरिज डेटा का बेहतर हैंडलिंग।

उपयोगी लिंक्स

- OpenAI CLIP रिपॉजिटरी

- OpenCLIP: ओपन सोर्स इम्प्लीमेंटेशन

- हगिंग फेस ट्रांसफॉर्मर्स डॉक्युमेंटेशन

- मेटा इमेजबाइंड

- LAION-5B डेटासेट

- FAISS डॉक्युमेंटेशन

- Milvus वेक्टर डेटाबेस

- Pinecone वेक्टर डेटाबेस

- पेपर: Learning Transferable Visual Models From Natural Language Supervision

- पेपर: ImageBind: One Embedding Space To Bind Them All

- Concrete Reinforcement Bar Caps object detection with tensorflow

- Reranking with embedding models

- Reranking text documents with Ollama and Qwen3 Embedding model - in Go

- Qwen3 Embedding & Reranker Models on Ollama: State-of-the-Art Performance

क्रॉस-मोडल एम्बेडिंग्स AI सिस्टम द्वारा जानकारी को प्रोसेस और समझने के तरीके में एक पैराडाइम शिफ्ट का प्रतिनिधित्व करते हैं। विभिन्न डेटा प्रकारों के बीच बाधाओं को तोड़कर, ये तकनीकें अधिक प्राकृतिक और सक्षम AI एप्लिकेशन्स को सक्षम बनाती हैं। चाहे आप सर्च सिस्टम, कंटेंट मॉडरेशन टूल्स, या क्रिएटिव एप्लिकेशन्स बन रहे हों, क्रॉस-मोडल एम्बेडिंग्स में महारत हासिल करने से मल्टीमोडल AI में नवाचार के लिए एक दुनिया भर के अवसर खुल जाते हैं।