स्थानीय ओल्लामा इंस्टेंस के लिए चैट यूआई

2025 में ओल्लामा के लिए सबसे प्रमुख यूआई का त्वरित अवलोकन

स्थानीय रूप से होस्टेड Ollama आपको अपने मशीन पर बड़े भाषा मॉडल चलाने की अनुमति देता है, लेकिन कमांड-लाइन के माध्यम से इसका उपयोग करना उपयोगकर्ता-मित्र नहीं है। यहाँ कुछ ओपन-सोर्स प्रोजेक्ट्स हैं जो ChatGPT-स्टाइल इंटरफेस प्रदान करते हैं जो स्थानीय Ollama से कनेक्ट होते हैं।

इन यूआई में संवादात्मक चैट का समर्थन होता है, अक्सर दस्तावेज़ अपलोड के लिए रिट्रीवल-ऑगमेंटेड जनरेशन (RAG) जैसे फीचर्स के साथ, और वे वेब या डेस्कटॉप एप्लिकेशन्स के रूप में चलते हैं। नीचे मुख्य विकल्पों की तुलना दी गई है, जिसके बाद प्रत्येक पर विस्तृत अनुभाग हैं।

Ollama-संगत यूआई की तुलना

| यूआई टूल | प्लेटफॉर्म | दस्तावेज़ समर्थन | Ollama इंटीग्रेशन | मजबूत बिंदु | सीमाएँ |

|---|---|---|---|---|---|

| पेज असिस्ट | ब्राउज़र एक्सटेंशन (Chrome, Firefox) | हाँ – विश्लेषण के लिए फ़ाइलें जोड़ें | एक्सटेंशन कॉन्फ़िग के माध्यम से स्थानीय Ollama से कनेक्ट होता है | इन-ब्राउज़र चैट; आसान मॉडल प्रबंधन और वेब पेज कॉन्टेक्स्ट इंटीग्रेशन। | ब्राउज़र-केवल; एक्सटेंशन इंस्टॉल/कॉन्फ़िगर करने की आवश्यकता है। |

| ओपन वेबयूआई | वेब ऐप (सेल्फ-होस्टेड; Docker/PWA) | हाँ – बिल्ट-इन RAG (दस्तावेज़ अपलोड करें या लाइब्रेरी में जोड़ें) | डायरेक्ट Ollama API समर्थन या बंडल्ड सर्वर (बेस URL कॉन्फ़िगर करें) | फीचर-रिच (मल्टी-एलएलएम, ऑफलाइन, इमेज जनरेशन); मोबाइल-फ्रेंडली (PWA)। | सेटअप भारी है (Docker/K8s); व्यापक स्कोप सरल उपयोग के लिए ओवरकिल हो सकता है। |

| लोबचैट | वेब ऐप (सेल्फ-होस्टेड; PWA समर्थन) | हाँ – “नॉलेज बेस” फ़ाइल अपलोड के साथ (PDF, इमेजेज, आदि) | Ollama को कई AI बैकएंड्स में से एक के रूप में समर्थन करता है (Ollama के API एक्सेस को इनेबल करने की आवश्यकता है) | स्लीक ChatGPT-स्टाइल यूआई; वॉइस चैट, प्लगइन्स, और मल्टी-मॉडल समर्थन। | जटिल फीचर सेट; पर्यावरण सेटअप की आवश्यकता है (उदाहरण के लिए, क्रॉस-ऑरिजिन के लिए Ollama)। |

| लिब्रेचैट | वेब ऐप (सेल्फ-होस्टेड; मल्टी-यूजर) | हाँ – “चैट विथ फ़ाइल्स” RAG का उपयोग करके (इम्बेडिंग्स के माध्यम से) | Ollama और कई अन्य प्रोवाइडर्स के साथ संगत है (प्रति चैट स्विच करने योग्य) | ChatGPT-स्टाइल इंटरफेस से परिचित; रिच फीचर्स (एजेंट्स, कोड इंटरप्रेटर, आदि)। | इंस्टॉलेशन/कॉन्फ़िगरेशन जटिल हो सकता है; बड़ा प्रोजेक्ट सरल उपयोग के लिए ज़्यादा हो सकता है। |

| एनीथिंगएलएलएम | डेस्कटॉप ऐप (विंडोज़, मैक, लिनक्स) या वेब (Docker) | हाँ – बिल्ट-इन RAG: ड्रैग-एंड-ड्रॉप दस्तावेज़ (PDF, DOCX, आदि) के साथ सिटेशन | Ollama को एक LLM प्रोवाइडर के रूप में समर्थन करता है (कॉन्फ़िग या Docker env में सेट करें) | ऑल-इन-वन यूआई (आपके दस्तावेज़ों के साथ प्राइवेट ChatGPT); नो-कोड एजेंट बिल्डर, मल्टी-यूजर समर्थन। | अधिक संसाधन उपयोग (इम्बेडिंग्स DB, आदि); डेस्कटॉप ऐप में कुछ मल्टी-यूजर फीचर्स का अभाव है। |

| चैट-विथ-नोट्स | वेब ऐप (लाइटवेट Flask सर्वर) | हाँ – टेक्स्ट/PDF फ़ाइलें अपलोड करें और उनके कॉन्टेंट के साथ चैट करें | Ollama का उपयोग सभी AI उत्तरों के लिए करता है (स्थानीय रूप से चल रहे Ollama की आवश्यकता है) | बहुत सरल सेटअप और इंटरफेस दस्तावेज़ Q&A पर केंद्रित है; डेटा स्थानीय रहता है। | बेसिक यूआई और फंक्शनालिटी; एकल-यूजर, एक दस्तावेज़ एक बार (उन्नत फीचर्स नहीं)। |

इनमें से हर टूल एक्टिवली मेन्टेन्ड और ओपन-सोर्स है। अगला, हम हर विकल्प के विवरण में गहराई से उतरते हैं, जिसमें शामिल है कि वे Ollama के साथ कैसे काम करते हैं, उल्लेखनीय फीचर्स, और ट्रेड-ऑफ्स।

पेज असिस्ट (ब्राउज़र एक्सटेंशन)

पेज असिस्ट एक ओपन-सोर्स ब्राउज़र एक्सटेंशन है जो स्थानीय LLM चैट को आपके ब्राउज़र में लाता है। यह क्रोमियम-आधारित ब्राउज़र्स और फायरफॉक्स का समर्थन करता है, एक ChatGPT-स्टाइल साइडबार या टैब प्रदान करता है जहां आप एक मॉडल के साथ संवाद कर सकते हैं। पेज असिस्ट स्थानीय रूप से चल रहे Ollama को AI प्रोवाइडर के रूप में कनेक्ट कर सकता है, या अन्य स्थानीय बैकएंड्स, अपने सेटिंग्स के माध्यम से। विशेष रूप से, यह आपको फ़ाइलें जोड़ने की अनुमति देता है (उदाहरण के लिए PDF या टेक्स्ट) ताकि AI चैट के भीतर विश्लेषण कर सके, बुनियादी RAG वर्कफ्लो को सक्षम बनाता है। आप इसे वर्तमान वेबपेज के कॉन्टेंट के साथ सहायता करने या जानकारी के लिए वेब खोज करने के लिए भी उपयोग कर सकते हैं।

सेटअप सरल है: एक्सटेंशन को Chrome वेब स्टोर या Firefox एड-ऑन्स से इंस्टॉल करें, सुनिश्चित करें कि Ollama चल रहा है, और पेज असिस्ट के सेटिंग्स में Ollama को स्थानीय AI प्रोवाइडर के रूप में चुनें। इंटरफेस में चैट इतिहास, मॉडल चयन, और चैट परिणामों के लिए एक ऑप्शनल शेयरएबल URL जैसे फीचर्स शामिल हैं। एक वेब यूआई भी एक कीबोर्ड शॉर्टकट के माध्यम से उपलब्ध है अगर आप एक फुल-टैब चैट अनुभव पसंद करते हैं।

मजबूत बिंदु: पेज असिस्ट हल्का और सुविधाजनक है – क्योंकि यह ब्राउज़र में रहता है, कोई अलग सर्वर चलाने की आवश्यकता नहीं है। यह ब्राउज़िंग संदर्भों के लिए अच्छा है (आप इसे किसी भी वेबपेज पर खोल सकते हैं) और इंटरनेट सर्च इंटीग्रेशन और फ़ाइल अटैचमेंट्स के साथ चैट को समृद्ध बनाने के लिए समर्थन करता है। यह नए चैट और साइडबार टॉगल करने के लिए कीबोर्ड शॉर्टकट्स जैसे उपयोगी फीचर्स भी प्रदान करता है।

सीमाएँ: एक्सटेंशन होने के नाते, यह ब्राउज़र वातावरण तक सीमित है। यूआई सरल है और कुछ हद तक कम फीचर-रिच है जैसे स्टैंडअलोन चैट ऐप्स। उदाहरण के लिए, मल्टी-यूजर प्रबंधन या उन्नत एजेंट प्लगइन्स स्कोप में नहीं हैं। इसके अलावा, प्रारंभिक सेटअप में एक्सटेंशन को बिल्ड/लोड करने की आवश्यकता हो सकती है अगर आपकी ब्राउज़र के लिए एक प्री-पैकेज्ड संस्करण उपलब्ध नहीं है (प्रोजेक्ट Bun या npm का उपयोग करके बिल्ड निर्देश प्रदान करता है)। समग्र रूप से, पेज असिस्ट वेब ब्राउज़िंग के दौरान Ollama-सक्षम चैट तक तेज़ पहुंच के लिए सबसे अच्छा है, मध्यम RAG क्षमताओं के साथ।

ओपन वेबयूआई (सेल्फ-होस्टेड वेब एप्लिकेशन)

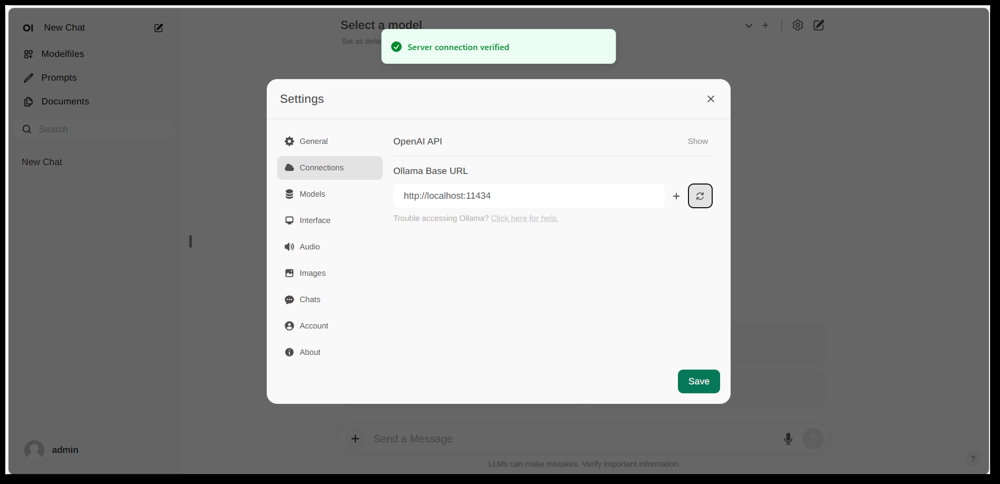

Open WebUI के सेटिंग्स इंटरफेस, जहां एक Ollama कनेक्शन कॉन्फ़िगर किया गया है (बेस URL स्थानीय Ollama API पर सेट किया गया है)। यूआई में एक दस्तावेज़ अनुभाग शामिल है, जो RAG वर्कफ्लो को सक्षम बनाता है।

Open WebUI एक शक्तिशाली, सामान्य-उद्देश्य चैट फ्रंट-एंड है जो मूल रूप से Ollama के साथ काम करने के लिए बनाया गया था, और अब विभिन्न LLM बैकएंड्स का समर्थन करने के लिए विस्तारित किया गया है। यह एक सेल्फ-होस्टेड वेब एप्लिकेशन के रूप में चलता है और आमतौर पर आसान सेटअप के लिए Docker या Kubernetes के माध्यम से तैनात किया जाता है। चलने के बाद, आप इसे अपने ब्राउज़र के माध्यम से एक्सेस करते हैं (मोबाइल डिवाइस पर प्रोग्रेसिव वेब ऐप के रूप में इंस्टॉल करने के साथ समर्थन है)।

Open WebUI एक चैट इंटरफेस प्रदान करता है जिसमें मल्टी-यूजर समर्थन, मॉडल प्रबंधन, और व्यापक फीचर्स हैं। महत्वपूर्ण रूप से, इसमें बिल्ट-इन RAG क्षमताएं हैं – आप दस्तावेज़ अपलोड या लाइब्रेरी में इम्पोर्ट कर सकते हैं और फिर रिट्रीवल ऑगमेंटेशन के साथ प्रश्न पूछ सकते हैं। इंटरफेस आपको दस्तावेज़ को सीधे एक चैट सेशन में लोड करने या ज्ञान के एक स्थायी लाइब्रेरी बनाए रखने की अनुमति देता है। यह वेब खोज करने और परिणामों को संवाद में इंजेक्ट करने के लिए भी समर्थन करता है ताकि अप-टू-डेट जानकारी प्राप्त हो सके।

Ollama इंटीग्रेशन: Open WebUI Ollama से अपने API के माध्यम से कनेक्ट होता है। आप या तो Open WebUI Docker कंटेनर को Ollama सर्वर के साथ चलाकर और एक पर्यावरण चर सेट करके Ollama के URL पर इशारा कर सकते हैं, या एक विशेष Docker इमेज का उपयोग कर सकते हैं जो वेब यूआई के साथ Ollama को बंडल करता है। अभ्यास में, कंटेनर्स को लॉन्च करने के बाद, आप अपने ब्राउज़र में Open WebUI पर जाएंगे और यदि सही ढंग से कॉन्फ़िगर किया गया है तो “सर्वर कनेक्शन वेरिफाइड” देखेंगे (उपरोक्त छवि में दिखाया गया है)। यह इंगित करता है कि यूआई आपकी स्थानीय Ollama मॉडल्स का उपयोग चैट के लिए करने के लिए तैयार है। Open WebUI OpenAI API-संगत एंडपॉइंट्स का भी समर्थन करता है, इसलिए यह LM Studio, OpenRouter, आदि के साथ-साथ Ollama से इंटरफेस कर सकता है।

मजबूत बिंदु: यह समाधान सबसे फीचर-रिच और लचीला यूआई में से एक है। यह एक साथ कई मॉडल्स और संवाद थ्रेड्स का समर्थन करता है, कस्टम “चरित्र” या सिस्टम प्रॉम्प्ट्स, इमेज जनरेशन, और अधिक। RAG इम्प्लीमेंटेशन मजबूत है – आपको दस्तावेज़ प्रबंधन के लिए एक पूर्ण यूआई मिलता है और यहां तक कि रिट्रीवल के लिए उपयोग किए जाने वाले वेक्टर स्टोर या खोज सेवा को कॉन्फ़िगर करने की भी अनुमति मिलती है। Open WebUI भी सक्रिय रूप से विकसित किया जाता है (इसके GitHub पर उच्च स्टार काउंट से इंगित होने वाले व्यापक समुदाय के साथ) और विस्तार और स्केलिंग के लिए डिज़ाइन किया गया है। यह एक व्यापक, ऑल-इन-वन चैट यूआई के लिए एक अच्छा विकल्प है स्थानीय मॉडल्स के लिए, विशेष रूप से कई उपयोगकर्ताओं या जटिल उपयोग मामलों वाले सीनारियो में।

सीमाएँ: अधिक शक्ति के साथ अधिक जटिलता आती है। Open WebUI सरल व्यक्तिगत उपयोग के लिए ओवरकिल हो सकता है – Docker कंटेनर्स तैनात करना और कॉन्फ़िगरेशन प्रबंधित करना डरावना हो सकता है अगर आप परिचित नहीं हैं। यह एक हल्के ऐप की तुलना में अधिक संसाधन का उपयोग करता है, क्योंकि यह एक वेब सर्वर, चैट इतिहास के लिए ऑप्शनल डेटाबेस, आदि चलाता है। इसके अलावा, फीचर्स जैसे रोल-आधारित एक्सेस कंट्रोल और यूजर प्रबंधन, हालांकि उपयोगी, इंगित करते हैं कि यह एक सर्वर सेटअप के लिए बनाया गया है – एक घर के पीसी पर एकल उपयोगकर्ता को शायद सभी की आवश्यकता नहीं होगी। संक्षेप में, सेटअप भारी है और इंटरफेस जटिल लग सकता है अगर आपको बस एक बुनियादी ChatGPT क्लोन की आवश्यकता है। लेकिन उन लोगों के लिए जो इसके फीचर्स की व्यापकता की आवश्यकता है (या एक यूआई में Ollama और अन्य मॉडल प्रोवाइडर्स के बीच आसानी से स्विच करने की इच्छा है), Open WebUI एक शीर्ष प्रतियोगी है।

LobeChat (ChatGPT-जैसी फ्रेमवर्क के साथ प्लगइन्स)

LobeChat इंटरफेस बैनर जो “Ollama Supported” और कई स्थानीय मॉडल दिखाता है। LobeChat आपको Ollama या अन्य प्रोवाइडर्स का उपयोग करके एक शानदार ChatGPT-स्टाइल वेब ऐप डिप्लॉय करने देता है, जिसमें वॉइस इनपुट और प्लगइन्स जैसे फीचर्स होते हैं।

LobeChat एक ओपन-सोर्स चैट फ्रेमवर्क है जो एक पॉलिश्ड यूजर एक्सपीरियंस और फ्लेक्सिबिलिटी पर फोकस करता है। यह एक ChatGPT-जैसा वेब एप्लिकेशन है जिसे आप स्व-होस्ट कर सकते हैं, जिसमें बहुत से AI प्रोवाइडर्स का समर्थन है – OpenAI और Anthropic से लेकर Ollama के माध्यम से ओपन मॉडल्स तक। LobeChat को प्राइवेसी के साथ डिज़ाइन किया गया है (आप इसे खुद चलाते हैं) और इसमें एक आधुनिक इंटरफेस है जिसमें सुविधाएं जैसे कन्वर्सेशन मेमोरी, वॉइस कन्वर्सेशन मोड, और प्लगइन्स के माध्यम से टेक्स्ट-टू-इमेज जनरेशन शामिल हैं।

LobeChat का एक मुख्य फीचर इसका नॉलेज बेस क्षमता है। आप दस्तावेज़ अपलोड कर सकते हैं (PDFs, इमेजेज, ऑडियो, वीडियो जैसे फॉर्मेट में) और एक नॉलेज बेस बनाएँ जो चैट के दौरान उपयोग किया जा सकता है। इसका मतलब है कि आप अपने फाइलों के सामग्री के बारे में सवाल पूछ सकते हैं – एक RAG वर्कफ्लो जिसे LobeChat आउट-ऑफ-द-बॉक्स सपोर्ट करता है। UI इन फाइलों/नॉलेज बेसेज का प्रबंधन प्रदान करता है और चैट में उनका उपयोग टॉगल करने की अनुमति देता है, जिससे बेस LLM से अधिक समृद्ध Q&A एक्सपीरियंस मिलता है।

Ollama के साथ LobeChat का उपयोग करने के लिए, आप LobeChat ऐप को डिप्लॉय करेंगे (उदाहरण के लिए, एक प्रदान की गई Docker इमेज या स्क्रिप्ट के माध्यम से) और Ollama को बैकएंड के रूप में कॉन्फ़िगर करेंगे। LobeChat Ollama को एक फर्स्ट-क्लास प्रोवाइडर के रूप में पहचानता है – यह Pinokio AI ब्राउज़र का उपयोग करने पर एक क्लिक डिप्लॉयमेंट स्क्रिप्ट भी प्रदान करता है। प्रैक्टिस में, आपको संभवतः Ollama के सेटिंग्स को समायोजित करने की आवश्यकता होगी (जैसे LobeChat के दस्तावेज़ों के अनुसार CORS को सक्षम करना) ताकि LobeChat का वेब फ्रंटएंड Ollama HTTP API तक पहुंच सके। कॉन्फ़िगरेशन के बाद, आप LobeChat UI में एक Ollama-होस्टेड मॉडल चुन सकते हैं और उससे बातचीत कर सकते हैं, जिसमें अपने अपलोड किए गए दस्तावेज़ों का प्रश्न पूछना भी शामिल है।

मजबूत बिंदु: LobeChat के UI को अक्सर साफ़ और यूजर-फ्रेंडली होने के लिए प्रशंसा की जाती है, जो ChatGPT की लुक और फील को करीब से नकल करता है (जो अपनाने में आसान बनाता है)। यह वॉइस इनपुट/आउटपुट जैसे अतिरिक्त सुविधाएं जोड़ता है बोलचाल के लिए और एक प्लगइन सिस्टम को फंक्शनलिटी बढ़ाने के लिए (ChatGPT के प्लगइन्स के समान, जैसे वेब ब्राउज़िंग या इमेज जनरेशन सक्षम बनाता है)। मल्टी-मॉडल सपोर्ट का मतलब है कि आप आसानी से, उदाहरण के लिए, एक Ollama स्थानीय मॉडल और एक OpenAI API मॉडल को एक ही इंटरफेस में स्विच कर सकते हैं। यह एक मोबाइल-फ्रेंडली PWA के रूप में इंस्टॉलेशन का भी समर्थन करता है, जिससे आप अपने स्थानीय चैट को चलाते हुए जा सकते हैं।

सीमाएं: LobeChat को सेटअप करना कुछ विकल्पों की तुलना में अधिक जटिल हो सकता है। यह एक फुल-स्टैक एप्लिकेशन है (अक्सर Docker Compose के साथ चलाया जाता है), इसलिए कुछ ओवरहेड है। विशेष रूप से, Ollama इंटीग्रेशन के लिए क्रॉस-ऑरिजिन रिक्वेस्ट्स को सक्षम करना और पोर्ट्स को मिलाना एक बार का काम है, लेकिन तकनीकी है। इसके अलावा, जबकि LobeChat काफी शक्तिशाली है, सभी फीचर्स हर उपयोगकर्ता के लिए आवश्यक नहीं हो सकते; उदाहरण के लिए, अगर आपको मल्टी-प्रोवाइडर सपोर्ट या प्लगइन्स की आवश्यकता नहीं है, तो इंटरफेस एक मिनिमल टूल की तुलना में भारी लग सकता है। अंत में, कुछ उन्नत फीचर्स जैसे एक-क्लिक डिप्लॉय Pinokio ब्राउज़र या Vercel जैसे विशिष्ट वातावरणों का अनुमान लगाते हैं, जिन्हें आप उपयोग कर सकते हैं या नहीं। समग्र रूप से, LobeChat आदर्श है अगर आप एक फुल-फीचर्ड ChatGPT विकल्प चाहते हैं जो Ollama के साथ स्थानीय रूप से चलता है, और आपको वहां पहुंचने के लिए कुछ प्रारंभिक कॉन्फ़िगरेशन करने में कोई परेशानी नहीं है।

LibreChat (ChatGPT क्लोन के साथ मल्टी-प्रोवाइडर सपोर्ट)

LibreChat (पहले ChatGPT-Clone या UI के नाम से जाना जाता था) एक ओपन-सोर्स प्रोजेक्ट है जो ChatGPT इंटरफेस और फंक्शनलिटी को प्रतिबिंबित और विस्तारित करने का लक्ष्य रखता है। इसे स्थानीय रूप से (या अपने सर्वर पर) डिप्लॉय किया जा सकता है और यह विभिन्न AI बैकएंड्स का समर्थन करता है – जिसमें Ollama के माध्यम से ओपन-सोर्स मॉडल्स शामिल हैं। मूल रूप से, LibreChat एक परिचित चैट एक्सपीरियंस प्रदान करता है (हिस्ट्री के साथ डायलॉग इंटरफेस, यूजर और असिस्टेंट संदेश) जबकि आपको बैकएंड पर विभिन्न मॉडल प्रोवाइडर्स प्लग इन करने की अनुमति देता है।

LibreChat दस्तावेज़ इंटरैक्शन और RAG का समर्थन करता है एक एड-ऑन के माध्यम से जिसे RAG API और एम्बेडिंग सर्विसेज कहा जाता है। इंटरफेस में, आप “Chat with Files” जैसे फीचर्स का उपयोग कर सकते हैं, जो आपको दस्तावेज़ अपलोड करने और फिर उनके बारे में सवाल पूछने की अनुमति देता है। इसके नीचे, यह एम्बेडिंग्स और एक वेक्टर स्टोर का उपयोग करता है ताकि आपके फाइलों से संबंधित संदर्भ प्राप्त किया जा सके। इसका मतलब है कि आप ChatGPT + कस्टम नॉलेज के समान प्रभाव प्राप्त कर सकते हैं, सभी स्थानीय रूप से। प्रोजेक्ट एक अलग रिपॉजिटरी भी प्रदान करता है RAG सर्विस के लिए अगर आप इसे स्व-होस्ट करना चाहते हैं।

Ollama के साथ LibreChat का उपयोग करना आमतौर पर LibreChat सर्वर को चलाना शामिल है (उदाहरण के लिए Node/Docker के माध्यम से) और सुनिश्चित करना कि यह Ollama सर्विस तक पहुंच सकता है। LibreChat में एक “Custom Endpoint” सेटिंग है जहां आप एक OpenAI-संगत API URL इनपुट कर सकते हैं। क्योंकि Ollama एक स्थानीय API एक्सपोज कर सकता है जो OpenAI-संगत है, LibreChat को http://localhost:11434 (या जहां भी Ollama सुन रहा है) की ओर इशारा किया जा सकता है। वास्तव में, LibreChat Ollama को अपने समर्थित AI प्रोवाइडर्स में से एक के रूप में स्पष्ट रूप से सूचीबद्ध करता है – OpenAI, Cohere, आदि के साथ। कॉन्फ़िगरेशन के बाद, आप ड्रॉपडाउन में मॉडल (Ollama का मॉडल) चुन सकते हैं और चैट कर सकते हैं। LibreChat यह भी अनुमति देता है कि आप मॉडल या प्रोवाइडर्स को कन्वर्सेशन के बीच में स्विच कर सकते हैं और कई चैट प्रीसेट्स/कॉन्टेक्स्ट्स का समर्थन करते हैं।

मजबूत बिंदु: LibreChat का प्राथमिक फायदा चैट एक्सपीरियंस के आसपास बनाई गई समृद्ध फीचर्स की श्रृंखला है। इसमें कन्वर्सेशन ब्रांचिंग, संदेश खोज, बिल्ट-इन कोड इंटरप्रिटर समर्थन (सुरक्षित सैंडबॉक्स्ड कोड एक्सिक्यूशन), और टूल/एजेंट इंटीग्रेशन जैसे चीजें शामिल हैं। यह ChatGPT++ है, स्थानीय मॉडल्स को इंटीग्रेट करने की क्षमता के साथ। किसी को जो ChatGPT के UI पसंद है, LibreChat बहुत परिचित लगेगा और सीखने के लिए कम लर्निंग कर्व होगा। प्रोजेक्ट सक्रिय और समुदाय-चालित है (अक्सर अपडेट्स और चर्चाओं से पता चलता है), और यह काफी फ्लेक्सिबल है: आप कई तरह के LLM एंडपॉइंट्स से कनेक्ट कर सकते हैं या इसे मल्टी-यूजर के साथ ऑथेंटिकेशन के लिए एक टीम सेटिंग में चलाया जा सकता है।

सीमाएं: अपनी कई फीचर्स के साथ, LibreChat चलाने में भारी हो सकता है। इंस्टॉलेशन में चैट्स को स्टोर करने के लिए एक डेटाबेस सेटअप करना और विभिन्न APIs के लिए एन्वायरनमेंट वेरिएबल्स कॉन्फ़िगर करना शामिल हो सकता है। अगर आप सभी घटकों को सक्षम करते हैं (RAG, एजेंट्स, इमेज जनरेशन, आदि), तो यह एक काफी जटिल स्टैक है। एकल उपयोगकर्ता के लिए जो केवल एक स्थानीय मॉडल के साथ एक बेसिक चैट की आवश्यकता है, LibreChat अधिक से अधिक हो सकता है। इसके अलावा, जबकि UI परिचित है, यह दस्तावेज़ QA के लिए विशेष रूप से अनुकूलित नहीं है – यह काम करता है लेकिन एक समर्पित “दस्तावेज़ लाइब्रेरी” इंटरफेस की कमी है (अपलोड आमतौर पर एक चैट या API के भीतर किए जाते हैं)। संक्षेप में, LibreChat तब चमकता है जब आप एक फुल ChatGPT-जैसा वातावरण चाहते हैं जिसमें कई फीचर्स स्थानीय रूप से चल रहे हैं, लेकिन सरल समाधानों को संकीर्ण उपयोग-केस के लिए पर्याप्त हो सकता है।

AnythingLLM (ऑल-इन-वन डेस्कटॉप या सर्वर ऐप)

AnythingLLM एक ऑल-इन-वन AI एप्लिकेशन है जो RAG और आसानी से उपयोग पर जोर देता है। यह आपको “अपने दस्तावेज़ों के साथ चैट” करने की अनुमति देता है, या तो ओपन-सोर्स LLMs का उपयोग करके या OpenAI के मॉडल्स का उपयोग करके, सभी एक ही एकीकृत इंटरफेस के माध्यम से। उल्लेखनीय रूप से, AnythingLLM को क्रॉस-प्लेटफॉर्म डेस्कटॉप ऐप (Windows, Mac, Linux के लिए) और एक स्व-होस्टेड वेब सर्वर (Docker के माध्यम से) के रूप में उपलब्ध है। इस फ्लेक्सिबिलिटी का मतलब है कि आप इसे अपने PC पर एक सामान्य एप्लिकेशन के रूप में चला सकते हैं, या एक सर्वर पर कई उपयोगकर्ताओं के लिए डिप्लॉय कर सकते हैं।

दस्तावेज़ हैंडलिंग AnythingLLM का कोर है। आप ड्रैग-एंड-ड्रॉप दस्तावेज़ (PDF, TXT, DOCX, आदि) ऐप में डाल सकते हैं, और यह स्वचालित रूप से उन्हें एक वेक्टर डेटाबेस में इंडेक्स करेगा (इसमें LanceDB डिफ़ॉल्ट रूप से आता है)। चैट इंटरफेस में, जब आप सवाल पूछते हैं, तो यह आपके दस्तावेज़ों से संबंधित चंक प्राप्त करेगा और साइटेड उत्तर प्रदान करेगा, जिससे पता चलेगा कि जानकारी कहाँ से आई है। मूल रूप से, यह आपके लिए एक प्राइवेट नॉलेज बेस बनाता है और LLM को इसे संदर्भ के रूप में उपयोग करने देता है। आप दस्तावेज़ों को “वर्कस्पेस” में संगठित कर सकते हैं (उदाहरण के लिए, हर प्रोजेक्ट या टॉपिक के लिए एक वर्कस्पेस), आवश्यकतानुसार संदर्भ को अलग करने के लिए।

Ollama के साथ AnythingLLM का उपयोग करना सरल है। कॉन्फ़िगरेशन में, आप Ollama को LLM प्रोवाइडर के रूप में चुनते हैं। अगर Docker के माध्यम से चलाया जा रहा है, तो आप एन्वायरनमेंट वेरिएबल्स जैसे LLM_PROVIDER=ollama सेट करते हैं और OLLAMA_BASE_PATH प्रदान करते हैं (आपके Ollama इंस्टेंस का URL)। AnythingLLM सर्वर फिर सभी मॉडल क्वेरी को Ollama के API को भेजेगा। Ollama आधिकारिक रूप से समर्थित है, और दस्तावेज़ यह नोट करते हैं कि आप इसे स्थानीय रूप से चलाने के लिए विभिन्न ओपन मॉडल्स (जैसे Llama 2, Mistral, आदि) का उपयोग करने के लिए ले जा सकते हैं। वास्तव में, डेवलपर्स यह उजागर करते हैं कि AnythingLLM को Ollama के साथ मिलाने से शक्तिशाली ऑफ़लाइन RAG क्षमताएं अनलॉक होती हैं: Ollama मॉडल इन्फरेंस का प्रबंधन करता है, और AnythingLLM एम्बेडिंग्स और UI/एजेंट लॉजिक का प्रबंधन करता है।

मजबूत बिंदु: AnythingLLM एक समग्र समाधान प्रदान करता है प्राइवेट Q&A और चैट के लिए। मुख्य मजबूत बिंदुओं में शामिल हैं: RAG के लिए आसान सेटअप (एम्बेडिंग्स और वेक्टर स्टोर करने की भारी मेहनत स्वचालित है), मल्टी-डॉक्यूमेंट सपोर्ट के साथ स्रोतों का स्पष्ट उद्धरण, और अतिरिक्त फीचर्स जैसे AI एजेंट्स (इसमें एक नो-कोड एजेंट बिल्डर है जहां आप कस्टम वर्कफ्लो और टूल उपयोग बना सकते हैं)। यह मल्टी-यूजर डिफ़ॉल्ट रूप से है (विशेष रूप से सर्वर मोड में), उपयोगकर्ता खातों और अनुमतियों के साथ अगर आवश्यक हो। इंटरफेस को सरल (चैट बॉक्स + दस्तावेज़/वर्कस्पेस के साथ साइडबार) लेकिन नीचे शक्तिशाली होने के लिए डिज़ाइन किया गया है। व्यक्तिगत उपयोग के लिए, डेस्कटॉप ऐप एक बड़ा फायदा है – आप एक नेटिव-फीलिंग ऐप प्राप्त करते हैं बिना ब्राउज़र खोलने या कमांड चलाने की आवश्यकता के, और यह डिफ़ॉल्ट रूप से स्थानीय रूप से डेटा स्टोर करता है।

सीमाएं: क्योंकि यह कई घटकों को इंटीग्रेट करता है (LLM API, एम्बेडिंग मॉडल्स, वेक्टर DB, आदि), AnythingLLM संसाधन-इंटेंसिव हो सकता है। जब आप दस्तावेज़ इनजेस्ट करते हैं, तो एम्बेडिंग्स जनरेट करने में समय और मेमोरी लग सकती है (यह Ollama या स्थानीय मॉडल्स का उपयोग करने के लिए भी समर्थन करता है मॉडल्स जैसे nomic-embed के साथ)। डेस्कटॉप ऐप उपयोग को सरल बनाता है, लेकिन अगर आपके पास बहुत सारे दस्तावेज़ या बहुत बड़े फाइल हैं, तो पृष्ठभूमि में कुछ भारी प्रोसेसिंग की उम्मीद करें। एक और सीमा यह है कि उन्नत उपयोगकर्ता इसे अपने स्टैक को असेंबल करने से कम कॉन्फ़िगरेशन योग्य पा सकते हैं – उदाहरण के लिए, यह वर्तमान में LanceDB या Chroma का उपयोग करता है; अगर आप एक अलग वेक्टर स्टोर चाहते हैं, तो आपको कॉन्फ़िग या कोड में डूबना पड़ेगा। इसके अलावा, जबकि मल्टी-प्रोवाइडर सपोर्ट किया जाता है, इंटरफेस वास्तव में एक मॉडल के समय के लिए तैयार है (आप ग्लोबल प्रोवाइडर सेटिंग बदलेंगे अगर आप एक अलग मॉडल का उपयोग करना चाहते हैं)। संक्षेप में, AnythingLLM एक आउट-ऑफ-द-बॉक्स समाधान है स्थानीय दस्तावेज़ चैट के लिए, विशेष रूप से Ollama के साथ, लेकिन यह एक मिनिमल UIs की तुलना में एक बड़ा एप्लिकेशन चलाने के लिए है।

चैट-विथ-नोट्स (मिनिमल डॉक्यूमेंट चैट UI)

चैट-विथ-नोट्स एक मिनिमलिस्ट एप्लिकेशन है जो विशेष रूप से Ollama-प्रबंधित मॉडल्स के साथ स्थानीय टेक्स्ट फाइलों के साथ चैट करने के लिए बनाया गया है। यह मूल रूप से एक लाइटवेट Flask वेब सर्वर है जिसे आप अपने पीसी पर चलाते हैं, जो एक सरल वेब पेज प्रदान करता है जहाँ आप एक दस्तावेज़ अपलोड कर सकते हैं और उसके बारे में चैट शुरू कर सकते हैं। इस प्रोजेक्ट का उद्देश्य सादगी है: इसमें बहुत सारे अतिरिक्त सुविधाएँ नहीं हैं, लेकिन यह स्थानीय LLM के साथ दस्तावेज़-प्रश्न-उत्तर का कोर काम करता है।

चैट-विथ-नोट्स का उपयोग करने के लिए पहले यह सुनिश्चित करना चाहिए कि आपका Ollama इंस्टेंस एक मॉडल चल रहा है (उदाहरण के लिए, आप Ollama को ollama run llama2 या किसी अन्य मॉडल के साथ शुरू कर सकते हैं)। फिर आप Flask ऐप को लॉन्च करते हैं (python app.py) और स्थानीय वेबसाइट खोलते हैं। UI आपको एक फाइल अपलोड करने के लिए प्रॉम्प्ट करेगा (सपोर्टेड फॉर्मेट्स में प्लेन टेक्स्ट, मार्कडाउन, कोड फाइलें, HTML, JSON, और PDF शामिल हैं)। अपलोड करने के बाद, फाइल के टेक्स्ट कंटेंट को डिस्प्ले किया जाता है, और आप उस कंटेंट के बारे में प्रश्न पूछ सकते हैं या AI के साथ चैट कर सकते हैं। चैट एक टाइपिकल चैट बबल फॉर्मेट में होती है। अगर आप मध्य-चैट में एक नई फाइल अपलोड करते हैं, तो ऐप पूछेगा कि क्या आप एक नई चैट शुरू करना चाहते हैं या वर्तमान चैट कॉन्टेक्स्ट बनाए रखना चाहते हैं और बस नई फाइल के इन्फो को जोड़ना चाहते हैं। इस तरह, अगर आवश्यक हो तो आप कई फाइलों के बारे में क्रमिक रूप से बात कर सकते हैं। चैट क्लियर करने या कन्वर्सेशन को एक टेक्स्ट फाइल में एक्सपोर्ट करने के लिए बटन भी हैं।

इन्टरफेस के नीचे, चैट-विथ-नोट्स Ollama API को क्वेरी करता है ताकि रिस्पॉन्स उत्पन्न किए जा सकें। Ollama मॉडल इन्फरेंस का प्रबंधन करता है, और चैट-विथ-नोट्स बस प्रॉम्प्ट प्रदान करता है (जिसमें अपलोड किए गए टेक्स्ट के संबंधित भाग शामिल होते हैं)। यह एक वेक्टर डेटाबेस का उपयोग नहीं करता; इसके बजाय, यह पूरे फाइल कंटेंट (या उसके चंक) को आपकी प्रश्न के साथ मॉडल को भेजता है। यह दृष्टिकोण सबसे अच्छी तरह काम करता है जब दस्तावेज़ मॉडल के कॉन्टेक्स्ट विंडो में फिट होते हैं।

मजबूतियाँ: ऐप बहुत सरल है डिप्लॉय और उपयोग करने के लिए। कोई जटिल कॉन्फ़िगरेशन नहीं है – अगर आपके पास Python और Ollama सेटअप है, तो आप इसे एक या दो मिनट में चलाने लग सकते हैं। इंटरफेस क्लीन और मिनिमल है, जो टेक्स्ट कंटेंट और Q&A पर केंद्रित है। क्योंकि यह इतना फोकस्ड है, यह सुनिश्चित करता है कि सभी डेटा स्थानीय और केवल मेमोरी में रहता है (केवल Ollama को localhost पर कॉल के अलावा कोई बाहरी कॉल नहीं)। यह एक अच्छा विकल्प है अगर आप विशेष रूप से फाइलों के साथ चैट करना चाहते हैं और एक दस्तावेज़ के बिना सामान्य कन्वर्सेशन की आवश्यकता नहीं है।

सीमाएँ: चैट-विथ-नोट्स की मिनिमलिज्म का मतलब है कि इसमें अन्य UIs में पाए जाने वाले कई फीचर्स का अभाव है। उदाहरण के लिए, यह कई मॉडल्स या प्रोवाइडर्स का उपयोग करने का समर्थन नहीं करता (यह डिज़ाइन के अनुसार Ollama-ओनली है), और यह एक लंबे समय तक दस्तावेज़ों की लाइब्रेरी बनाए रखता नहीं है – आप सेशन के अनुसार फाइलों को अपलोड करते हैं, और कोई स्थायी वेक्टर इंडेक्स नहीं है। बहुत बड़े दस्तावेज़ों को स्केल करने में समस्या हो सकती है बिना मैनुअल एडजस्टमेंट्स के, क्योंकि यह प्रॉम्प्ट में बहुत सारा टेक्स्ट शामिल करने की कोशिश कर सकता है। इसके अलावा, जबकि UI फंक्शनल है, यह उतना पॉलिश्ड नहीं है (डार्क मोड नहीं है, रिस्पॉन्स का रिच टेक्स्ट फॉर्मेटिंग नहीं है, आदि)। सारांश में, यह टूल ओल्लामा मॉडल के साथ फाइलों के तेज़, एक बार के विश्लेषण के लिए आदर्श है। अगर आपकी आवश्यकताएँ बढ़ती हैं (उदाहरण के लिए, कई दस्तावेज़, या एक फैंसी UI की इच्छा), तो आप चैट-विथ-नोट्स से बढ़ सकते हैं। लेकिन एक स्टार्टिंग पॉइंट या ओल्लामा पर एक व्यक्तिगत “अपने पीडीएफ से पूछें” समाधान के रूप में, यह बहुत प्रभावी है।

निष्कर्ष

इनमें से प्रत्येक ओपन-सोर्स UI स्थानीय Ollama मॉडल्स के साथ आपकी अनुभव को बढ़ा सकता है एक उपयोगकर्ता-मित्रतापूर्ण चैट इंटरफेस और अतिरिक्त क्षमताओं जैसे दस्तावेज़ प्रश्न-उत्तर प्रदान करके। सबसे अच्छा विकल्प आपकी आवश्यकताओं और तकनीकी आराम पर निर्भर करता है:

- तेज़ सेटअप और ब्राउज़र-आधारित उपयोग के लिए: पेज असिस्ट एक अच्छा विकल्प है, जो आपके वेब ब्राउज़िंग में सीधे इंटीग्रेट होता है बिना किसी परेशानी के।

- एक पूर्ण-फीचर्ड वेब ऐप वातावरण के लिए: ओपन वेबUI या लिब्रेचैट विस्तृत फीचर्स और मल्टी-मॉडल फ्लेक्सिबिलिटी प्रदान करते हैं, जो पावर यूजर्स या मल्टी-यूजर सेटअप्स के लिए उपयुक्त हैं।

- एक पॉलिश्ड चैटजीपीटी विकल्प के लिए प्लगिन क्षमता के साथ: लोबेचैट एक स्व-होस्टेड पैकेज में उपयोगिता और फीचर्स के अच्छे संतुलन प्रदान करता है।

- दस्तावेज़-आधारित इंटरैक्शन के लिए: एनीथिंगएलएम एक ऑल-इन-वन समाधान प्रदान करता है (विशेष रूप से अगर आपको एक डेस्कटॉप ऐप पसंद है), जबकि चैट-विथ-नोट्स एक मिनिमलिस्टिक दृष्टिकोण प्रदान करता है एकल-दस्तावेज़ Q&A के लिए।

इन सभी टूल्स को सक्रिय रूप से बनाए रखा जाता है, इसलिए आप सुधारों और समुदाय समर्थन की उम्मीद कर सकते हैं। इनमें से किसी भी UI का चयन करके, आप अपने स्थानीय Ollama-होस्टेड मॉडल्स के साथ एक सुविधाजनक तरीके से चैट कर पाएंगे – चाहे यह दस्तावेज़ों का विश्लेषण करना हो, सहायक के साथ कोडिंग करना हो, या बस क्लाउड निर्भरताओं के बिना कन्वर्सेशनल AI उपलब्ध होना हो। ऊपर दिए गए प्रत्येक समाधान ओपन-सोर्स है, इसलिए आप उन्हें अपनी आवश्यकताओं के अनुसार और अधिक अनुकूलित कर सकते हैं या उनके विकास में योगदान भी कर सकते हैं।

अपने स्थानीय LLM के साथ खुश चैटिंग!